В последно време все по-често се говори за текстове, генерирани от изкуствен интелект (AI). Заедно с това се появиха и различни инструменти за разпознаване на съдържание, създадено по този начин. Но до каква степен може да им се доверим в нашата практика и кои от тях са най-използваните?

В този кейс ще “хвърлим” повече светлина по темата, като разгледаме горепоставените въпроси и проучим какво всъщност е мнението на Google по темата.

Как работят AI детекторите на текстове?

Преди да се впуснем в анализи и проучвания, нека първо се запознаем с механизма на работа на тези инструменти. Детекторите за AI анализират даден текст и определят каква е вероятността той да е написан от човек или да е генериран от изкуствен интелект. За постигането на тази цел, те използват различни методи и алгоритми, сред които:

- модели на машинно обучение – някои детектори се базират на модели, обучени върху голямо количество данни, съдържащи както човешки, така и AI-генерирани текстове. Те се учат да разпознават различията между двата типа;

- лингвистичен анализ – други включват анализ на лингвистични характеристики като синтаксис, граматика и стилистика, които може да се различават между AI-генерираните текстове и тези, писани от човек;

- повторяемост и шаблонност – детекторите често отчитат повтарящи се структури и шаблони, които не са типични за човешкия стил на писане. Как звучат двата типа?

- AI генериран текст – „Котките са страхотни домашни любимци. Те са независими и привързани. Кучетата са страхотни домашни любимци. Те са лоялни и приятелски настроени.“;

- човешки текст – „Котките и кучетата са чудесни домашни любимци. Котките са известни със своята независимост и привързаност, докато кучетата са прочути със своята лоялност и приятелско поведение.“

- статистически методи – някои инструменти използват статистически анализи за откриване на вероятностни модели и аномалии, характерни за AI-генерираните текстове. Примери за думи, звучащи неестествено в разговорната реч, са – "всъщност", "в крайна сметка", "и така", "като", "поради това", "въпреки това", "в заключение". Те представляват твърде общи думи или фрази за детекторите, идентифициращи ги като генерирани с изкуствен интелект;

- семантична последователност – при реализирането на крайния резултат инструментите за откриване на съдържание, генерирано от ИИ, вземат предвид самия контекст, думите, които не съответстват логически на съдържанието, както и реда, в който са разписани.

Много често детекторите използват комбинация от тези методи за оценка на вероятността за изкуствено генерирани текстове.

Изследване на надеждността на AI детекторите в SEO практиката

Като SEO копирайтъри започнахме да тестваме различни инструменти за разпознаване на AI-генерирано съдържание (AI Content Detectors). Един от наблюдаваните феномени е, че текстове, създадени от хора много преди появата на езиковите модели (ChatGPT, Harpa, Jasper и други), биват оценявани с висок процент на вероятност за AI генерирано съдържание, но и обратното.

Нека разгледаме няколко примера, като направим сравнение на получените резултати през различни инструменти.

Проверка на текстове, писани от хора и такива, генерирани от AI

Ще сравним три типа текстове: три SEO оптимизирани, писани от различни копирайтъри без намесата на изкуствен интелект, както и три на същата тема, изцяло генерирани от изкуствен интелект, без каквато и да е редакция от човек:

- Текст за публикуване в медийни сайтове с цел Линкбилдинг, разписан през 2023 година от копирайтър, без използването на какъвто и да е изкуствен интелект, и текст, генериран от ChatGPT тази година със същото заглавие:

Ето какви са резултатите от проверката в различните инструменти:

|

Инструмент за проверка |

Получени резултати (%) на текст, писан от човек |

Получени резултати (%) на текст, генериран от ИИ |

|

zerogpt.com |

||

|

originality.ai (Lite 1.0.0) |

||

|

originality.ai (Turbo 3.0.1) |

||

|

originality.ai (Multi Language) |

||

|

gptzero.me |

||

|

smodin.io |

||

|

plagiarismdetector.net |

- Категориен текст, разписан през 2023 година от копирайтър, и текст за същата категория, генериран от изкуствен интелект през февруари 2025 година.

Резултати от проверката в различните инструменти:

|

Инструмент за проверка |

Получени резултати (%) на текст, писан от човек |

Получени резултати (%) на текст, генериран от ИИ |

|

zerogpt.com |

||

|

originality.ai (Lite 1.0.0) |

||

|

originality.ai (Turbo 3.0.1) |

||

|

originality.ai (Multi Language) |

||

|

gptzero.me |

||

|

smodin.io |

||

|

plagiarismdetector.net |

- Текст за Блог статия, създаден през 2023 година от човек, и генериран текст с изкуствен интелект през тази година от ChatGPT 4o, на който е подадено само заглавието.

Ето какви са резултатите:

|

Инструмент за проверка |

Получени резултати (%) на текст, писан от човек |

Получени резултати (%) на текст, генериран от ИИ |

|

zerogpt.com |

||

|

originality.ai (Lite 1.0.0) |

||

|

originality.ai (Turbo 3.0.1) |

||

|

originality.ai (Multi Language) |

||

|

gptzero.me |

||

|

smodin.io |

||

|

plagiarismdetector.net |

Анализ на получените резултати

Всички тези примери ясно показват как едно и също съдържание, проверено през различни инструменти, включително и техните модели, показва различен процент AI. Текстове, създадени от хора, често биват класифицирани като AI-генерирани от съвременните детектори, а тези, които са генерирани от ИИ, дори при някои модели дават по-добри проценти за Human съдържание.

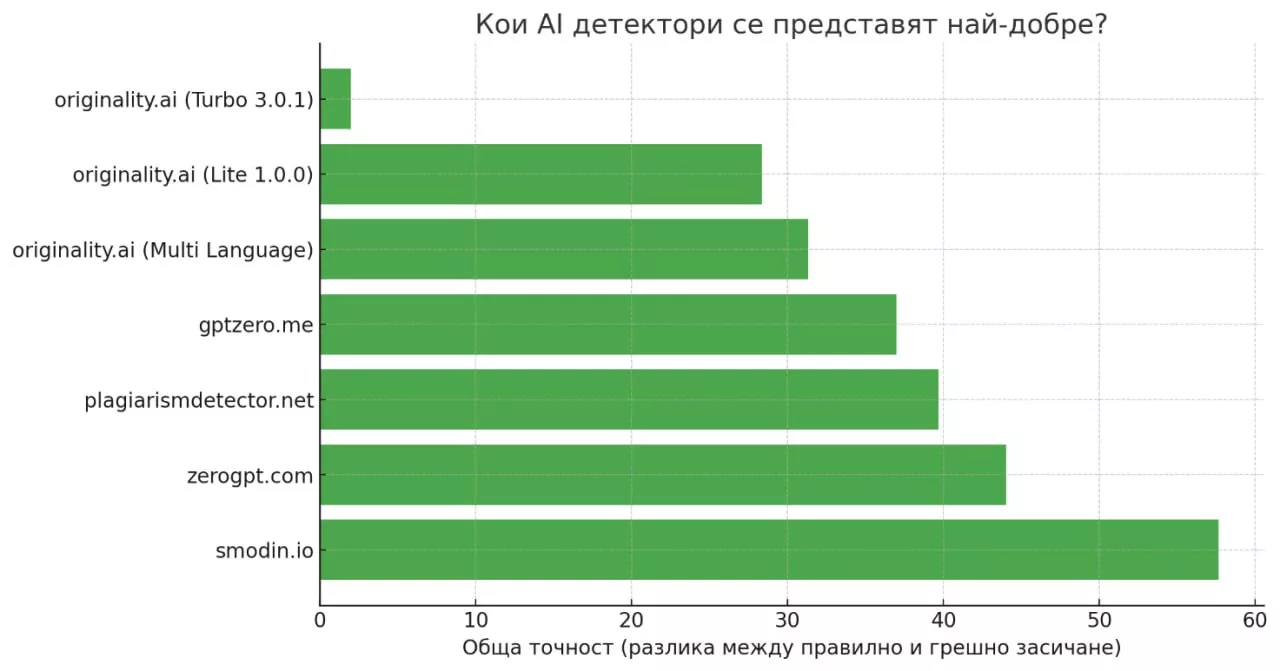

Ето как се представиха различните инструменти като в първата колона търсим най-близката стойност до 0%, а във втората – най-близката до 100%:

|

Инструмент за проверка |

Средна оценка (%) при текст, писан от човек |

Средна оценка (%) при текст, генериран от ИИ |

|

zerogpt.com |

44.0 % |

88.0 % |

|

originality.ai (Lite 1.0.0) |

67.0 % |

95.3 % |

|

originality.ai (Turbo 3.0.1) |

78.7 % |

76.7 % |

|

originality.ai (Multi Language) |

68.7 % |

100.00 % |

|

gptzero.me |

56.0 % |

93.0 % |

|

smodin.io |

0.0 % |

57.7 % |

|

plagiarismdetector.net |

39.7 % |

0.0 % |

Обобщено, резултатите изглеждат така:

След този анализ не може да класифицираме който и да е инструмент като надежден, защото всеки от тях се проваля в някоя от представените проверки. Някои инструменти и модели, дори тези на челни позиции в графиката, показват големи вариации в оценките си при един и същ тип текст, което поставя под съмнение надеждността им. Най-агресивните AI детектори често маркират човешки текстове с фалшиво положителни резултати (False Positives), а други са почти безполезни, тъй като не засичат или улавят с ниска точност AI съдържание.

Също така, при направени тестове от нашия екип през няколко дни, както и при такива в едно и също време на един и същи текст, но през различни IP-та, инструментите показват разминаващи се резултати.

На база на това липсата на каквато и да е проследима зависимост може да се окаже проблем за потребителите, разчитащи на точността на тези оценки.

Какви може да са причините за неточности в AI детекторите?

Анализът показва, че тези инструменти не винаги успяват да разграничат с точност човешки текст от такъв, генериран от изкуствен интелект. На какво може да се дължи това?

- Ограничения на алгоритмите

Алгоритмите на машинно обучение и статистическите методи не винаги може да уловят всички нюанси на човешкото писане, особено когато то е различно от обучителния набор данни.

- Лингвистични особености

Някои лингвистични характеристики, присъщи на човешките текстове, е вероятно да бъдат сбъркани с такива, характерни за AI-генерирани текстове поради сходства в граматиката и синтаксиса. Алгоритмите може да са прекалено чувствителни към специфични езикови конструкции, които приличат на AI-генерирани.

- Малък брой символи

По-често AI детекторите дават фалшиви положителни резултати при проверка на кратки текстове. За по-точни резултати – те изискват по-дълги текстове, които предоставят повече данни и контекст за анализ.

Изследването сочи, че съществува сериозна нужда от подобряване на AI Content Detector инструментите, за да се повиши тяхната надеждност. Важно е да се адаптират към по-широк спектър от стилове на писане.

Това ще позволи по-точно разграничаване на човешките текстове от тези, които са генерирани от изкуствен интелект, както и ще подобри общата им ефективност в SEO практиката и други области.

Кои инструменти се използват най-често за текстове на български?

Има няколко основни AI Content Detectors, които се използват за разпознаване на съдържание на български език, генерирано от изкуствен интелект. Сред тях са именно тези, с които направихме проверка на двата текста по-горе, а именно – zerogpt.com, originality.ai, smodin.io, gptzero.me.

Те са популярни сред професионални писатели, студенти и преподаватели, които искат да проверят автентичността на текстове, разписани с ChatGPT, Claude, Gemini и други AI инструменти и да избегнат дигитална манипулация.

Един от тях обаче е най-широко разпространен, като при него има и една особеност. Това е Originality.ai, който предоставя няколко модела за проверка на различни типове текстове. Ето какво представлява всеки един според информацията в официалния сайт и за какво е предназначен да се използва:

- Lite 1.0.0 – осигурява баланс между висока точност и минимални фалшиви позитиви. Идеален за маркетинг съдържание, за което е важно да бъде оригинално, но също така ефективно оптимизирано с AI инструменти като Grammarly и AI-powered Content Optimization Tools;

- Turbo 3.1.0 – проектиран за строги политики срещу използването на AI. Предназначен е за издателски и журналистически дейности, изискващи почти пълна сигурност в произхода на съдържанието;

- Multi Language – това е стандартният модел за откриване на AI-генерирано съдържание на различни езици, като автоматично идентифицира езика на текста и прилага съответния алгоритъм за анализ. Този мултиезичен детектор е предназначен за организации и лица, работещи с многоезично съдържание, например на испански, немски, френски, португалски, италиански, руски, мандарин, японски, турски, гръцки, полски, персийски, холандски и виетнамски.

Изборът на правилния модел за откриване на AI съдържание зависи от специфичните нужди и контекст на употреба. В нашата работа, спрямо това описание, се счита, че е подходящ Lite 1.0.0, тъй като позволява използване на AI инструменти за подобряване на съдържанието, като същевременно поддържа контрол върху автентичността и целостта му. Българският език обаче не е сред поддържаните.

Има ли допустими проценти, които се приемат за нормални?

Допустимите проценти, които индикират дали текстът е генериран от AI, варират в зависимост от конкретния AI content detector. Ето какво включват общоприетите прагове и как се тълкуват:

- 0-30% вероятност – по-вероятно е текстът да е написан от човек или да има много лека редакция с AI инструменти, включващи предимно подобрения от граматическо естество.

- 30-50% вероятност – текстът може да съдържа елементи от AI проучване или контуриране на структурата, но все още вероятността да е написан от човек е по-голяма.

- 50-80% вероятност – текстът вероятно съдържа значителен обем, генериран от AI, като само част от него е редактирана от човек.

- 80-100% вероятност – по-вероятно е текстът да е генериран от AI и да няма редакторска намеса от човек.

Важно е да се отбележи, че тези проценти не са абсолютни и може да варират в зависимост от алгоритъма и модела на конкретния детектор. Поради това е важно резултатите да се интерпретират внимателно в контекста на съответния случай.

Какво казват от Google относно AI генерираното съдържание?

От Google имат определени насоки относно използването на AI за създаване на съдържание. Те споделят, че основният им фокус е върху възнаграждаването на висококачествено съдържание, демонстриращо E-E-A-T концепцията, а не върху това как то е създадено.

Има някои ключови точки, които трябва да се вземат предвид при публикуване на съдържание, генерирано с AI, включително:

- Качество на съдържанието

От Google подчертават, че съдържанието трябва да предоставя стойност на потребителите. Независимо дали е създадено от AI, или е написано от човек, то следва да е полезно, надеждно, информативно и грамотно написано.

- Спам и манипулации

Google има строги правила срещу спам и манипулативните практики. Съдържание, което е генерирано от изкуствен интелект или е написано от човек с цел манипулиране на класирането в търсачките, може да бъде санкционирано.

- Оригиналност и уникалност

Съдържанието трябва да бъде уникално и оригинално. AI инструментите често генерират текстове, които са комбинации от вече съществуващи източници, което може да доведе до проблеми с оригиналността.

- Прозрачност

Google препоръчва прозрачност при използването на AI за създаване на съдържание. Ако е генерирано от изкуствен интелект, не е лошо да се помисли това да бъде отразено в случаите, които го позволяват.

В крайна сметка от Google признават, че използването на изкуствен интелект е полезно, когато се третира като възможност за създаване на по-вълнуващо съдържание, което не е в противовес с техните правила и изисквания.

Защо е важно наличието на AI детектори за съдържание?

След като тези инструменти не са особено надеждни, защо да ги използваме? Ако AI съдържанието бъде оставено без контрол, въздействието от това би било значително. Ето до какво би довело в отделните случаи:

- за уеб сайтовете – Google наказва сайтове, които използват AI-генерирано съдържание за манипулиране на резултатите от търсенето. Детекторите помагат на сайтовете да се придържат към указанията на Google и да избегнат санкции;

- за писателите – без тях писателите ще се сблъскат с масова конкуренция от потребители на ChatGPT, което ще затрудни доказването на стойността на техните произведения;

- за образователните среди – неконтролираното използване на AI може да доведе до намаляване и обезценяване качеството на образованието;

- за маркетинговите агенции – AI детекторите улесняват комуникацията с клиенти, изискващи доказателства за автентичността на съдържанието;

- за AI детекторите – AI инструментите се обучават на големи бази данни от човешко съдържание. Ако тези бази данни се наситят с AI-генерирано съдържание, точността и разнообразието на бъдещите модели ще бъдат застрашени.

И така, нека обобщим. Все още няма точен модел детектор, на който да се доверим напълно – всички те показват проценти, които са вероятност, но не и 100% гаранция. Дори самите разработчици на AI Detectors призовават резултатите от проверката от техните инструменти да не се приемат като абсолютно твърдение, нито да се използват за предприемане на каквито и да е наказателни мерки.

Но, въпреки че инструментите за детекция на AI не са перфектни, те играят значителна роля в управлението на въздействието на генерираното съдържание от изкуствен интелект.

Прочетете повече за копирайтинг:

|

|

|---|---|

| 20 полезни инструмента, подходящи за SEO копирайтинг | Създаване на SEO текстове: как да пишем съдържание за хора |