Как бързо да оценим ефективността на снипети и бранд фрази

Как бързо да оценим ефективността на бранд фрази, да разберем качеството на нашите снипети и броя грешки сред линковете на сайтове-донори? Тези въпроси са болезнени, ако работите със среден или голям проект, а времето за събиране на информация е ограничено. Ние, от отдела за големи проекти в Netpeak, решихме да ускорим анализа на данни, които най-често проверяваме в Google Search Console: отчетът Search Analytics и грешките при сканиране. За тази цел създадохме специален инструмент. Той позволява бързо да се зареждат и анализират данни от Search Console. Най-важното за него е, че e напълно безплатен, за за разлика от Supermetrics, например.

Как да настроим инструмента за анализ на данни от Google Search Console

- Копирайте таблицата със скрипта на своя Google Диск. Натиснете «Файл» — «Създай копие». След това трябва да се настрои авторизация OAuth2 — скриптът използва тази технология за авторизиране в Search Console (ще се постараем да опростим процеса на авторизация в близко бъдеще).

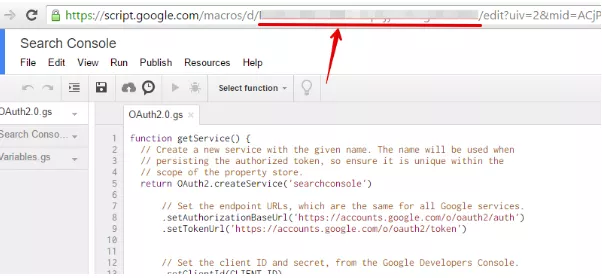

- Влезте в меню «Инструменти» — «Редактор на скриптове…».

- Включете Search Console API в своя Google акаунт. За да работи с API, трябва да го включите проекта в Google Developers Console, който е свързан със скрипта. За целта направете следното:

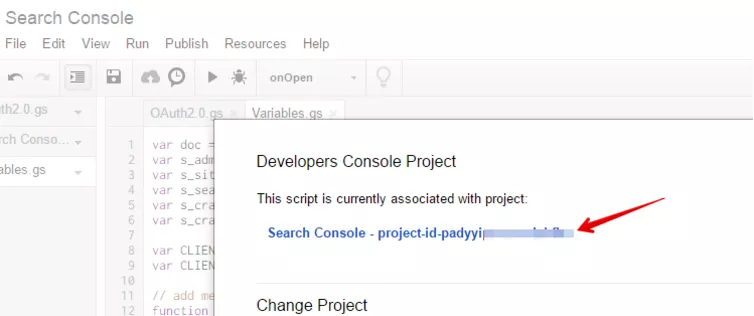

3.1. В Search Console отидете на секция «Ресурси» — «Проект Developers Console…».

3.2. Използвайте линка в отворилия се прозорец.

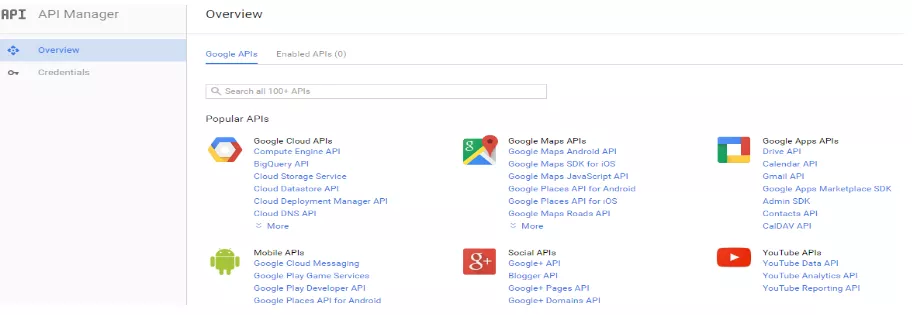

3.3. От линка ще се озовете в API мениджъра. Ако това не се е получило (Google често променя дизайна), намерете API мениджъра в менюто.

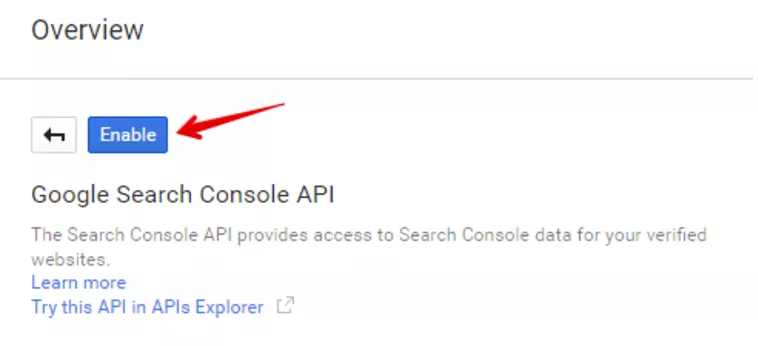

3.4. Въведете в полето за търсене Search Console API, кликнете върху името, а след това върху «Enable».

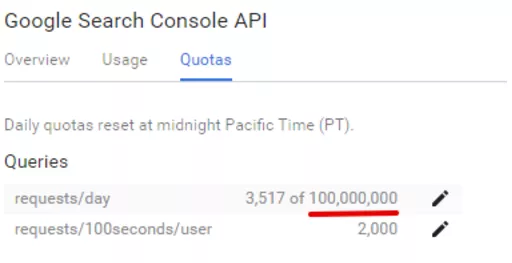

В API Search Console има ограничение до 100 000 000 заявки на ден. Но това е напълно достатъчно за ефективна работа. Затова не се безпокойте да използвате скрипта на пълни обороти.

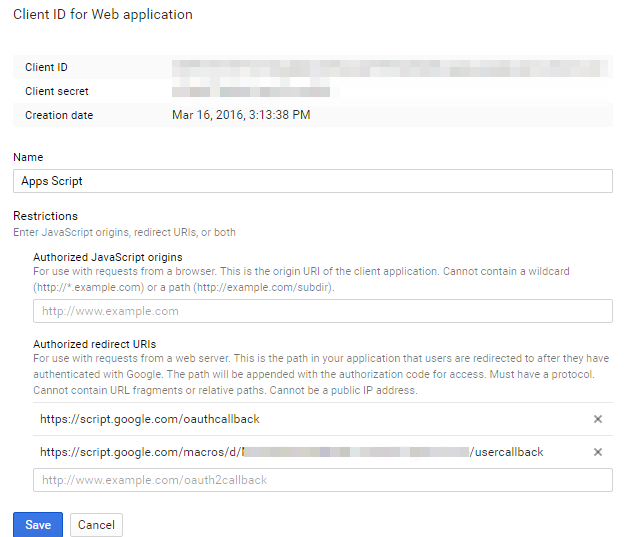

3.5. Преминете към връзка «Credentials». По подразбиране в списъка «OAuth 2.0 client IDs» трябва да има Client ID с название «Apps Script». Натиснете го.

3.6. За библиотеката OAuth2 трябва да се зададе «Authorized redirect URIs», който съответства на проекта на скрипта. Трябва да се въведе следният URL:

https://script.google.com/macros/d/{PROJECT KEY}/usercallback

Тук PROJECT KEY е ключът на Вашия скрипт. Можете да го намерите в URL след /macros/d/.

Копирайте и си запазете някъде «Client ID» и «Client Secret», те ще потрябват и по-нататък. Натиснете «Save».

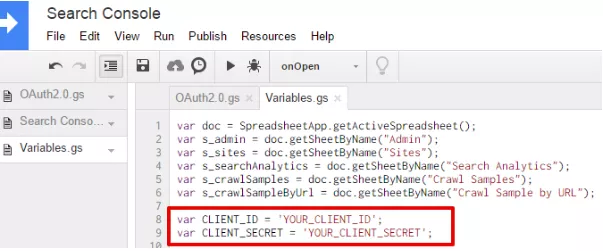

4. Включете услугата в проекта Apps Script. Във файла «Variables.gs» заменете «YOUR_CLIENT_ID» и «YOUR_CLIENT_SECRET» с данните, които имате за Client ID и Client Secret.

След това затворете прозореца с редактора Apps Script и се върнете към таблицата.

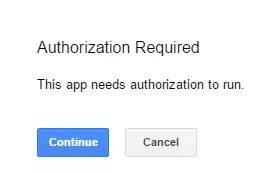

5. Преминаваме към авторизация. Стартирайте «Search Console» — «List Account Sites» в менюто. Ще видите такова съобщение.

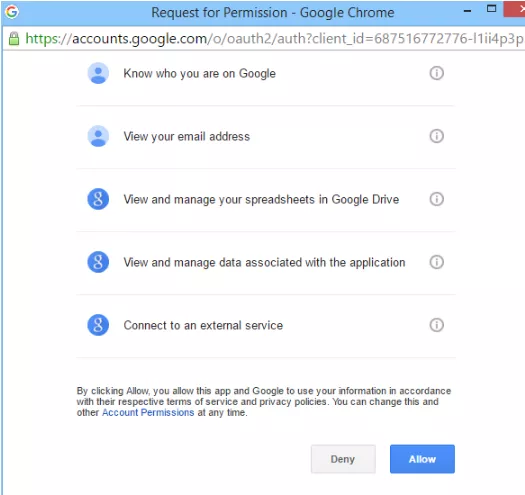

5.1. Натиснете «Продължи», а след това — «Разреши».

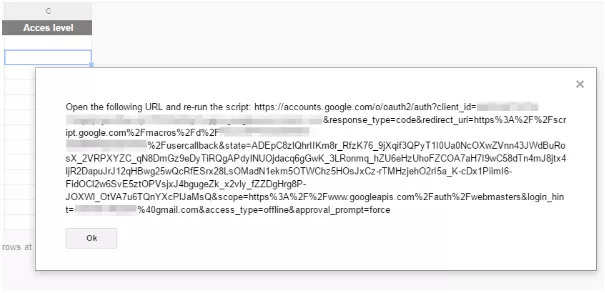

5.2. Ако всичко е правилно, в таблицата ще се появи такова съобщение:

Копирайте линка от съобщението и го отворете в браузъра.

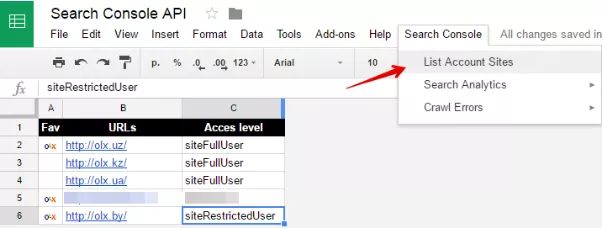

5.3. Разрешете достъпа до скрипта към Search Console. За да го направите, натиснете «Разреши», след отварянето на копирания линк в браузъра. Сега скриптът има достъп до Вашата Search Console. Можете да се върнете в таблицата и да пристъпите към работа. Пуснете още веднъж «Search Console» — «List Account Sites» в менюто, и във връзка «Sites» ще се появят всички сайтове, които имате във Вашия акаунт.

Как да използвате инструмента за анализ на данни от Google Search Console

Нашият инструмент, разбира се, не е толкова универсален, както приложението Supermetrics за Google Таблици, но може да изтегля грешки при сканиране и да събира данни за бърз анализ.

1. Как да заредите информацията за сайтовете във Вашия акаунт

Преминете към връзка «Search Console» и в падащото меню изберете «List Account Sites».

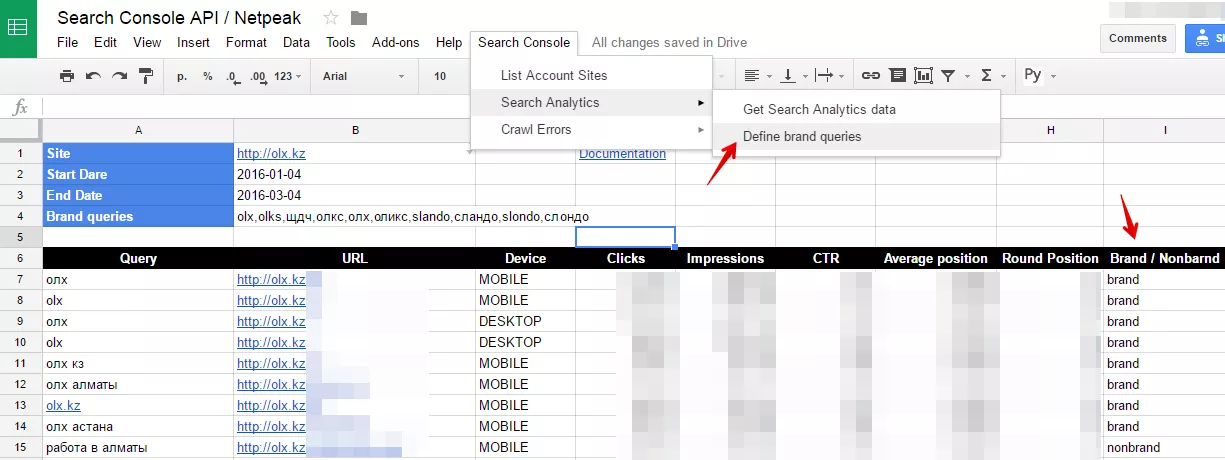

Скриптът може да изтегли данните от отчета Search Analytics за посочен ;период. За това трябва да се въведе в полето «Search Analytics» сайт и дата. След това да се премине по пътя «Search Console» — «Search Analytics» — «Get Search Analytics data».

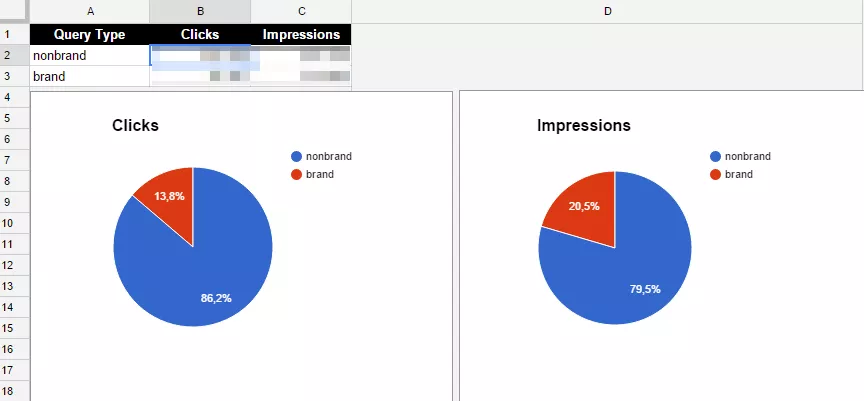

2. Как да определите ефективност на брандови/небрандови фрази

В скрипта има функция, която определя кои от изтеглените заявки съдържат името на бранда и кои не. За да покажете на скрипта как да определя името на бранда, вмъкнете в клетка B4 всички възможни вариации на името, разделени със запетайки (без интервали). Скриптът ще определи съдържа ли фразата някоя от тези комбинации. Например, за olx.kz бранд заявките могат да съдържат: olx, olks, оль, олкс, олх, оликс, slando, сландо, slondo, слондо.

Натискаме «Define brand queries». Във връзка «Brand Analysis» може да се види разпределението по показвания и кликове между заявките, съдържащи и несъдържащи името на бранда.

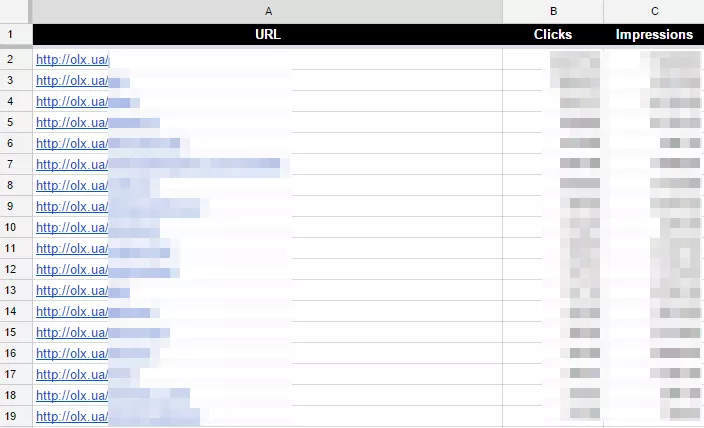

3. Как да групирате показвания и кликове по URL-адреси на страници

Връзката «Landing page» съдържа данни за показвания и кликове, групирани по URL адресите на страниците. Може да се анализира колко показвания и кликове получава определен URL.

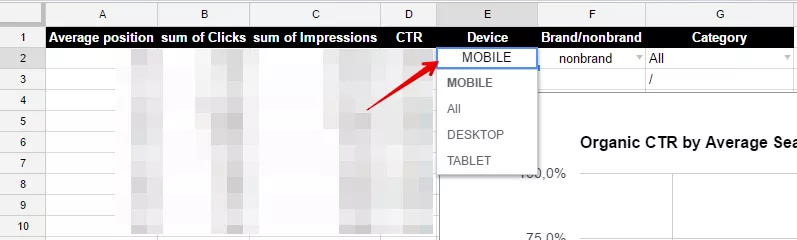

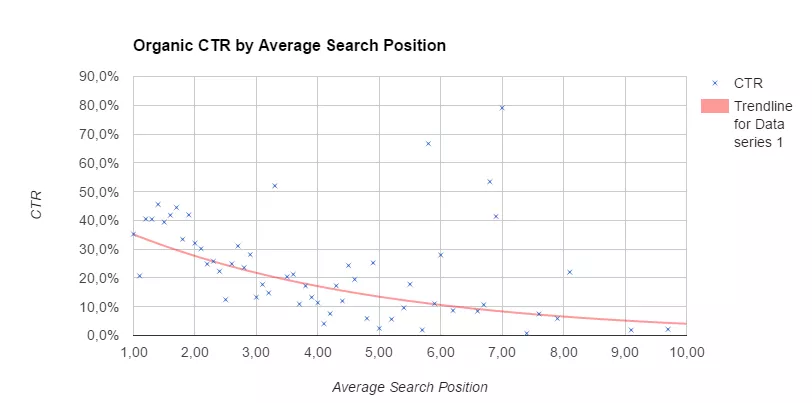

4. Как да анализирате в зависимост от CTR на заявките според позицията в резултатите от търсенето

Във връзка «CTR» може да се види зависимостта на CTR на заявките според позицията в резултата от търсене. Позициите на фразите са закръглени, за да се намали показаната база данни, но можете да промените закръглянето в колонката “Round Position” на листа “Search Analytics”. Може да групирате данните в зависимост от устройство или тип на заявка, променяйки параметрите в клетки E2 и F2.

За анализ на CTR по рубрики в сайта настройте избора на Вашите раздели в клетка G2. Можете да въведете името в колонка N, а частта от URL, която определя раздела, — в колонка O. Получаваме диаграма на зависимост на CTR според позицията в резултата от търсенето.

Както виждате, някои заявки могат да дават висок CTR дори при ниски позиции в резултата от търсене. Анализът на тези отклонения може да е полезен за подобряване на снипетите в останалите заявки.

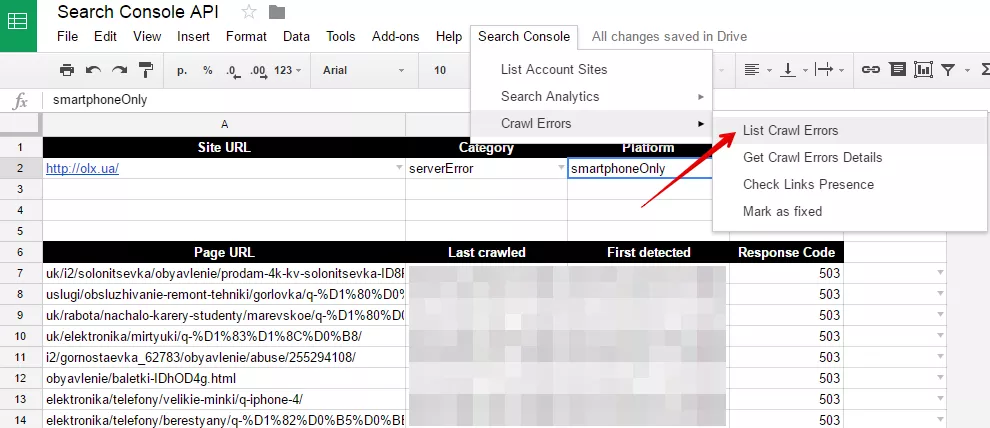

5. Как да направите анализ на намерените на сайта грешки

Методът «URL Crawl Errors Samples: list» позволява да се съберете грешките при сканиране от определен тип и платформа. Въведете сайт, тип, платформа и преминете по пътя «Search Console» — «Crawl Errors» — «List Crawl Errors».

5.1. Как да изтеглим списък със страници, които водят към URL с грешки при сканиране

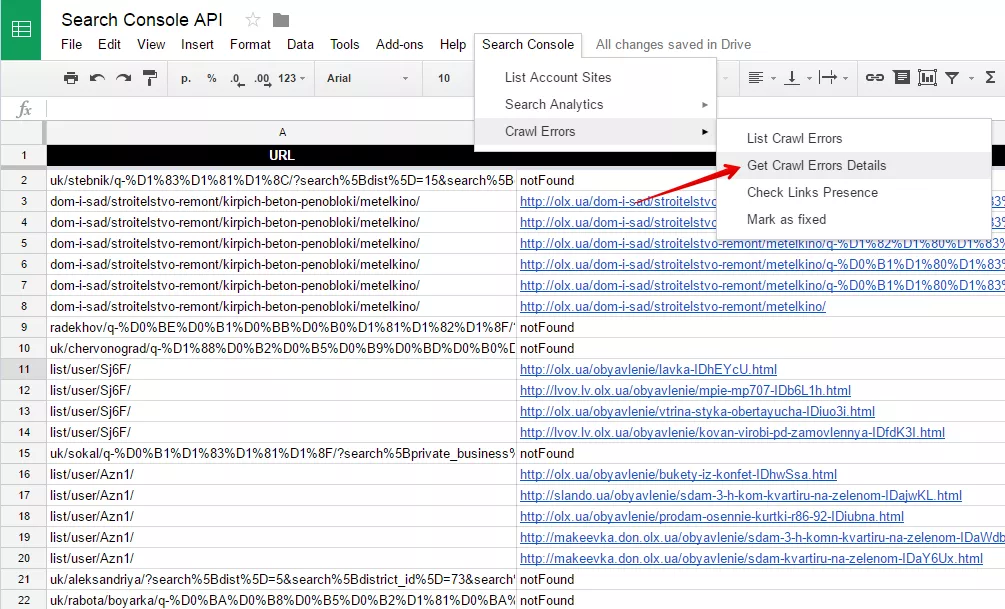

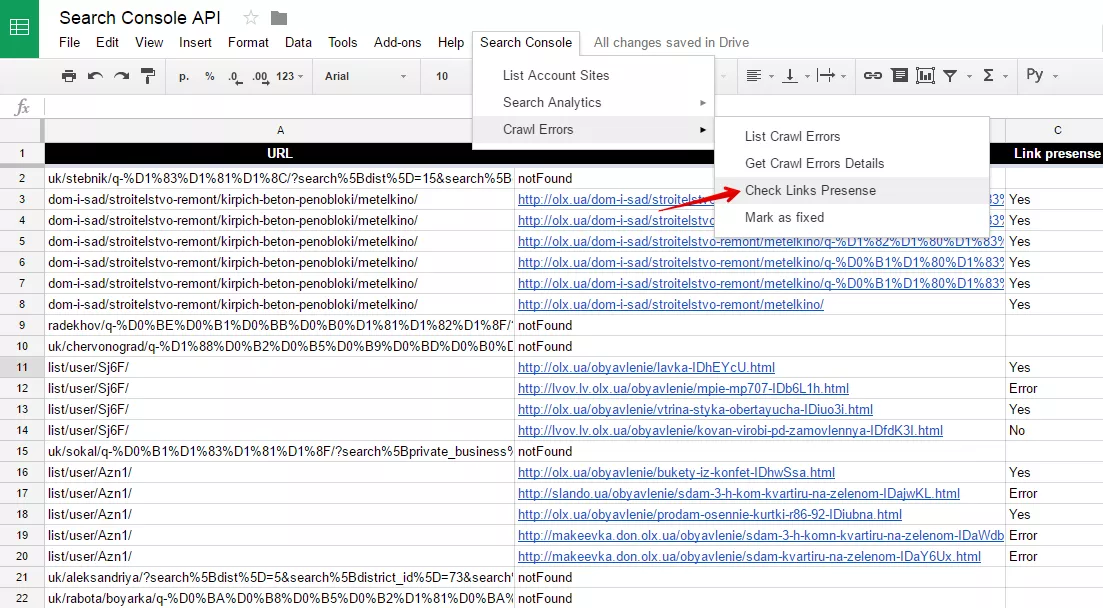

Ако искате да получите детайлна информация за проблемните URL адреси, отидете на «Search Console» — «Crawl Errors» — «Get Crawl Errors Details». Във връзка «Crawl Samples by URL» се показва списък с проблемните URL адреси и страници, които са намерени от googlebot.

5.2. Как да проверите актуалността на грешките при сканиране

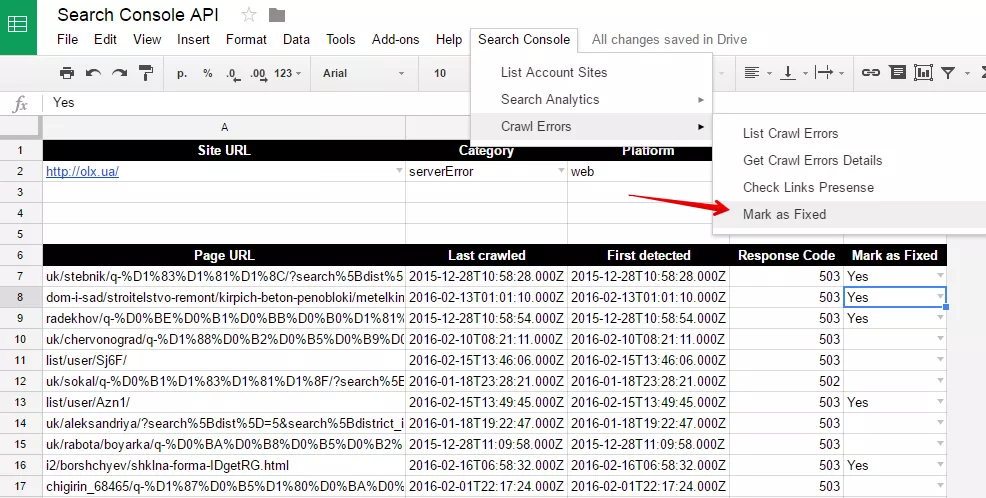

Често данните от Search Console за грешки при сканиране не са актуални. URL адресите с грешки при сканиране могат вече да не се намират там, където ги е намерил googlebot. За да проверите актуалността на намерените грешки, преминете по пътя «Search Console» — «Crawl Errors» — «Check Links Presense». Срещу всяка страница донор ще се появи съответното отбелязване:

Какво означават това отбелязване?

- «Yes» — страницата и до момента съдържа линк към страница с проблеми при сканиране;

- «No» — страницата вече не съдържа такъв линк;

- «Error» — страницата-донор връща отговор на сървъра за грешка «404», «500» или други.

Важно! Продължителността на работа на скрипта за проверка на линкове на страници-донори е 6 минути,

това е ограничение на Apps Script. За това време той може да провери до 100 URL-адреса.

5.3. Как да отбележите страниците без грешки в Google Search Console

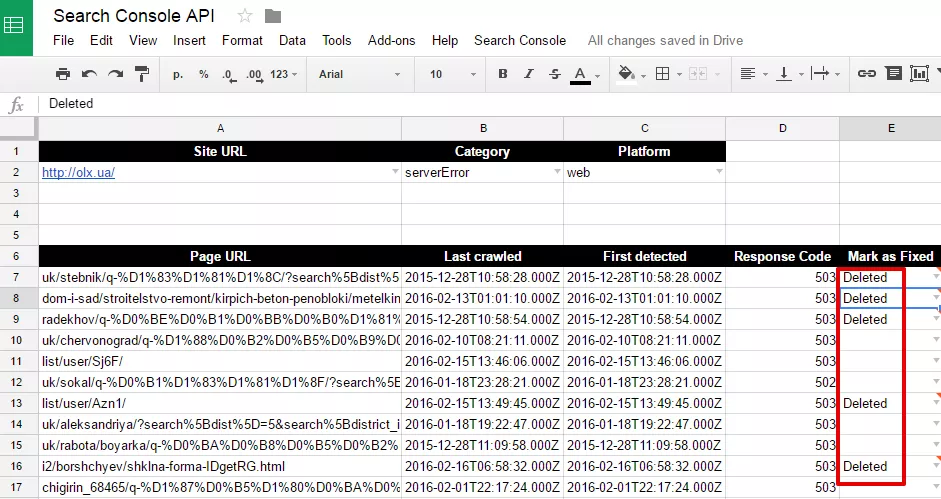

Ако проблемът вече е решен, за това може да се съобщи в Search Console. За целта, във връзка «Crawl Samples» отбележете в колона E значение «Yes» срещу нужните URL адреси. След това минете отново по пътя «Search Console» — «Crawl Errors» — «Mark as Fixed».

Ако всичко е преминало успешно, ще видите отметка «deleted» вместо «Yes»:

Готово!

Изводи

Какво умее нашият инструмент за анализ на данни от Google Search Console днес?

- 1. Определя ефективността на брандови/небрандови фрази.

- 2. Групира показвания и кликове по URL-адреси на страници.

- 3. Анализира зависимост на CTR на заявки според позиции в резултата от търсене (в селекции по устройства, тип на заявка и категории на сайта).

- 4. Изтегля списъка на страници, които водят до URL адреси с грешки при сканиране.

- 5. Проверява актуалността на грешките при сканиране.

- 6. Отбелязва страниците без грешки в Google Search Console.

Разбира се, в този скрипт, както и във всички останали, базирани на Google Apps Scripts, съществуват лимити при работа. Така, че за много сложни проекти е по-добре все пак да не пестите за платени инструменти. Ако този скрипт Ви помогне, моля, споделете статията с колеги и познати. Ще се радваме да получим от Вас обратна връзка за грешки и желания за нови функционалности.