Jak zaoszczędzić czas specjalisty podczas pracy nad dużym projektem — case OLX

“Czas się nie śpieszy — to my nie nadążamy.” - powiedział kiedyś Lew Tołstoj. Wiadomo dokładnie, czym specjaliści ds. reklamy kontekstowej zajmują się w dużych projektach większość czasu — przygotowaniem raportów, ręcznym opracowaniem danych otrzymanych za pomocą AdWords, Facebook i dziesiątków innych źródeł.

Postanowiłem zaoszczędzić czas zespołu reklamująсemu OLX za pomocą wdrożenia specjalnego narzędzia analitycznego.

Co postanowiliśmy zrobić?

Zautomatyzować proces zbierania i konsolidacji danych z Google, Facebook, MyTarget, AT Internet oraz AdJust według kategorii kampanii reklamowych, typów urządzeń a platform, i skonfigurować wizualizacje danych otrzymanych ze wszystkich przeliczonych źródeł, z możliwością dostępu do raportów online.

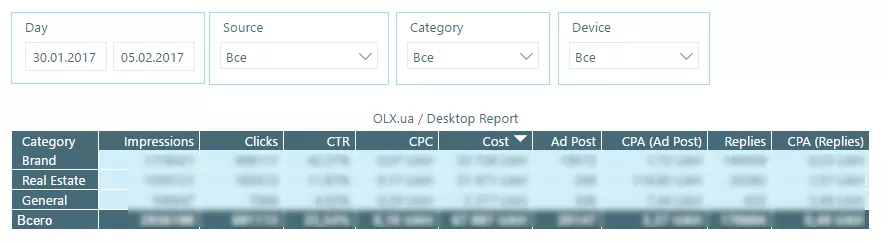

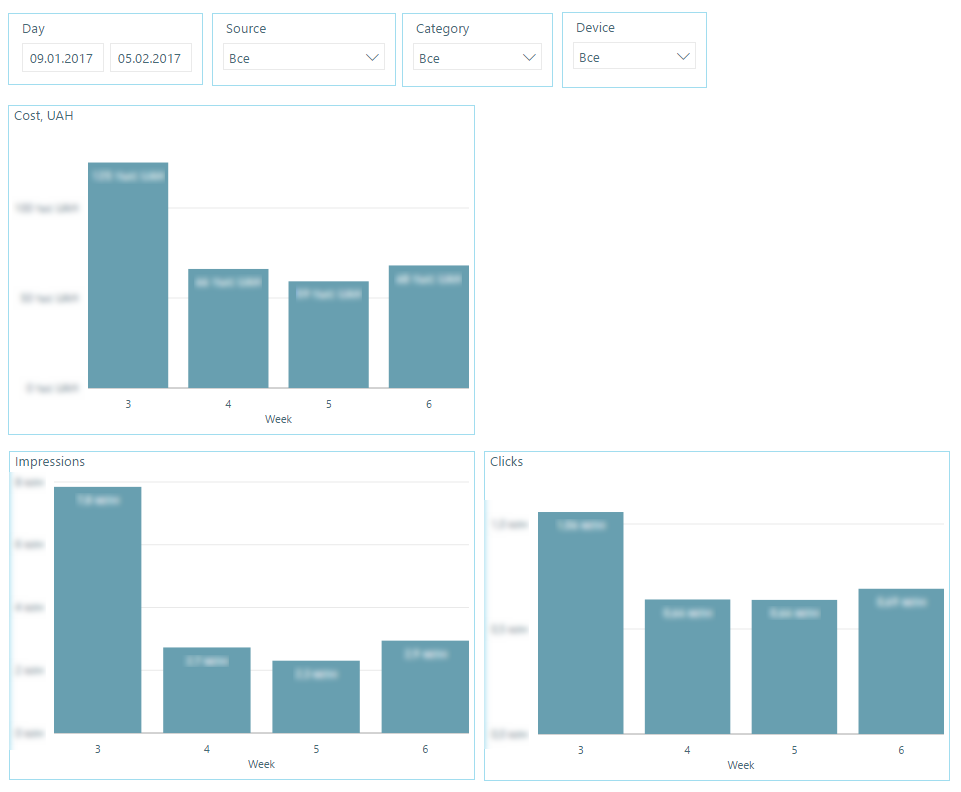

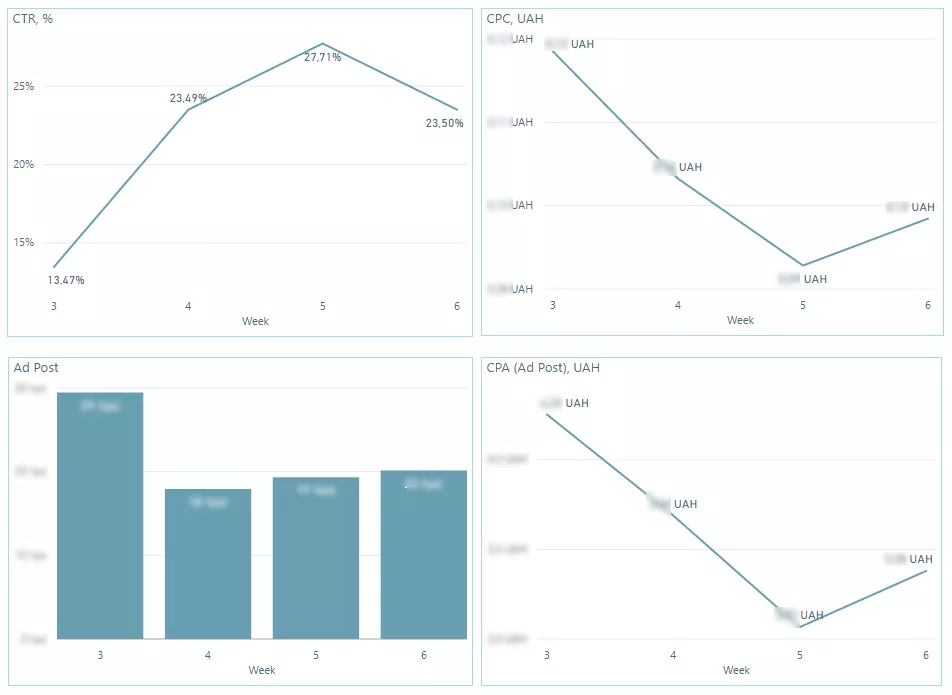

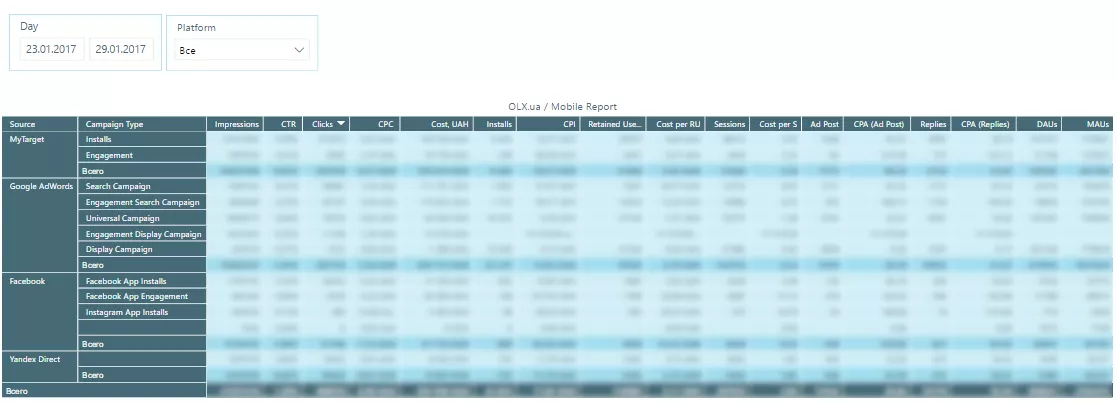

W rezultacie mieliśmy otrzymać dwa raporty: dla reklamy desktopowej i dla mobilnej.

Trochę więcej na ten temat:

Do tabeli przeznaczonej dla reklamy desktopowej zbieraliśmy informacje na temat promocji w zależności od kategorii kampanii reklamowych (brandowe, ogólne kampanii), typów urządzeń oraz źródeł.

Główne wskaźniki:

- Day — dzień, w którym została zebrana statystyka;

- Source — platforma reklamowa / źródło;

- Device — typ urządzenia;

- Category — kategoria kampanii reklamowej;

- Impressions — odsłony;

- Clicks — liczba kliknięć;

- Cost — koszt;

- AdPosts — liczba rekłam na stronie;

- Reply — liczba otrzymanych odpowiedzi.

Źródła danych:

- Google AdWords — dane, dotyczące kliknięć, odsłon i wydatków na reklamę;

- AT Internet — dane dotyczące publikacji a odpowiedzi na ogłoszenie.

Do tablicy, przeznaczonej dla reklamy mobilnej, zbieraliśmy ibformacji dotyczące promocji aplikacji w zależności od źródeł, typów kampanii reklamowych i platform (Android, iOS).

Główne wskaźniki:

- Day — dzień, w którym została zebrana statystyka;

- Source — źródło;

- CampaignType — typ kampanii reklamowej;

- Platform — platforma Android lub iOS;

- Impressions — odsłony;

- Clicks — liczba kliknięć;

- Cost — wartość;

- Installs — liczba pobrań;

- DAUs — średnia liczba aktywnych użytkowników w ciągu jednego dnia;

- MAUs — średnia liczba aktywnych użytkowników w ciągu jednego miesiąca;

- RetainerUsers — liczba użytkowników, co powrócili do aplikacji;

- CohortsSessions — liczba sesji powracających użytkowników;

- CohortsAdPost — liczba szerów powracających użytkowników;

- CohortsReplies — liczba polubień i komentarzy powracających użytkowników.

Źródła danych:

- AdWords — kliknięcia, odsłony, wartość;

- Facebook — kliknięcia, odsłony, wartość;

- MyTarget — kliknięcia, odsłony, wartość;

- AdJust — pobrania, liczba powracających użytkowników, liczba sesji powracających użytkowników, liczba szerów powracających użytkowników, liczba polubień i komentarzy powracających użytkowników, DAUs, MAUs.

Z których narzędzi korzystałem?

- Język R — do zbierania informacji ze wszystkich źródeł za pośrednictwem API, konsolidacji oraz przechowywania danych.

Jakie pakiety języku R wykorzystałem?

- RAdwords — API Google AdWords;

- adjust — API AdJust;

- rfacebookstat — API Facebook;

- rmytarget — API MyTarget.

- Google BigQuery — bardzo łatwa w użyciu baza danych w chmurze. Nie wymaga żadnego dodatkowego administrowania. Ponadto, jest warunkowo bezpłatna.

- Microsoft Power BI — darmowe narzędzie do wizualizacji danych.

Co się udało?

Napisałem dwa skrypty, które zbierają wszystkie dane, konwertują je na jedną walutę (UAH) i zapisują do Google BigQuery. Do BigQuery podłączyliśmy konto w Power BI. W rezultacie, w każdej chwili można zaktualizować wszystkie dane za pomocą jednego przycisku i dzielić się nimi z zespołem naciskając przycisk „Opublikuj”.

Jak pracuje to narzędzie?

- Od poniedziałku do piątku skrypty R są automatycznie uruchamiane w celu zbierania i konsolidacji danych ze wszystkich źródeł za pośrednictwem API.

- W trakcie zbioru danych do Google BigQuery zapisują się logi związane z pracą skryptów zbierających informacji za pośrednictwem API.

- Uruchamia się skrypt R, który sprawdza logi związane z pracą zbierających informacji skryptów.

- Jeżeli wśród logów znaleziono błędy lub ostrzeżenia związane z tym, że dane mogą być zebrane w sposób nieprawidłowy, automatycznie generuje się komunikat z informacją, dotyczącą błędów i ostrzeżeń. Komunikat jest wysłany do odpowiedniego specjalisty i projektanta.

- Jeśli podczas sprawdzaniф nie były znalezione problemy, wtedy zebrane dane przenoszą się do odpowiednich tablic Google BigQuery.

- Dane są aktualizowane i publikowane za pomocą dwóch przycisków.

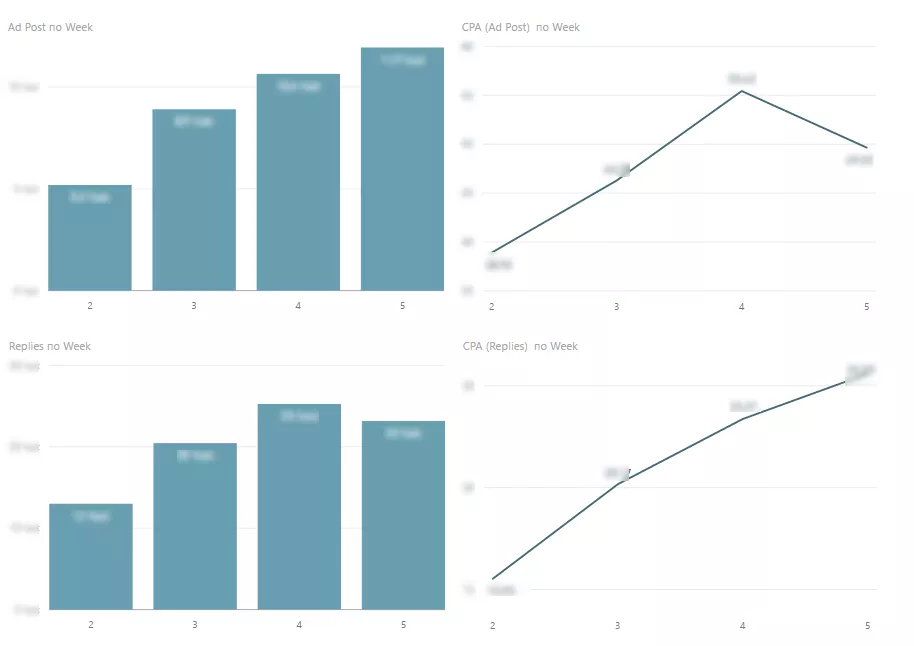

Tak wygląda raport dotyczący reklamy desktopowej:

Raport dotyczący reklamy mobilnej:

Projektowanie instrumentu zajęło 30 godzin, ponieważ wiele czasu poszło na konfigurację zbioru danych z sześciu źródeł. Zwykle dane są zbierane z dwóch lub trzech źródeł, a projektowanie potrzebuje o wiele mniej czasu: 10-15 godzin.

Wyniki:

- Wcześniej zbiór danych, składanie i sprawdzanie raportów ręcznie zajmowały specjalistom około 30 godzin miesięcznie. Dzisiaj — kilka minut.

- Wcześniej raporty były aktualizowane tygodniowo, teraz — codziennie.

“Podczas pracy z dużymi projektami, prędzej czy później przychodzi czas, kiedy zaczynasz tonąć w morze raportów. Załóżmy, że już wiesz, jakie wskaźniki i metryki należy analizować, jednak jeśli przygotowywać raporty ręcznie, masz co najmniej dwie problemy:

- Czynnik ludzki — nikt nie jest odporny na błędy.

- Czas — zbieranie i konsolidacja wszystkich danych zajmuje bardzo dużo czasu na stałe.

Po automatyzacji otrzymaliśmy, po-pierwsze, zawsze aktualne i prawidłowe dane, i, po-drugie, czas wolny, który obecnie nie tracimy na przygotowanie raportów, tylko wykorzystujemy dla rozwoju projektu.

Powiązane artykuły

Jak wybrać wykonawcę SEO i PPC: zatrudnić agencję lub stworzyć własny zespół

Chcę podzielić się tym, co Netpeak wymyślił przez lata w SEO i PPC.

Historia sukcesu Amrity: przychody wzrosły o 172,72%, liczba sesji wzrosła o 96,05%

Promocja monobrandu: cechy, trudności, pułapki.

Secunda Success Story: Jak uzyskać 400% ROI kampanii za pomocą ukierunkowanych reklam na Facebooku

Format reklamy Instant Experience z połączonym katalogiem produktów i nie tylko.