Внешняя ссылочная масса — один из факторов ранжирования, вокруг которого ведутся бесконечные дискуссии: о качестве, количестве, идеальном соотношении nofollow и dofollow, анкорах. Единого мнения нет, как и идеальной стратегии. Специалисты с опытом вырабатывают собственный подход для каждого проекта и тематики.

О чем не спорят, так это о том, что вредные ссылки нужно удалять. В этом посте расскажем, как понять, что ссылки «плохие», а потом избавиться от них.

Ссылки нужно не только наращивать, но и постоянно мониторить качество уже существующих. Почему? Они могут стоять на страницы с кодом ответа отличным от 200. Например, на страницы ошибок, страницы с множественными редиректами и прочее. Чтобы не терять вес внешних ссылок такие ошибки нужно устранять.

Кроме того со временем качество площадок может меняться. Например, вы тяжким трудом в далеком 2015 получили ссылку с сайта siteA.com с текстовым анкором, которая была полезная не только для SEO, но и для пользователей. На тот момент показатели у сайта siteA.com были замечательными, но в 2018 году siteA.com уже:

- Побывал под фильтром АГС.

- Содержит внешние ссылки на множество низкокачественных ресурсов.

- Растерял все свои показатели и выглядит как типичная спам площадка.

Ссылку с такого сайта нужно снять.

Как собрать все внешние ссылки на свой сайт?

Собирать внешние ссылки нужно из всех доступных источников. Основные инструменты и способы сбора:

Search Console

Чтобы получить выгрузку следует:

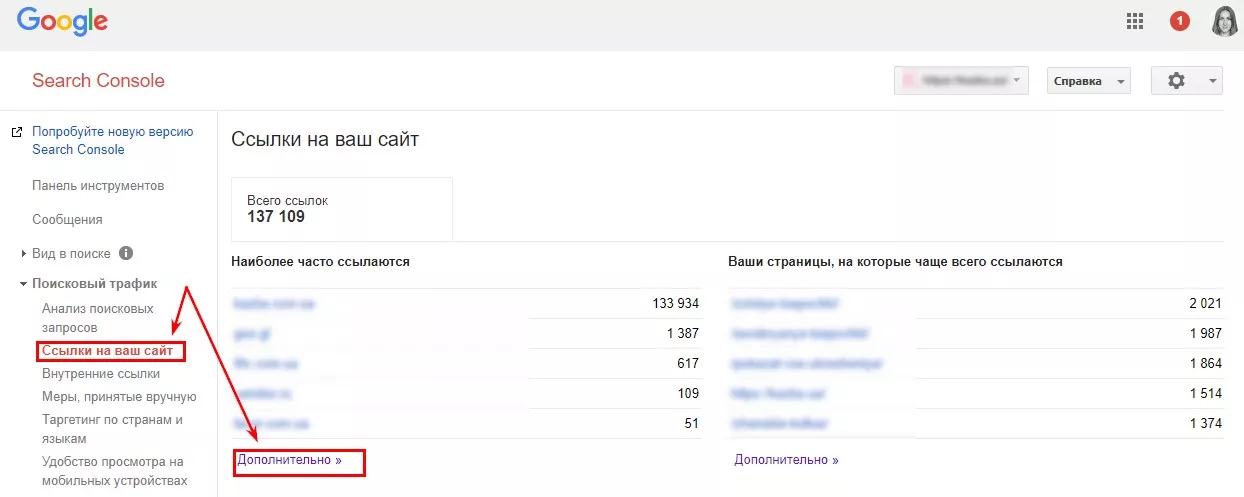

- Перейти в Search Console и выбрать нужный ресурс.

- В разделе «Поисковый трафик» выбрать «Ссылки на ваш сайт».

- Нажать «Дополнительно»:

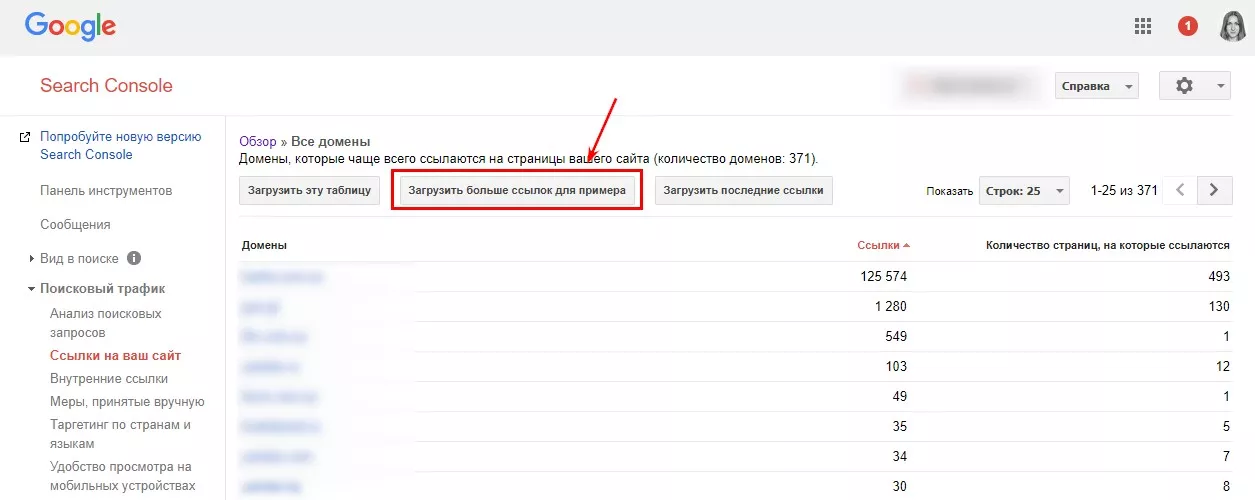

- Выбрать пункт «Загрузить больше ссылок для примера» и получить выгрузку. Она может быть в двух форматах: CSV или Google Документы. Определяйтесь, с каким форматом удобнее работать.

- Выгрузка со всеми страницами, на которых, по мнению Google, есть или была ссылка — готова.

Ahrefs

Пожалуй, самый популярный сервис. Здесь можно посмотреть динамику ссылочной массы, начиная с 2013 года. А выгрузка возможна в двух форматах: csv и pdf.

Переходим на ahrefs.com и вводим нужный нам адрес сайта. Выбираем тип отображения информации: «протокол», «домен с субдоменами», «домен без субдоменов», «раздел сайта».

При анализе ссылочной массы рекомендуем вариант «http+https» и даже если у сайта нет поддоменов, выбирать тип анализа «домен со всеми субдоменами». Сюда войдут ссылки на разные комбинации (если таковые были):

- https://site.com;

- https://www.site.com;

- https://www.site.com;

- https://site.com.

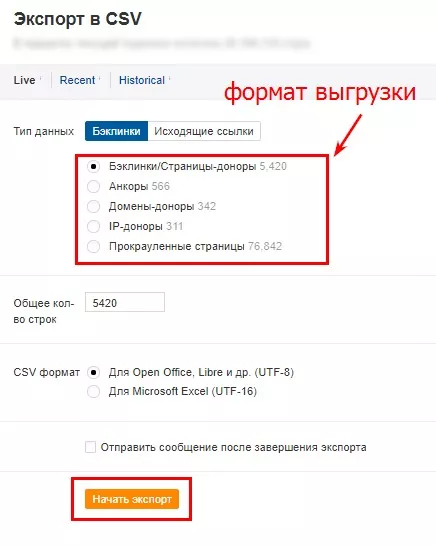

Идем в раздел «Экспорт» и указываем формат csv. Выбираем данные для выгрузки, которые будем анализировать:

Для каждой задачи — свой формат. Например, для общего анализа выделяем только некачественные домены, не заморачиваясь на анализ анкоров и ограничиваемся выгрузкой «Домены-доноры». Для детального анализа следует учитывать параметры качества площадки и анкоры ссылки — и здесь понадобится выгрузка «Бэклинки/Страницы доноры».

Для нашего блиц-анализа выгружаем только «Домены-доноры».

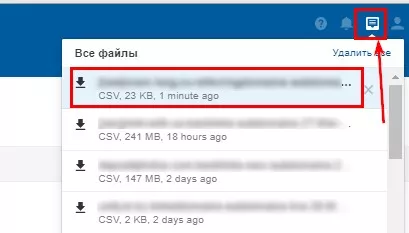

Процесс выгрузки завершен — в правом верхнем меню выбираем «Все файлы» и скачиваем выгрузку нужного проекта:

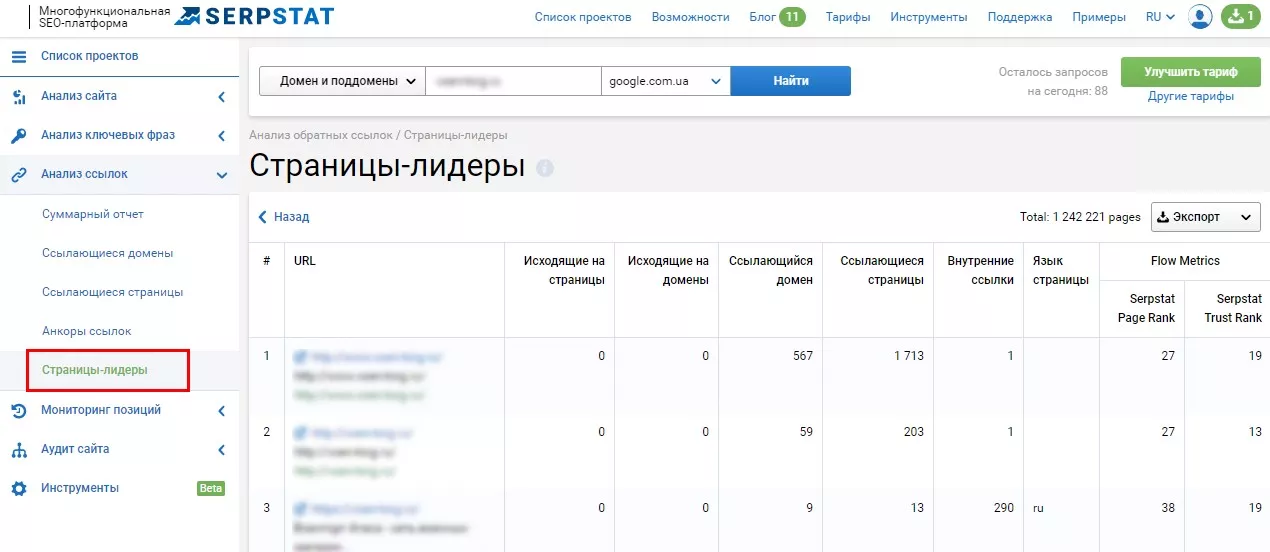

Serpstat

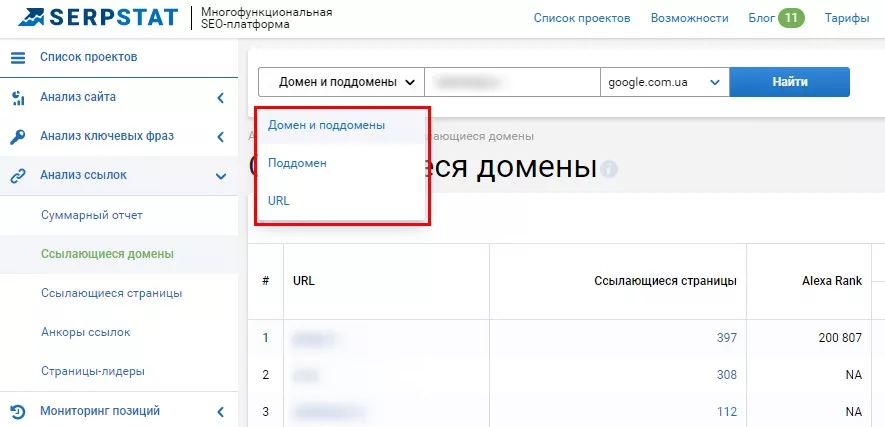

Переходим на сайт Serpstat. Вбиваем адрес сайта, выбираем нужный режим анализа: «домен и поддомены», «поддомен», «URL». Для данного блиц-анализа — «Домен и поддомены»:

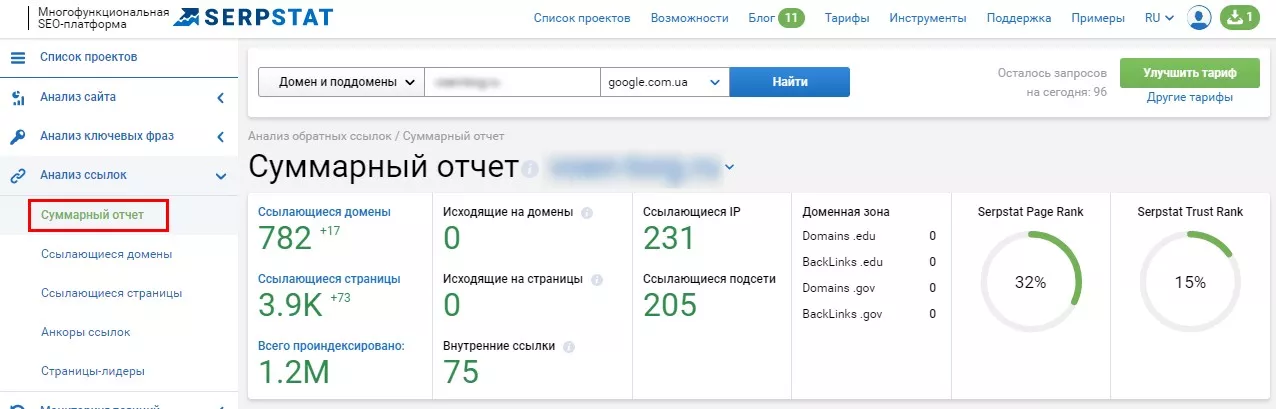

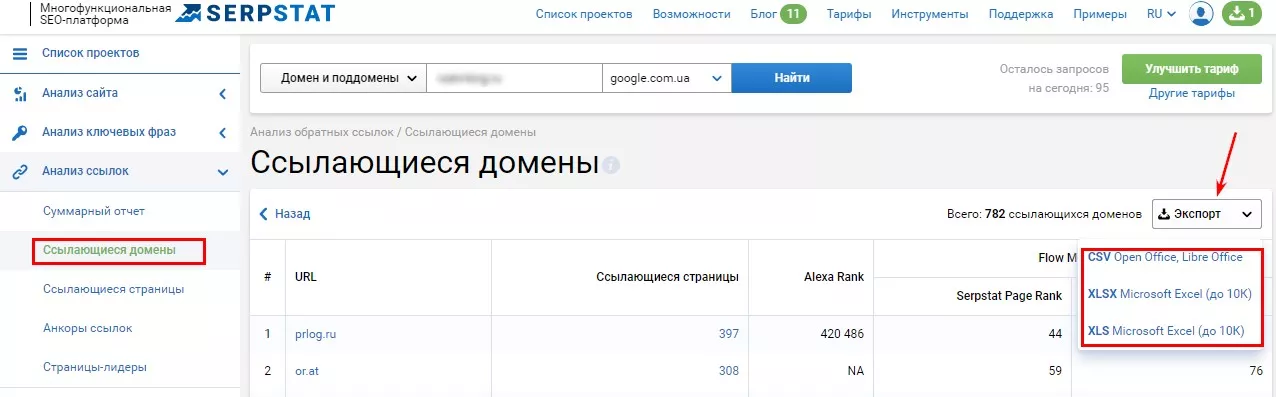

Переходим в раздел «Анализ ссылок». Здесь доступны:

- суммарный отчет. Сводка с диаграммами по общей картине ссылочной массы;

- ссылающиеся домены. Список всех доменов, с которых есть внешние ссылки. Для экспресс-анализа достаточно этого отчета;

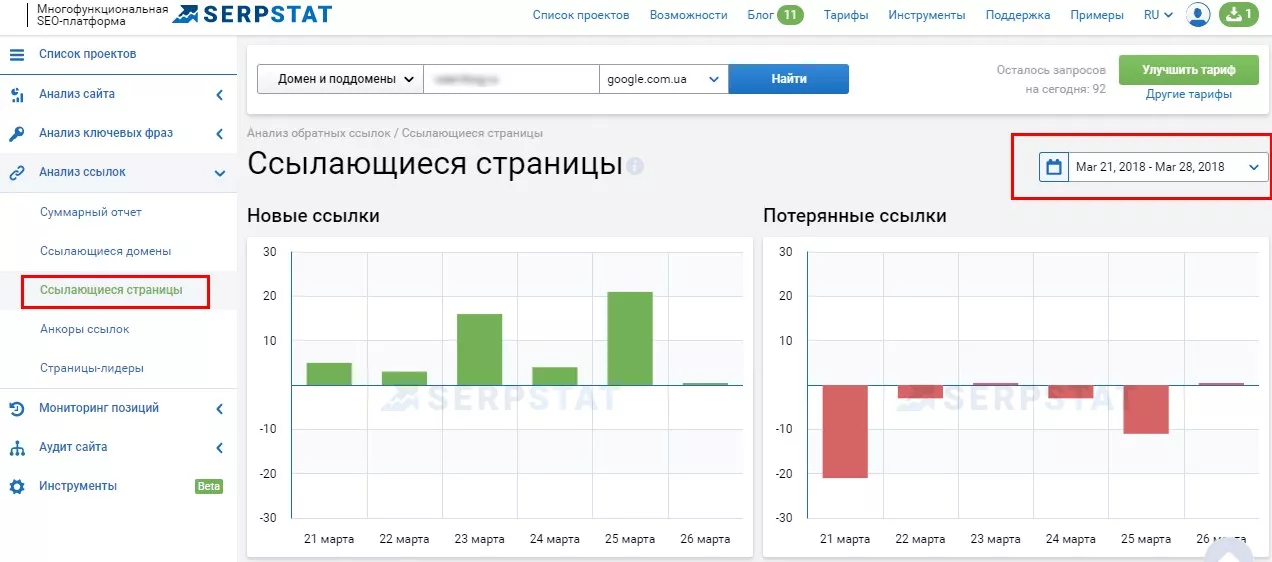

- ссылающиеся страницы. Список внешних ссылок с примерами URL. Можно выбрать временной диапазон не ранее трех месяцев;

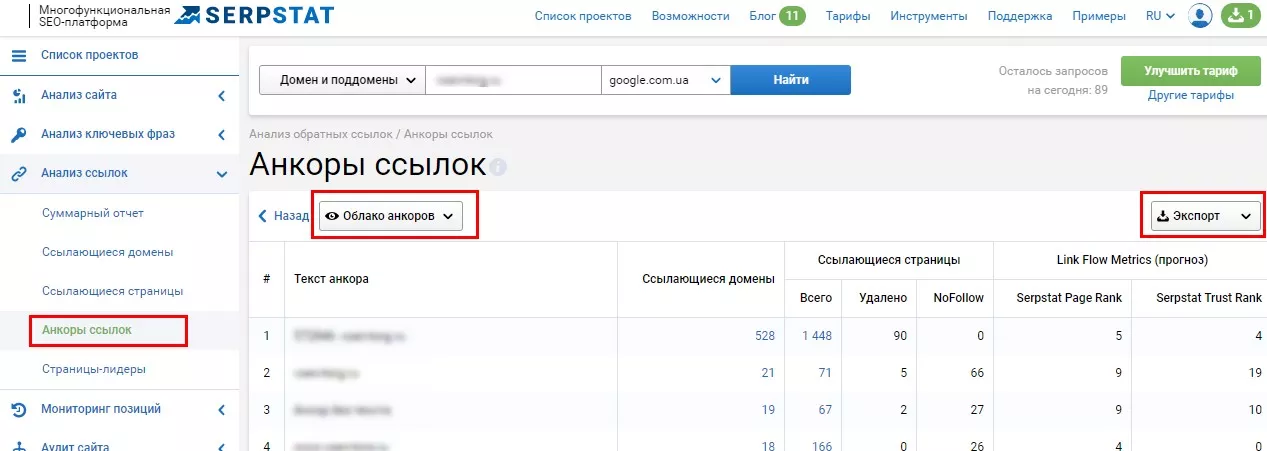

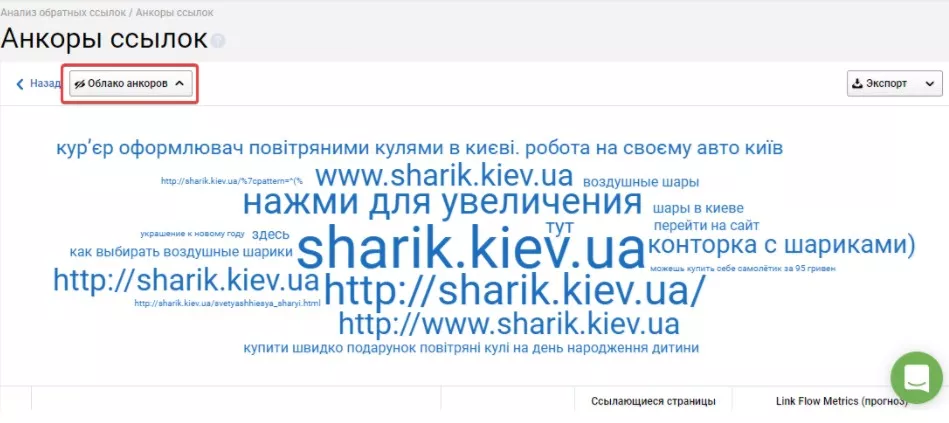

- анкоры ссылок — анализ анкоров для внешних ссылок сайта;

Удобно анализировать анкоры в виде «Облака анкоров» — самый частотный анкор будет самым «большим».

- страницы-лидеры. В этом отчете будут отфильтрованы страницы, у которых большое количество внешних ссылок. Как правило, страницы-лидеры — это главные страницы сайта и приоритетные категории.

Как проанализировать домены?

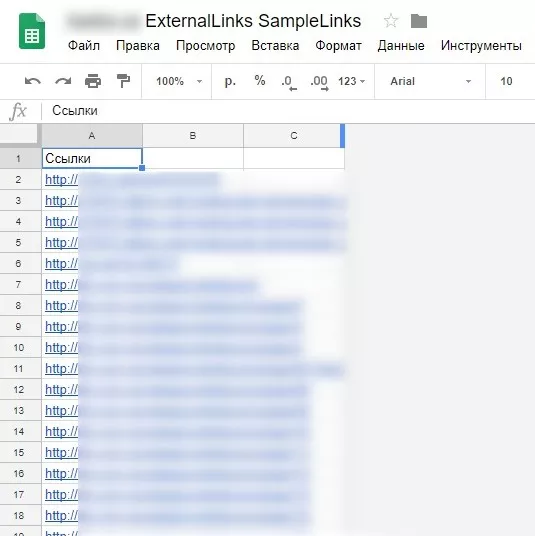

Чтобы приступить к анализу, нужно привести все выгрузки к единому формату. Удобнее всего объединить их в таблице Google.

Каждую выгрузку можно поместить на отдельную вкладку, также создать отдельную вкладку для анализа. Сюда переместить все домены для анализа.

- Удаляем дубликаты. Так, как выгружали из разных источников, домены будут повторятся. Чтобы не анализировать несколько раз один и тот же домен, нужно оставить только уникальные значения в таблице.

- Приводим все данные к единому формату. Нам нужны для анализа домены, поэтому следует убрать все лишнее. Можно использовать готовые плагины для электронных таблиц, регулярные выражения — любой удобный вариант.

- Полученный список готов для анализа.

Как собрать параметры для анализа?

На этом этапе нужно собрать параметры для анализа. Собирать будем только основные.

Список основных параметров

|

№ |

Параметр |

Чем собрать? |

|

1 |

Траст сайта |

Checktrust |

|

2 |

Спам сайта |

Checktrust |

|

3 |

Whois возраст |

Netpeak Checker, Checktrust, на сайте who.is |

|

4 |

Google индекс |

вручную оператором site:site.com (для Google), Сhecktrust, Netpeak Checker |

|

5 |

Citation Flow |

Netpeak Checker (нужен будет API для Majestic), Сhecktrust |

|

6 |

Trust Flow |

Netpeak Checker (нужен будет API для Majestic), Сhecktrust |

|

7 |

Входящие/исходящие уникальные ссылки |

Netpeak Checker (нужен будет API для Ahrefs), Сhecktrust, RDS бар |

|

8 |

Количество посетителей из разных каналов Similarweb |

Плагин SimilarWeb, на сайте similarweb.com, Сhecktrust |

Показатели основных параметров

- Citation Flow — уровень цитирования сайта по данным Majestic от 0 до 100, определяет количество и качество внешней ссылочной массы донора;

- спам сайта — это субъективный показатель качества внутренней оптимизации. На него влияет количество проиндексированных страниц, внешних ссылок с сайта и так далее. Варьируется параметр от 0 до 100. От 12 до 100 считается плохим показателем;

- траст сайта — уровень доверия. Это субъективный параметр со шкалой от 0 до 100. Оценивает «траст сайта» общее качество ссылочного профиля. Если на сайт ссылаются только качественные ресурсы, уровень доверия будет приближаться к 100 и наоборот. Значение от 30 и выше считается хорошим показателем;

- Whois возраст — время существования сайта. Измеряется в днях, или выводится в виде даты регистрации. Если сайт создан только вчера, нужно уделить ему больше внимания. У такого сайта будут отличаться показатели качества — сервисы не могут моментально выставить ему «оценки».

- Google индекс — количество страниц в индексе поисковой системы. Иногда параметр показывает процентное соотношение. Если у сайта проиндексировано всего 10% страниц, задумайтесь над качеством донора;

- Trust Flow — уровень доверия сайта по данным Majestic от 0 до 100, определяет качество ссылочного профиля донора по данным Majestic. У параметра нет нижнего/верхнего предела. У донора среднего качества показатель, как правило, от 10 и выше;

Между Trust Flow и Citation Flow не должно быть большой разницы. Если показатели сильно отличаются (например, в два раза), велика вероятность спамных методов наращивания ссылочной массы. В таких случаях нужен более детальный анализ.

- входящих/исходящих уникальных по данным Linkpad — количество входящих или исходящих ссылок для донора по данным Linkpad. Рекомендуется, чтобы количество входящих ссылок было большее, чем исходящих. Каждая исходящая ссылка отдает «вес» сайту на который ссылается. Поэтому, если грубо оценивать качество ссылочной массы, количество входящих ссылок должно быть больше, чем количество исходящих;

- количество посетителей из разных каналов Similarweb — такие параметры отображают численный или процентный показатель трафика по разным каналам. Например, есть площадки, которые получают только реферальный или платный трафик, а органического нет. Значит позиции и семантический охват у сайта на низком уровне, хотя по остальным параметрам он будет выглядеть привлекательным донором. Нужно индивидуально подходить к этим параметрам в зависимости от целей.

Сортировать параметры удобно, используя фильтры и формулы.

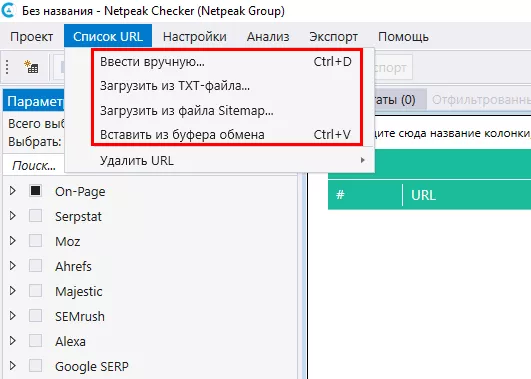

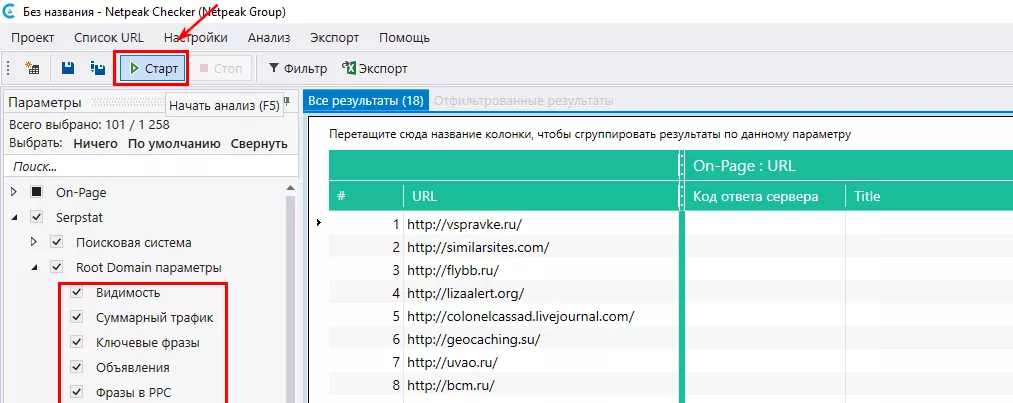

Netpeak Checker

Удобный, быстрый. Netpeak Checker собирает параметры из разных систем: Serpstat, Moz, Ahrefs, Majestic, SEMrush. Для сбора данных нужен будет доступ по API к сервисам. Загружаете список доменов любым способом:

Выбираете на панеле слева нужные параметры и кликаете «Старт»:

Все значения будут вынесены в таблицу, которую можно выгрузить.

Бесплатный пробный период — 14 дней.

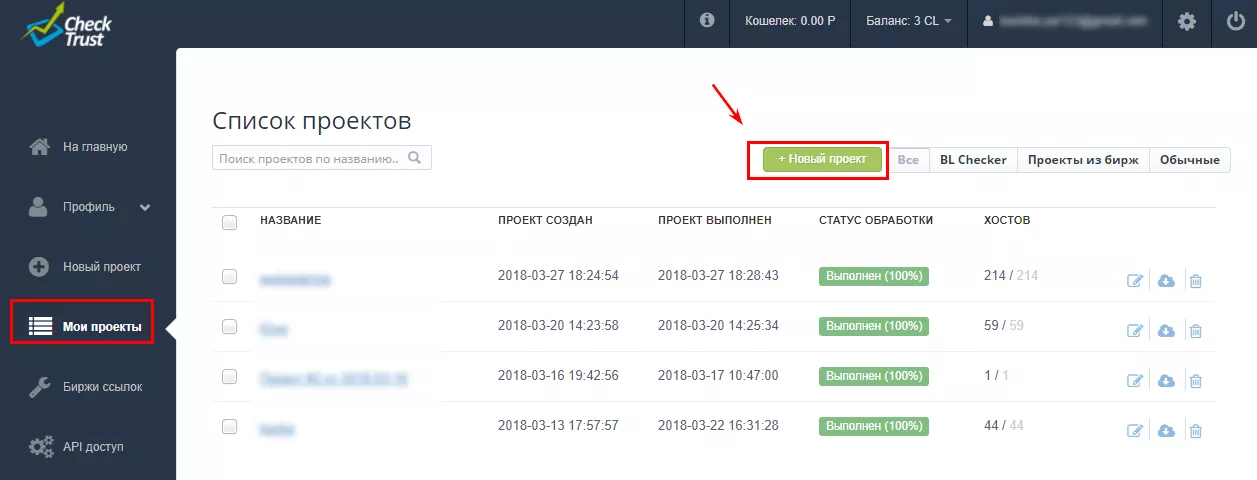

Сhecktrust

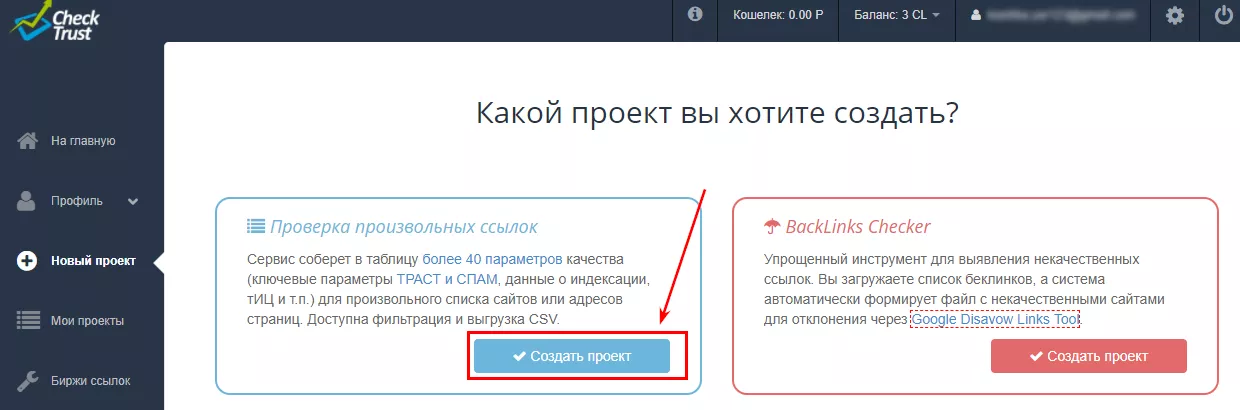

- Создаете новый проект «Проверка произвольных ссылок»:

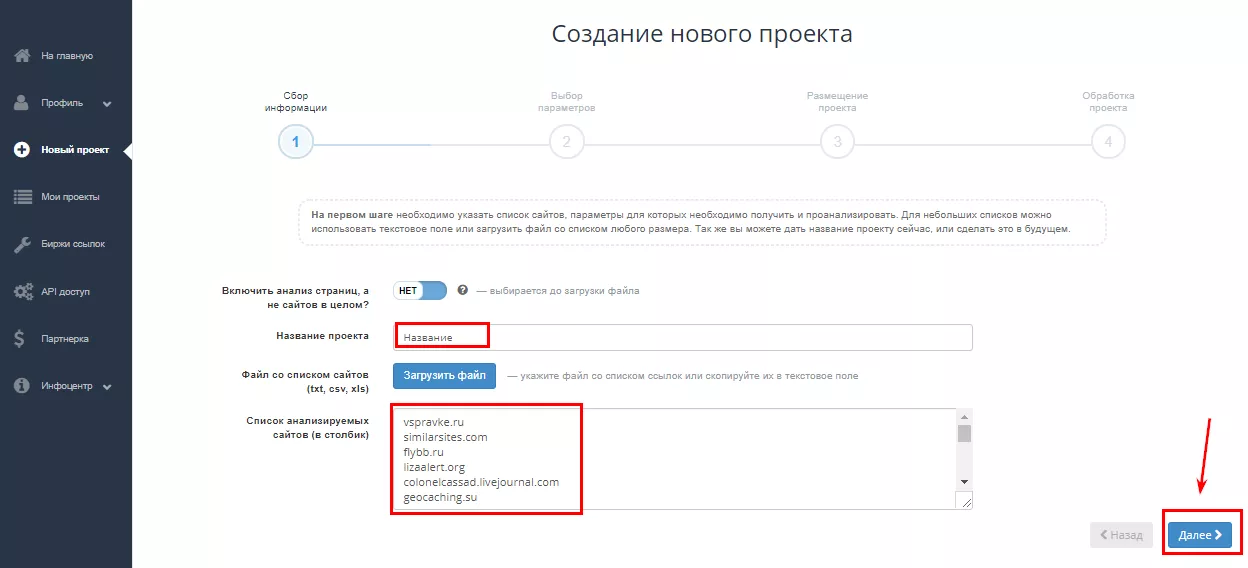

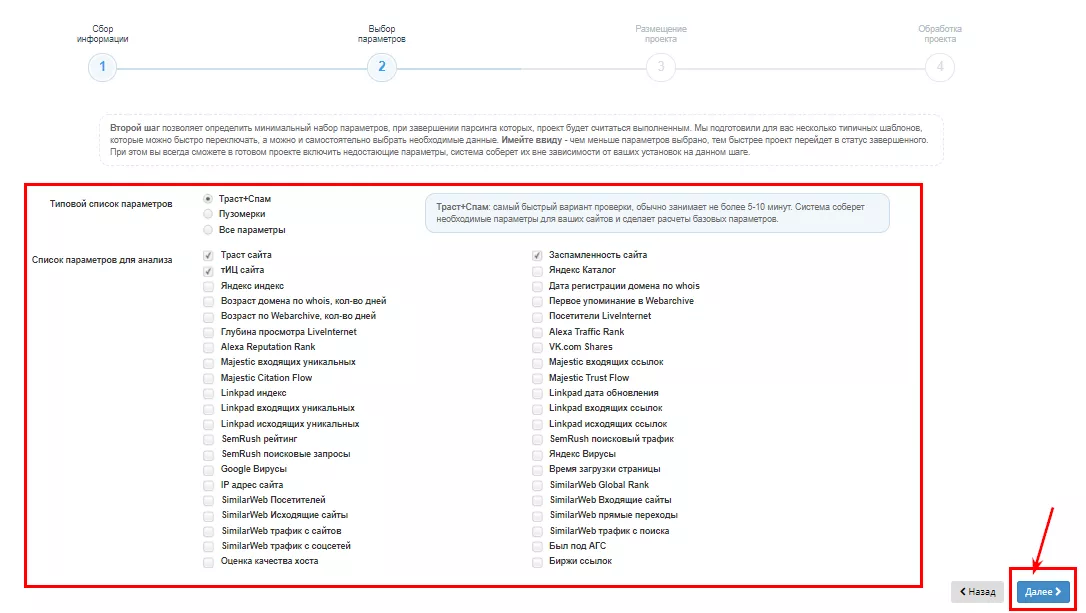

- Указываете название и добавляете список доменов:

Для новых посетителей — 500 бесплатных проверок.

Как анализировать параметры внешних ссылок?

Рекомендуем добавить все параметры в таблицу Google и в ней поэтапно отсеять площадки. Анализировать нужно, руководствуясь несколькими правилами:

- Показателями основных параметров.

- Ручной дополнительный анализ. Нет 100% чек-листа со значениями, отходить от которых нельзя. Например, у форума низкие показатели качества, но при этом у него высокая посещаемость. Такая площадка может принести реальный трафик из пользователей, которые совершат покупку или оставят заявку.

Как снять «плохую» ссылочную массу?

Ок, вредная ссылочная масса обнаружена. Теперь нужно от нее избавиться. Вот как это сделать:

- Написать вебмастерам с просьбой снять/заменить ссылку. Как правило, это срабатывает и вебмастера убирают ссылки.

- Составить файл на отклонение для поисковой системы Google. Можно поспорить, насколько способ на сегодня актуальный — официально Google больше не учитывает ссылки плохого качества в автоматическом режиме. Рекомендации по оформлению файла есть в официальной справке.

- Удалить покупные ссылки на бирже. Здесь все зависит от условий биржи, где вы наращивали ссылки.

Выводы

Нужно не только наращивать ссылки, но и постоянно мониторить качество уже существующих. Почему? Они могут вести на страницы с кодом ответа отличным от 200. Например, на страницы ошибок, страницы с множественными редиректами и так далее. Чтобы не терять вес внешних ссылок такие ошибки нужно устранять.

- Собираем все внешние ссылки из разных источников: Google Search Console, Ahrefs, Serpstat.

- Далее собираем все параметры доменов для анализа с помощью сервисов: Netpeak Checker и/или Сhecktrust. Можно и вручную, правда, это очень долго.

- Смотрим на основные показатели и сортируем список доменов на «плохие» и «хорошие». «Плохие» пойдут на отклонение.

- Снимаем «плохие» ссылки доступным способом: вручную (письма вебмастерам) или составляем файл на отклонение для поисковой системы Google. Если ссылки наращивались через биржи — удаляем их оттуда.

Свежее

Почему пользователи удаляют приложение и как этого избежать

Что именно заставляет пользователей забывать и удалять приложение? Разбираем и предотвращаем отток юзеров

Как настроить расширенную электронную торговлю с помощью Google Tag Manager

В этой статье разберу этапы построения системы — от стратегии до отдельных событий в воронке

Как оценить готовность бизнеса к ML-аналитике: чеклист от Netpeak

Компании все чаще инвестируют в машинное обучение, однако модели не становятся частью повседневных решений. Разбираем, почему