Коллеги, буквально вчера команда Netpeak Software представила новую версию нашего флагманского инструмента — Netpeak Spider 3.0. Это самое крупное обновление за всё время существования программы, которое включает в себя около 300 изменений: от супер-фич до небольших фиксов в юзабилити. Пока что оно доступно только на Windows, однако очень скоро мы портируем его и на Mac OS.

Ниже перечислю для вас самые масштабные изменения в программе, с которыми можно ознакомиться бесплатно в течение недели с момента релиза (до 4 апреля включительно).

Кстати, кодовое название нового обновлённого продукта — ни много ни мало «Новая SEO-надежда», и в следующем видео вы поймёте, почему.

А теперь давайте перейдём к обзору главных улучшений.

1. Скорость сканирования до 30 раз выше, чем в версии 2.1

Благодаря оптимизации процессов сканирования в Netpeak Spider 3.0 произошёл значительный прирост скорости работы.

Исходя из тестов, в рамках которых мы сравнивали скорость пробивки сайта на 100 000 URL c помощью Netpeak Spider 3.0 и предыдущей версии Netpeak Spider 2.1 с одинаковыми условиями, новая версия показывает увеличение скорости где-то в 30 раз.

2. Оптимальное потребление оперативной памяти

При анализе небольших сайтов (10 000 URL) мы сократили потребление оперативной памяти в 3 раза и ускорили сканирование в 8 раз.

Анализ больших сайтов (100 000 URL) раскрывает сильные стороны новой версии: потребление оперативной памяти ещё сильнее уменьшилось (в 4 раза), а сканирование заняло в 30 раз меньше времени.

3. Возможность продолжения сканирования после загрузки проекта

Теперь вы можете остановить сканирование, сохранить проект и потом досканировать сайт:

- к примеру, на следующий день → для этого необходимо просто открыть проект и нажать на кнопку «Старт»;

- на другом компьютере → для этого необходимо перенести всю папку с проектом на нужный компьютер (например, более мощный), открыть проект там и снова нажать на заветную кнопку «Старт».

4. Перепробивка URL или списка URL

Раньше, чтобы проверить корректность исправления определённой ошибки, нужно было сканировать весь сайт заново или мучиться со списками URL. Теперь же вы можете выбрать ошибку в боковой панели и запустить пересканирование только тех страниц, которые ей соответствуют → на выходе вы получите полностью обновлённый отчёт по всему сайту.

Также вы можете пересканировать как один URL, так и любой список URL на вкладках «Все результаты» или «Отфильтрованные результаты».

5. Удаление URL из отчёта

Если вы просканировали что-то лишнее, и вам мешают эти данные в отчётах, теперь вы можете без проблем удалить их, и все стандартные отчёты будут обновлены.

Также теперь вы можете просто очистить результаты, не удаляя сами URL — крайне полезно, когда вам необходимо как-то по-новому просканировать уже существующие страницы.

6. Изменение параметров в ходе сканирования

Возможность изменения параметров в процессе сканирования — одна из наиболее долгожданных функций, внедрить которую нас уже давно просят юзеры. Суть её заключается в следующем:

Если вы начали сканирование, а потом вспомнили, что не включили какой-то важный параметр или парсинг какого-то фрагмента HTML-кода, то теперь вы можете остановить сканирование, включить необходимые параметры и продолжить сканирование дальше. Уже просканированные страницы не будут перепробиваться, а включённые параметры начнут появляться только для новых страниц.

Если вы начали сканирование и понимаете, что данных слишком много, а они забивают оперативную память, при этом вы спокойно сможете без них прожить, то аналогично — останавливаете сканирование, выключаете ненужные параметры или парсеры, продолжаете сканирование. Эта опция позволяет освободить больше оперативной памяти и пробить ещё больше результатов.

7. Сегментация данных

Сегменты — это уникальная для десктопных продуктов функция, позволяющая изменить представление данных, ограничивая их определённым фильтром. Применение сегментов влияет на все отчёты в программе, включая ошибки, сводку, структуру сайта, дашборд и т.д.

8. Отчёт по структуре сайта

Мы реализовали новый отчёт с полной структурой сайта в виде дерева и возможностью отфильтровать страницы на любом уровне вложенности.

Выделив категорию и нажав кнопку «Расширенное копирование», вы скопируете в буфер обмена интересные результаты, которые можно вставить в любую внешнюю таблицу (например, Google Таблицы или Microsoft Excel).

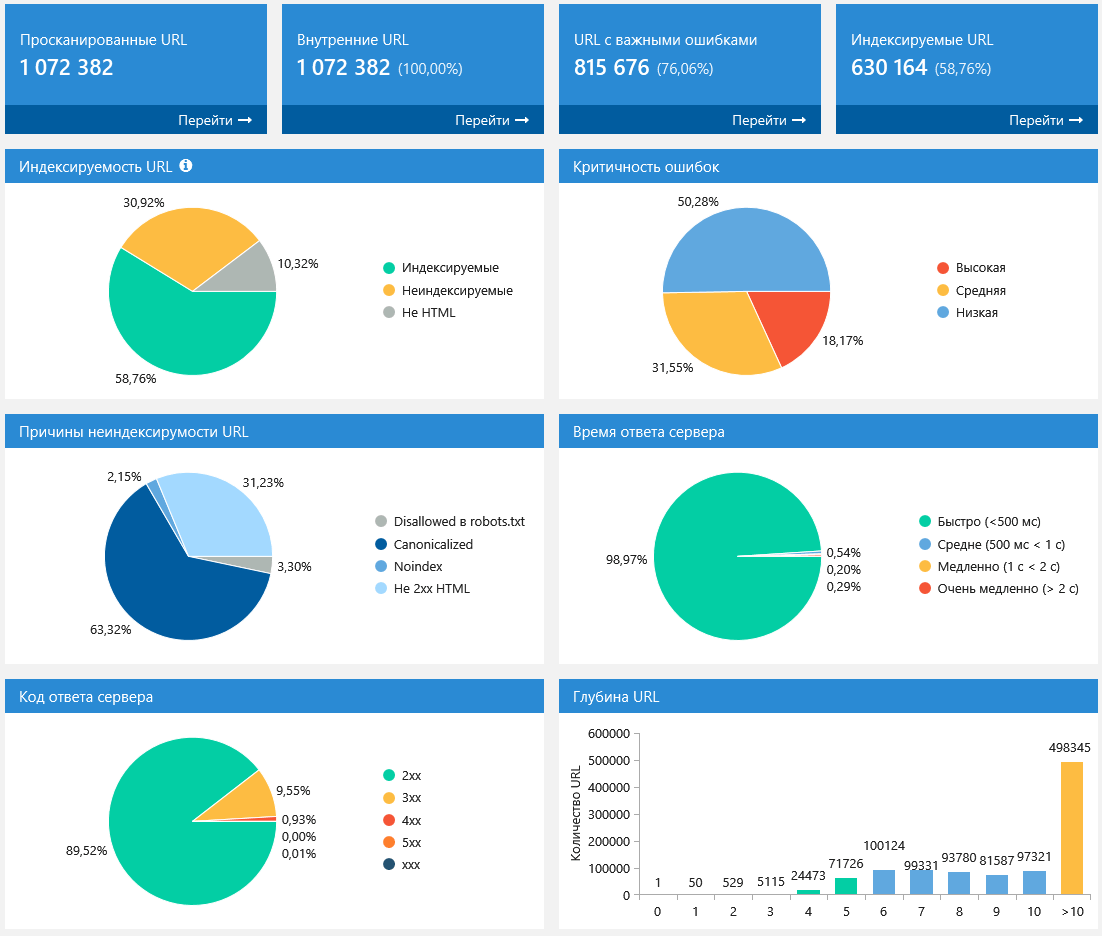

9. Дашборд (информация о ходе сканирования и диаграммы после окончания сканирования)

В новой версии Netpeak Spider вы найдёте новую вкладку «Дашборд», которая включает в себя сводные данные о настройках и ходе сканирования, круговые и столбчатые диаграммы, SEO-инсайты и удобные преднастроенные фильтры.

В процессе сканирования на этой панели отображается удобная сводка по ходу сканирования и всем важным настройкам. Если необходимо, можно выгрузить её полный скриншот с помощью кнопки «Экспорт...».

Когда сканирование завершено, или вы его специально остановили, на «Дашборде» можно будет найти наглядные графики и диаграммы с полезными инсайтами о просканированных страницах. Все графики интерактивные: можно нажать на любую часть диаграммы или на любое значение рядом с ней и перейти на отфильтрованные результаты по этому значению.

10. Экспорт 10+ новых отчётов и 60+ отчётов об ошибках в два клика

В новой версии программы были реализованы новые удобные шаблоны, с помощью которых можно выгрузить необходимые отчёты в два клика. В их числе значатся следующие форматы отчётов:

- Все ошибки → все отчёты по ошибкам в одну папку;

- Специальные отчёты по ошибкам → отчёты с удобным представлением данных по определённым ошибкам:

- Битые ссылки,

- Изображения без атрибута ALT,

- Цепочки редиректов,

- Редиректы, заблокированные в robots.txt,

- Редиректы с неправильным форматом URL,

- Цепочки Canonical,

- Canonical, заблокированный в robots.txt,

- Ссылки с неправильным форматом URL.

- Все ссылки → отдельная выгрузка всех внешних и внутренних ссылок, которые присутствуют на просканированных страницах;

- Все уникальные URL и анкоры → аналогично, выгружаются отдельно все внешние и внутренние ссылки: данные в первом отчёте группируются по URL, а во втором — сразу по URL и анкору.

11. Определение индексируемых URL

Теперь Netpeak Spider разделяет страницы по степени индексируемости на 3 типа:

- Индексируемые — это HTML-документы с 2xx кодом ответа сервера, не закрытые от индексации с помощью различных инструкций (robots.txt, Canonical, Meta Robots и т.д.). Это самые важные страницы на сайте, которые потенциально могут приносить органический трафик.

- Неиндексируемые — это HTML-документы с отличным от 2xx кодом ответа сервера или закрытые от индексации. Такие страницы зачастую не приносят трафик из поисковых систем и расходуют краулинговый бюджет.

- Не HTML — все остальные документы, которые имеют меньший потенциал для ранжирования в выдаче поисковых систем.

Индексируемость станет единым унифицированным понятием для инструментов и аналитики внутри программы, а большинство ошибок теперь будет определяться исключительно среди индексируемых URL.

12. Специальные отчёты по каждой ошибке

Для удобства фильтрации определённых страниц, содержащих те или иные ошибки, мы сделали быстрый доступ по спецкнопке «Отчёт по ошибке». В рамках данной функции доступны отчёты для таких ошибок:

- Битые ссылки,

- Ссылки с неправильным форматом URL,

- Редирект, заблокированный в robots.txt,

- Canonical, заблокированный в robots.txt,

- Изображения без атрибута ALT,

- Внутренние nofollow ссылки,

- Внешние nofollow ссылки.

13. Полностью переработаны инструменты «Расчёт внутреннего PageRank», «Валидатор XML Sitemap», «Анализ исходного кода и HTTP-заголовков» и «Генератор Sitemap»

Расчёт внутреннего PageRank

- Добавлен отдельный параметр «Внутренний PR» для каждой ссылки.

- Теперь расчёт внутреннего PageRank происходит только для индексируемых URL: в нём больше не принимают участие изображения и другие типы файлов, отличные от HTML.

- Появился новый параметр «Вес ссылки», который показывает сколько веса передаётся по каждой конкретной ссылке. Он помогает оптимизировать внутренний ссылочный вес, если вы после моделирования перенесёте созданную структуру на сайт.

- Добавлена таблица «Динамика сумм PageRank» — на каждой итерации производится подсчёт отношения суммы внутреннего PageRank на текущей итерации к сумме на нулевой итерации.

Валидатор XML Sitemap

В предыдущей версии валидатор XML-карт сайта был режимом сканирования, однако теперь мы вынесли его в отдельный инструмент для решения следующих задач:

- Парсинг ссылок из XML Sitemap с возможностью передачи их в основную таблицу для дальнейшего сканирования;

- Валидация карты сайта → здесь мы полностью переработали все ошибки (теперь их 34 штуки) и учли основные рекомендации Google и Яндекса;

- Отправка ping в поисковые системы для того, чтобы обратить их внимание на изменения в ваших файлах XML Sitemap.

Обратите внимание, что теперь правила сканирования учитываются при парсинге ссылок из XML-карт сайта. Также инструмент хранит все ваши запросы: начните вводить URL, и он подскажет, какие XML Sitemap вы анализировали ранее.

Анализ исходного кода и HTTP-заголовков

Аналогично, был полностью переработан интерфейс и добавлена вкладка «Извлечённый текст», на которой отображается весь контент страницы без HTML-тегов. Эта функция не заменяет, например, просмотр текстовой копии в Google (это более надёжный источник данных), однако показывает, как именно Netpeak Spider анализирует текст при расчётах количества слов или символов на странице.

Генератор Sitemap

Кроме переработки интерфейса, инструмент теперь создаёт карты сайта исключительно для индексируемых URL. Это означает, что в карту наверняка не попадут, например, страницы, закрытые от индексации.

14. Кастомные шаблоны настроек, фильтров / сегментов и параметров

В Netpeak Spider 3.0 мы реализовали преднастроенные шаблоны с возможностью создавать свои собственные шаблоны для:

- Настроек → такие шаблоны хранят информацию на всех вкладках настроек сканирования (кроме «Экспорт», «Аутентификация» и «Прокси») и позволяют переключаться между нужными настройками в два клика.

- Фильтров и сегментов → создавайте свои шаблоны, если часто фильтруете данные по одним и тем же условиям;

- Параметров → доступ к этим шаблонам вы можете получить на вкладке «Параметры» в боковой панели.

15. Возможность настроить виртуальный robots.txt

В Netpeak Spider 3.0 предусмотрена функция «Виртуальный robots.txt». Благодаря ней вместо актуального файла robots.txt в корневой директории вашего сайта будет использоваться именно составленный вами виртуальный файл. В первую очередь этот функционал будет полезен для тестирования нового файла robots.txt.

16. Совмещение всех режимов сканирования в один

В новой версии программы URL для сканирования можно добавлять следующими способами:

- Сканируя сайт → просто добавьте нужный адрес в поле «Начальный URL» и нажмите кнопку «Старт»: страницы будут добавляться по мере продвижения краулера по сайту.

- Вручную → программа откроет отдельное окно для ввода списка страниц, где каждый URL должен быть прописан с новой строки.

- Из файла → URL импортируются из файлов с расширениями .xlsx (Microsoft Excel), .csv (comma-separated values), .xml (Extensible Markup Language), .nspj (проект Netpeak Spider) и .ncpj (проект Netpeak Checker);

- Из XML Sitemap → этот способ откроет инструмент валидации XML Sitemap, через который уже можно выгрузить URL для сканирования в основной таблице.

- Из буфера обмена → просто нажмите комбинацию Ctrl+V, находясь в главном окне программы, и список URL из буфера обмена добавится в таблицу, а в уведомлении будет приведена краткая информация (что успешно добавилось, что уже есть в таблице, а что не добавилось по причине несоответствия стандартному формату URL).

- Drag and Drop → вы можете просто перенести проект или любой файл с вышеуказанным расширением из папки прямо в основную таблицу: Netpeak Spider проанализирует файлы и загрузит необходимые данные.

17. Таблица пропущенных при сканировании ссылок

Для случаев, когда сайт по каким-то причинам не сканируется, в программе был реализован следующий функционал:

Адрес, который вы вводите в поле «Начальный URL» всегда будет добавляться в таблицу. Таким образом, вы получите информацию, если этот URL редиректит на какой-то другой сайт или просто недоступен на данный момент.

Мы создали отдельную вкладку «Пропущенные URL», которая появляется только в тех случаях, если при сканировании были проигнорированы какие-то страницы. Здесь будут отображаться URL страницы и причина, по которой они были пропущены: например, вы включили учёт инструкций из файла robots.txt, применили правила сканирования или отключили проверку какого-то типа контента.

18. Быстрый поиск по таблице

Во всех интерфейсах программы реализована возможность быстрого поиска по соответствующей таблице — просто нажмите Ctrl+E и введите поисковый запрос.

Если вам необходимо отфильтровать данные по какому-то определённому параметру или сегментировать все данные, то можно воспользоваться соответствующими функциями:

- Ctrl+F → настройка фильтра;

- Ctrl+Shift+F → настройка сегмента.

19. Отложенный анализ тяжёлых данных

Все массивы тяжёлых данных были вынесены и сведены в единый модуль. С его помощью вы можете просматривать огромные списки:

- входящих, исходящих, внутренних и внешних ссылок,

- изображений,

- ошибок,

- редиректов,

- Canonical,

- заголовков H1-H6.

20. Новая вкладка «Параметры» с поиском и переходом к параметру в таблице

Установка анализируемых параметров была перенесена из настроек сканирования на вкладку «Параметры» в боковой панели. Теперь, аналогично Netpeak Checker, здесь можно осуществить поиск по всем параметрам, а также выбрать параметр и увидеть подробную подсказку о нём в блоке «Информация».

Если уже имеются результаты в основной таблице, то можно нажать на параметр (или воспользоваться кнопкой «Перейти» на этой панели), чтобы быстро перейти к соответствующему параметру в текущей таблице.

21. Мониторинг лимита памяти для сохранности данных

В новой версии программы реализована проверка объёма свободной оперативной памяти и места на жёстком диске: и там, и там для работы программы должно быть не менее 128 Мбайт. Если лимит обнаружен, то сканирование останавливается, и данные остаются в сохранности.

Коротко о главном

Netpeak Spider в версии 3.0 превратился в супербыстрый инструмент, позволяющий без проблем работать с большими сайтами и проводить их комплексную SEO-аналитику. По сравнению с версией 2.1 мы улучшили потребление оперативной памяти в 4 раза и уменьшили время сканирования в 30 раз (на примере пробивки большого сайта). А детальную информацию касательно всех обновлений, которые мы внедрили в Netpeak Spider 3.0, и сравнение по производительности с основными конкурентами вы можете найти в отдельном посте на блоге Netpeak Software.

Свежее

Cloud Marketing и AI-аналитика: как бизнес оптимизирует рекламу благодаря данным

В статье рассмотрю, как внедрить AI, GA4 и Google Cloud в маркетинг, сократить время до инсайта и повысить ROMI. Покажу, как бизнес адаптируется к новым требованиям и повышает эффективность за счёт данных

Аудит оптимизации в App Store и Google Play: подробное руководство

Чтобы выделяться среди других, нужна качественная оптимизация. И именно здесь пригодится аудит оптимизации в App Store и Google Play

Как настроить тег конверсий Google Ads через Google Tag Manager

Из этой статьи-инструкции вы узнаете, как настроить тег пошагово, избежать технических ошибок и обеспечить передачу ключевых параметров транзакции в Google Ads