Как настроить Google Indexing API — инструмент для ускорения индексации страниц сайта

Ежедневно SEO-специалисты работают над тем, чтобы как можно больше релевантных страниц сайта было проиндексировано. Это довольно сложный процесс, который в зависимости от размера сайта может занять недели, месяцы, а то и годы. Однако есть способы его ускорить.

Что такое индексация сайта и для чего она нужна

Индексация сайта — это процесс попадания содержимого сайтов в базу поисковой системы (ПС): не только самих страниц сайта, но и видео, фото и других материалов, размещаемых на ресурсах.

С точки зрения отдельной страницы, попадание в базу данных ПС означает: система считает ее достаточно качественной, чтобы она в дальнейшем появилась в выдаче. Поисковый бот при считывании информации и добавлении страницы в индекс также ориентируется на ее содержание: это позволяет присвоить ей в индексе определенный перечень ключевых запросов, по которым она будет ранжироваться.

Почему же индексация важна?

-

Попадание в индекс и, соответственно, в результаты поиска — это и есть SEO-трафик любого сайта. Без индексации возможность найти пользователями ваш сайт стремительно падает.

-

Лематизация позволяет присвоить индексу наиболее релевантный кластер запросов. По ним страница будет появляться в поиске, увеличивая релевантный трафик и улучшая поведенческие факторы.

В то же время, далеко не все страницы полезны для выдачи, а некоторые — даже вредны. В таком случае важно знать, как правильно закрыть сайт или отдельные страницы от индексации.

Когда возникают проблемы с индексацией и сканированием сайта

Среди проблем, которые могут помешать индексации контента сайта:

-

Страницы низкого качества. Если на странице, по мнению Google, нет достаточно полезного контента или он похож на спам, поисковая система не добавит ее в индекс. В Google Search Console такие страницы будут иметь статус «просканировано», но не «проиндексировано».

-

Дубликат страницы. Когда Google считает страницу дублирующей контент, он также не добавляет ее в индекс. В Google Search Console это может отображаться статусами: «дубликат, Google определил другой каноникал, чем пользователь», «альтернативная страница с правильным каноническим тегом», «дубликат страницы без канонического тега».

-

Сайт находится под ручными санкциями/фильтрами от поисковых систем (касается прежде всего Google). Сайт может как частично потерять страницы в индексе, так и полностью вылететь из него.

Больше о причинах проблем с индексацией читайте в материале «Что такое деиндексация, или Как выйти из теневого бана Google».

Кроме индексации, необходимо также упомянуть о краулинге страниц — это процесс обнаружения и сканирования содержимого сайтов поисковыми роботами. Без предварительного краулинга индексация невозможна, потому что поисковые роботы не смогут найти ваш контент. И даже если найдут, могут быть ограничения для сканирования (одного из компонентов краулинга), что также сделает невозможным попадание контента в выдачу.

Среди основных причин проблем с краулингом:

-

Отсутствие директивы Robots.txt — текстового документа, содержащего информацию о типах страниц и файлов, доступных для индексации.

-

Отсутствие карты сайта. Sitemap облегчает поисковым роботам нахождение нужных страниц.

-

Большое количество редиректов и битых ссылок. Существует понятие «краулингового бюджета», то есть количества страниц, которые могут быть просканированы за определенное время. Каждый редирект считается отдельной страницей, и таким образом краулинговый бюджет тратится зря.

-

Плохая внутренняя перелинковка. Если на странице слишком много ссылок, они все ведут на один и тот же адрес или имеют непонятные анкоры, то часть нужных URL-адресов так и не будет найдена поисковыми роботами.

-

429, 500, 503 коды ответов — данные коды сообщают поисковым роботам о проблемах на стороне сервера. При их массовом получении, поисковый робот на определенное время прекращает сканировать сайт и уменьшает дальнейший краулинговый бюджет.

-

Низкая скорость загрузки страниц, что также способствует снижению краулингового бюджета.

-

Обработка файлов. Отдельные JavaScript и CSS-файлы могут не обрабатываться поисковым роботом, что вызывает как проблемы с индексацией отдельного контента страницы, так и делает невозможным ее сканирование.

-

Отсутствие мобильной версии. Google работает по принципу Mobile-First Index, который ставит первоочередным приоритетом оптимизацию страницы именно для мобильных устройств.

Способы ускорения индексации страниц

Есть несколько стандартных методов ускорения краулинга и индексации страниц:

-

Грамотная внутренняя перелинковка.

-

Наличие Sitemap.

-

Увеличение скорости загрузки страниц и их элементов.

-

Уменьшение количества битых ссылок и лишних редиректов, например, тех, что ведут на еще одну переадресацию.

-

Обеспечение качества и ценности контента.

-

Наличие ссылок на социальные сети.

Среди инструментов, с помощью которых можно ускорить краулинг и индексацию, есть следующие:

-

Инструмент проверки URL в Google Search Console.

Позволяет проверить:

-

статус страницы в Google Search Console;

-

где она была найдена;

-

когда в последний раз просканирована и т. д.

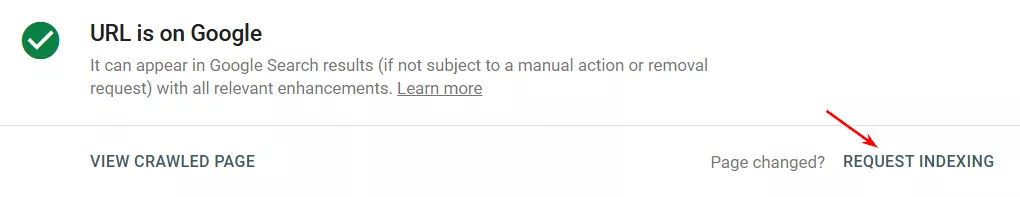

Если необходимо просканировать ее повторно, например, после изменения контента или статуса, воспользуйтесь кнопкой «Отправить запрос на индексирование».

Инструмент подходит только для единичных запросов на сканирование/индексацию, так как не может проверить более одного URL за раз.

Общий лимит составляет примерно 10–20 запросов. После его исчерпания появится сообщение о временном ограничении запросов, которое будет действовать до следующего дня.

-

Ping-сервисы — ресурсы, которые уведомляют поисковые системы о появлении новых страниц. В них вы добавляете страницы сайта, которые необходимо просканировать и проиндексировать. Некоторые из этих сайтов используют в работе Google Indexing API, поэтому это не самый надежный способ индексации для разных типов страниц (об этом чуть ниже).

-

Google Indexing API — бесплатный инструмент для массового сканирования URL-адресов.

Важно! Google Indexing API работает только для страниц с микроразметками Job Posting/BroadcastEvent для видео. Это страницы с коротким циклом существования, и индексация через API обеспечивает показ актуального контента. Попытки использовать его для индексации обычных страниц не сработают: Google предварительно проверяет запросы на спам и отклоняет их, если они не соответствуют требованиям.

Инструкция по настройке Google Indexing API

Настройка делится на шесть этапов:

Далее разберу каждый этап подробно.

Этап 1. Создание сервисного аккаунта и JSON-ключа

Зайдите в Google Cloud Platform и нажмите Console.

Далее, перейдя в Console, нажмите следующую иконку.

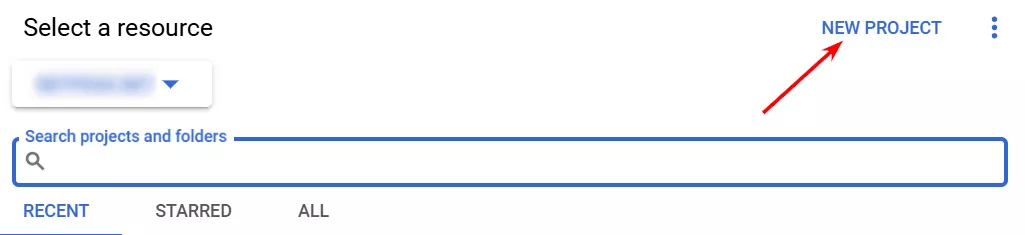

Выберите «New Project».

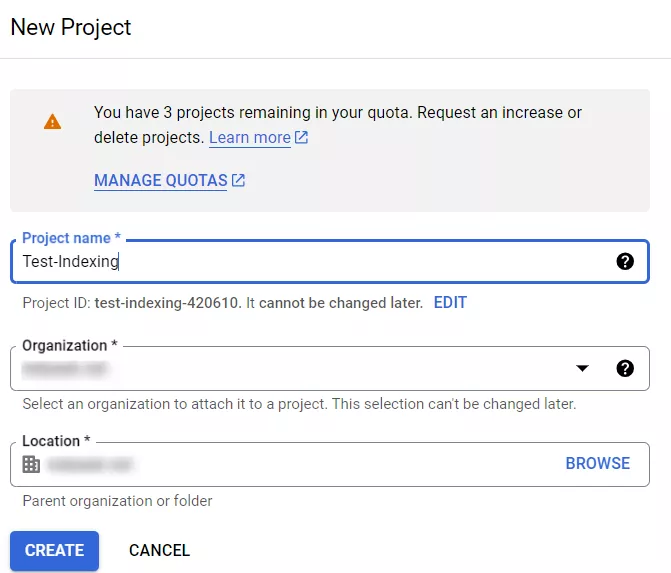

У вас появится вот такое окно.

В нем необходимо указать название вашего проекта (любое удобное для вас), Organization — можно указывать «No organization» и без Location. Если у вас корпоративная почта, по умолчанию будет указано название корпоративного домена в Location и в Organization. В таком случае вариант «No organization» будет недоступен.

Закончив, нажмите «Create».

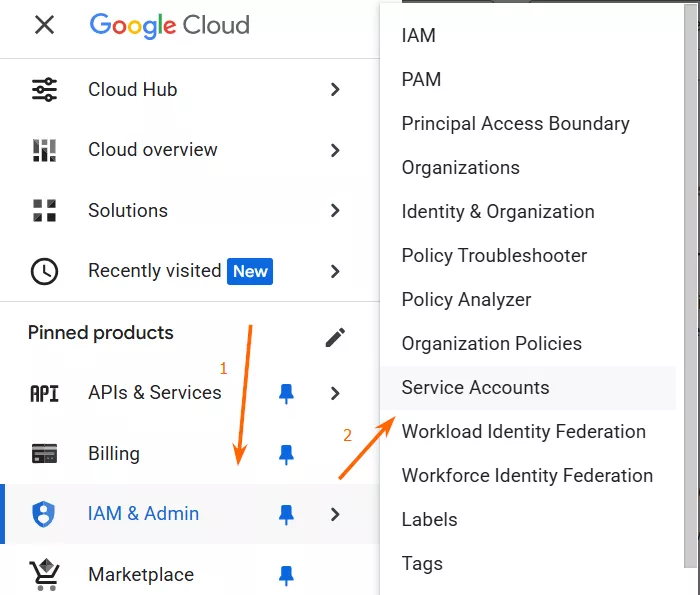

Когда проект создан, нажмите на навигационное меню (три горизонтальные полоски) слева вверху и перейдите в Service Accounts.

Вверху нажмите кнопку «Create Service Account».

Подробнее о сервисном аккаунте и его создании рассказала в статье моя коллега.

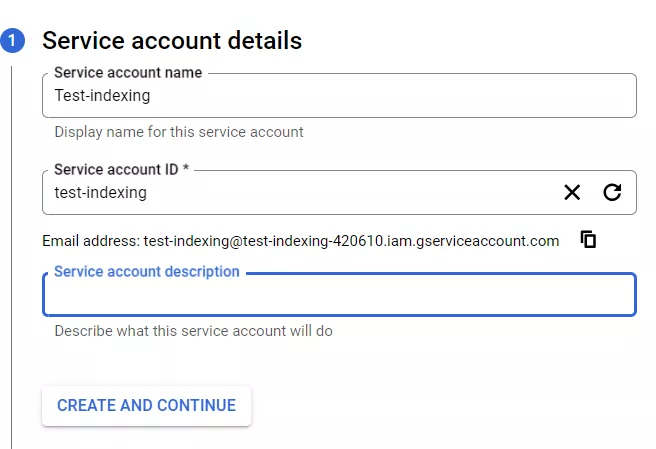

Появится вкладка.

Название аккаунта вы можете придумать самостоятельно, ID автоматически подтянется после его прописки. Описание сервисного аккаунта можно пропустить, нажимайте «Create and Continue».

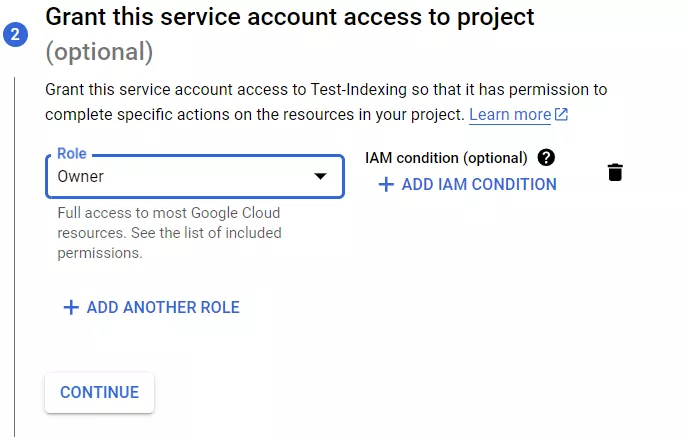

Далее выберите роль «Owner» для сервисного аккаунта. Выбор любой другой роли не позволит вам воспользоваться Google Indexing API для вашего сайта.

На третьем шаге можно предоставить доступ другим к сервисной учетной записи, однако для этой инструкции данное действие не обязательно, поэтому я его пропущу.

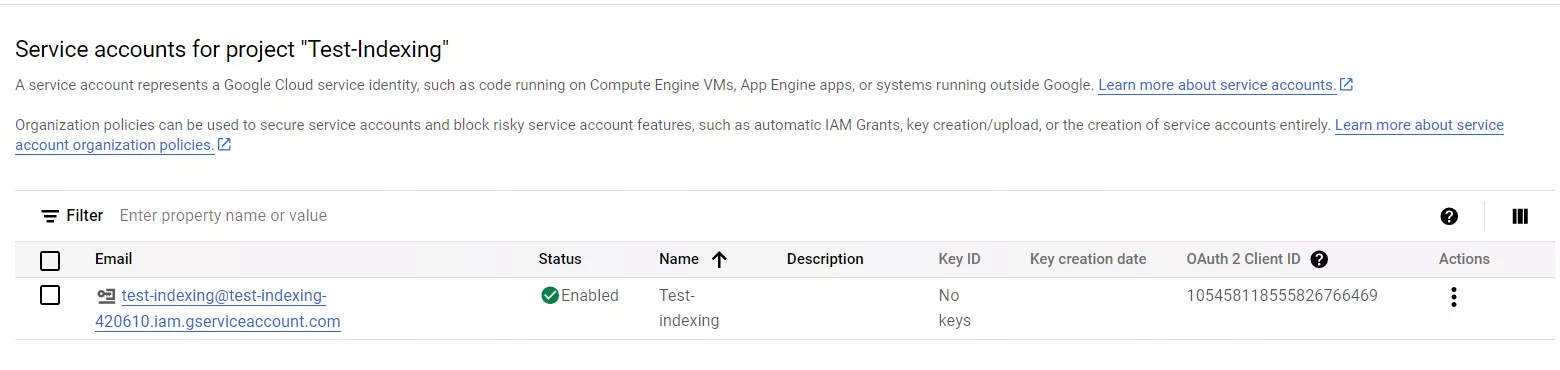

Нажмите кнопку «Done», после чего вас перебросит на вкладку с именем проекта и email-адресом, который понадобится позже.

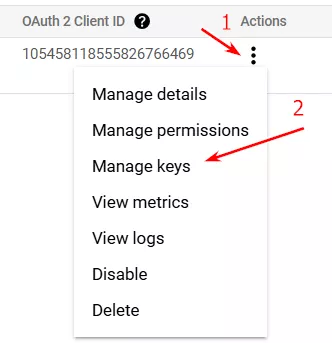

Далее нажмите на три точки под «Actions» и выберите «Manage Keys».

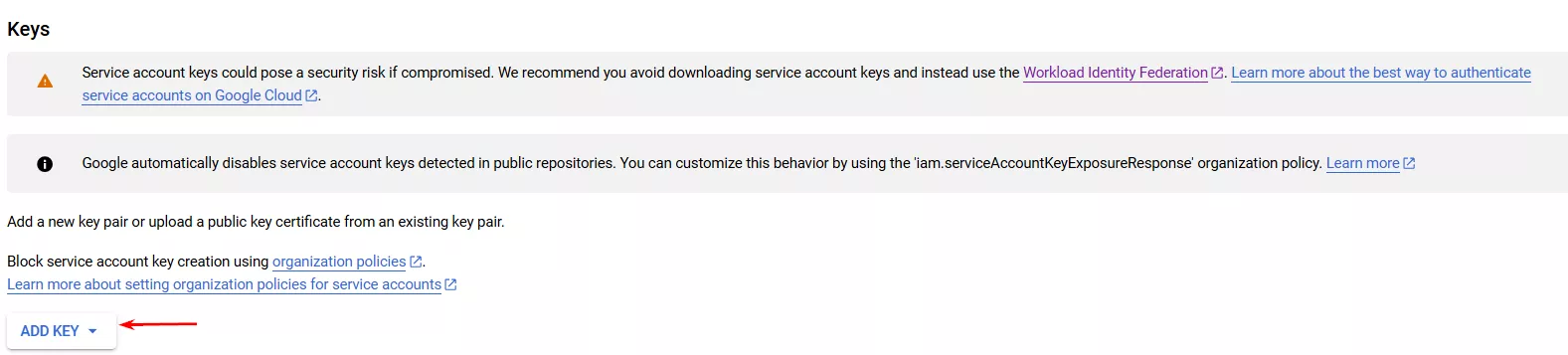

После этого вас перекинет на вкладку, где нужно будет выбрать «Add key».

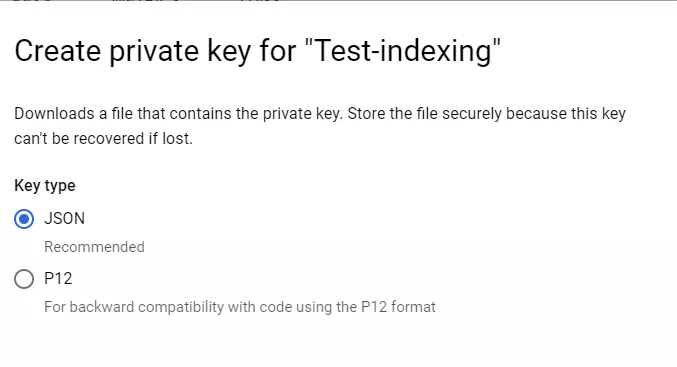

Вам будет предложено «Create new key». Выберите формат JSON.

Ключ автоматически загрузится на компьютер. В дальнейшем он понадобится для добавления в файл service_account, о чем пойдет речь во втором этапе.

Невозможно запустить скрипт для отправки страниц на индексацию без создания сервисного аккаунта и скачивания JSON-ключа.

Этап 2. Подготовка папки проекта

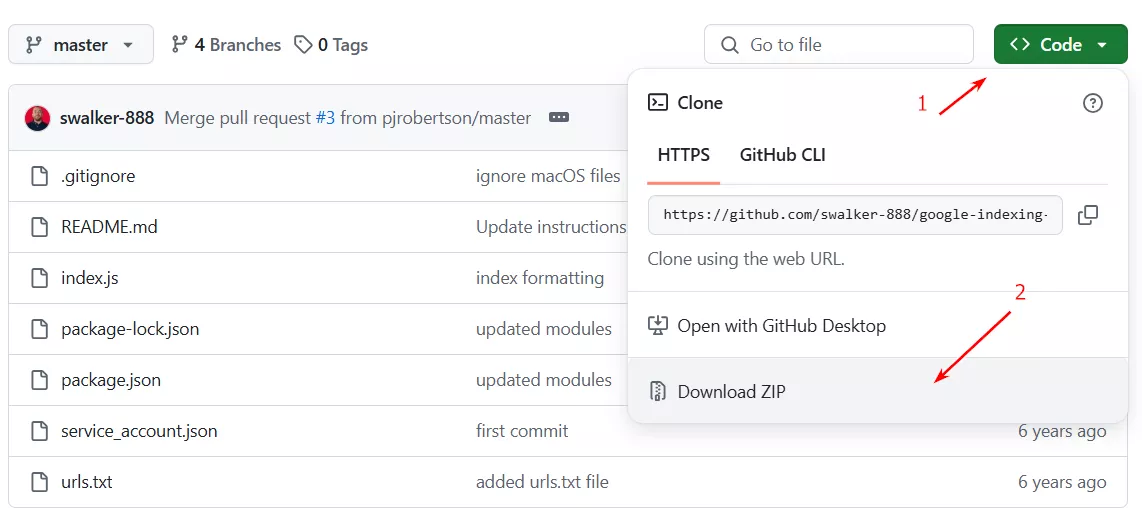

Перейдите в Github (сервис для совместной разработки ПО) и загрузите ZIP-архив проекта.

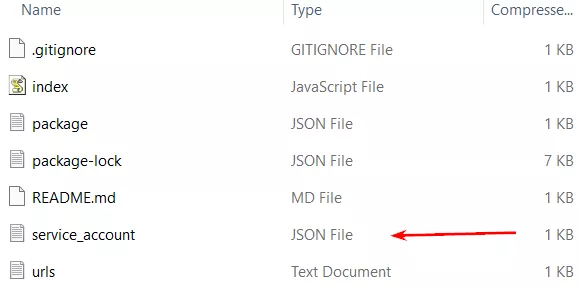

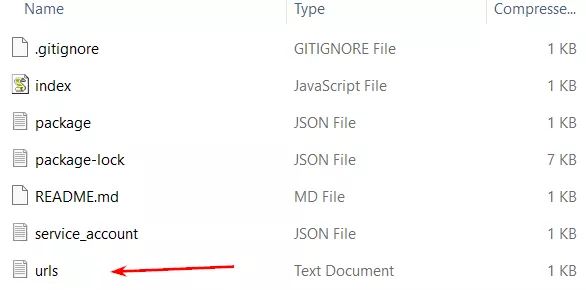

Распакуйте папку. В ней будет список файлов, вам нужен следующий:

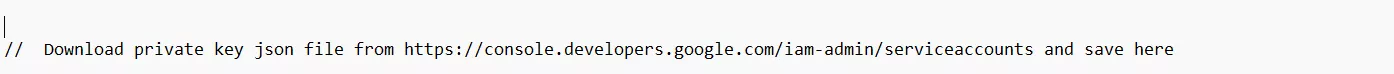

Откройте его и найдите следующую строку.

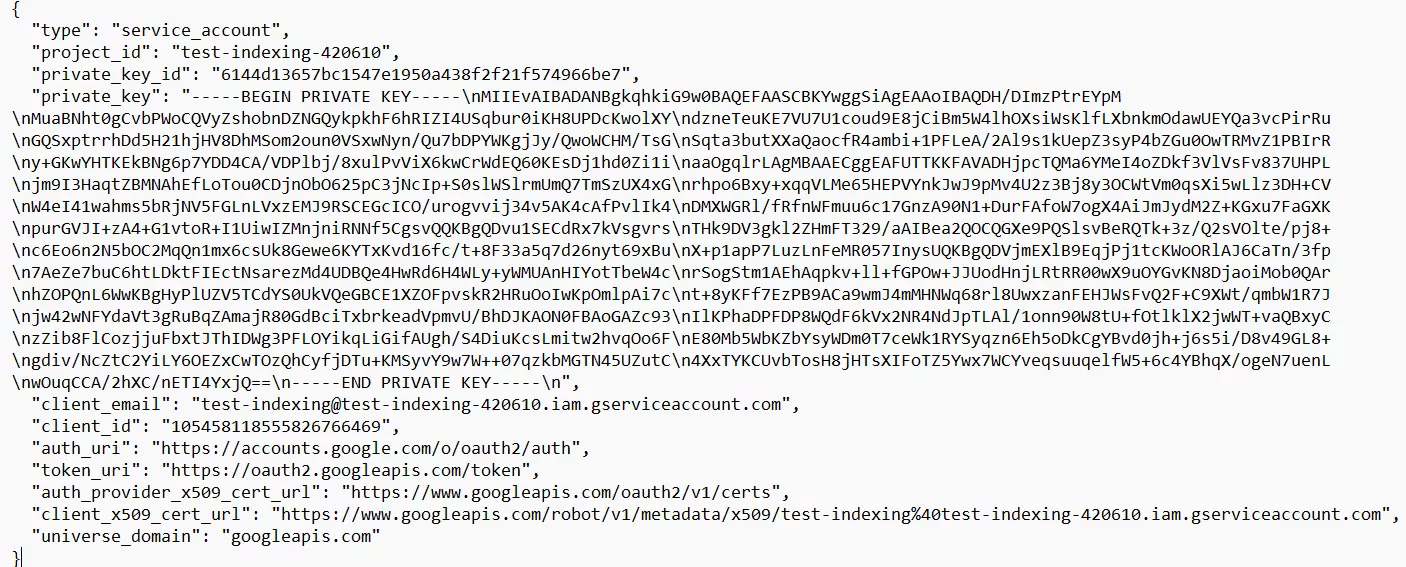

Замените его полностью JSON-ключом, который вы скачали предварительно, и не забудьте сохранить файл. Должно выглядеть следующим образом:

Этап 3. Предоставление разрешений в Google Search Console

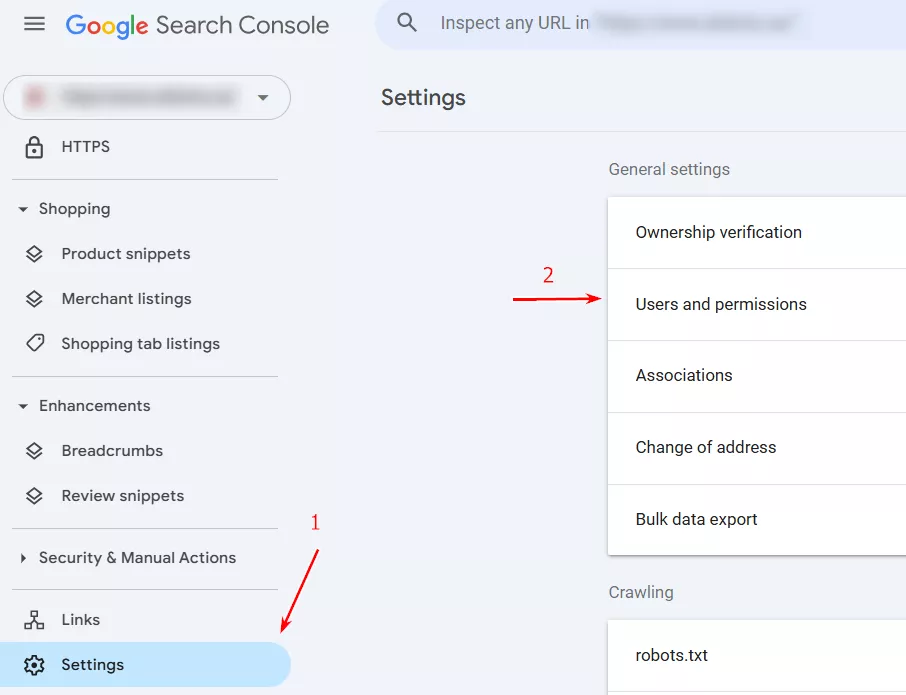

В GSC перейдите в раздел «Настройки» и зайдите во вкладку «Пользователи и разрешения».

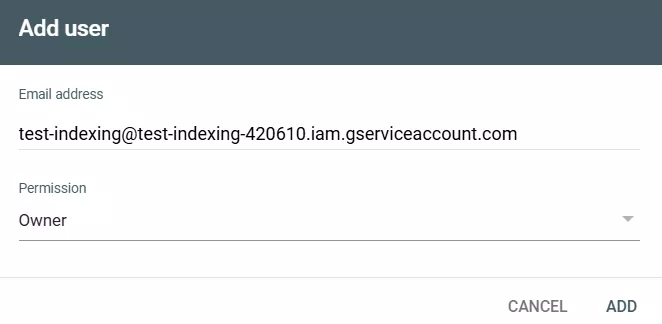

Нажмите кнопку «Добавить пользователя» и введите email-адрес, который вы получили при создании сервисного аккаунта. Также назначьте роль Владельца (Owner), как делали это в Google Cloud Platform. Нажмите «Добавить».

Этап 4. Подключение API в Google Cloud Platform

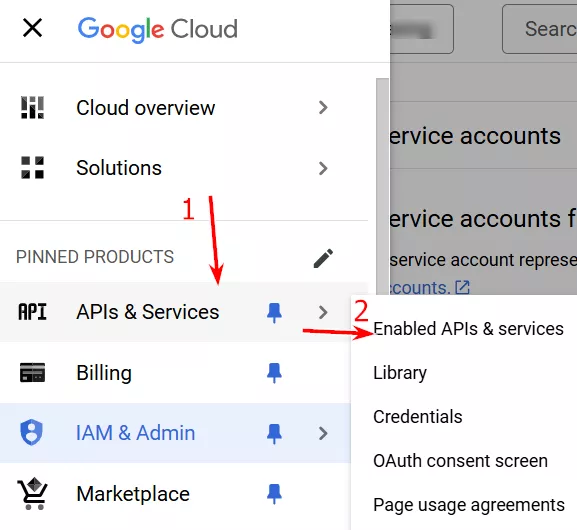

Вернитесь в Google Cloud Platform, нажмите «Навигационное меню», перейдите на вкладку «APIs & Services» и выберите «Enabled APIs & services».

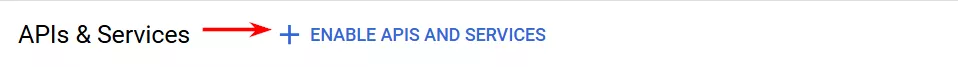

Вверху страницы нажмите кнопку «Enable APIs and services».

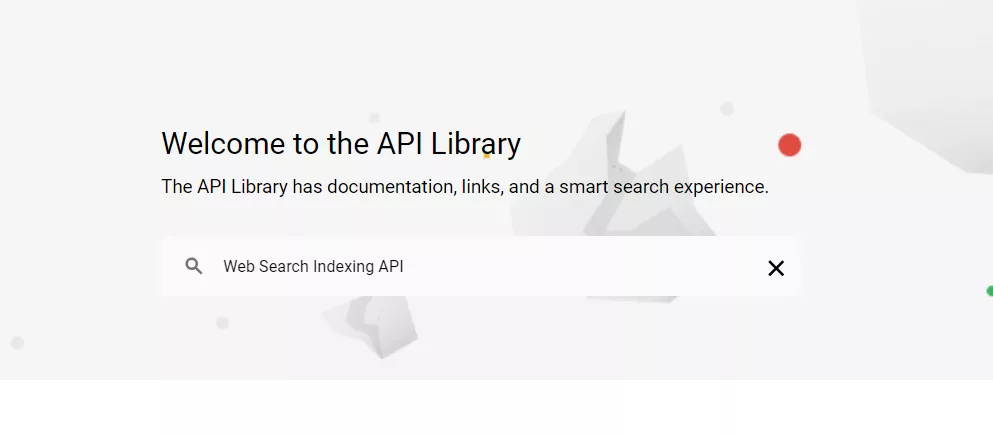

После чего вас перебросит на вкладку, указанную ниже, где вы должны ввести в поисковую строку «Web Search Indexing API» и кликнуть на результат поиска.

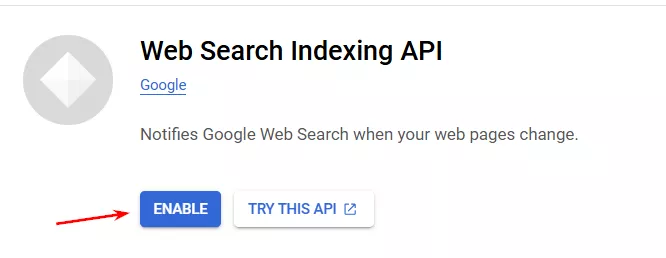

В появившемся окне нажмите «Enable».

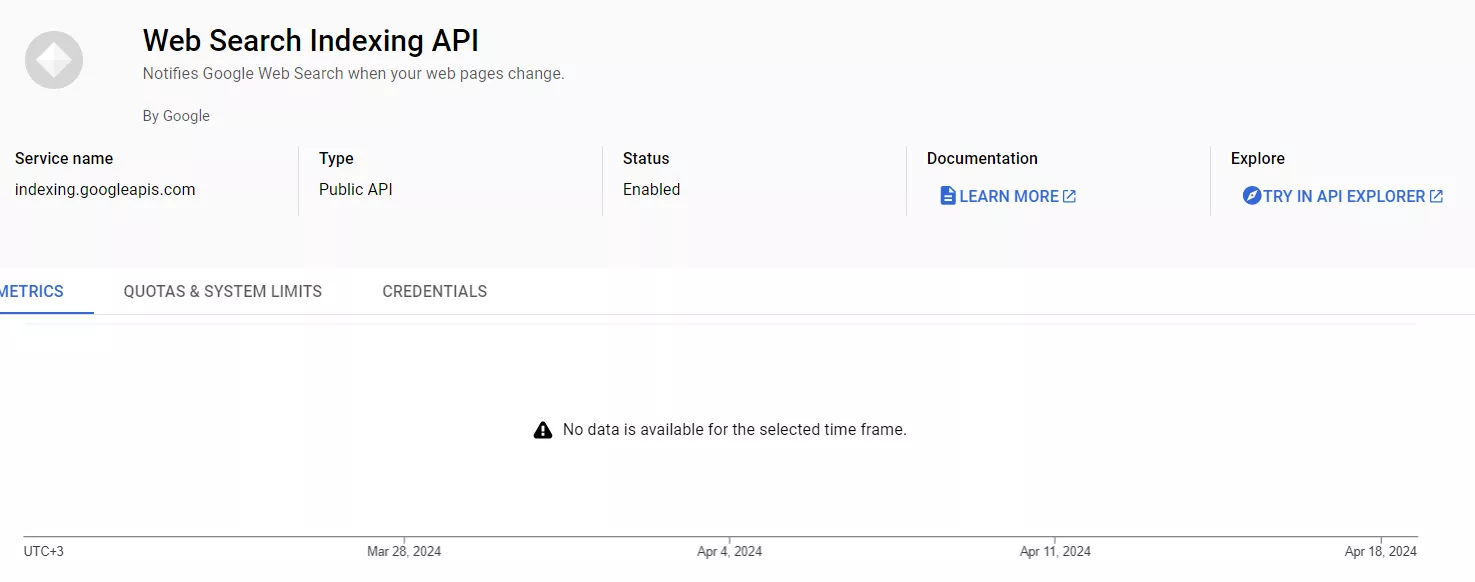

После этого вы попадете на экран настроенного API.

Этап 5. Загрузка библиотеки проекта

Библиотека — это набор функций, классов, модулей и других компонентов, которые разработчики используют в приложениях для выполнения определенных задач. В нашем случае библиотека понадобится для отправки URL-адресов на сканирование и индексацию.

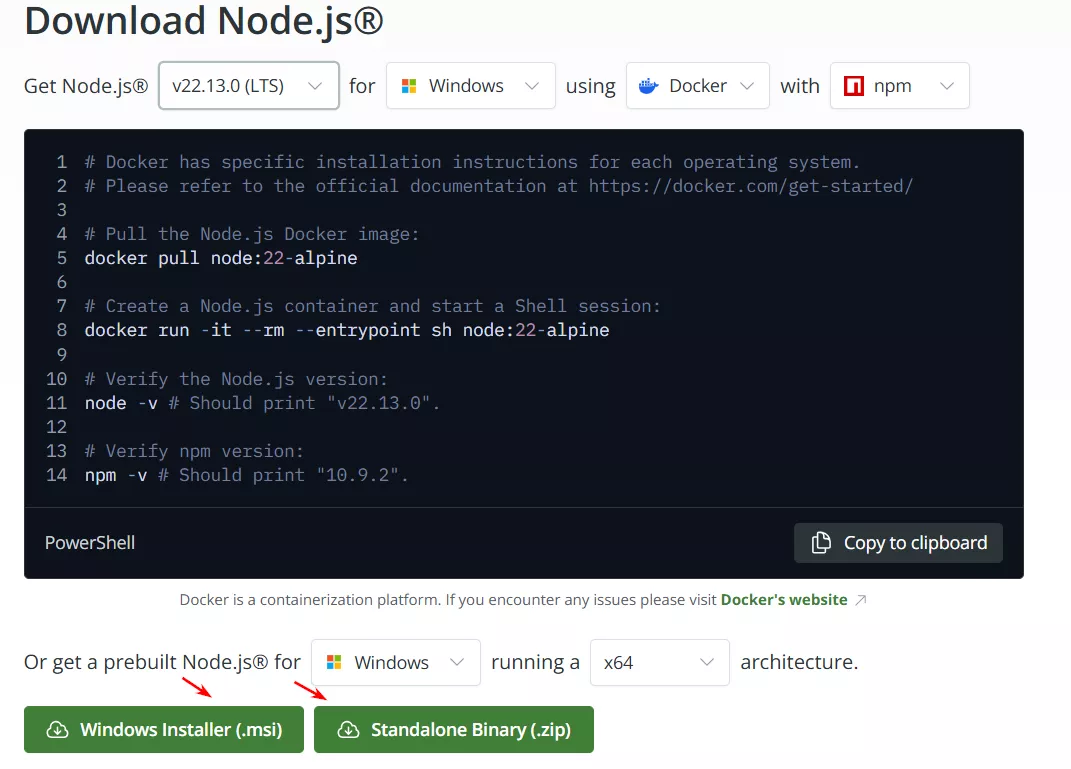

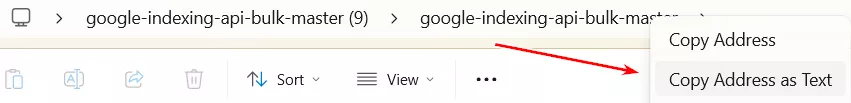

Для работы вам понадобится библиотека Node.js. Перейдите на сайт nodejs.org и выберите вашу операционную систему, ее версию и другие параметры. После чего нажмите на одну из кнопок внизу, чтобы загрузить библиотеку в соответствующем формате.

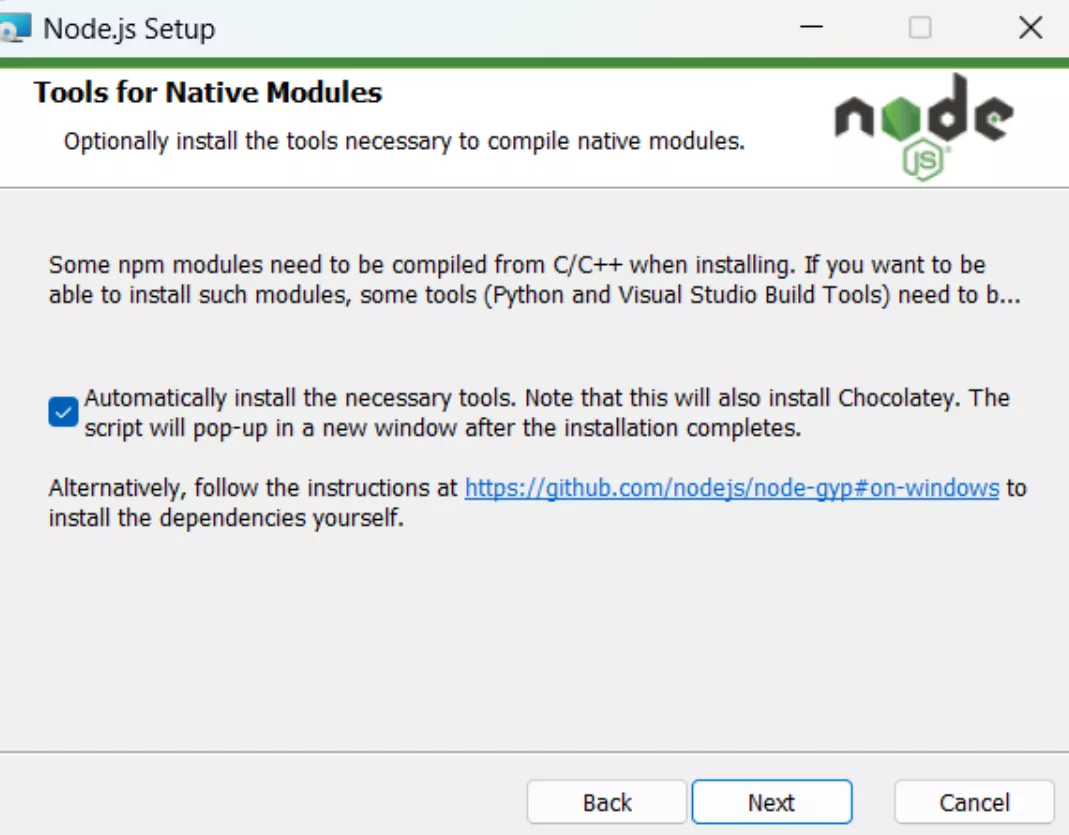

Далее начнется стандартный процесс установки. Единственное, на что стоит обратить внимание — на этапе, изображенном внизу, необходимо поставить галочку. Это нужно, чтобы Node.js автоматически загружал обновления (для безопасности и производительности). После чего завершите установку и переходите к финальному этапу.

Этап 6. Отправка страниц на индексацию

Отберите страницы, которые вы хотите отправить на сканирование Google. Помните об ограниченном типе страниц, допускаемых к сканированию и индексации через Google Indexing API.

Зайдите в папку, которую вы ранее создали для проекта, и выберите файл «urls».

Внесите сюда необходимые URL-адреса. За раз можно добавить не более 100, а всего за день — 200 адресов. Нажмите «Сохранить».

После этого откройте Node.js через командную строку Windows. Перед вами появится вот такая иконка. Нажмите на нее.

Откроется этот экран.

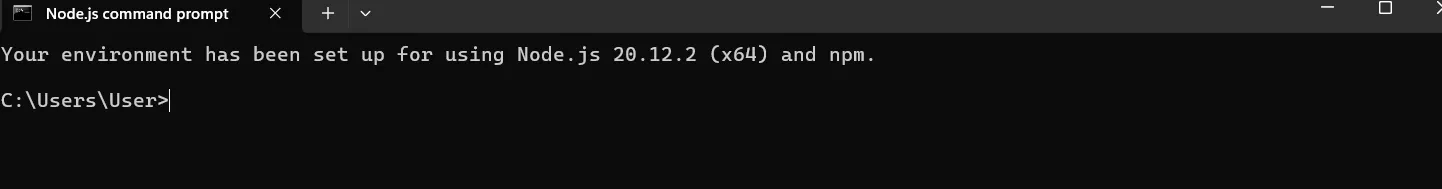

Чтобы загрузить нужные URL для сканирования, вам необходимо ввести точный путь к папке с необходимыми URL-адресами. Для этого перейдите в папку проекта и нажмите правой кнопкой мыши на последнюю строку адресного пути. У вас появится возможность скопировать адрес как текст.

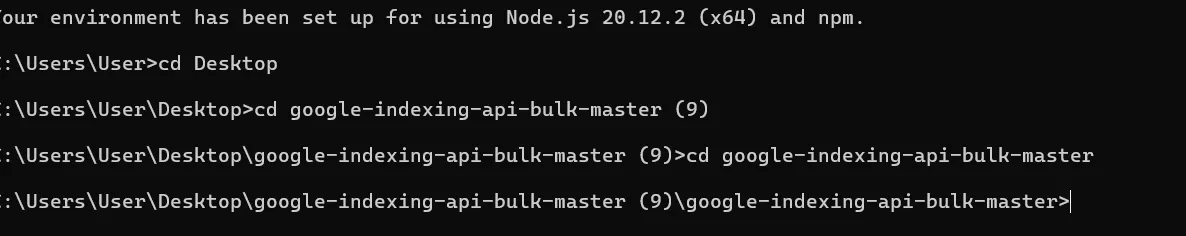

В моем случае адрес файла следующий: C:\Users\User\Desktop\google-indexing-api-bulk-master (9)\google-indexing-api-bulk-master.

После этого добавьте каждый из элементов адреса в Node.js с приставкой cd. Это будет выглядеть следующим образом.

После того как добавите последний элемент пути к папке, выполните команды по очереди (введите одну команду — нажмите Enter, вторую — Enter, и т. д.):

-

npm install requests

-

npm audit fix

-

npm audit fix --force

-

node index.js

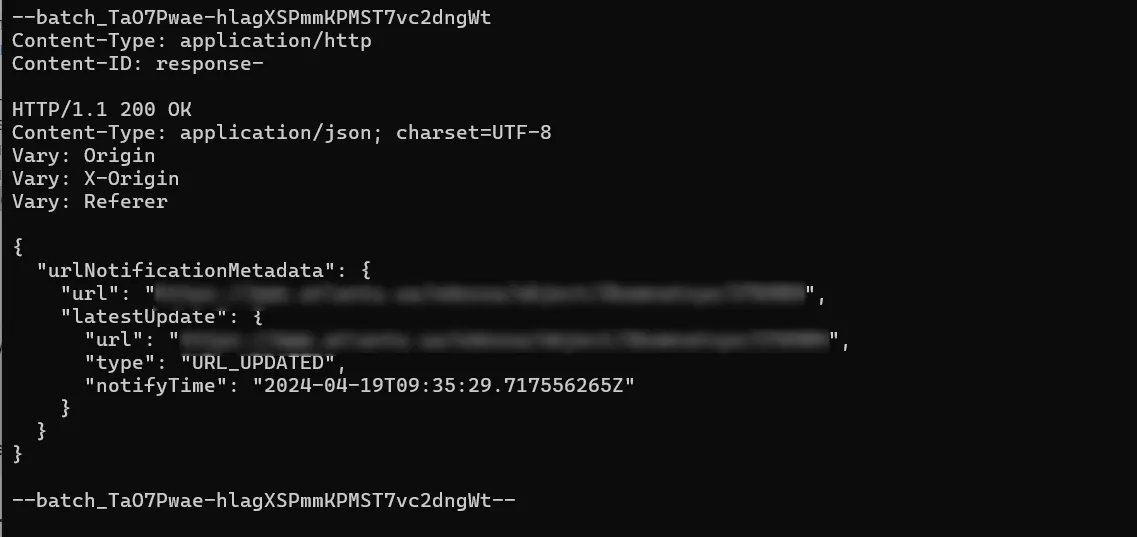

Если все сделано правильно, вы увидите результат, подобный этому.

Распространенные проблемы использования Google Indexing API

Если во время работы возникают ошибки, проверьте следующие ответы системы.

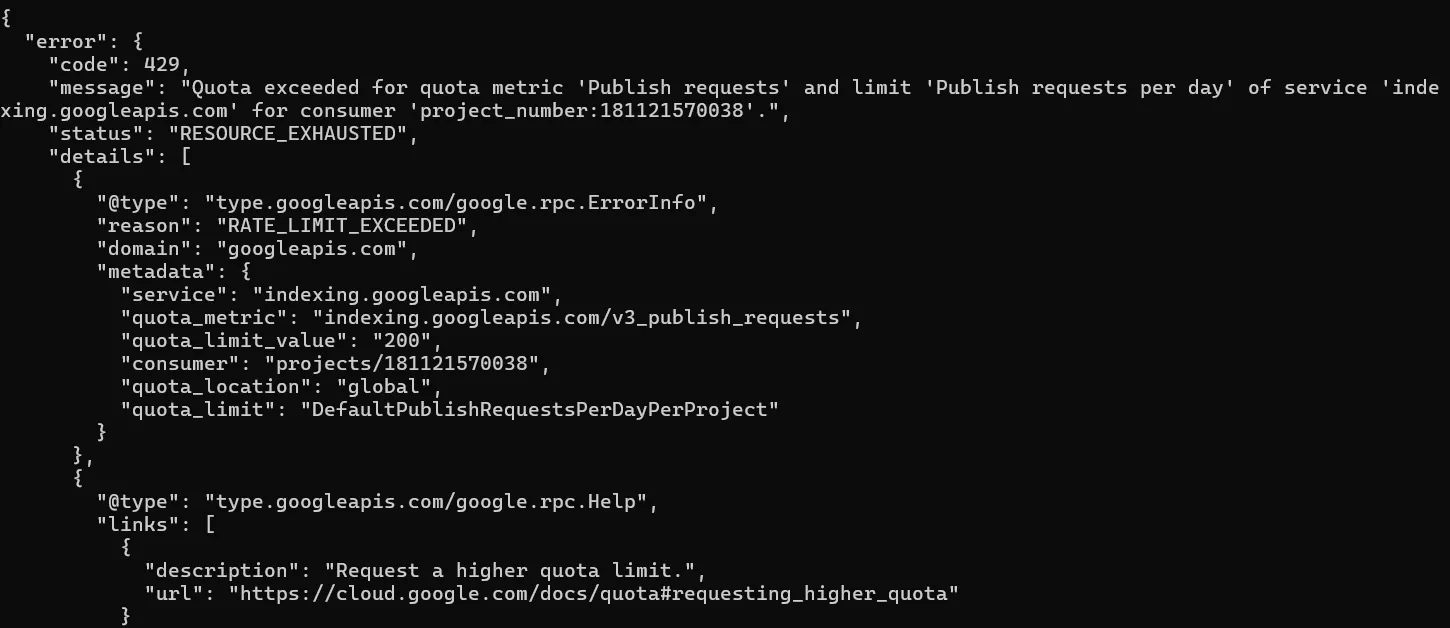

Код 429 — Too Many Requests

Возникает, если вы пытаетесь отправить более 200 URL-адресов в день для одного сайта.

Это не критическая проблема: вам необходимо дождаться 12 часов ночи по североамериканскому тихоокеанскому времени (это 10 утра по Киеву) и повторно отправить URL на сканирование.

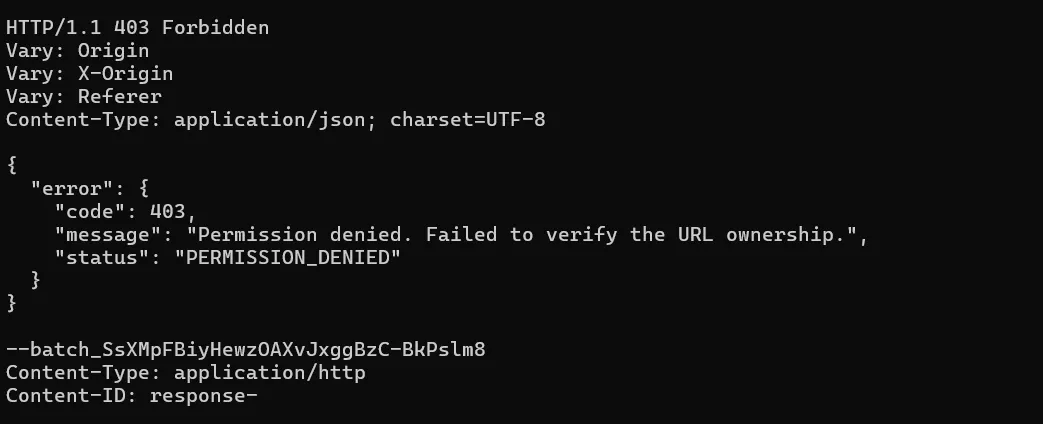

403 код — Forbidden

Данный код ответа может появиться, если вы отправили на сканирование URL-адреса другого проекта. То есть: у вас есть проекты Х и У (разные сайты) и вы в файл «urls» папки проекта Х добавили URL-адреса проекта У.

Для исправления отправьте URL-адреса через папку корректного проекта.

Такая же ошибка будет, если вы не привяжете почту своей сервисной учетной записи к Google Search Console или сделаете это, не указав роль «Владелец».

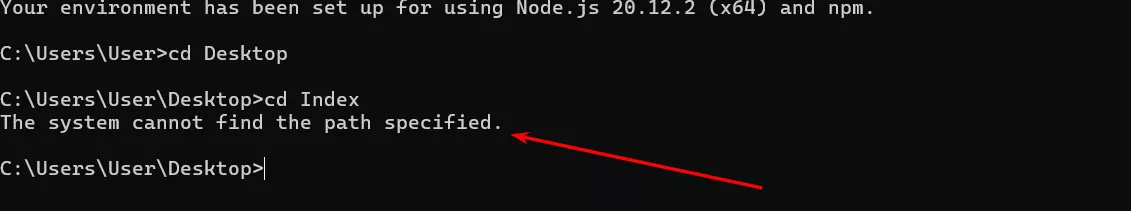

Система не может найти указанный путь

Означает, что вы могли неправильно указать путь при вводе элементов адреса папки в Node.js. Чтобы избежать этого, рекомендую копировать и вставлять отдельно каждый элемент адреса.

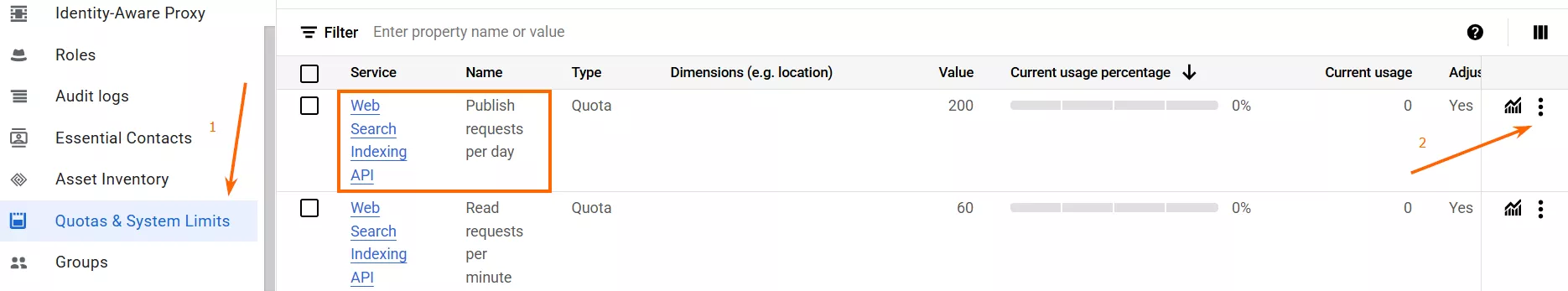

Можно ли отправлять более 200 URL-адресов в день?

Да, но для этого необходимо подать специальный запрос в Google на увеличение квот.

Сделать это можно в разделе «Quotas & System Limits» вашего аккаунта в Google Cloud Console, нажав на три точки напротив сервиса «Web Search Indexing API — Publish Requests per Day». После этого выберите функцию «Edit Quota».

В появившейся форме перейдите на опцию «Apply for higher quota».

Далее откроется Google-форма, где нужно указать имя и фамилию, электронную почту, желаемую ежедневную квоту, пример URL, который будет отправлен на индексацию и, соответственно, случай использования (для вакансий/прямых трансляций).

На следующем этапе формы ознакомьтесь с условиями увеличения квот, нажмите «Я понял» и подайте заявку.

Учтите следующие моменты при подаче заявки:

-

Принятие решения занимает две-три недели. Обращаться в Google за обновлениями нет смысла.

-

Ни в случае успеха, ни в случае неудачи вы не получите уведомления от Google. Понять, все ли прошло успешно, можно только посмотрев квоты на запросы Google Indexing API через три недели.

-

Google не объясняет причины отказа. Если ваш сайт соответствует требованиям (постинг вакансий/прямых трансляций), но запрос отклонен — подайте заявку повторно.

Что учитывать при индексации

Хотя Google Indexing API — полезный инструмент для сканирования и индексации отдельных типов страниц, он не гарантирует их индексацию. Если после использования инструмента ваши страницы не появились в индексе, учтите следующие факторы:

-

Страница уже добавлена в индекс, но еще не отображается в поиске и/или в отчете Google Search Console. Период между добавлением в базу и реальным появлением в выдаче может колебаться от нескольких часов до нескольких недель. Это зависит от таких показателей, как качество контента, конкуренция в выдаче, авторитет сайта, технические аспекты.

В отчете Google Search Console страница тоже может появиться не сразу, поскольку данные в Console попадают только через определенное время (обычно это 24–72 часа).

-

Страница является дублем.

-

Страница имеет слишком низкое качество по мнению Google.

-

Страница с редиректом.

-

Страница заблокирована мета-тегом noindex или через robots.txt

-

Страница на период сканирования отдавала 4xx или 5xx код ответа.

Как проверить индексацию страниц

Для этого есть следующие инструменты:

-

Проверка URL в Google Search Console.

-

Оператор site: в поиске. Добавляете к site: нужный URL-адрес. Если он уже есть в индексе, страница появится в результатах поиска.

-

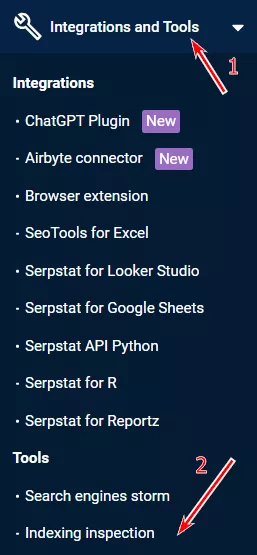

Проверка индексации URL с помощью сторонних сервисов. Для массовой проверки индексации URL-адресов можно использовать Serpstat. Инструмент доступен в разделе «Интеграции и инструменты» — «Инструменты», где будет вкладка «Проверка индексации».

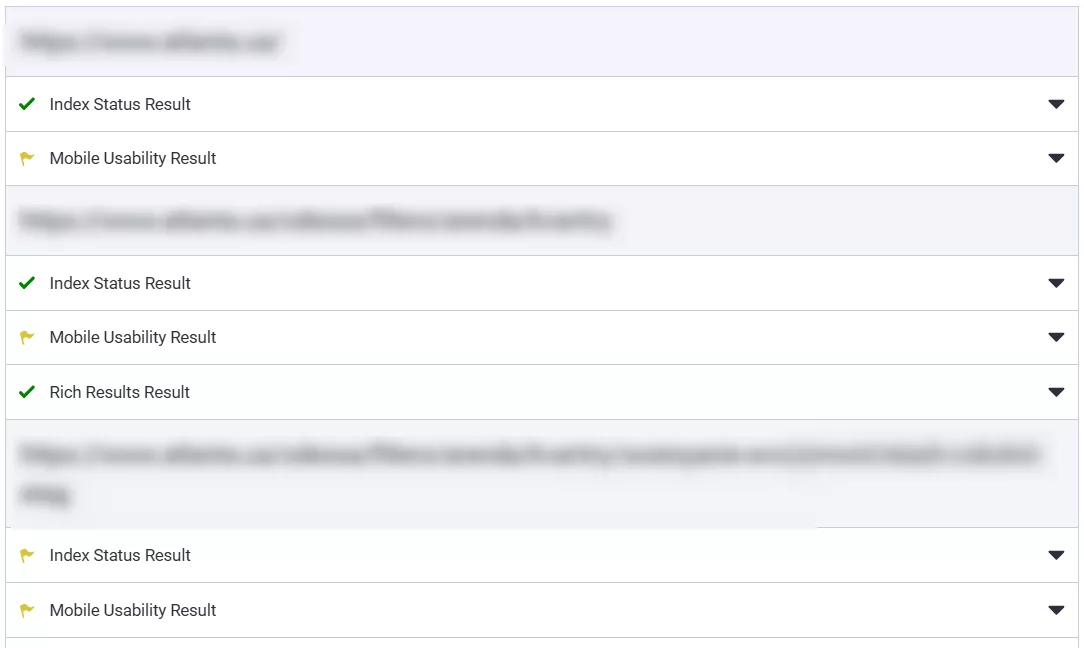

Далее выбираете необходимый домен. Предварительно необходимо добавить ваш собственный e-mail, который вы используете в Serpstat, в Google Search Console проекта в роли «Владелец», иначе вы не получите результатов. Затем добавляете URL-адреса, которые вам необходимо проверить (до 100 адресов за раз и до 2000 в целом за день), и нажимаете кнопку «Проверить страницы». Результаты будут выглядеть следующим образом.

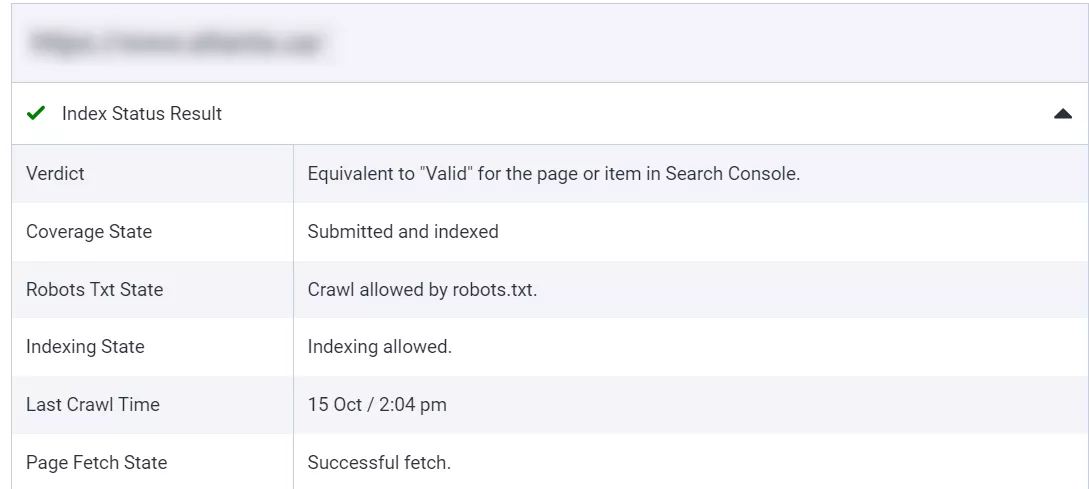

Index Status Result показывает, находится ли ваша страница в индексе поисковой системы Google. Может возникнуть ситуация, что в индексе страница уже есть, но в результатах поиска еще нет — в таком случае нужно подождать.

Если зеленая галочка — все хорошо, если желтый флажок — что-то мешает странице быть добавленной в индекс: просмотрите статус страницы, чтобы выяснить, в чем причина.

Выводы

-

Индексация сайта — добавление страниц и другого контента сайта в базы данных поисковых систем. Без нее ваш сайт пользователю будет невозможно найти в поиске.

-

Среди причин, затрудняющих индексацию — низкое качество страницы, дублированный контент, ручные санкции или фильтры. Среди тех, что влияют на процесс краулинга — плохая структура сайта, низкая скорость загрузки, большое количество редиректов, битых ссылок или 5хх ошибок, отсутствие мобильной версии, необрабатываемые файлы и директивы Robots.txt.

-

Чтобы ускорить индексацию страниц обычными методами, можно настроить грамотную внутреннюю перелинковку, увеличить скорость загрузки контента сайта, добавить Sitemap, уменьшить количество битых ссылок и редиректов. Среди инструментов можно выделить такие вещи, как Google Indexing API, ping-сервисы и инструмент проверки URL от Google Search Console.

-

Процесс подключения Google Indexing API включает в себя 6 базовых этапов:

-

настройка в Google Cloud Platform;

-

скачивание ZIP-папки с GitHub, добавление ключа J-SON в файл service_account;

-

подключение почты проекта в Google Search Console;

-

подключение Web Search Indexing API к проекту;

-

скачивание библиотеки, например — node.js;

-

отправка URL-адресов на индексацию с помощью node.js.

-

Среди частых ошибок, которые могут возникнуть при использовании Google Indexing API — 429 код — Too Many Requests, 403 код — Forbidden, Система не может найти указанный путь.

-

Отправить за день с одного проекта домена можно 200 URL-адресов, но можно отправить и больше — для этого необходимо запросить увеличение квот через Google.

-

Для проверки индексации можно воспользоваться как поисковым оператором и инструментом проверки URL от Google Search Console, так и сторонними сервисами вроде Инструмент проверки индексации URL от Serpstat.

Свежее

Что ждет бизнес и как адаптировать маркетинговые стратегии: AI-поиск 2026

Материал на основе митапа AI Search 2026. Рассматриваем изменения в AI-поиске и выдаче в целом.

Почему пользователи удаляют приложение и как этого избежать

Что именно заставляет пользователей забывать и удалять приложение? Разбираем и предотвращаем отток юзеров

Как настроить расширенную электронную торговлю с помощью Google Tag Manager

В этой статье разберу этапы построения системы — от стратегии до отдельных событий в воронке