Обратные ссылки остаются одним из трех основных факторов ранжирования Google. Именно поэтому наличие объективной картины по собственному ссылочному профилю и ваших конкурентов — важное условие для создания эффективной стратегии поискового продвижения.

Принято считать, что объем ссылочного индекса является основополагающим фактором при выборе SEO сервиса, позволяющего оценить внешние ссылки. Однако так ли это?

Свежее исследование Serpstat показало, что количество ссылок не равно качество, и многие маркетологи в погоне за цифрами тратят впустую бюджеты на неактуальные данные, включающие дубли, спамные и устаревшие ссылки.

Ключевые параметры исследования

Компания Serpstat провела анализ популярных платформ по параметрам, позволяющим дать не только количественную, но и качественную оценку их ссылочных индексов:

- объем ссылочного индекса;

- частота и скорость обновления данных;

- индекс покрытия;

- уникальность данных по ссылкам.

В исследовании рассмотрели такие сервисы SEO:

- ahrefs.com

- moz.com

- megaindex.ru

- semrush.com

- majestic.com

- serpstat.com

Чтобы получить максимально объективные результаты, специалисты Serpstat рассматривали данные сервисов для 10 доменов, выбранных рандомно, относящихся к разным нишам и имеющим различную географию и объемы трафика.

Результаты исследования

У каждого сервиса есть собственная архитектура, которую могут составлять ссылки различных типов:

- fresh;

- live;

- recent;

- historical.

Наиболее объективную картину показывают fresh ссылки, так как они определяются как активные при последней проверке, в отличие от других типов, которые могут включать устаревшие данные. Из-за того, что некоторые сервисы учитывают все существующие ссылки (а многие из них неактуальны), объем ссылочного индекса становится количественным, а не качественным параметром оценки информации в отчетах.

У каждого сервиса своя частота обновления данных. По словам опрошенных экспертов, чем чаще платформа актуализирует информацию, тем лучше. Большинство специалистов сходится во мнении, что оптимальная частота обновления в интервале от нескольких дней до двух месяцев.

Индекс покрытия определяет, какое количество от всех существующих ссылок показывают сервисы. В среднем данный параметр варьируется в рамках от 30% до 70%.

Так как определить точное количество всех ссылок невозможно, компания Serpstat использовала данные Google Search Console в качестве контрольного показателя для сравнения.

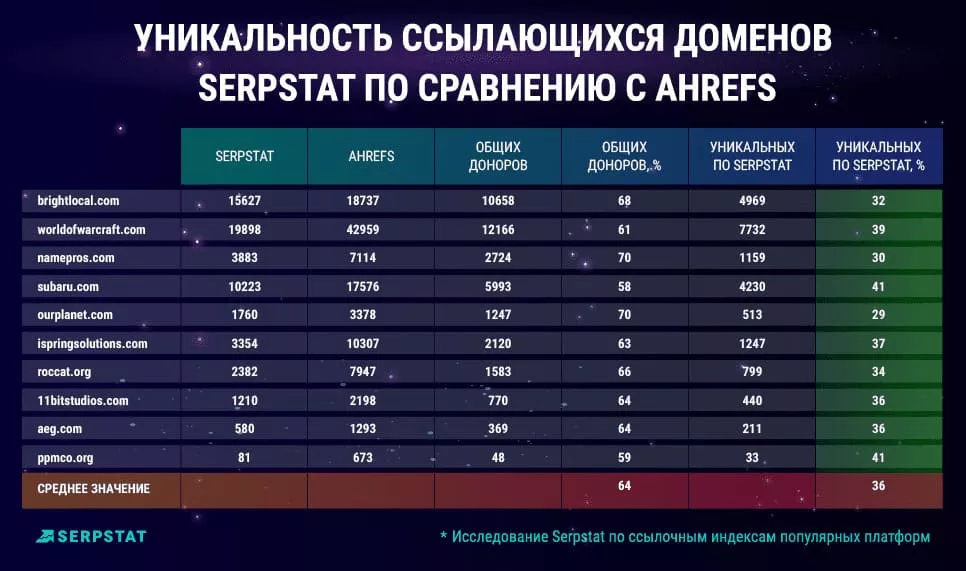

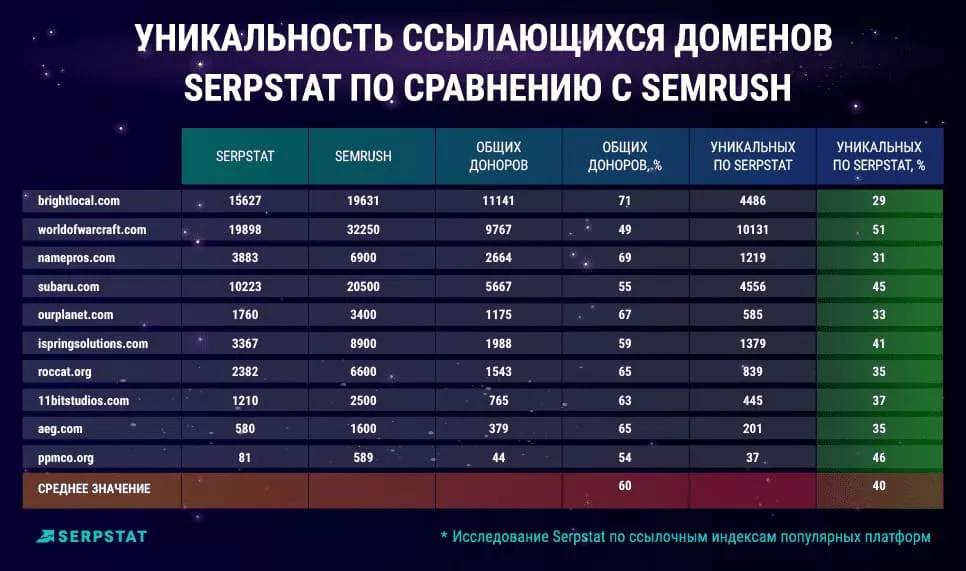

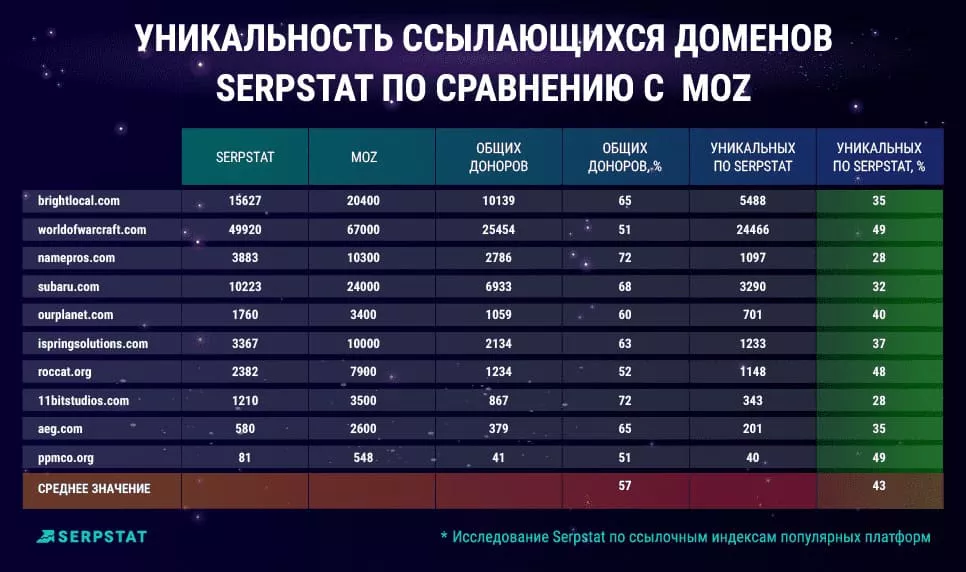

Одним из важнейших параметров при выборе сервиса для анализа ссылок считается уникальность данных: процент сайтов-доноров, отсутствующих в отчетах конкурирующих платформ.

Компания Serpstat сравнила собственные показатели с данными конкурентов, получив около 60% ссылающихся доменов, которые присутствуют в отчетах других сервисов, и в среднем 40% уникальных ссылок, не представленных в них.

В заключение

Объем ссылочного индекса не позволяет получить объективную картину по беклинкам, указывая на количественные, а не качественные показатели. При выборе сервиса анализа ссылок стоит ориентироваться на актуальность и уникальность данных, которые он предоставляет. Многие специалисты утверждают, что используют несколько платформ одновременно, чтобы иметь максимально точное представление о своих маркетинговых усилиях.

Важно: компания Serpstat дарит скидку 30% существующим клиентам и 40% новым пользователям на покупку тарифного плана на 6 месяцев или год. Акция проводится продлится до 17 декабря 2021 года включительно.

Больше информации — в оригинале поста на блоге Serpstat.

Свежее

Cloud Marketing и AI-аналитика: как бизнес оптимизирует рекламу благодаря данным

В статье рассмотрю, как внедрить AI, GA4 и Google Cloud в маркетинг, сократить время до инсайта и повысить ROMI. Покажу, как бизнес адаптируется к новым требованиям и повышает эффективность за счёт данных

Аудит оптимизации в App Store и Google Play: подробное руководство

Чтобы выделяться среди других, нужна качественная оптимизация. И именно здесь пригодится аудит оптимизации в App Store и Google Play

Как настроить тег конверсий Google Ads через Google Tag Manager

Из этой статьи-инструкции вы узнаете, как настроить тег пошагово, избежать технических ошибок и обеспечить передачу ключевых параметров транзакции в Google Ads