Этот пост был опубликован в 2018 году и до сих пор пользуется популярностью (если верить Google Analytics). Напомню, материал — адаптация перевода и в то же время пересказ статьи с www.SEOmoz.org. В посте есть пояснения из Википедии, потому что хоть пост и более узкоспециализированный, не хотим заставлять вас бесконечно гуглить.

Суть вопроса в том, что СЕОмоз создал систему, которая определяет ключевые слова в тексте. Но не просто подсчитывает все и выдает плотность ключевых слов, нет. Такой способ определения плотности ключей уже давным давно устарел и мир шагнул далеко вперед. Сегодня мы рассмотрим несколько вариантов определения релевантности документа ключевому запросу. Итак, готовьтесь встречать искусственный интеллект и семантический поиск по смыслу написанного к 2020 году.

А пока рассмотрим, какие же алгоритмы используются для определения релевантности различных документов (часть информации взята из Википедии).

Еще в незапамятном XX веке началось развитие метода TF-IDF (от англ. TF — term frequency, IDF — inverse document frequency) — статистическая мера, используемая для оценки важности слова в контексте документа, являющегося частью коллекции документов. Мера TF-IDF часто используется в задачах анализа текстов и информационного поиска, например, как один из критериев релевантности документа поисковому запросу, при расчёте меры схожести документов при кластеризации (выделение групп документов, похожих по смыслу).

TF (term frequency — частота слова) — отношение числа вхождения некоторого слова к общему количеству слов документа. Таким образом, оценивается важность слова в пределах отдельного документа.

IDF (inverse document frequency — обратная частота документа) — инверсия частоты, с которой некоторое слово встречается в других документах. Учёт IDF уменьшает вес часто и широко употребляемых слов. Таким образом, мера TF-IDF - произведение двух сомножителей: TF и IDF.

TF-IDF вес для слова «заяц»

Если документ содержит 100 слов и слово «заяц» встречается в нём 3 раза, то частота слова (TF) для слова «заяц» в документе будет 0,03 (3/100). Один из вариантов вычисления частоты документа (DF) определяется как количество документов содержащих слово «заяц», разделенное на количество всех документов. Таким образом, если слово «заяц» содержится в 1000 документов из 10 000 000 документов, то частота документа (DF) будет равной 0,0001 (1000/10 000 000). Для расчета окончательного значения веса слова необходимо разделить TF на DF (или умножить на IDF). В данном примере, TF-IDF вес для слова «заяц» в выбранном документе будет 300 (0,03/0,0001).

По наблюдениям Рэнда Фишкина за результатами выдачи Гугла, влияние on-page факторов вроде использования ключевых слов или TF-IDF довольно мало. Даже в низкоконкурентных запросах не наблюдается такого, чтобы кто-то мог просто написать больше раз свой ключевой запрос (или использовать синонимы), чем конкурент и улучшить позиции в выдаче. И этот опыт, который подкрепился разговорами с сеошниками, заставил Фишкина верить в то, что поисковые машины ранжируют более сложно, учитывая связи между словами и фразами. Поэтому, СЕОмоз начал работу над крупным проектом, который назвали — LDA (Latent Dirichlet Allocation).

Кому интересно распределение Дирихле из теории вероятностей, которое использовалось в данной системе, может почитать о нем вот тут — Распределение Дирихле. В двух словах скажу, что оно описывает связь между словами. То есть, какое слово чаще всего используется с каким-нибудь другим, какие слова вообще вместе не используются и т.д. Все это подводит нас к тематическим моделям.

Почему поисковым машинам необходимо тематическое моделирование?

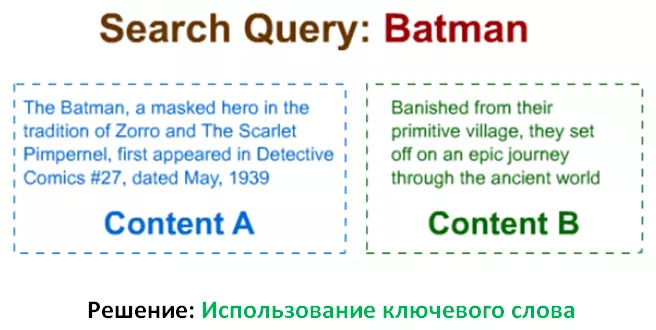

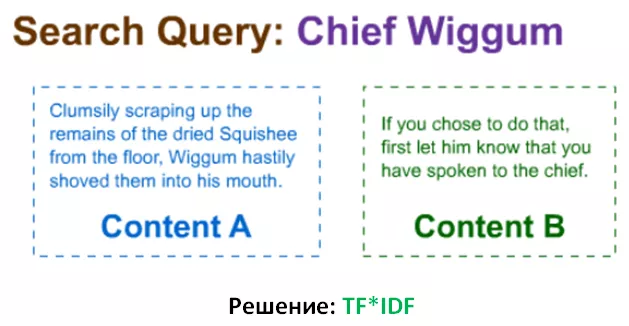

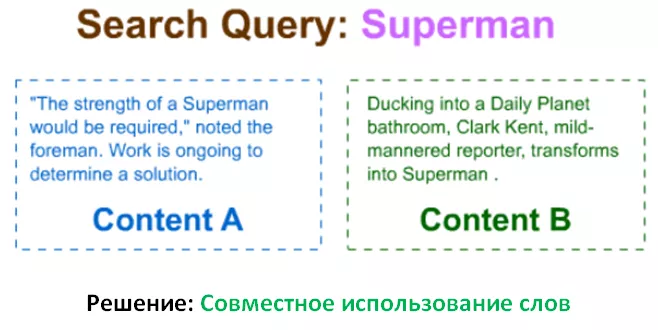

Некоторые запросы довольно простые. Поиск по запросу «Википедия» не слишком сложный и результат по такому поиску может вернуть даже простая поисковая машина. Но некоторые другие запросы не являются такими же простыми. Давайте посмотрим как поисковые системы могут упорядочивать два результата — простая проблема, которая, в большинстве случаев, может быть комплексно решена несколькими методами, в зависимости от ситуации. Запросы привожу на английском языке, как есть в оригинале.

Так как Контент А содержит слово «Batman», а контент В — нет, то ПС может легко выбрать, какой же запрос поставить выше в выдаче.

ПС может использовать TF*IDF для определения того, что слово «Wiggum» имеет меньшую частоту употребления, чем «chief» и поэтому, Контент А будет считаться более релевантным запросу. Обратите внимание, что этот пример ясно показывает недостаток такой метрики, как плотность ключевого слова.

Используя знания о совместном использовании слов, ПС определит, что «Daily Planet» и «Clark Kent» появляются чаще со словом «Superman» и поэтому, Контент В будет более релевантен, чем Контент А, в котором есть точное вхождения ключа в текст!

Прочитав оба предложения, мы можем сделать однозначный вывод, что Контент В описывает музыкальный инструмент — пианино — и женщина играет на нем. Но, поисковая машина, вооруженная методами, которые мы описывали раньше, будет бороться с этими предложениями, т.к. оба они используют слова «keys» и «notes», которые являются только ключами к головоломке. СЕОмоз рад, что их система LDA поставила Контент В выше, чем А. Значит, их алгоритмы на правильном пути.

Для более комплексных запросов или когда большое влияние на результат могут оказать множество связей в контенте, ПС необходимы пути, для определения цели данной страницы. То, что на странице повторяется 4 или 5 раз ключевое слово, совсем не означает, что страница действительно релевантна запросу пользователя.

Исторически сложилось так, что много сеошников прикладывали очень много усилий в этом направлении, поэтому то, что делает СЕОмоз — это не революционное тематическое моделирование, которое включает в себя LDA, всегда было вокруг да около. Но, никто из тех, кто развивается в данном направлении, не делал такую систему общедоступной или сравнимой с результатами выдачи Гугла, чтобы показать, как могут влиять на позиции данные сигналы. Итак, суть ясна, я думаю.

Плотность ключевых слов была хороша раньше, сегодня мир шагнул далеко вперед в данном направлении.

Так давайте же заглянем внутрь и посмотрим на сердце данного метода.

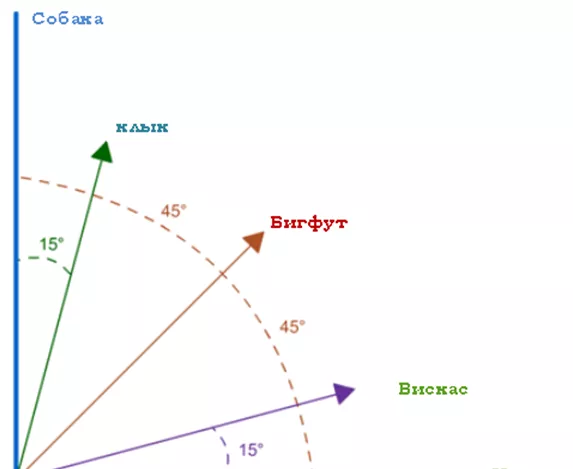

Векторное пространство терминов и Тематическое моделирование

Упрощенная модель векторного пространства

Представим себе, что в данный момент существуют только две темы — «Собака» и «Кошка», а все остальные слова в разной степени связаны с этими двумя тематиками. К примеру, слово «клык» чаще всего используется со словом «Собака», а «Вискас» — с «Кошка». В действительности так и есть, любые два слова связаны между собой более или менее сильно. Эта модель просто представляет эти связи математически. К сожалению, изобразить больше, чем три тематики (три измерения), мне очень сложно, но вы должны помнить, что таких тематик много. Соответственно и измерений много. И каждое слово можно отнести частично к этой тематике, частично к другой. И получаются вектора в многомерном пространстве. Кому интересно углубиться в векторное пространство, вот вам материалы Стэндфордского Университета по этому повод.

К сожалению, у LDA пока что очень много ограничений. Он работает только для англоязычных сайтов и не отражает полной и стопроцентной картины. Так как это, все-таки, не Гугл. Также, LDA не использует пока что фразы и очки в % по LDA являются относительными, так как это только что запущенная версия и в ней есть свои недочеты. И следует запомнить, что увеличение количества ключевых слов может помочь получить больше очков в LDA, но вряд ли поможет улучшить позиции.

Прошу всех не упускать из головы то, что система делалась 10 месяцев двумя математиками-программистами, а в Гугле работают не двое.

Думаю, что обещания Гугла по поводу семантического поиска имеют под собой серьезную основу. Роботы прогрессируют и готовятся захватить человечество. Поэтому нам нужно внимательно за ними следить, чтобы не упустить тот момент, когда начнется восстание машин. Очень надеюсь, что эти материалы помогут в написании тематических текстов копирайтерам. Да и сеошникам они полезны.

Кстати, если вам нужен не просто оптимизированный с точки зрения SEO пост, но и продающий полезный материал, который поможет привлечь трафик, получить заявки, повысить узнаваемость бренда и так далее... Обращайтесь, редакция Netpeak Journal создаст качественный контент и разместит его в журнале.

Оставить заявку можно, заполнив форму:

Свежее

Что такое Data Layer и переменные уровня данных в Google Analytics 4

Data Layer — это хранилище данных, которые могут быть использованы для отслеживания событий и формирования отчетов. Как именно, рассказываю в статье

Как автоматизировать бизнес-процессы с помощью чат-ботов с AI

Статья создана по материалам митапа, проведенного Виталием Ивановым, Head of Retention Marketing в Netpeak Ukraine

Аналитика для удержания клиентов: как внедрить лучшие решения

В этой статье я расскажу об основных метриках для оценки результативности системы удержания пользователей