Продвижение сайта в поисковых системах — комплексная процедура. Если пропустить хотя бы один из этапов оптимизации, то легко потерять позиции или не добиться желаемых результатов. On-page ошибки связаны с конкретной страницей, но зачастую шаблонно распространяются на все страницы домена.

Список основных on-page ошибок:

- отсутствуют метаданные;

- нерелевантные метаданные;

- неканоническая страница;

- страница закрыта/не закрыта от индексации;

- не указаны атрибуты hreflang;

- неправильная структура заголовков;

- долгая загрузка;

- плохое usability;

- неоптимизированные изображения;

- плохие тексты;

- ошибки в микроразметке данных;

- невалидность кода.

Каждый пункт из списка может привести к ухудшению ранжирования страниц сайта поисковыми системами.

Однако, проверять все это вручную — не лучшая идея, тем более на регулярной основе. Поэтому существуют бесплатные и платные сервисы и программы, которые позволяют автоматизировать проверку.

Важно: бесплатные инструменты предоставляют меньше возможностей по сравнению с платными. Кроме того, бесплатные решения зачастую нужно дольше настраивать, в отличие от платных, где для анализа ошибок все уже готово.

1. Netpeak Spider

Цена: платно, пробный период — 14 дней.

Netpeak Spider — десктопный краулер, предназначенный для анализа сайта на внутренние SEO-ошибки, а также позволяющий извлекать из него необходимые данные. По умолчанию программа обходит весь сайт, начиная с главной страницы и продвигаясь по ссылкам вглубь сайта. Помимо этого, в Netpeak Spider вы можете сканировать:

- определённую директорию;

- заданный список URL;

- страницы, указанные в файле Sitemap.xml;

- страницы, соответствующие заданным требованиям.

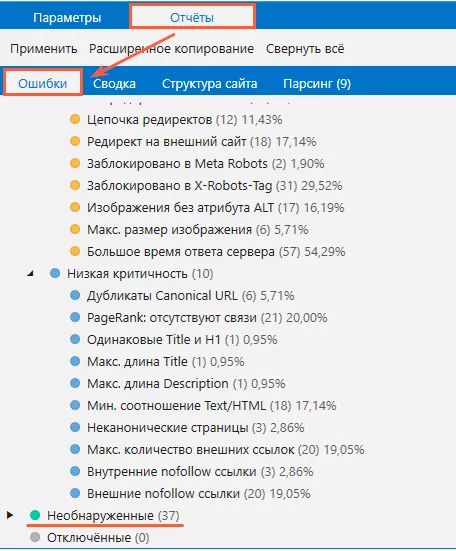

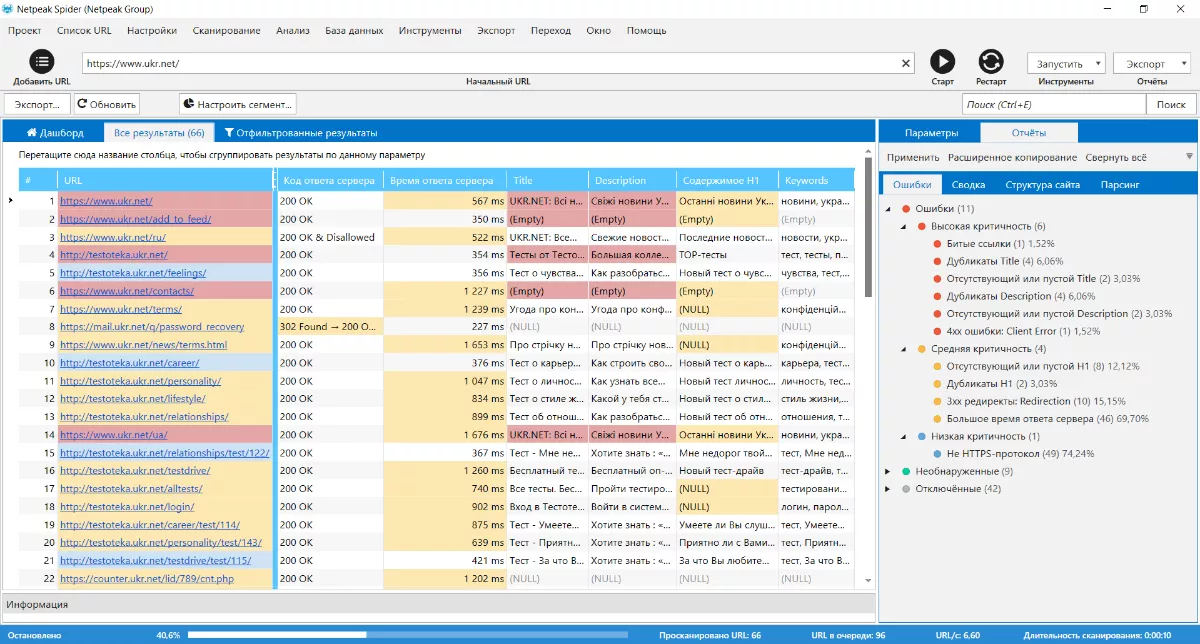

Netpeak Spider предоставляет широкие возможности для проверки всех страниц сайта на 60+ on-page ошибок. Полный список найденных внутри сайта ошибок отображается по итогу сканирования на боковой панели на вкладке «Ошибки». Те ошибки, которые краулер на данном сайте не нашёл, скрываются в самом низу списка:

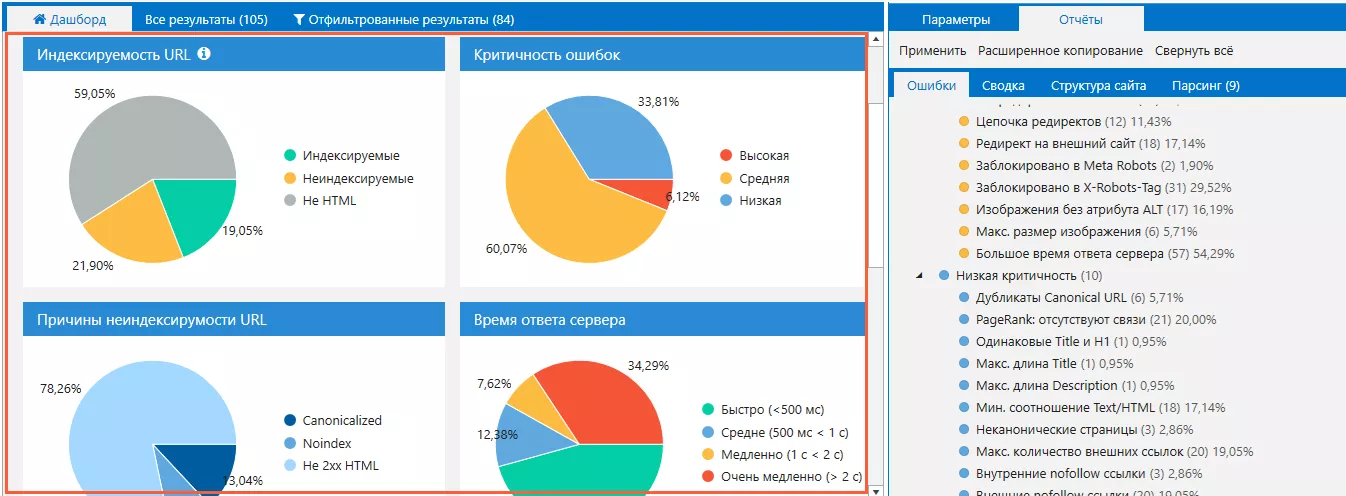

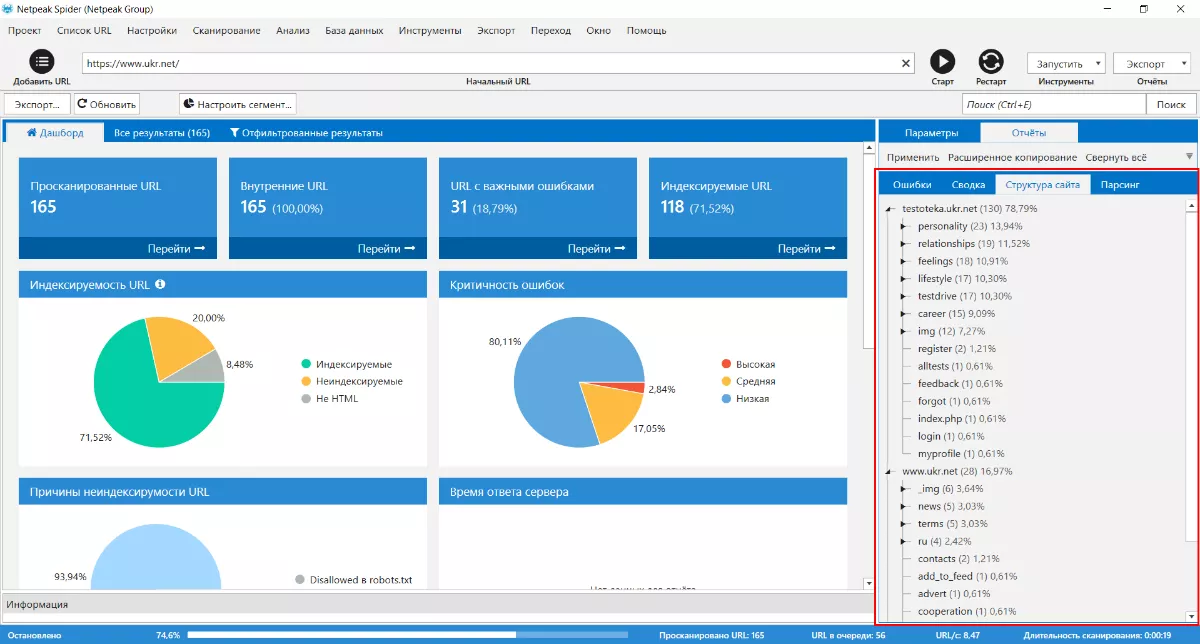

Удобная особенность программы заключается в том, что данные сканирования представлены не только в виде перечня ошибок, но также в виде детальных сводных данных (вкладка «Сводка» на боковой панели) и удобных кликабельных диаграмм на панели «Дашборд». К примеру, одна из них показывает процент страниц, которые могут быть проиндексированы поисковыми системами, другой — причины, по которым те или иные URL могут не попасть в индекс.

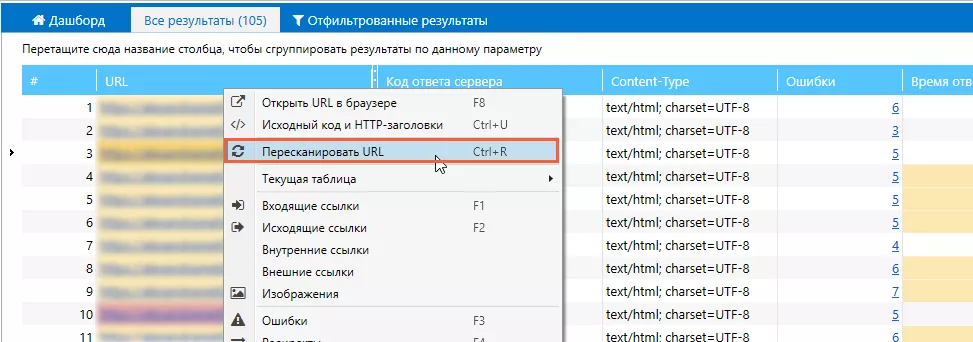

После исправления всех найденных ошибок проблемные страницы можно пересканировать.

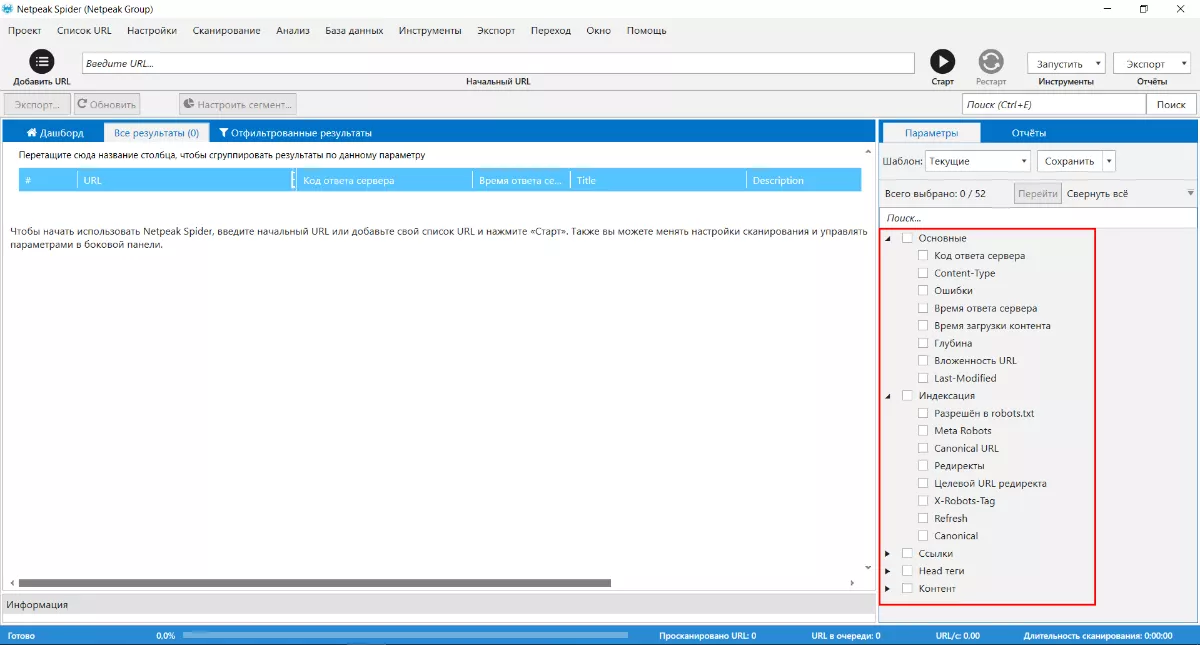

Spider позволяет выбирать необходимые для проверки параметры, а ненужные отключать.

Вот пример прохода программы по сайту:

Для проверки выбирали параметры: «Код ответа сервера», «Время ответа сервера», «Title», «Description», «Содержимое H1», «Keywords».

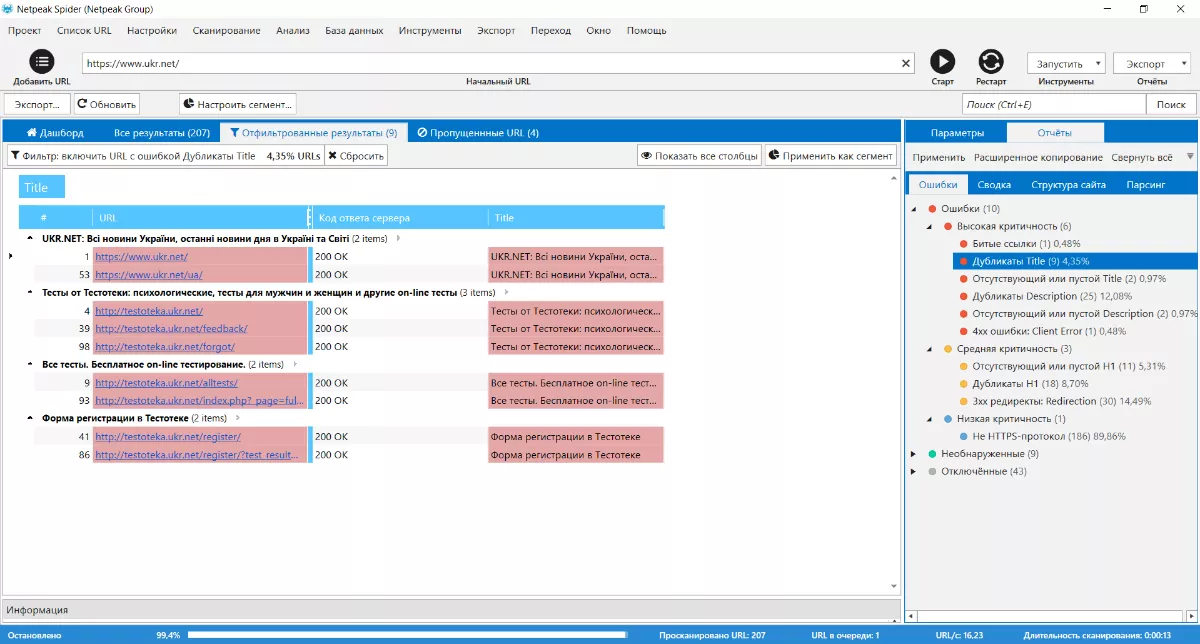

Чтобы просмотреть детальную информацию по каждой ошибке, достаточно кликнуть по её названию:

Netpeak Spider умеет самостоятельно составлять структуру сканируемого сайта. Это помогает выявить шаблонные проблемы страниц одной категории или раздела:

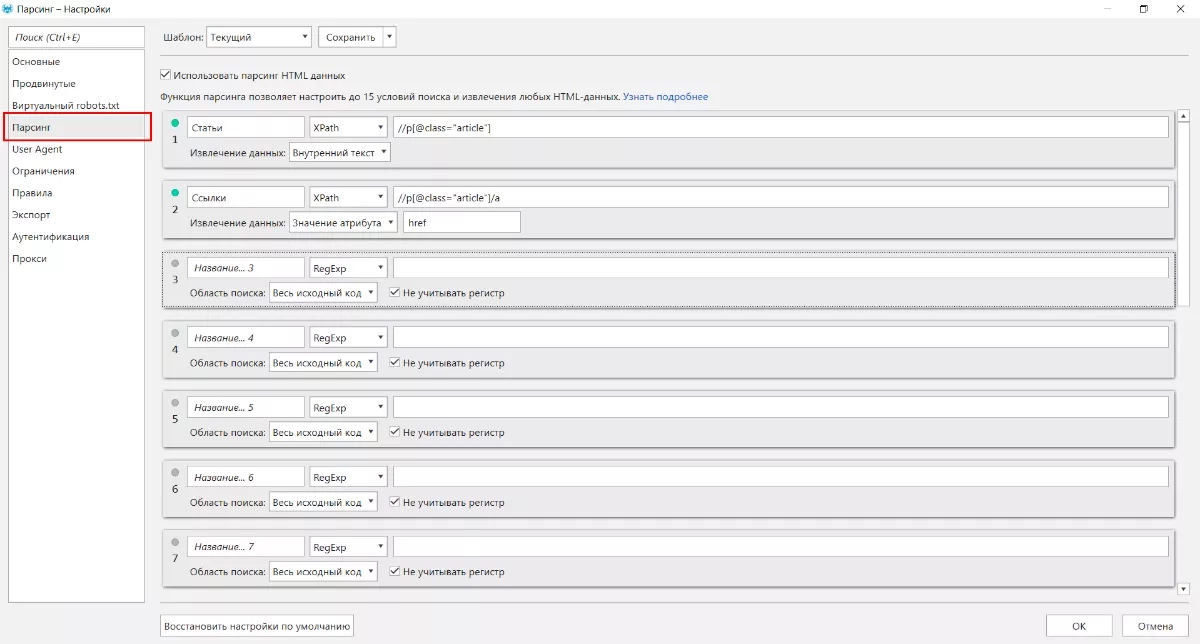

Если этого покажется мало, используйте функцию «Парсинг», которая расширяет возможности программы и позволяет извлекать данные при помощи XPath, CSS-селекторов и регулярных выражений:

Помимо основного функционала, в программе предусмотрено несколько полезных самостоятельных инструментов:

- анализ исходного кода и HTTP-заголовков, удобный для мгновенного изучения найденной проблемы;

- расчёт внутреннего PageRank, который позволяет выявить проблемы с распределением ссылочного веса внутри сайта;

- валидатор XML Sitemap, предназначенный для проверки карты сайта на ошибки;

- генератор Sitemap, с помощью которого можно сделать карту сайта в разных форматах.

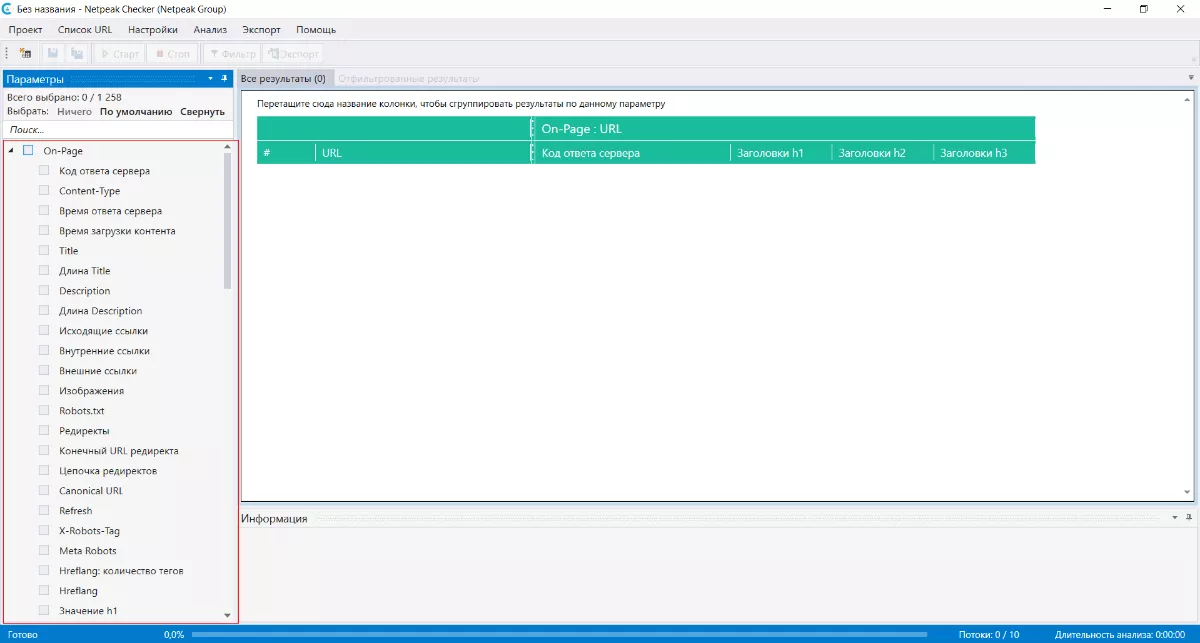

2. Netpeak Checker

Цена: платно. Пробный период: 14 дней.

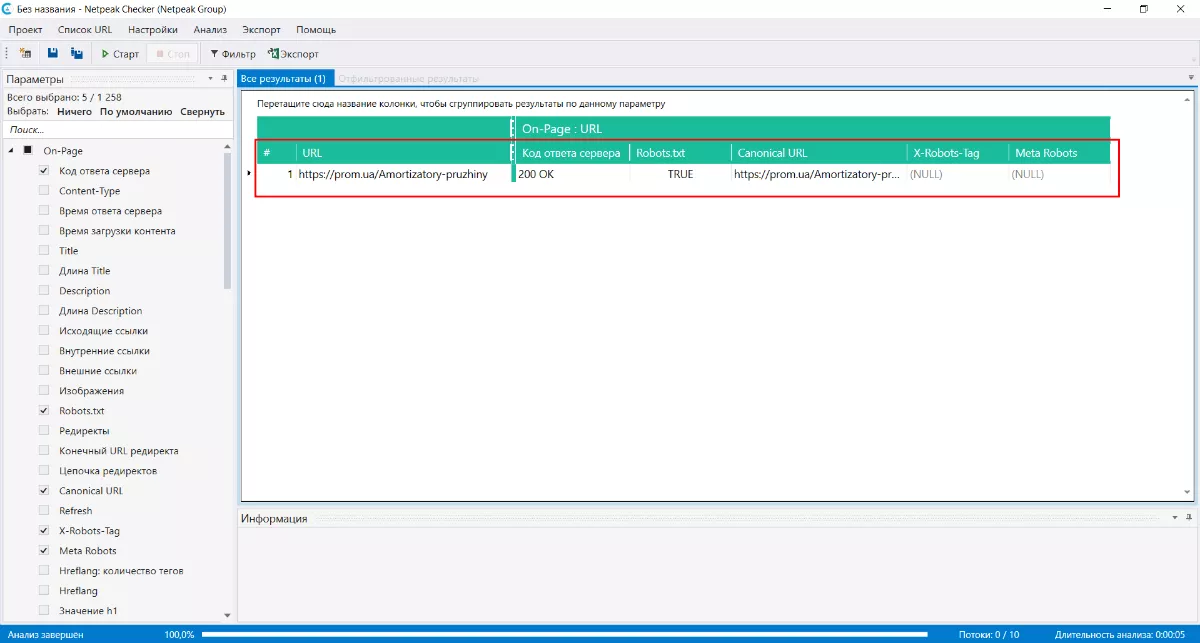

Программа Netpeak Checker предназначена, в первую очередь, для работы с off-page оптимизацией (более 1200 параметров суммарно), но также обладает базовым функционалом для проверки on-page ошибок:

Checker позволяет пробить интересующие параметры для заданного списка URL. Можно делать собственные связки параметров.

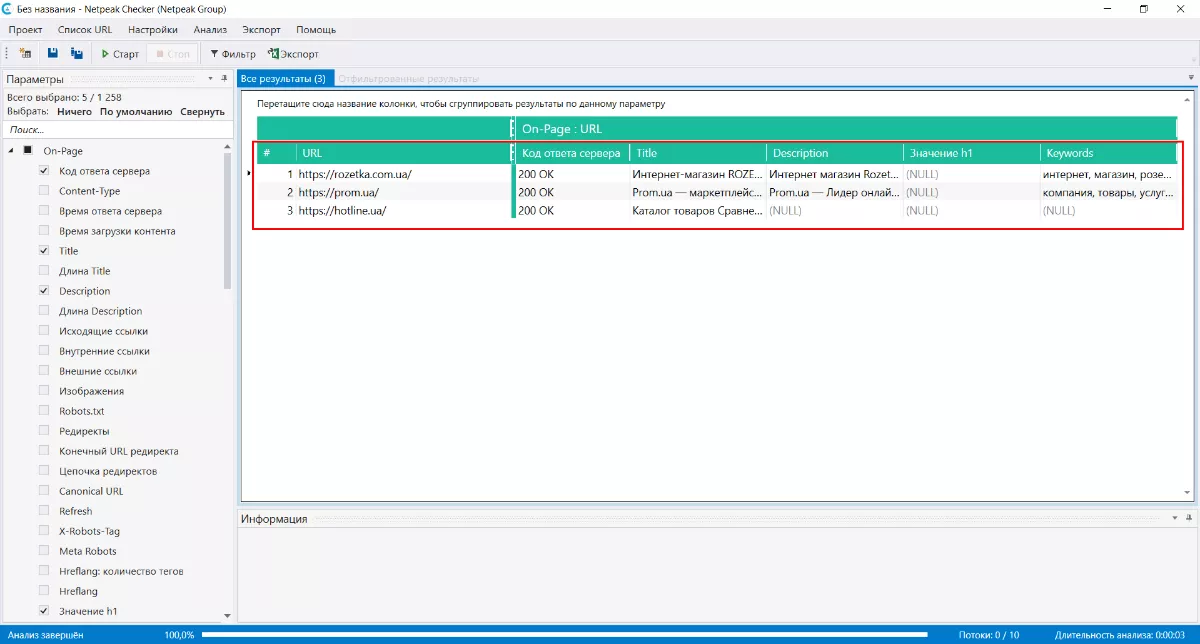

Например, проверим:

- какие метаданные содержит список страниц (параметры: «Код ответа сервера», «Title», «Description», «Значение h1», «Keywords»). Вот что получится после сканирования:

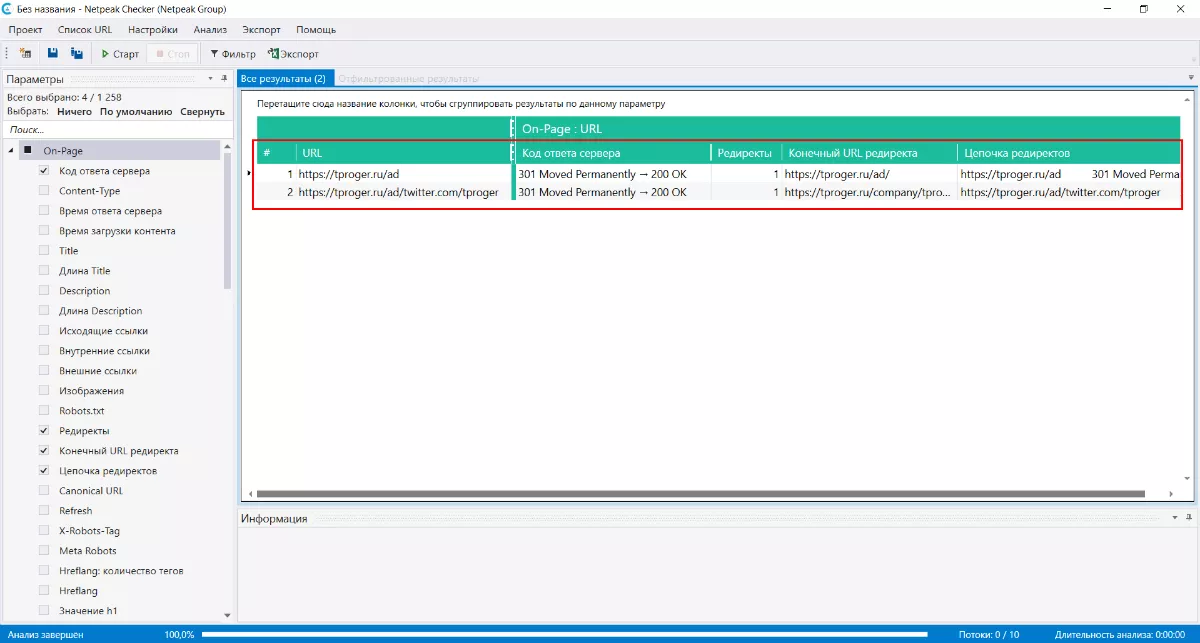

- корректно ли настроен редирект (параметры: «Код ответа сервера», «Редиректы», «Конечный URL редиректа», «Цепочка редиректов»):

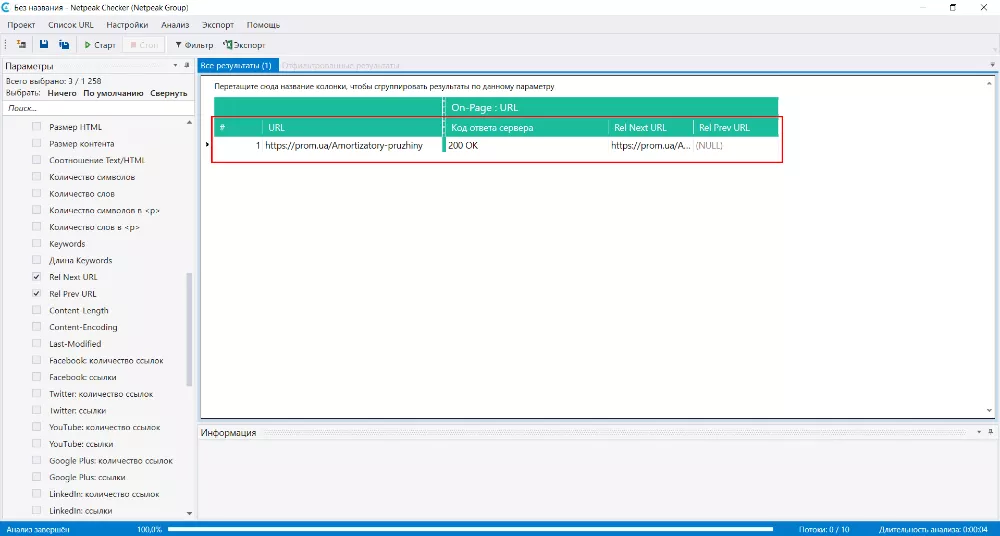

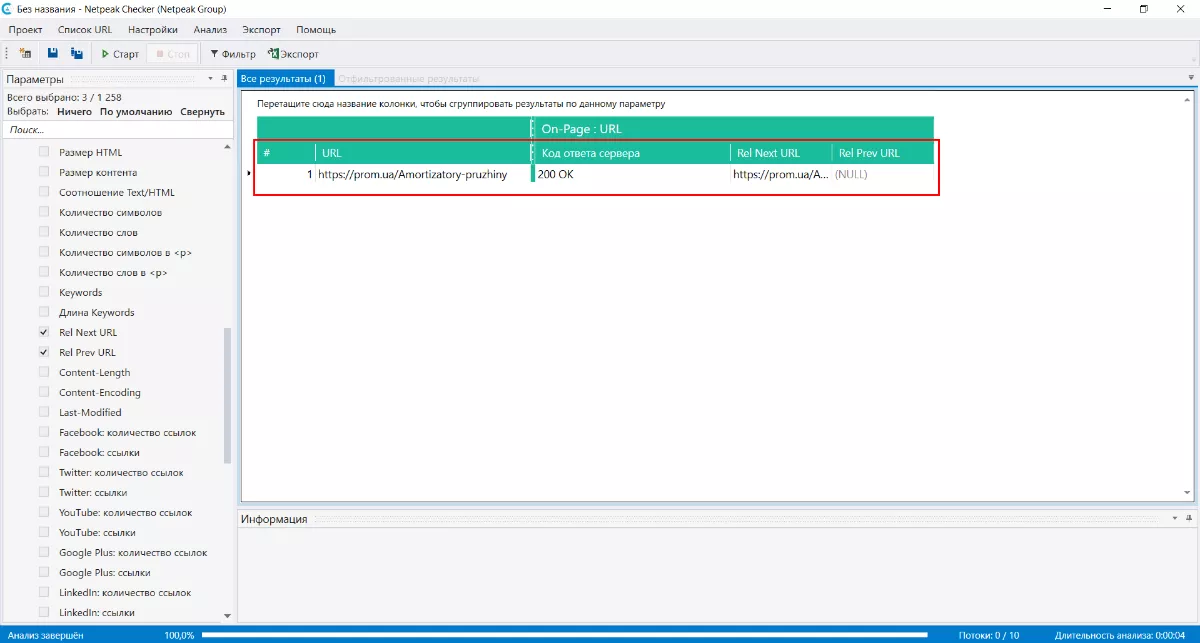

- установлен ли rel="next" и rel="prev" для страниц пагинации (параметры: «Код ответа сервера», «Rel Next URL», «Rel Prev URL»):

- открыта ли страница для индексации (параметры: «Код ответа сервера», «Robots.txt», «Canonical URL», «X-Robots-Tag», «Meta Robots»):

- открыта ли страница для индексации (параметры: «Код ответа сервера», «Robots.txt», «Canonical URL», «X-Robots-Tag», «Meta Robots»):

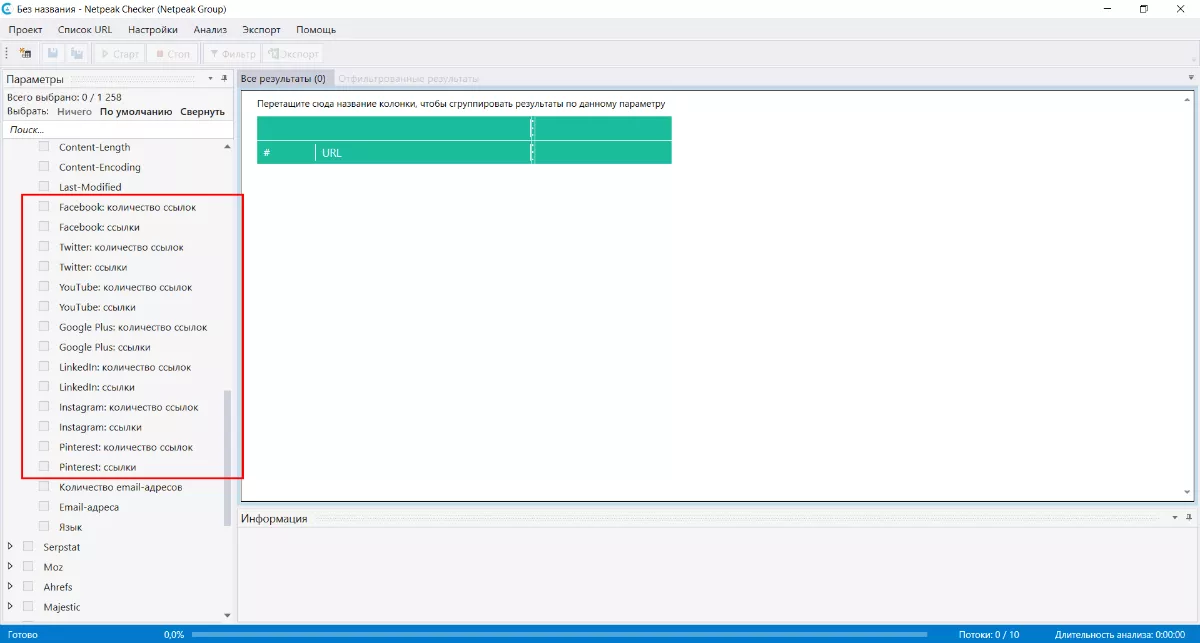

- насколько страница популярна в социальных сетях:

В программе доступны и другие параметры проверки — их можно связать между собой в один отчет.

3. Sitechecker.pro

Цена: бесплатно.

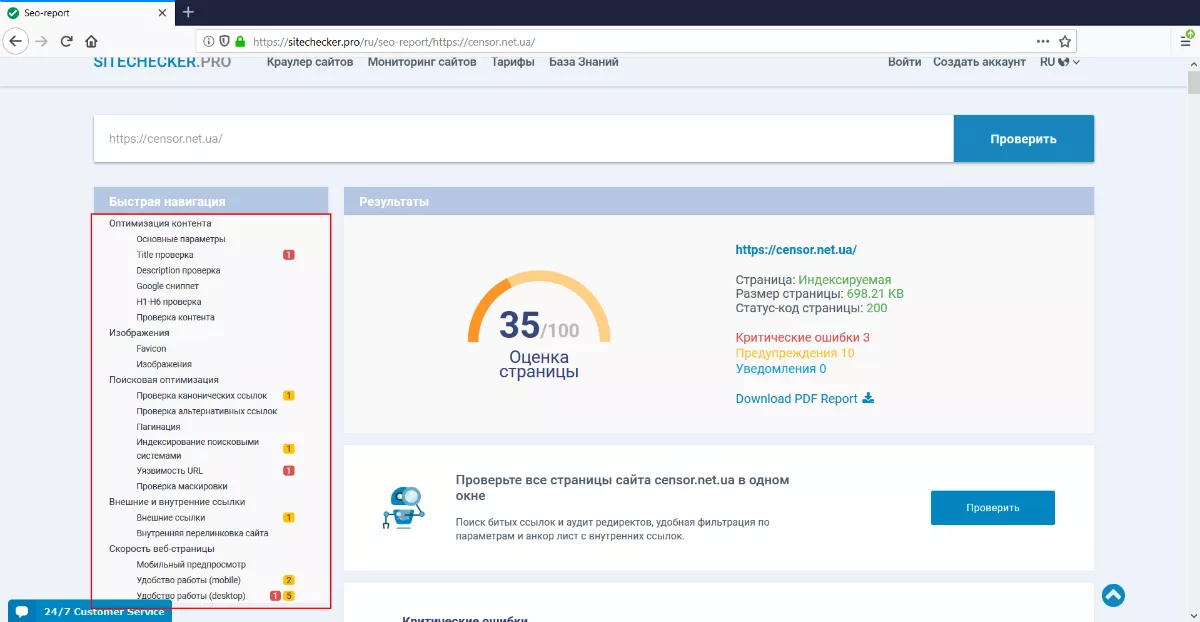

Сервис позволяет проверить страницу по таким параметрам:

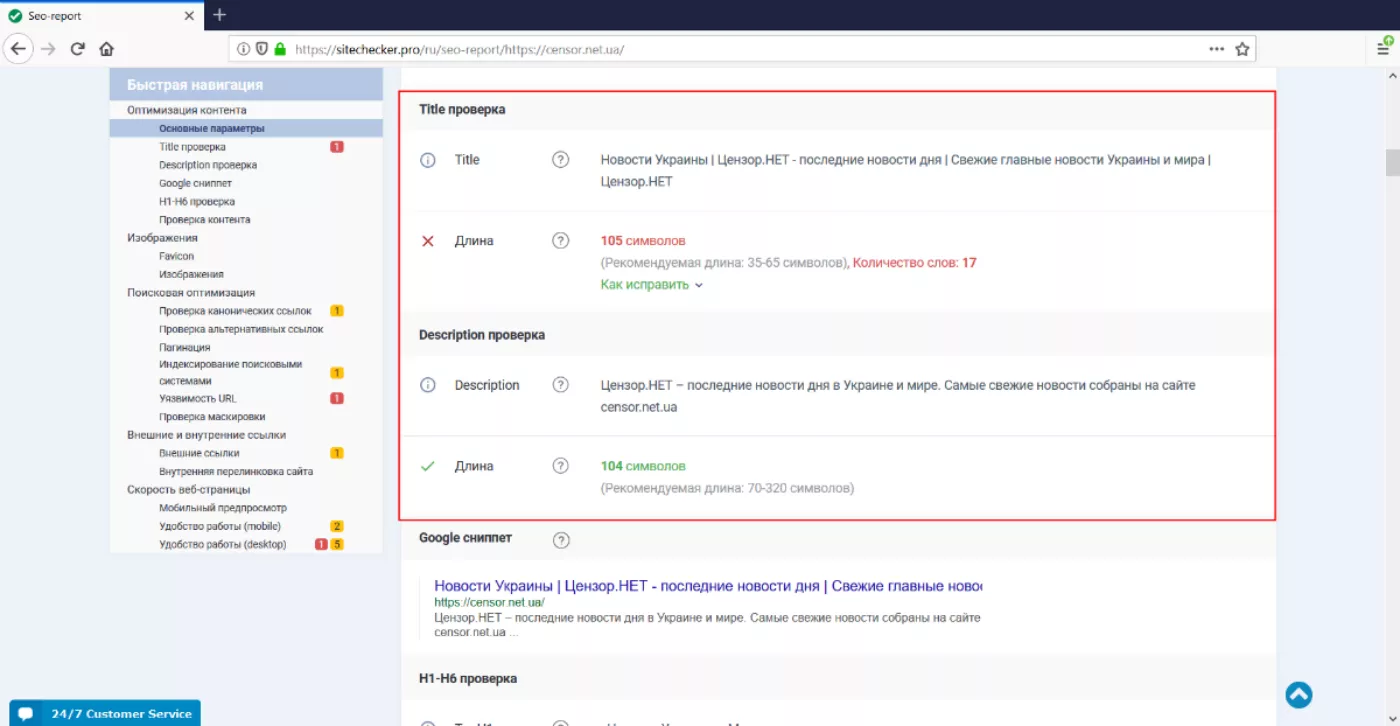

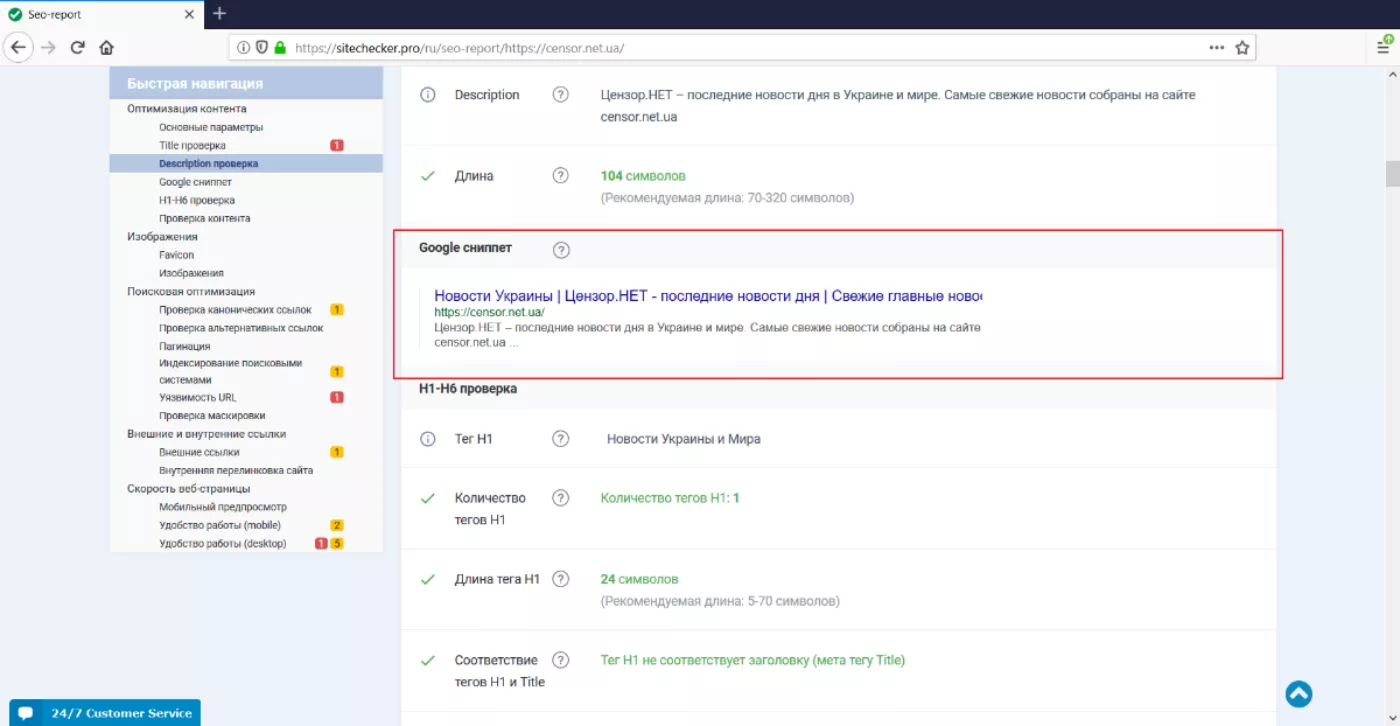

Интересная особенность Sitechecker — он показывает метаданные:

А еще показывает, как будет выглядеть сниппет в поисковой выдаче Google:

Из стандартных возможностей — сервис может проверить, например:

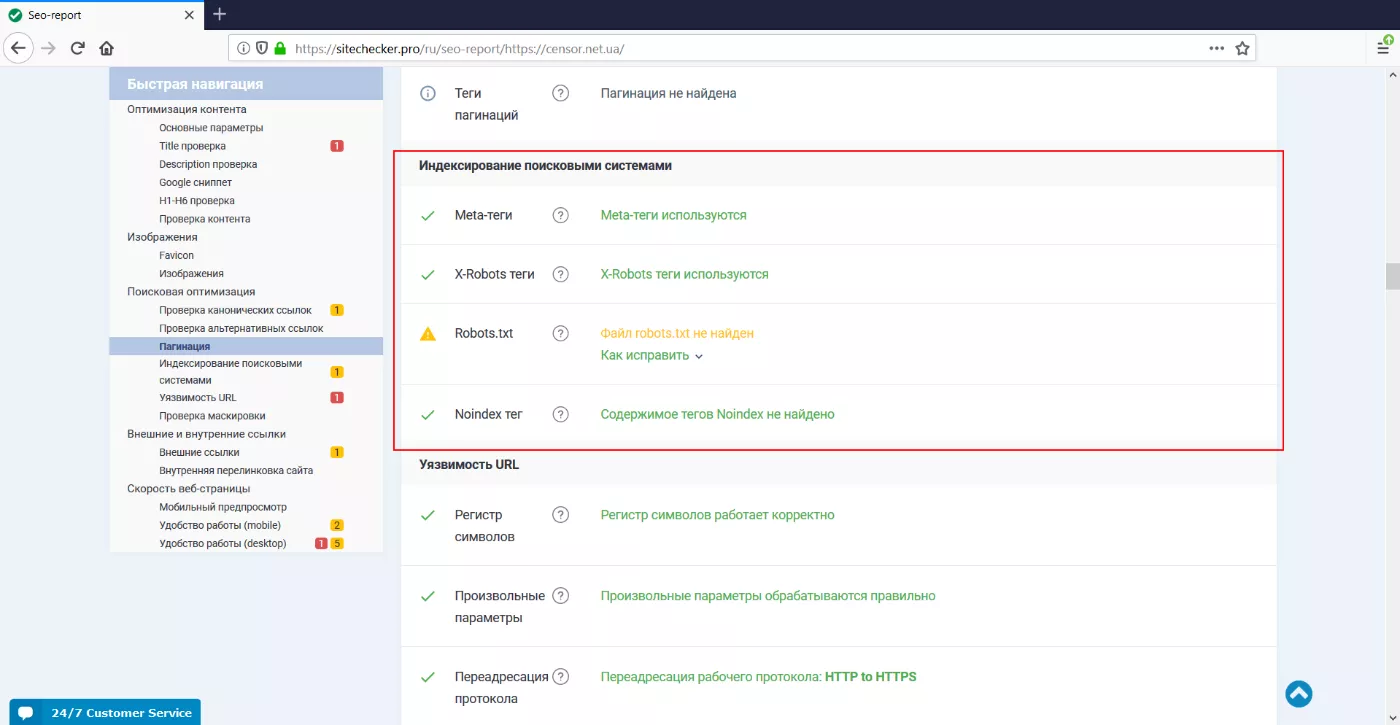

- настройки индексации:

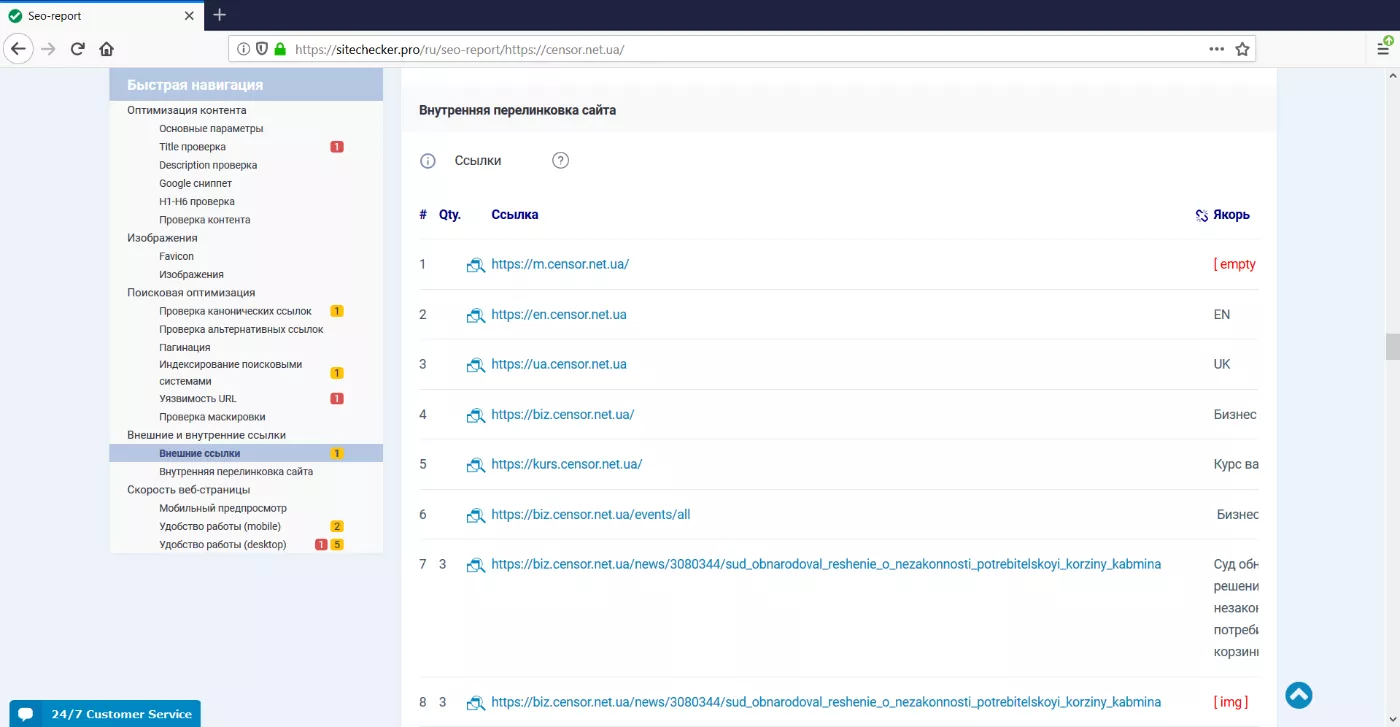

- внутренние ссылки:

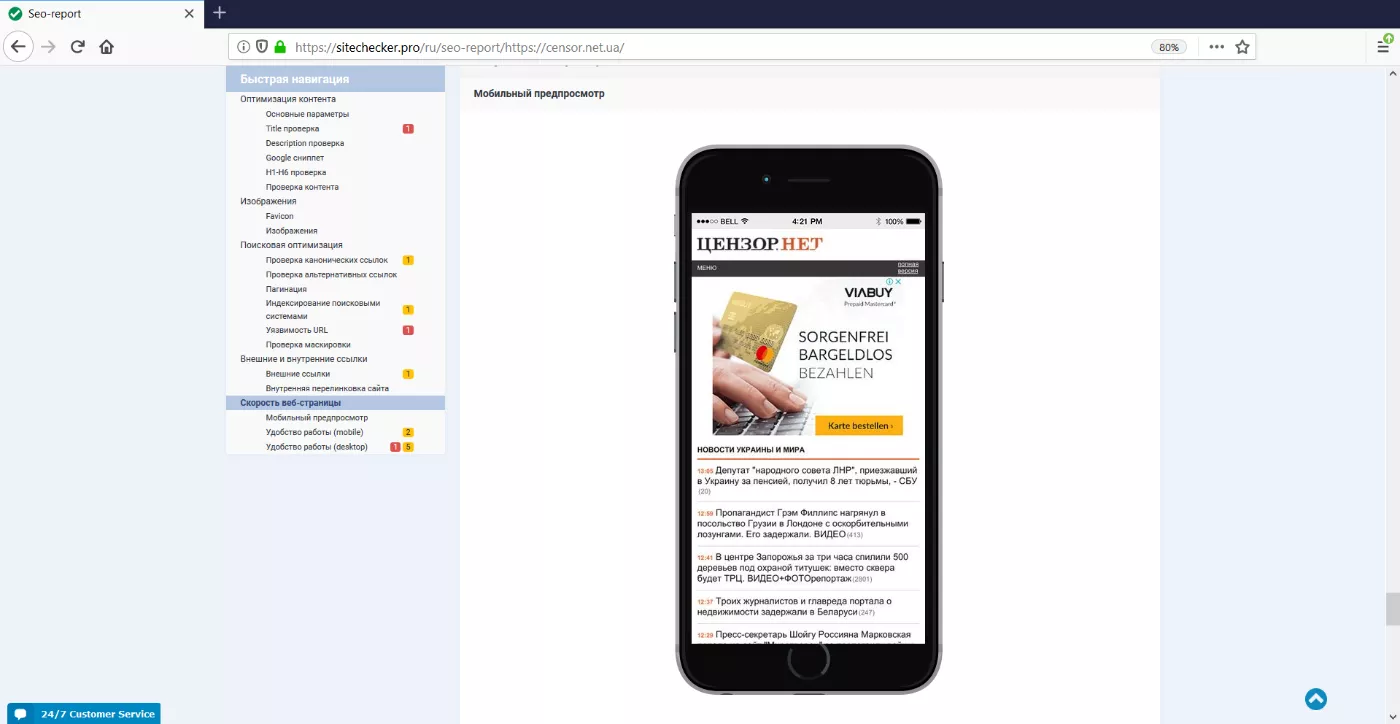

Sitechecker.pro дает предпросмотр страницы на мобильных устройствах:

Сервис не может провести проверку только выбранных параметров, а остальные игнорировать.

4. Screaming Frog SEO Spider

Цена: платно. Есть бесплатная версия, но здесь до 500 URL и часть настроек заблокирована.

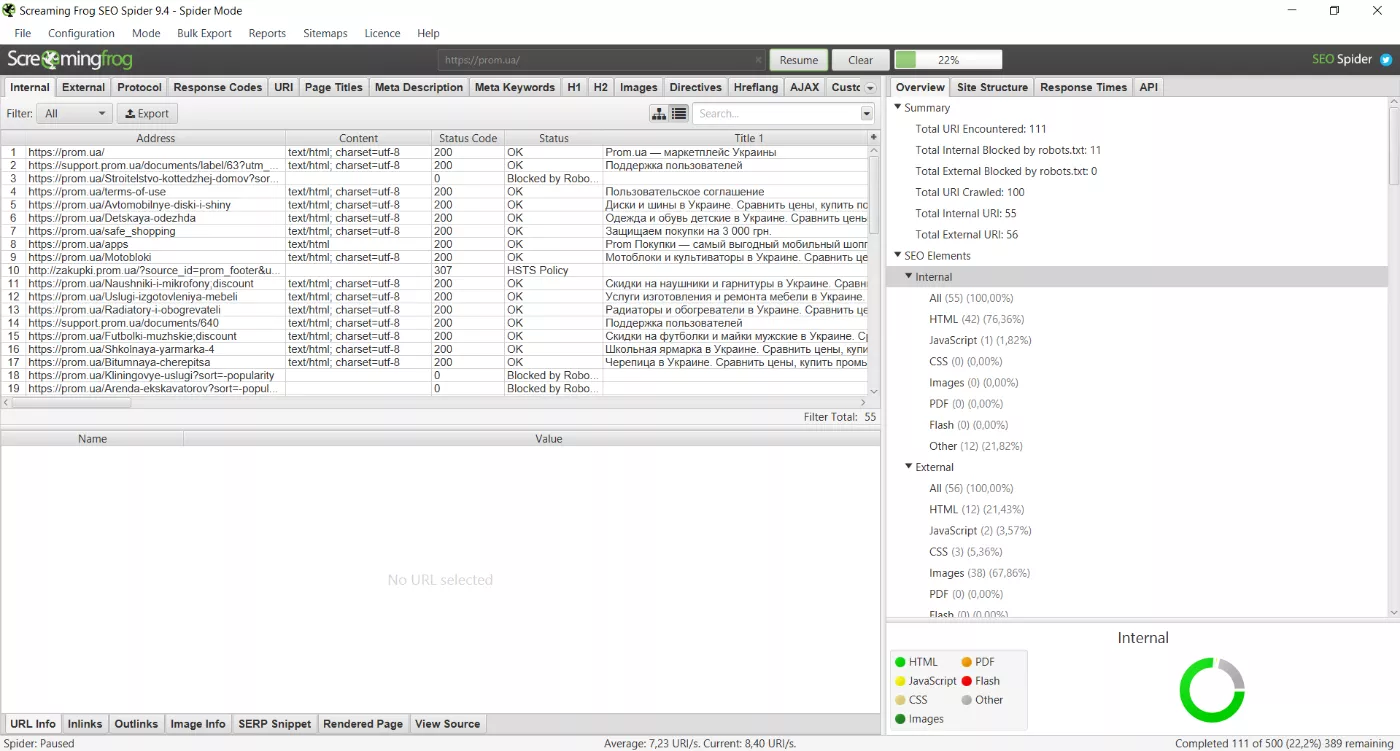

Screaming Frog SEO Spider сканирует все страницы сайта и сразу проверяет их на ошибки (в том числе и on-page):

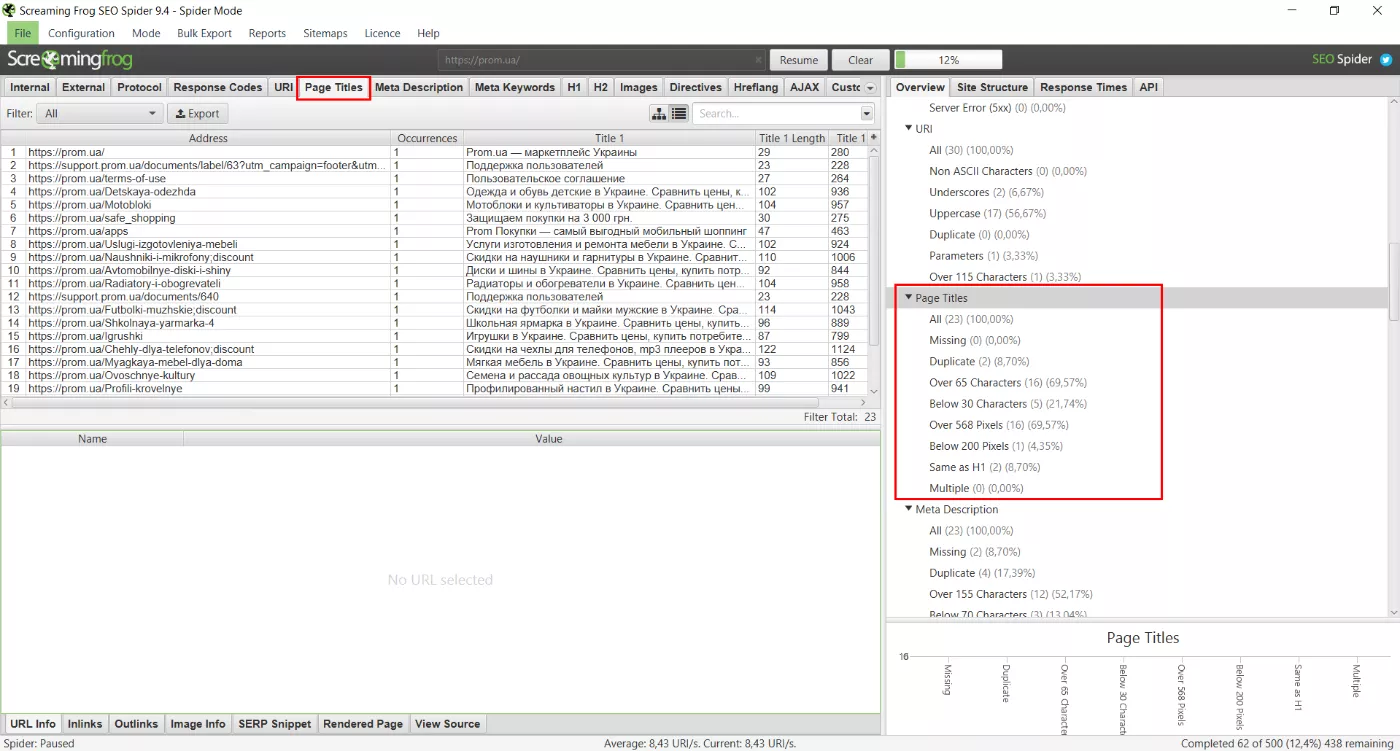

Например, проверить ошибки в теге title конкретной страницы можно на вкладке «Page Title». В разделе «Page Titles» вкладки «Overview» приведены общие данные по тегу title на отсканированных страницах:

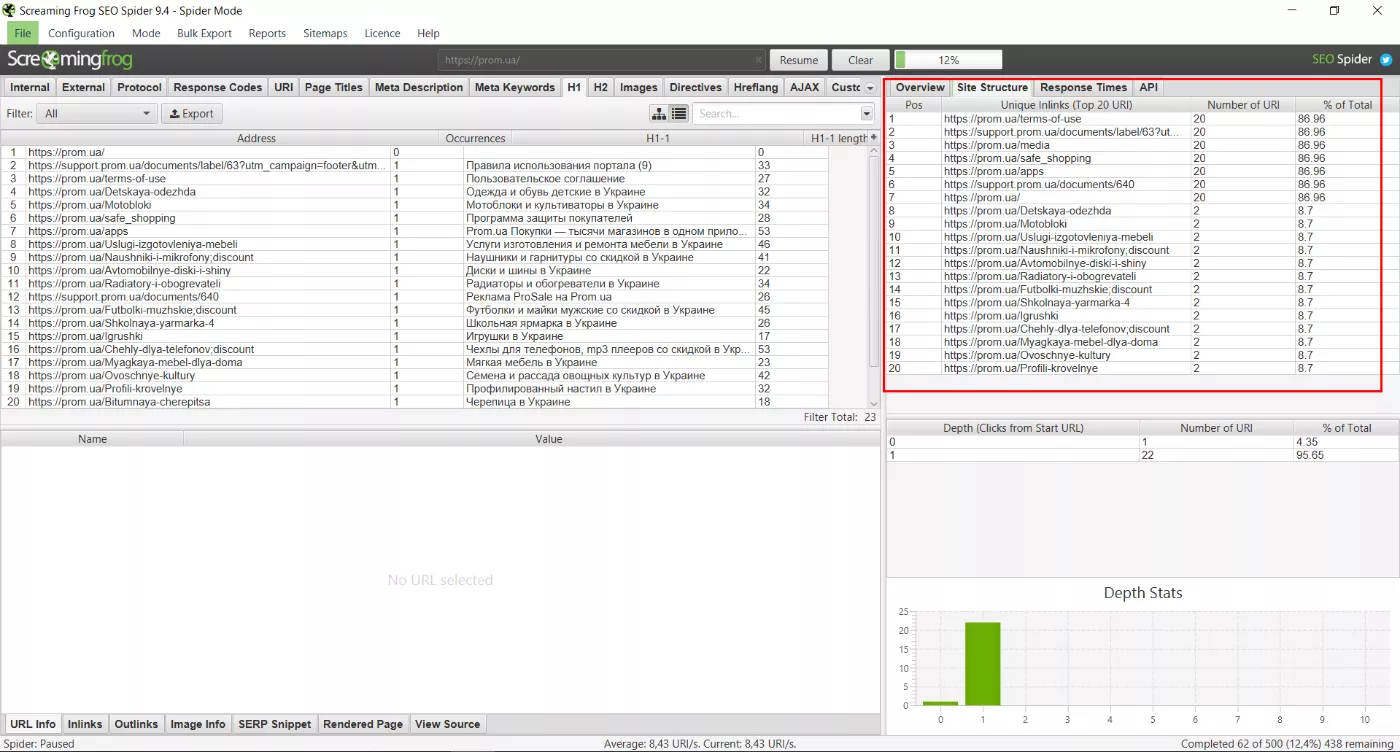

Чтобы найти закономерности в распределении ошибок по страницам можно воспользоваться вкладкой «Site Structure»:

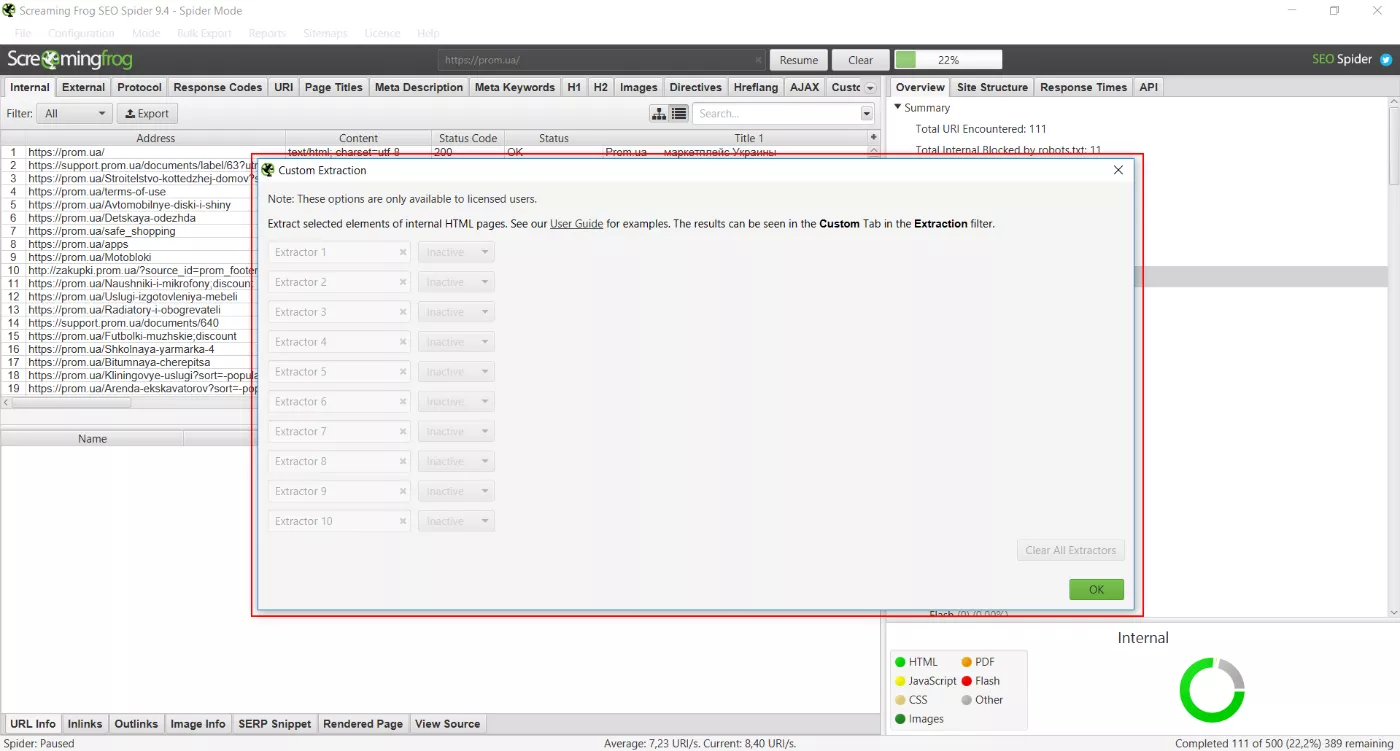

В случае необходимости, можно настроить пользовательский парсинг данных со страниц:

Программа позволяет сканировать сайты, созданные на JavaScript, но не дает возможности отключить проверку ненужных параметров.

5. Google Search Console

Цена: бесплатно.

Выявить ошибки на страницах сайта позволяет и вебмастерка от Google — Search Console.

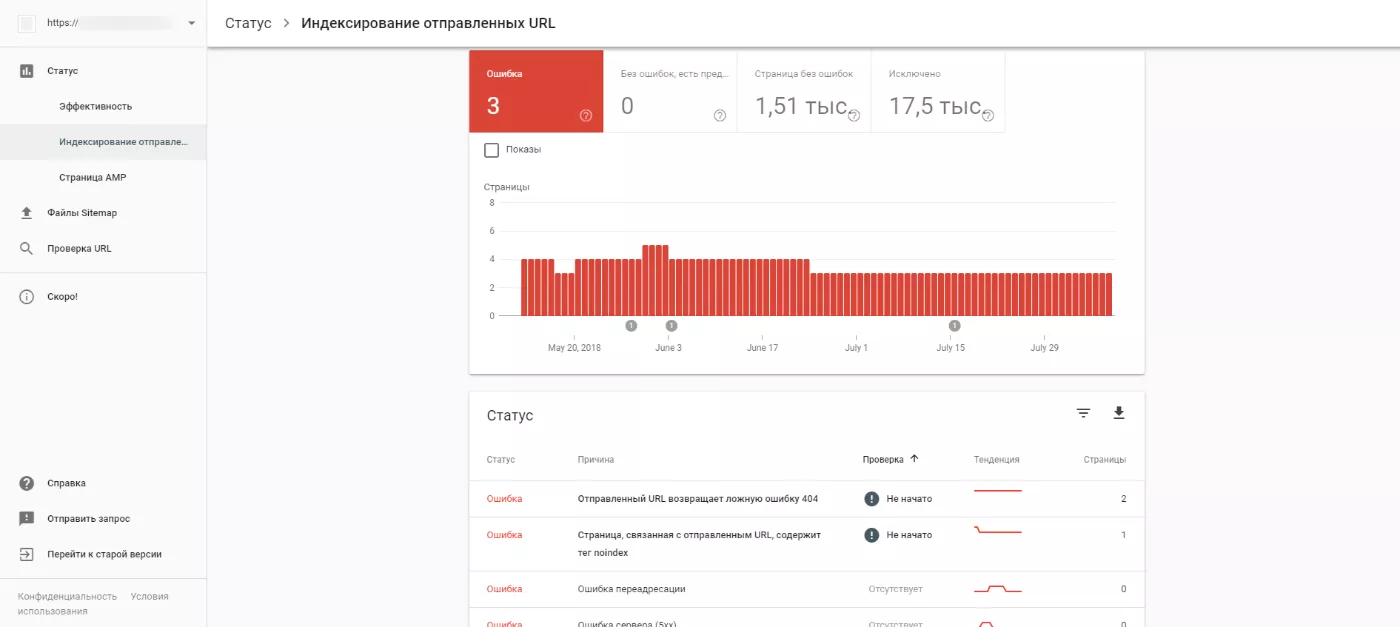

В новой версии Google Search Console появился наглядный отчет о том, почему список страниц не индексируется:

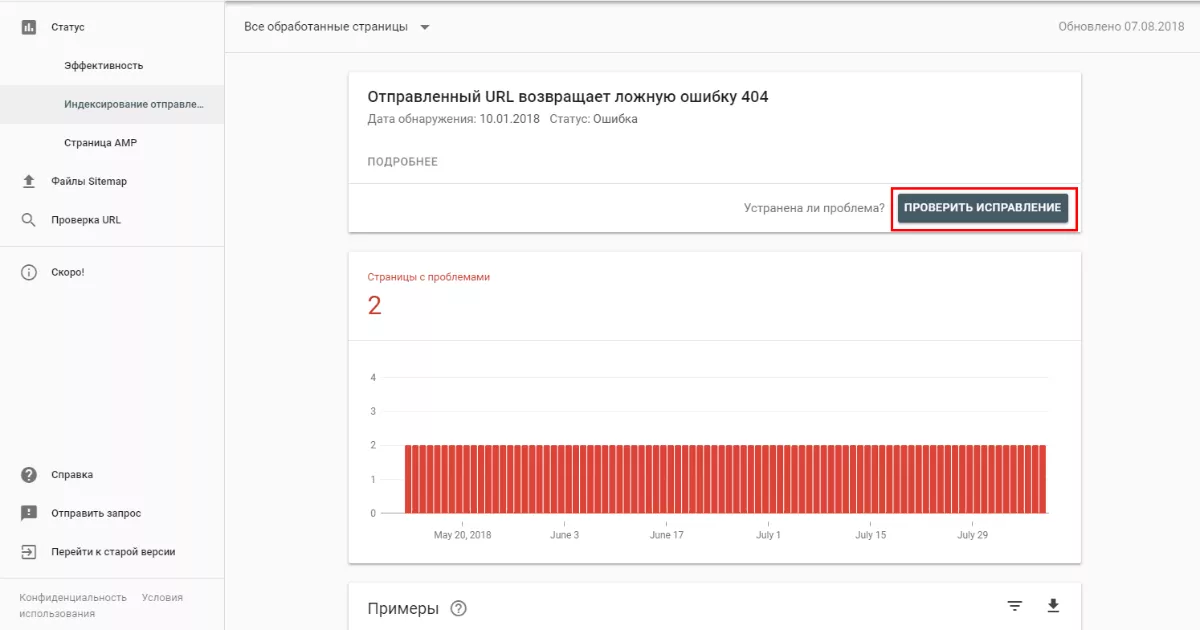

Отчет «Индексирование отправленных URL», объясняет, почему страницы не индексируются.

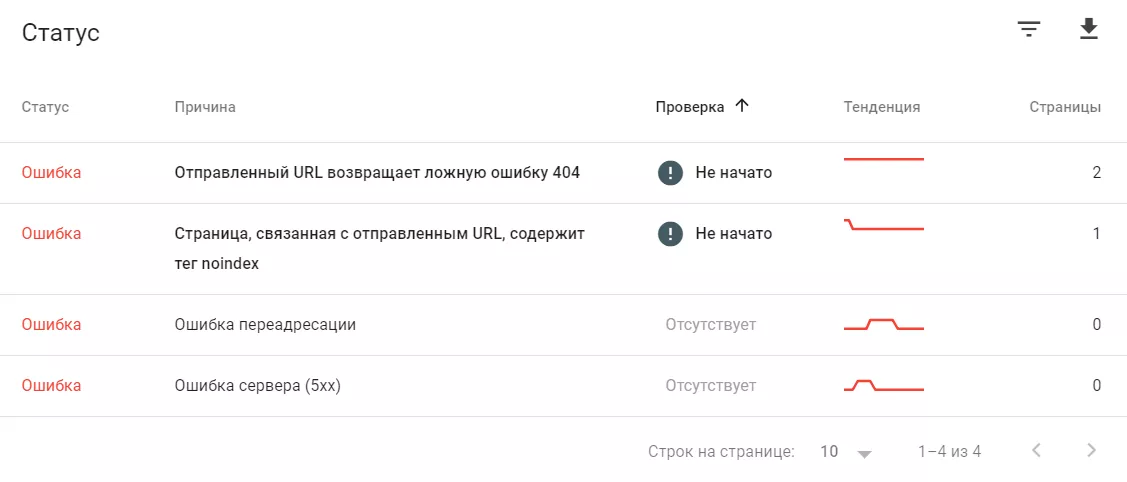

Например:

- «отправленный URL возвращает ложную ошибку 404»;

- «страница, связанная с отправленным URL, содержит тег noindex»;

- «ошибка переадресации»;

- «ошибка сервера (5xx)».

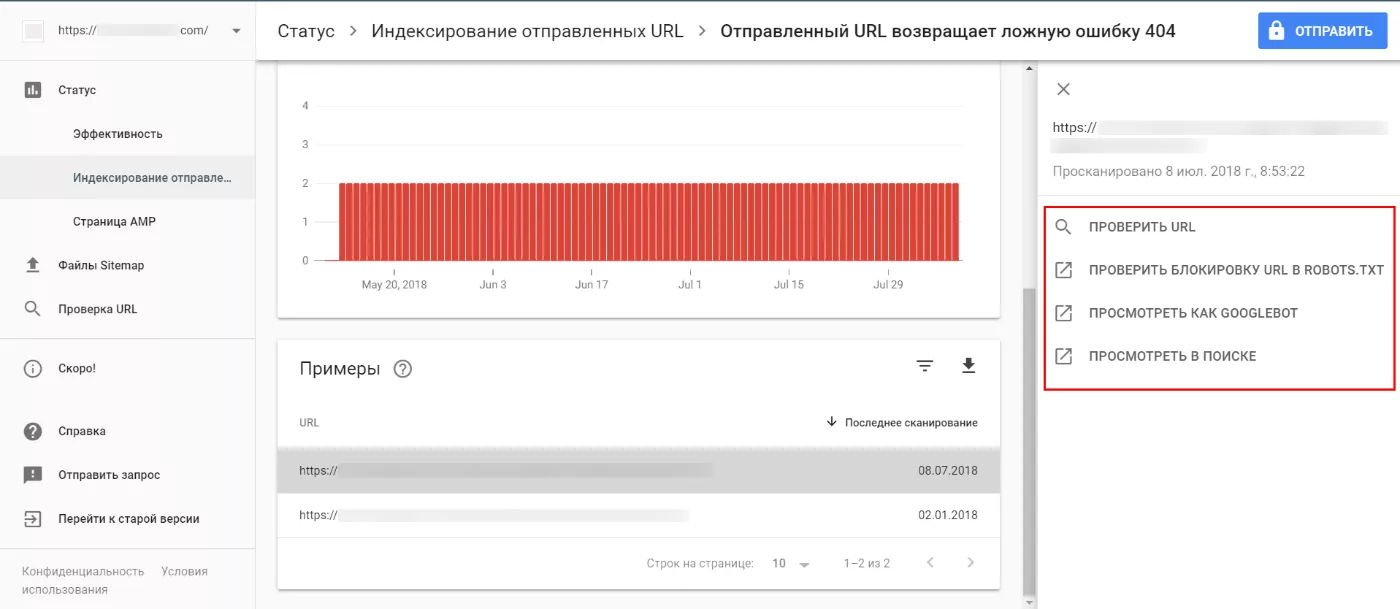

Нажимаем на «причину» и получаем список URL, которые из-за нее не проиндексированы:

В отчете по не индексированным страницам есть функции работы с отдельными URL:

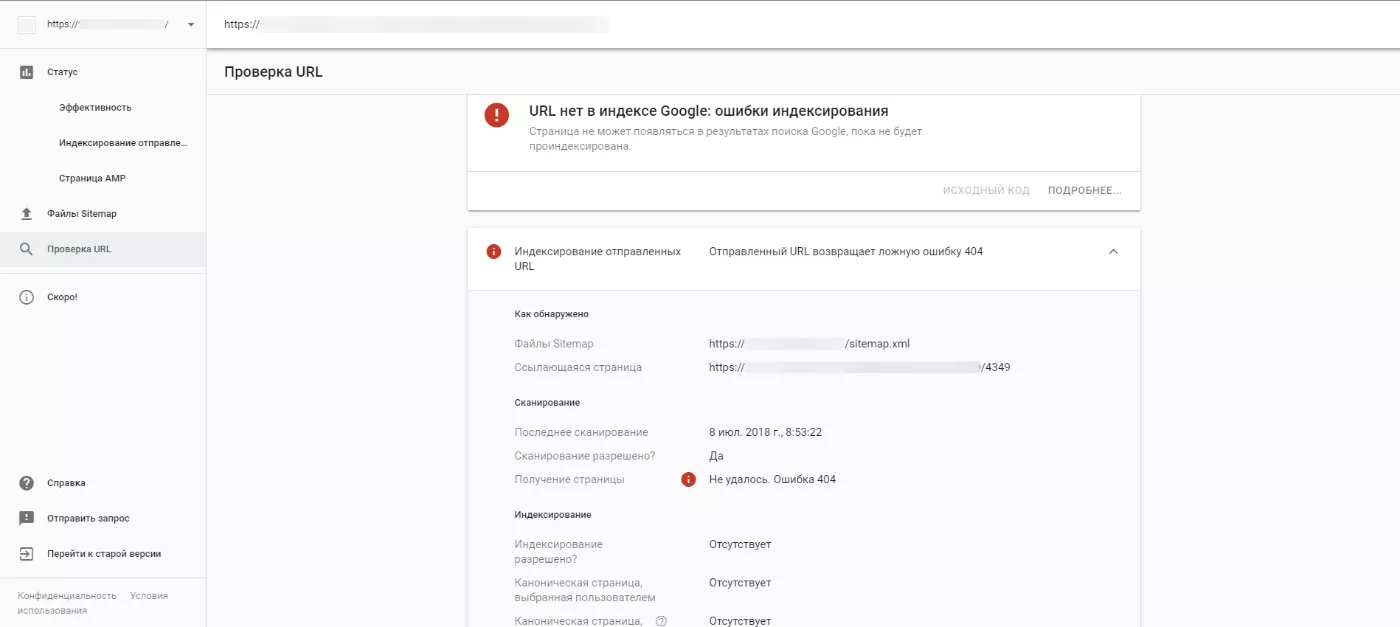

«Проверить URL» — показывает, существует ли запрошенная страница в индексе, откуда Google узнал о ней и дату последнего запроса поискового бота:

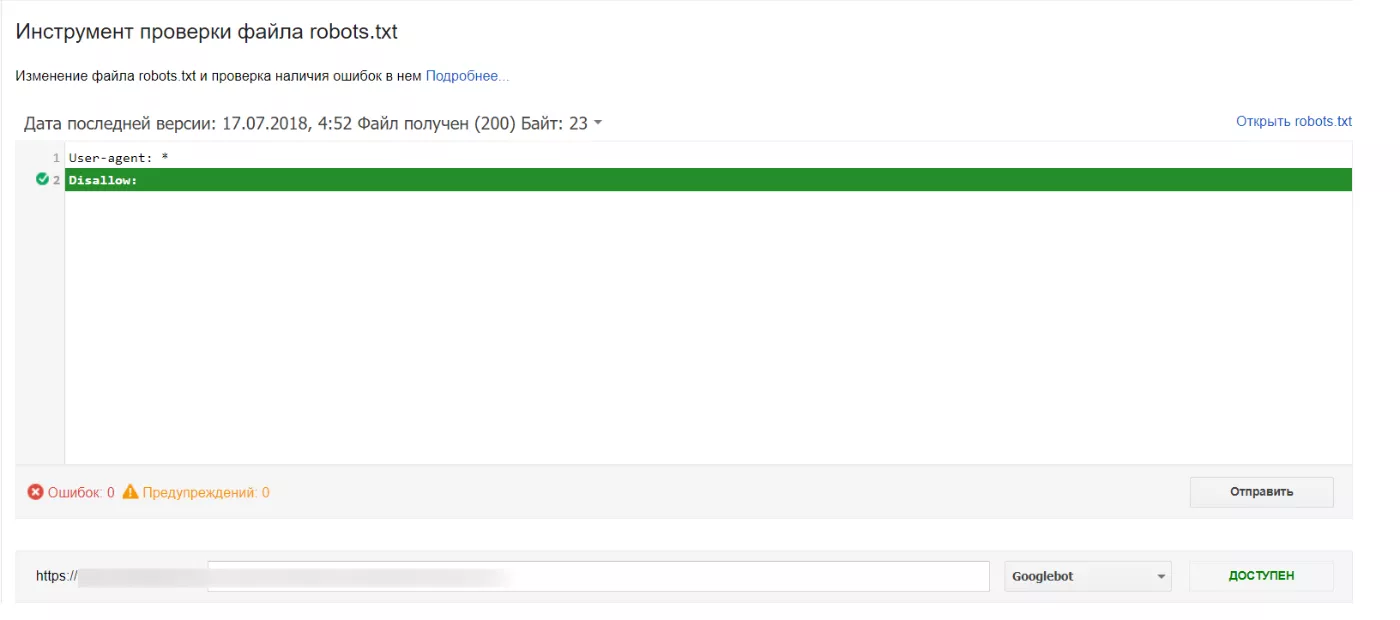

«Проверить блокировку URL в robots.txt» — показывает, заблокирован ли проверяемый URL в файле robots.txt сайта:

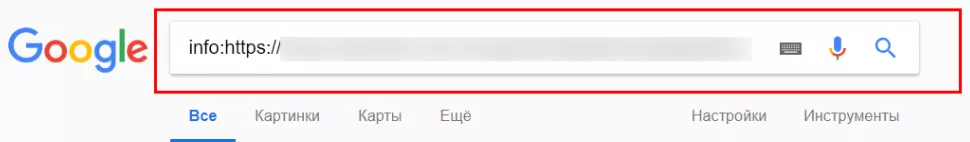

«Посмотреть в поиске» — перебрасывает на страницу поиска с оператором «info:», что позволяет посмотреть, как выглядит проверяемая страница в поисковой выдаче:

«Проверить исправление» — в случае устранения ошибок на страницах, можно отправить URL на переобход поисковым ботом:

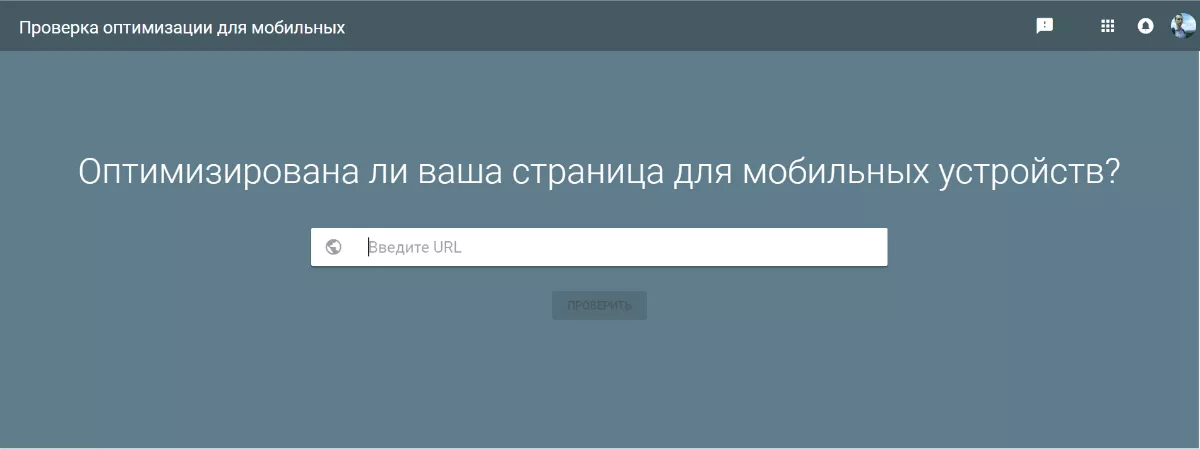

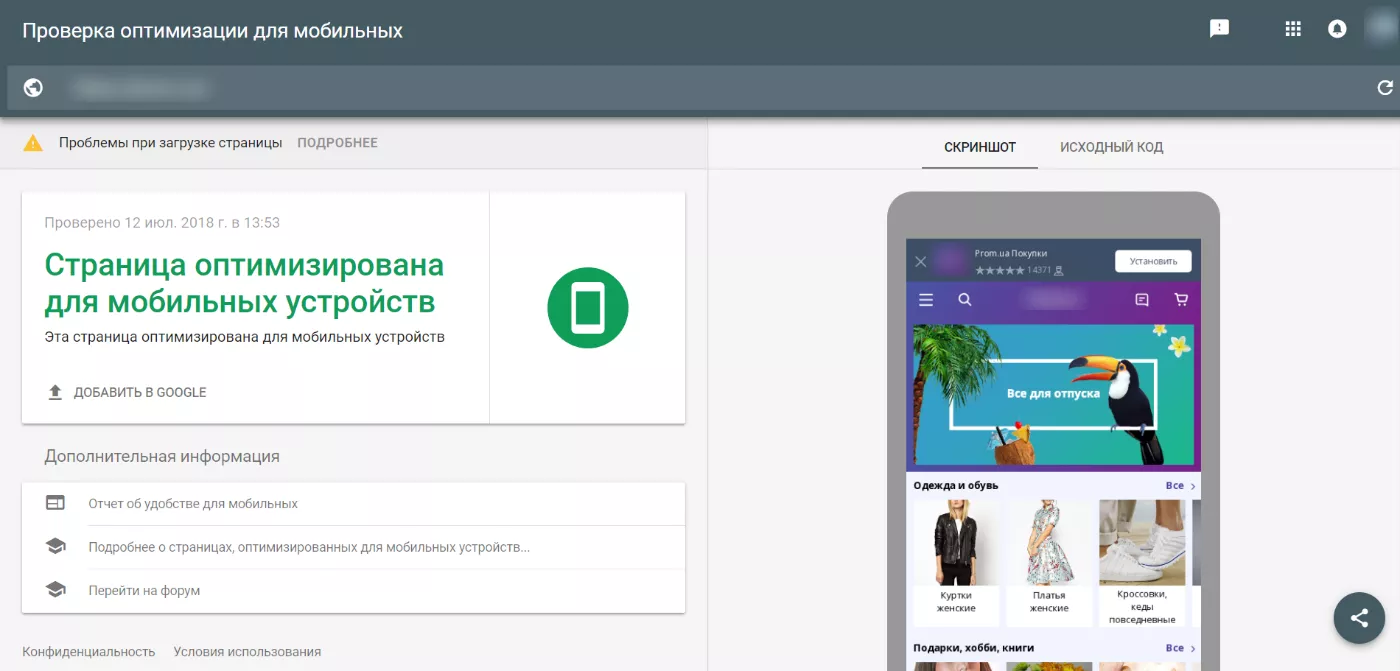

Плюс, как отдельный инструмент, существует «Проверка оптимизации для мобильных»:

Так выглядит отчет по оптимизации страницы для мобильных устройств:

6. Google Tag Manager

Цена: бесплатно.

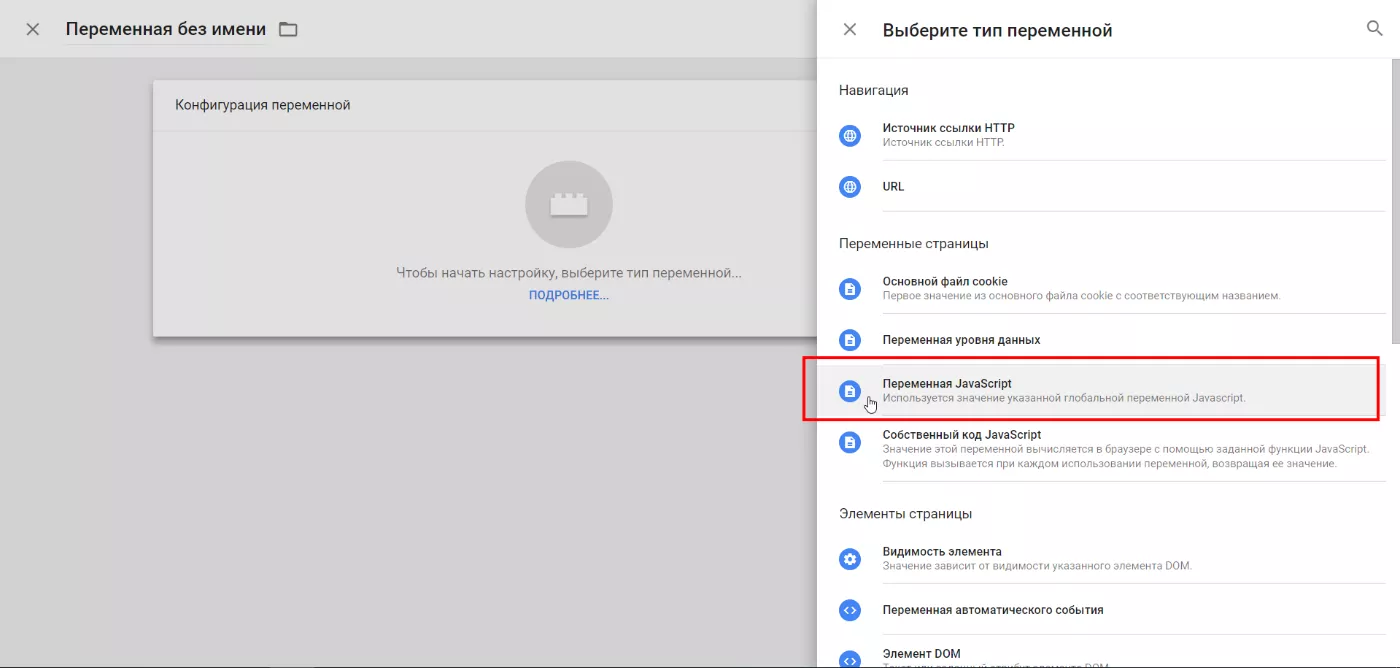

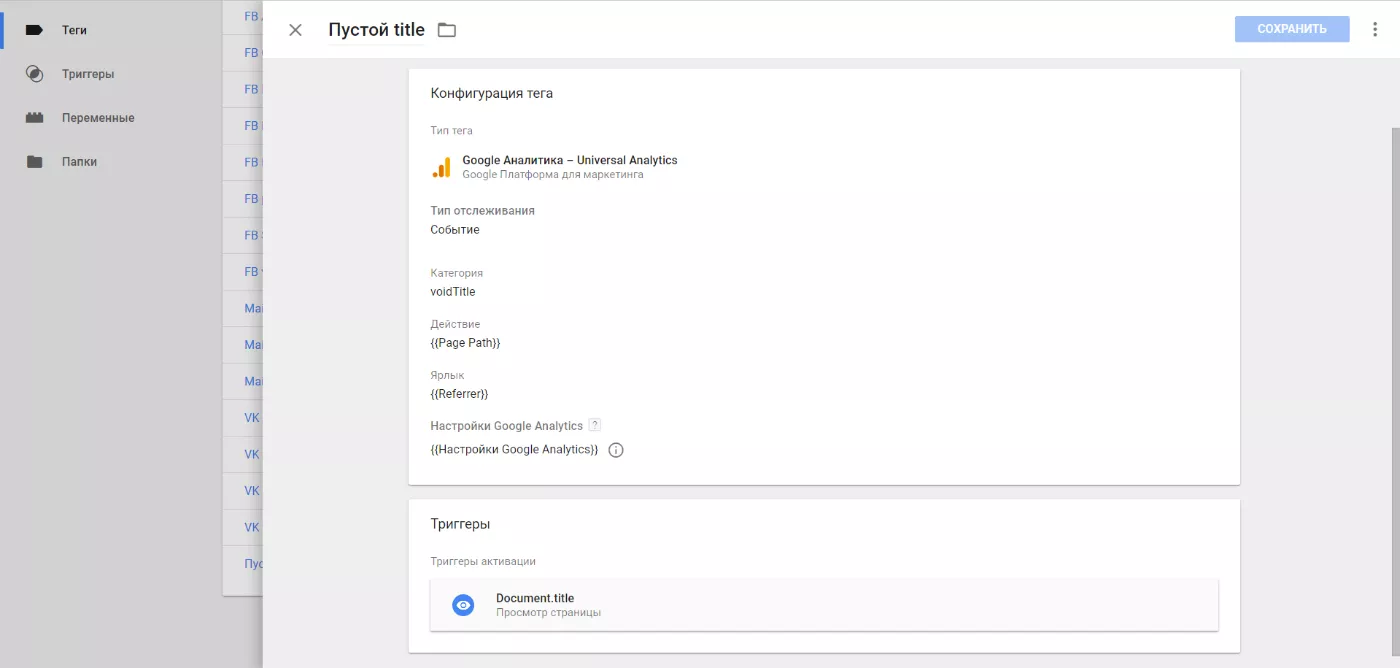

Например, отследим ошибки с метаданными. Будем искать страницы, которые содержат пустой тег title.

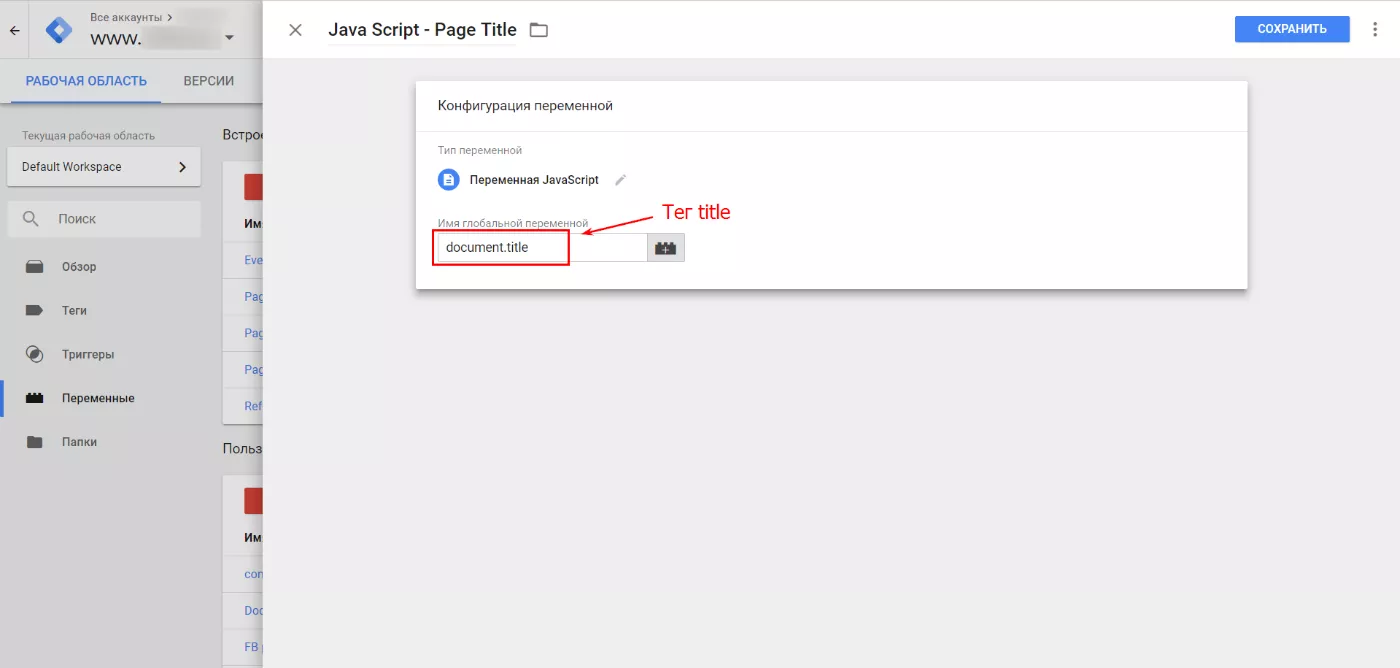

Создаем переменную JavaScript:

Получаем в переменной — значение title страницы:

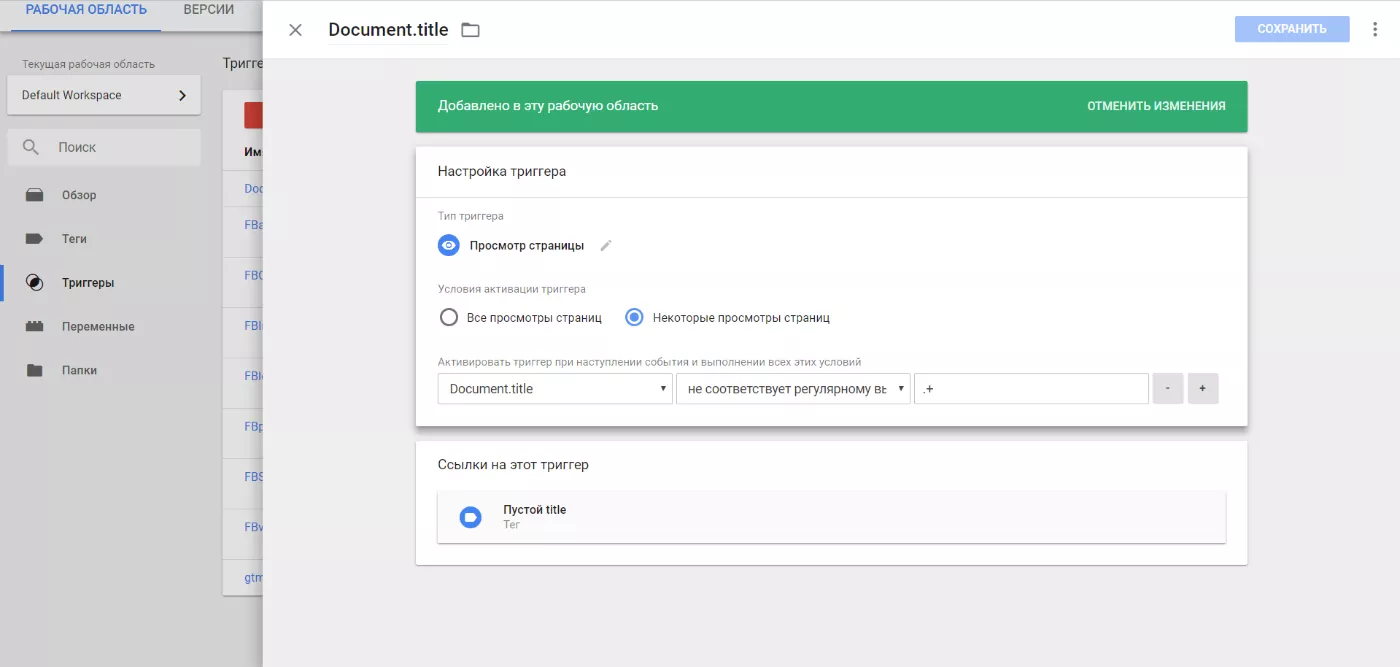

Настраиваем триггер (если значение переменной document.title не равно любому количеству любых символов, то элемент <title> пуст)

Чтобы получить URL проблемной страницы и узнать, как на нее попали, используем стандартные переменные «Page Path» и «Referrer».

Настраиваем тег (передаем в действие — Page Path, а в ярлык — Referrer)

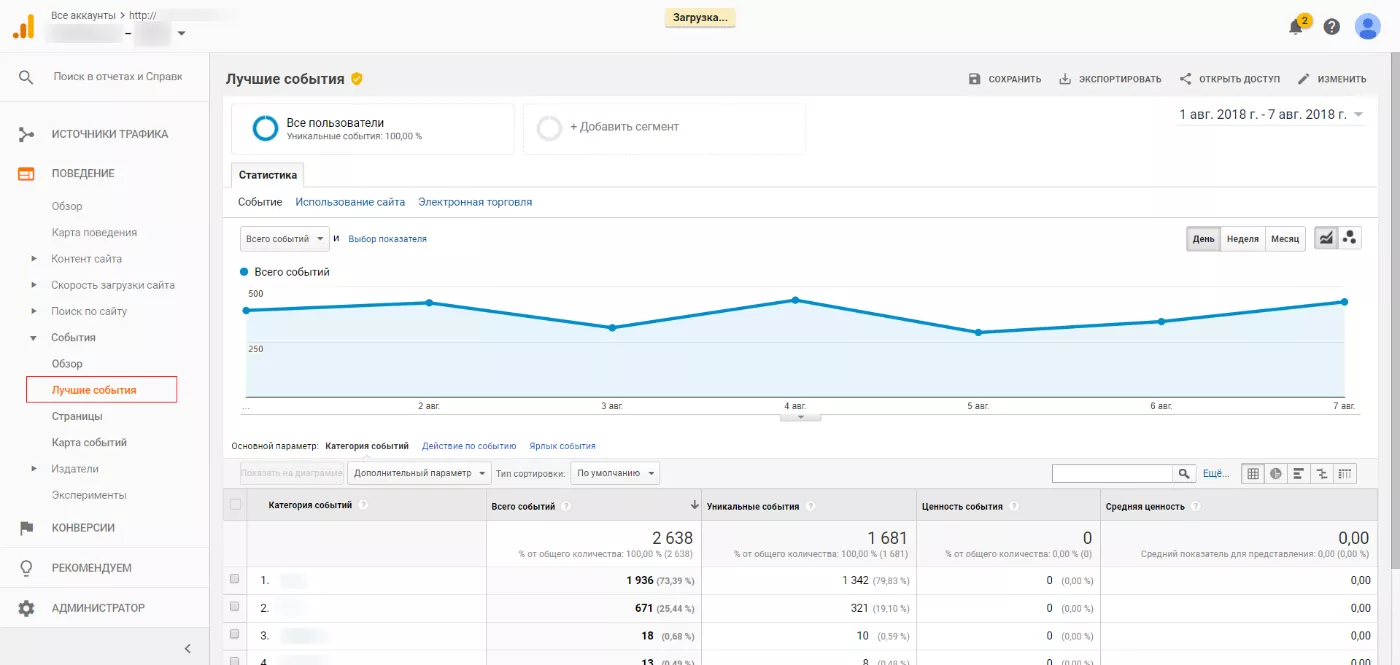

Далее передаем полученные с помощью Google Tag Manager данные в Google Analytics, где, по желанию, настраиваем цель с подходящим названием.

Без настройки отдельной цели в Google Analytics посмотреть событие можно здесь:

С помощью GTM можно отслеживать и другие on-page ошибки. Например, вот переменная для отслеживания мета-тега description:

document.head.children.description.content

7. Google Таблицы

Цена: бесплатно.

Если необходимо что-то проверить, а времени/желания искать подходящий сервис нет (или настраивать Google Tag Manager, который потом требует времени для сбора данных), тогда можно воспользоваться классическим инструментом интернет-маркетологов — таблицами.

Проверять страницы на on-page ошибки можно с помощью Microsoft Excel и Google Таблиц.

Разберем реализацию в Google Таблицах: допустим, нужно проверить наличие и длину title, канонический URL и количество h2.

Для этого пропишем несколько формул. Вот пример такого рода таблицы (сделайте копию, чтобы подставить свои URL).

Так, с помощью нескольких функций и XPath получилась бесплатная самодельная версия таблицы для проверки страниц.

Например, в формуле =ЕСЛИ(A2<>"";ЕСЛИОШИБКА(IMPORTXML(A2;"//link[@rel='canonical']/@href");"ПУСТО");"")

использовано три функции: ЕСЛИ, ЕСЛИОШИБКА и IMPORTXML + один XPath.

Выводы

On-page ошибки — это широкий спектр недочетов оптимизации. К ним относятся проблемы с настройками индексации, метаданные, каноничность страницы, ошибочная или отсутствующая микроразметка и другие.

Охватить все их вручную, конечно же, можно, но это займет слишком много времени. В этом случае на помощь приходят средства автоматизации — сервисы, программы и даже простые таблицы. Каждый из них уместно применять, исходя из целей, доступных средств и времени.

В редких случаях, когда требуется лишь точечная проверка некоторых недочетов на нескольких страницах, можно провести это вручную, но часто проблема on-page ошибок масштабнее уровня одной страницы и без средств автоматизации не обойтись.

Свежее

Продвижение криптокошелька в Google Ads: как получить сертификацию в 12 странах и привлечь 300 000 пользователей

Возвращение рекламы после блокировки и масштабирования без потерь трафика

Как собрать 4900 контактов и получить 174 лида в сфере производства — кейс B2B Lead Generation для KZS Glass

Масштабирование B2B-коммуникации на европейских рынках

Как продвигать Fin-Tech приложения. Полное руководство для бизнеса

В статье рассмотрю ключевые подходы к продвижению FinTech-приложени в App Store и Google Play