Big Data SEO — как заставить большие данные работать на ваш бизнес

Big Data в сфере маркетинга означает работу

Big Data SEO: кому и зачем

С каждым годом появляется больше грамотных пользователей, которые умеют четко сформулировать свой запрос в поиске, по одному только названию сайта и сниппету определить, можно ли доверять ресурсу. Также чрезвычайно много людей, которые готовы долго искать, продумывать и формулировать длинные запросы, чтобы найти именно то, чего хочется.

Большим проектам (от 300 000 страниц) есть что предложить этим пользователям, но далеко не всегда нужные категории и товары оказываются на первых страницах выдачи даже по тому товару или услуге, которые интересуют покупателя и есть в наличии магазина. И это при том, что SEO-работы на сайте проводят систематически и штатные специалисты регулярно оптимизируют всё на свете.

А сколько всего спрятано в подкатегориях...

В какой-то момент проект перестает быстро расти. Маркетинговые активности, реклама дают какие-то скачки на праздники и другие традиционные сезонные пики, но в целом нет ощущения, что проект развивается. Собственники бизнеса, маркетинг-команды начинают переживать, что SEO не работает.

Средний рост проекта в год — +20-30% трафика на сайт. У больших проектов такой показатель снижается, и меньше 10% в год считается вполне себе нормой.

Елена Воскобойник, глава департамента SEO в Netpeak

Можно точечно оптимизировать каждую страницу и категорию: подбирать релевантные ключевые слова, включать их в описание, контент, организовывать с ними перелинковку, наращивать ссылки, строить планы проработки всех разделов сайта и двигаться постепенно, наблюдая результат своей работы. Но такой подход для объемных проектов с сотнями тысяч страниц энерго и трудозатратен, а результат растянут во времени.

Можно добиться значительного прироста трафика, увеличить число продаж с помощью масштабирования классического SEO. Та же работа с поисковыми запросами, только большая, очень большая работа — выгрузка нескольких миллионов запросов по тематике и нише, их сортировка и массовая оптимизация страниц на основании готовых шаблонов.

Big data SEO — альтернативный способ решения проблемы. За основу мы берем один из важнейших параметров внутренней оптимизации —

Почему перелинковка?

Существует множество способов улучшить ранжирование страниц в выдаче и непрокаченные проекты могут использовать их по полной. Но когда уже все или почти всё сделано, нужно искать новые точки роста. Подход Netpeak строится на работе с семантикой, которая всегда бесконечна

Наши продукты заточены под такие задачи — инструменты и сервисы, которые помогают извлечь огромные объемы данных, упорядочить их, очистить от шлака и структурировать для постановки технических заданий на SEO-специалистов, разработчиков и аналитиков в штате заказчика. Речь о Serpstat, Netpeak Spider, Netpeak Checker.

Напомним, в чем суть перелинковки:

- Передача веса между страницами. Если на страницу ссылается много других страниц внутри сайта, это указывает поисковикам: страница действительно весома. Так, главная всегда самая «тяжелая», потому что на неё ссылаются все остальные страницы сайта. Та же история со страницами категорий в интернет-магазине. Они сквозные: на каждой странице есть ссылка на категорию. Из-за этого роботы считают страницы категорий весомыми.

Таким образом формируется иерархия важности страниц сайта в глазах робота. Перелинковкой мы придаем так называемый статический вес страницам, который важен с точки зрения продвижения. Мы размещаем ссылки перелинковки на страницы, которые потенциально может искать пользователь — услуг, товаров и так далее.

- Передача анкорного веса (задаем тематику странице). Ссылка всегда привязана к анкорному тексту. Анкорный текст это, по сути, запрос, например «стиральная машина». Увеличивая анкорный вес, мы передаем поисковым роботам понимание, о чем она.

Анкорный текст может быть разный «стиральная машина», «стиральная машина купить», «стиральная машина киев». Чем лучше робот понимает, о чем страница, тем она релевантнее.

- Удобство для пользователя. Человеку предлагают товары, страницы, которые могут его заинтересовать. Это и про навигацию и про помощь в выборе — предложение максимально близкое к тому, что ищет человек.

Почему перелинковка важна для больших проектов? Структура таких сайтов настолько широкая, что пользователи и боты могут не доходить до страниц с большой вложенностью.

Выносить тысячи ссылок на эти страницы в меню для придания им веса— идея тоже не очень. Приходится искать другие варианты и делать перелинковку внутри сайта.

Почему низкочастотные запросы?

Зачем для продвижения использовать

Например, заходим на сайт магазина одежды. Здесь нет категории «сиреневое платье в клеточку», но на сайте оно может быть. Но на главной только основные категории, необходимые для выбора. А ведь запросов по платьям десятки тысяч: фасоны, цвета, модели, имя селебрити, которая надевала похожее на красную дорожку.

У пользователя есть определенный образ, по нему формируется запрос и он ожидает увидеть соответствующее его ожиданиям предложение. Задача оптимизатора — предоставить страницу релевантную запросу.

На продвижении с помощью низкочастотных запросов строится стратегия успешных

Этапы Big Data Seo

Вне зависимости от объема, тематики сайта, работа над проектом разбивается на шесть этапов (итераций):

Под каждый проект подбираем источники данных, метод и принцип, алгоритм, по которому мы будем их обрабатывать. На старте готовим техническое задание, в котором детально описываем этапы и промежуточные шаги каждой итерации.

Работаем с семантикой (пулом поисковых запросов)

Выгрузка всей семантики ниши, начиная с нашего сайта и сайтов конкурентов (прямых и косвенных) в каждой категории.

Откуда берем данные:

- Google Search Console;

- Serpstat;

- Google Ads;

- Google Analytics и другие.

Эти данные собираются как для текущего сайта, так и с сайтов конкурентов. То есть мы получаем всю семантику ниши. Затем информация автоматически очищается от мусора.

Следующий шаг — расширение списка запросов с помощью скрипта генерации семантики. Для каждого ранее выгруженного запроса автоматически подбираются похожие фразы, подсказки. Объем снова увеличивается и мы проводим повторную чистку.

При повторной чистке фильтруются, например, запросы в нерелевантной для языка системе письменности (для кириллицы — латиница и наоборот, иероглифы). Также определяем нерелевантную длину запроса. Количество слов в фразе выбирается исходя из объема данных и личной оценки фраз Data Scientist.

Какие инструменты использует отдел Data Science — собственные скрипты на языке R и Python, Serpstat, Netpeak Spider. Только с помощью этих сервисов можно собрать, выгрузить сотни тысяч или миллионы запросов, отсеять нерелевантные.

Собираем топ по всем запросам

По каждому поисковому запросу, собранному на предыдущем этапе, выгружаем топ-100 выдачи для того, чтобы определить тип страницы, который чаще всего встречается среди конкурентов. Результат — миллионы строк данных.

В дальнейшем эта информация понадобится нам для автоматического сопоставления страниц сайта и поисковых запросов.

Формируем скоринговую модель

Цель — из всего собранного пула отобрать запросы, которые нам выгодно использовать для перелинковки. Делаем это с помощью скоринговой модели.

Скоринг — это «оценка». Скоринговая модель — алгоритм оценки.

В нашем случае он заключается в определении эффективных запросов, которые потенциально могут принести трафик с наименьшими затратами.

С помощью нейронной сети формируем скоринговую модель. Модель помогает оценить каждый поисковый запрос с точки зрения конкурентности, релевантности, потенциала трафика. Каждому запросу присваивается балл. Балл показывает эффективность ключевого запроса.

После оценки отбираем пул запросов, которые принесут максимальную выгоду.

«На пальцах»: если нет рекламы в выдаче — фразе добавляем два балла, если есть слово «купить» — добавляем ещё три бала, присутствует слово «бесплатно» — минус шесть баллов. Если конкуренция по запросу почти отсутствует — плюс пять баллов. В итоге берем только те ключевики, которые собрали достаточное количество баллов.

Денис Стадник, SEO Tech Lead в Netpeak

Скоринг нужен, чтобы определить запросы, которые точно подойдут данному конкретному сайту.

На этом этапе используем собственный скрипт для определения показателя качества фразы. Скоринговая модель, а следовательно и скрипт корректируется под каждую конкретную тематику, учитывая ее особенности.

Проводим автоматическую кластеризацию подходящих запросов

Цель — сопоставить страницы сайта и ключевые запросы ниши, которые мы получили на основании двух предыдущих итераций.

Для кластеризации (группировки) поисковых запросов используем алгоритмы Machine learning, в основе которых лежат метод иерархической и k-means кластеризации и данные поисковой выдачи (топа).

Создаем связки для перелинковки

Цель: определить доноров — страницы сайта, с которых будем расставлять ссылки и связать их уже с созданными на предыдущем этапе связками «URL+кластер».

Проводим оценку «веса» и «тематичности» каждой страницы сайта для максимального эффекта.

Мы принимаем решение, какие именно страницы-доноры будут ссылаться на страницы-реципиенты. Важно, чтобы на страницу с ноутбуками ссылалась страница с телефонами, а не подгузниками (параметр «тематичность»). Дальше смотрим — если по этому запросу большая конкуренция, значит донору нужны ссылки с 20 страниц сайта. По другому такой конкуренции нет — достаточно и одной ссылки.

Денис Стадник, SEO Tech Lead в Netpeak

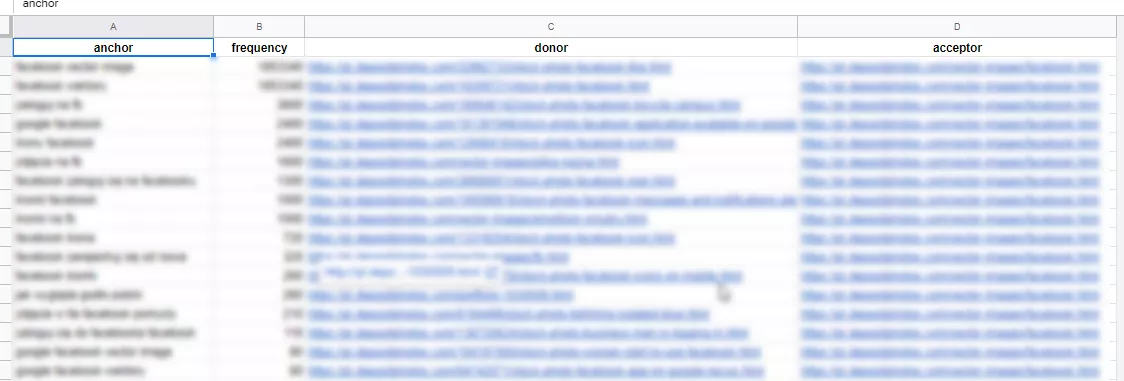

В результате получаем базы данных со списком анкоров, доноров и реципиентов. Пример:

На этом этапе мы используем, в частности, собственные скрипты для кластеризации и привязки кластеров к текущей структуре сайта, Serpstat.

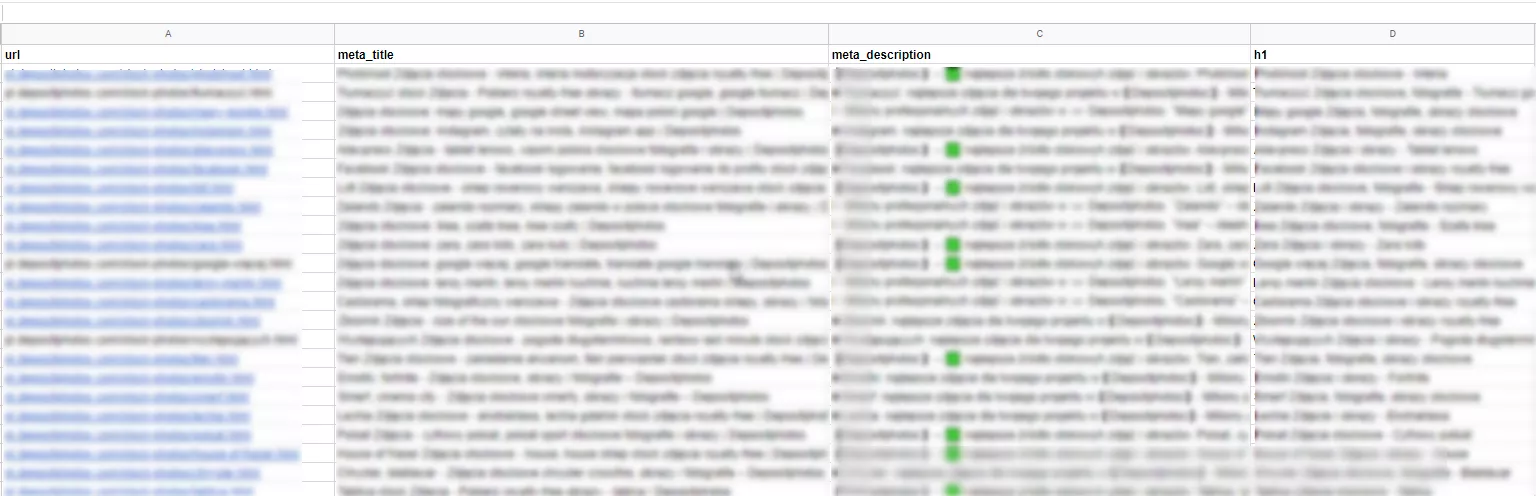

Формируем шаблоны title, h1, description

На финальной стадии работ наши специалисты генерируют новое

Далее мы сопровождаем внедрение перелинковки, шаблонов новых описаний и отслеживаем результат, консультируем специалистов заказчиков на протяжении всего процесса оптимизации.

Как правило, такая работа показывает результаты в сжатые сроки — и не только за счет опытных специалистов в штате команд крупных проектов. Дело в том, что большие сайты (с историей и регулярными работами по SEO) для поисковых систем — трастовые ресурсы и это помогает ускорить продвижение оптимизированных страниц.

Запомнить

Существует огромное количество данных о пользователях, их предпочтениях, поведении на сайтах, о том, как и что ищут люди (в поисковых запросах). Все эти данные — и есть Big Data.

Использование Big Data для поискового продвижения называется Big Data SEO. Подход Netpeak заключается в том, чтобы масштабировать

Упор делаем на перелинковку и низкочастотные запросы.

Перелинковка помогает передавать вес между страницами, анкорный вес, улучшает навигацию по сайту. В итоге, поисковикам станет понятнее ресурс, отдельные его страницы, вырастет их вес, а значит ценность по мнению роботов. Такой сайт будет удобен для пользователя — а здесь и лояльность, и низкий показатель отказов.

Использование низкочастотных запросов помогает увеличить конверсию, а ещё такие запросы, как правило, низкоконкурентные. Но нельзя так просто взять и массово найти, выгрузить, очистить от мусора нч запросы для больших проектов.

Этапы Big Data SEO:

- Сбор семантики, чтобы по максимуму расширить пул поисковых запросов. Мы делаем выгрузку всей семантики ниши: нашего сайта и сайтов конкурентов (прямых и косвенных) в каждой категории.

- По каждому поисковому запросу, собранному на предыдущем этапе, выгружаем топ-100 выдачи для того, чтобы определить тип страницы, который чаще всего встречается среди конкурентов. Результат — миллионы строк данных.

- Формирование скоринговой модели: здесь находим запросы, которые выгодно использовать для перелинковки.

- Кластеризация подходящих запросов — сопоставляем страницы сайта и ключевые запросы ниши.

- Создание связки для перелинковки (определяем релевантных доноров).

- Формирование шаблонов title, h1, description — делаем описания для страниц, участвующих в перелинковке.

Свежее

Что такое Server-Side Tagging и почему оно важно для вебаналитики

Узнайте, как server-side tagging повышает точность данных, улучшает контроль над конфиденциальностью и оптимизирует аналитику для бизнеса любого масштаба.

Что ждет бизнес и как адаптировать маркетинговые стратегии: AI-поиск 2026

Материал на основе митапа AI Search 2026. Рассматриваем изменения в AI-поиске и выдаче в целом.

Почему пользователи удаляют приложение и как этого избежать

Что именно заставляет пользователей забывать и удалять приложение? Разбираем и предотвращаем отток юзеров