Netpeak Spider — помощник при составлении технического аудита сайта

Мы решили поделиться еще одной программой, которая была написана нашим секретным подразделением программистов и ранее использовалась только внутри компании. Программа называется Netpeak Spider и она помогает составить технический аудит сайта.

А конкретнее:

- сканировать сайты с помощью собственного робота;

- искать ошибки на сайтах (битые ссылки, неправильные редиректы, дублирование Title, Keywords и Description);

- анализировать входящие и исходящие внутренние ссылки для каждой страницы;

- рассчитывать внутренний PageRank;

- экспортировать данные в Excel.

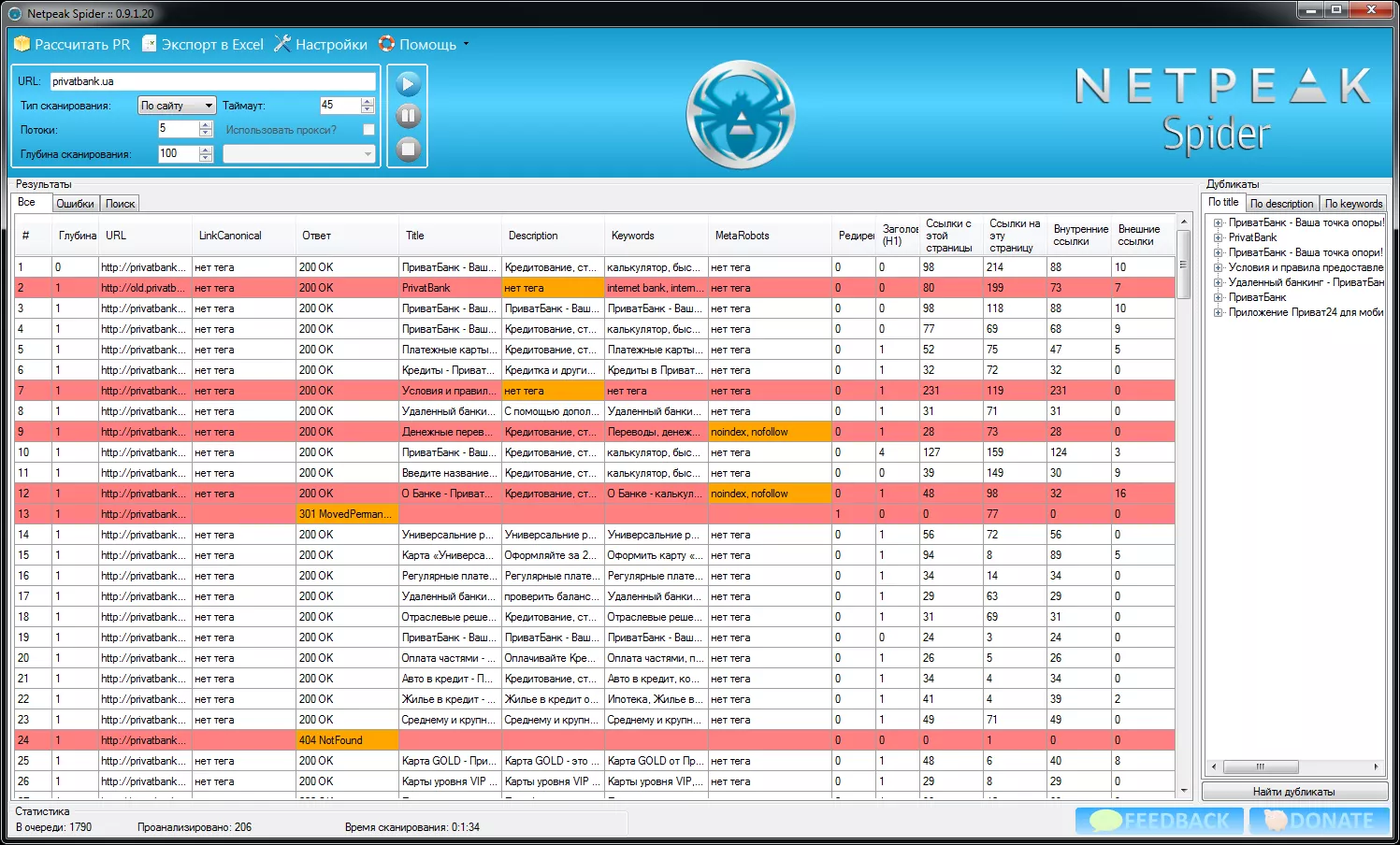

Внешний вид главного окна программы выглядит так:

В настройках можно гибко настраивать количество потоков парсера, т.к. можно ненароком «уронить» сайты на некоторых хостингах. Есть возможность просканировать только определенный раздел сайта. То есть, если какая-то категория на сайте подверглась изменениям, то можно проверить на ошибки только ее.

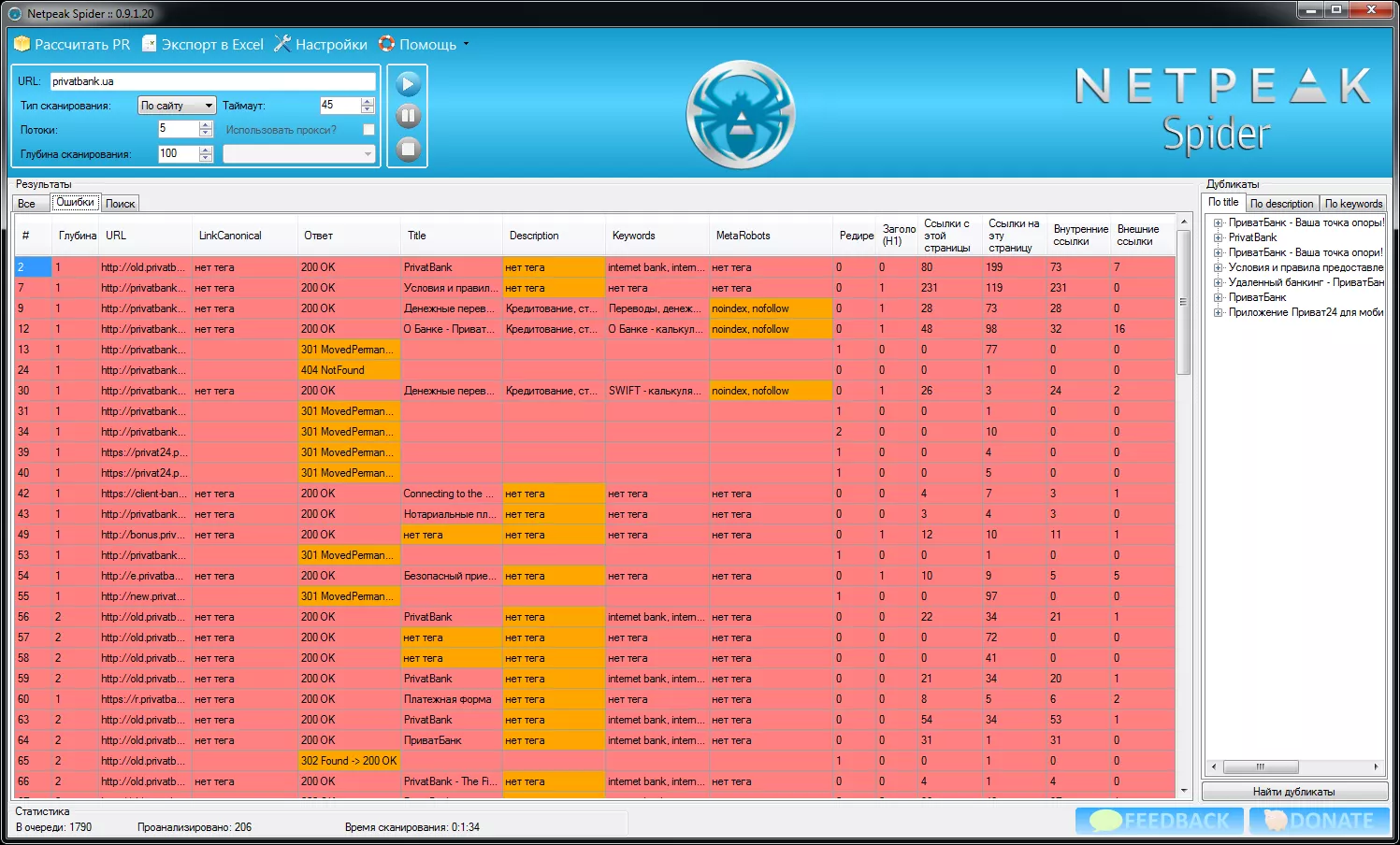

Ошибки, найденные на сайте, вынесены в отдельный список:

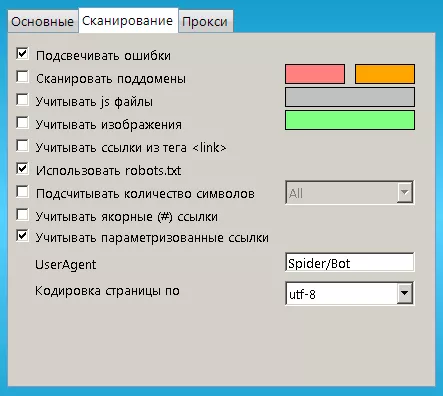

В настройках сканирования можно включать/отключать подсветку ошибок, сканирование поддоменов, использование robots.txt и т.д.:

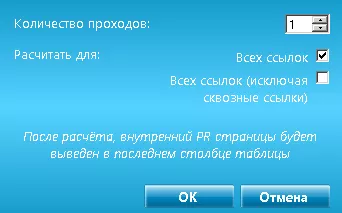

Интересная функция — расчет внутреннего PR с учетом и без учета сквозных внутренних ссылок на сайте:

Вряд ли найдется человек, который хочет, чтобы интернет был завален сайтами, у которых есть технические проблемы. Поэтому и отдаем данную программу вебмастерам, интернет-маркетологам и другим заинтересованным людям совершенно бесплатно. Надеемся, что Netpeak Spider станет полезным инструментом и в вашем арсенале. Вся подробная информация о возможностях и обновлениях программы находится на этой странице.

Вряд ли найдется человек, который хочет, чтобы интернет был завален сайтами, у которых есть технические проблемы. Поэтому и отдаем данную программу вебмастерам, интернет-маркетологам и другим заинтересованным людям совершенно бесплатно. Надеемся, что Netpeak Spider станет полезным инструментом и в вашем арсенале. Вся подробная информация о возможностях и обновлениях программы находится на этой странице.

Свежее

Маркетинг, который работает: как научить рекламные алгоритмы приносить больше прибыли

Рекламные кампании не дают желаемого результата? Узнайте о новейших инструментах веб-аналитики и превратите рекламный бюджет из расходов в инвестиции

Cloud Marketing и AI-аналитика: как бизнес оптимизирует рекламу благодаря данным

В статье рассмотрю, как внедрить AI, GA4 и Google Cloud в маркетинг, сократить время до инсайта и повысить ROMI. Покажу, как бизнес адаптируется к новым требованиям и повышает эффективность за счёт данных

Аудит оптимизации в App Store и Google Play: подробное руководство

Чтобы выделяться среди других, нужна качественная оптимизация. И именно здесь пригодится аудит оптимизации в App Store и Google Play