Как перейти на HTTPS и не остаться невидимкой в Google Analytics

Итак, вы уже перевели свой сайт на HTTPS. Или пока только собираетесь и хотите учесть все нюансы переезда на другой протокол. А может вообще не стоит этого делать, чтобы не навредить своему бизнесу? Давайте разбираться.

Преимущества HTTPS

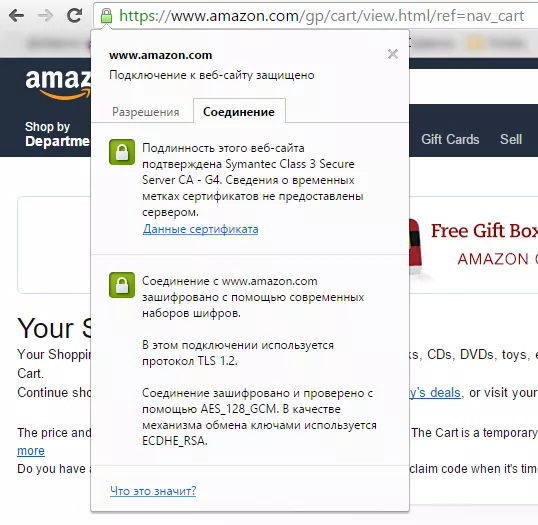

1. Ваш сайт будет более солидно выглядеть в глазах посетителей. Они смогут нажать на значок защищенного протокола в браузере и почитать/проверить данные о сертификате:

2. Вы сможете защититься от ряда атак прослушивания сетевого соединения и действительно предоставлять более высокий уровень сохранности данных. Для этого в HTTPS используется шифрование.

3. Поисковые системы будут любить вас чуточку больше, потому что вы следуете их рекомендациям.

4. Chrome, Firefox и Opera поддерживают HTTP/2 через HTTPS, а HTTP/2 — это скорость, скорость и еще раз скорость.

Недостатки HTTPS

1. Вам нужно учесть множество технических параметров, в которых без опыта работы с ними можно легко допустить ошибки.

2. Вы потеряете часть поискового трафика. Как и при смене домена, минимум на время переиндексации, трафик просядет. Если вы все правильно сделали, то он вернется. Но нужно быть к этому готовым и понимать финансовые риски.

3. Вы не получите ожидаемого роста всего в поисковых системах. Ваш сайт и с HTTPS, и без него может быть на столько плох, что этот параметр никак не будет влиять на его ранжирование на фоне более важных параметров.

4. HTTPS может замедлить ваш сайт. Нужны будут дополнительные доработки, чтобы избежать этого.

5. SSL-сертификат стоит денег. Или времени на то, чтобы найти бесплатный.

Потерянные рефералы в Google Analytics

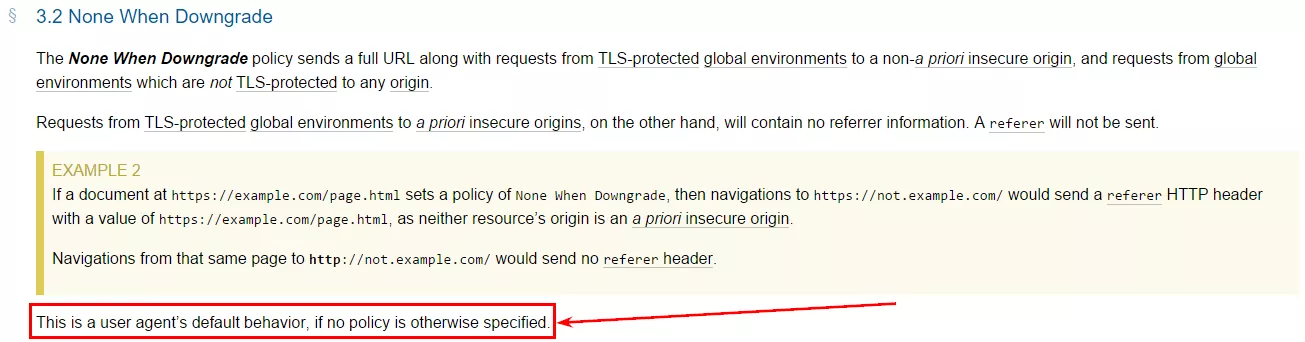

Все-таки вы решились перейти на HTTPS. Сделали все правильно, дождались переиндексации, вернули весь поисковый трафик. Неожиданно в два часа ночи вам пишет недовольный вебмастер с сайта-партнера и говорит, что вы пропали как реферал в его отчетах в Google Analytics. И это как раз совпадает по времени с переездом на HTTPS. Почему так случилось? Давайте заглянем сюда и прочитаем параграф 3.2:

Весь секрет в последнем предложении:

Существует определенное поведение user agent, которое используется по умолчанию.

Проще говоря, если пользователь осуществляет переход с сайта на HTTPS на сайт без HTTPS, то по умолчанию HTTP заголовок referer не передается, если не указано иное правило. Поведение вполне логичное, ведь вы покидаете защищенную зону и отправляетесь в зону риска. Это означает, что источник трафика Google Analytics определить не сможет и отнесет весь этот трафик к прямому.

Как перестать быть невидимкой?

Если вам не безразлично будущее сотрудничество с вашими партнерами, то есть способ решения этого вопроса. Этим способом пользуется Google на своих страницах.

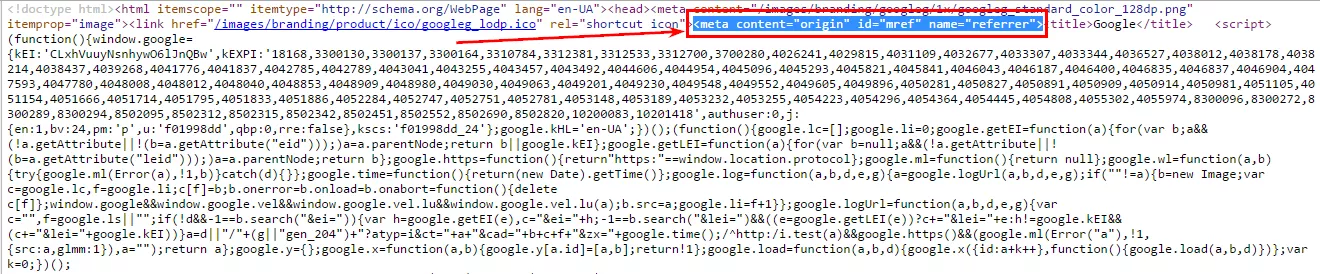

Заглянем в код главной поисковика:

Кроме прочего интересного, в коде страницы вы увидите строку:

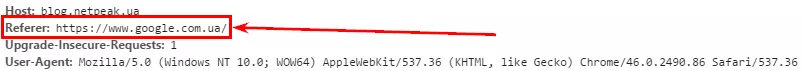

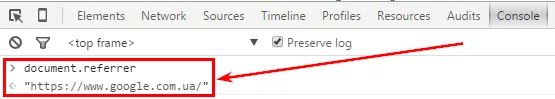

<meta content="origin" id="mref" name="referrer">Если из выдачи вы перейдете на сайт без HTTPS и посмотрите HTTP-заголовки, то увидите значение заголовка referer, которое отдает вам Google:

Это же вы можете проверить в JavaScript консоли браузера:

Чтобы перестать быть невидимкой, вам нужно на своем HTTPS-сайте добавить на страницах мета-тег:

<meta name="referrer" content="[директива]" />где [директива] — одна из тактик поведения из следующего списка:

- none — не передавать;

- origin — передавать протокол и домен;

- none-when-downgrade — не передавать при переходе с HTTPS-сайта на HTTP-сайт;

- unsafe-url — всегда передавать;

- другие варианты.

Выбрав нужное значение, вы можете позволить надоедливому вебмастеру видеть в отчетах интересующую его информацию. Вам может быть абсолютно безразлична экосистема, в которой вы существуете, тогда вы решите ничего не делать. Или просто добавите UTM-метки к ссылке на сайт вебмастера. Но если у вас широкий круг партнерских отношений, а UTM-метки не позволяет ставить внутренняя политика, то вот решение всех вопросов:

meta name="referrer"Есть еще один вариант — заставить всех партнеров перейти на HTTPS, дав им почитать эту статью :) При переходе с HTTPS-сайта на HTTPS-сайт и с HTTP-сайта на HTTPS-сайт referer передается.

Знаете что-то интересное по теме? Поделитесь в комментариях.

Свежее

Маркетинг, который работает: как научить рекламные алгоритмы приносить больше прибыли

Рекламные кампании не дают желаемого результата? Узнайте о новейших инструментах веб-аналитики и превратите рекламный бюджет из расходов в инвестиции

Cloud Marketing и AI-аналитика: как бизнес оптимизирует рекламу благодаря данным

В статье рассмотрю, как внедрить AI, GA4 и Google Cloud в маркетинг, сократить время до инсайта и повысить ROMI. Покажу, как бизнес адаптируется к новым требованиям и повышает эффективность за счёт данных

Аудит оптимизации в App Store и Google Play: подробное руководство

Чтобы выделяться среди других, нужна качественная оптимизация. И именно здесь пригодится аудит оптимизации в App Store и Google Play