Как использовать аналитику, чтобы не расходовать рекламный бюджет впустую

На прошлогодней конференции 8P Анна Иванова, менеджер проектов отдела аналитики в OWOX, поделилась фишками из практики специалистов компании. Если вам интересно, как не тратить на рекламу для тех, кто ничего не покупает, читайте этот пост.

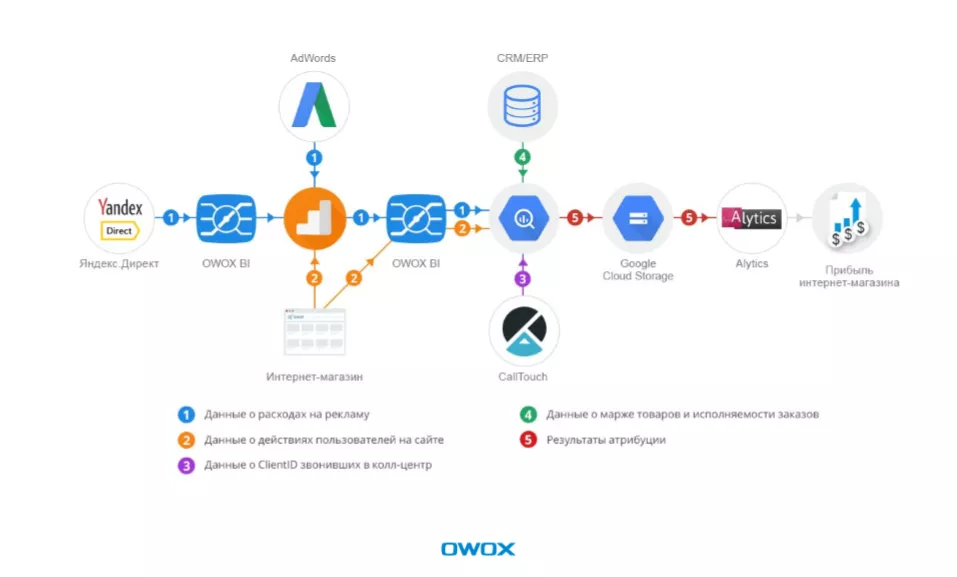

Как собрать данные из разных систем в едином хранилище

Специалисты знают: используя стандартные (статистические) модели атрибуции мы не можем точно определить ценность рекламной кампании. Почему? Потому что не учитываем:

- отмененные заказы;

- оффлайн-заказы;

- маржу заказа;

- заказы по телефону;

- воспринимаем пользователя, который заходит на сайт с разных устройств, как нескольких пользователей;

- используем сэмплированные данные при построении отчетов.

Как же тогда увеличить ROI онлайн-рекламы? Для этого следует:

- Собрать данные о всех сессиях пользователя онлайн (с разных устройств) и офлайн.

- Оценить прибыль от каждой поисковой фразы, а не назначать 100% ценности поисковым фразам перед конверсией.

- Автоматизировать управление контекстной рекламой и расчет ставок.

Решение в кейсе, представленное на 8P:

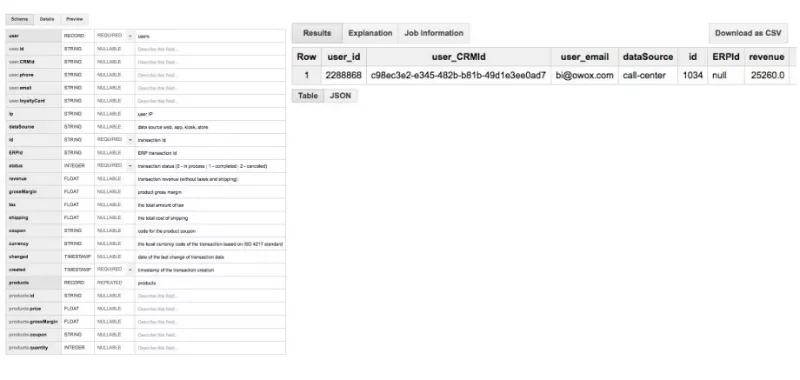

Шаг 1. Сбор данных в Google BigQuery.

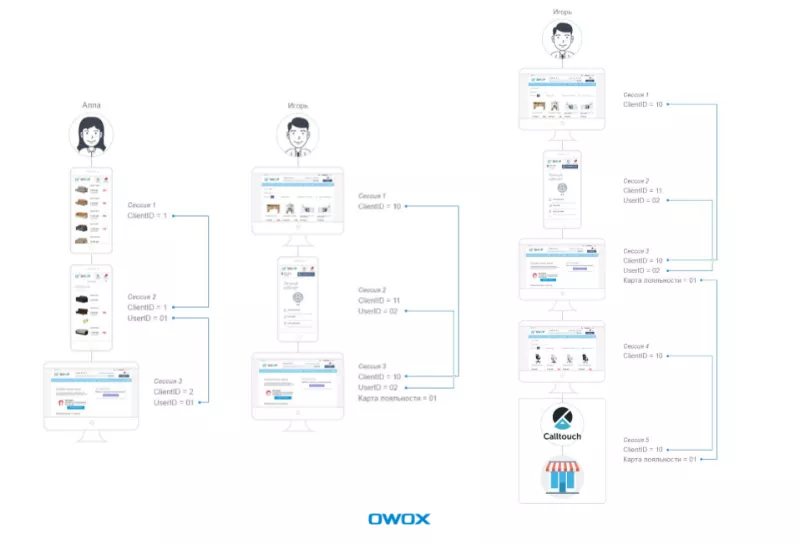

При сборе аналитической информации существует три точки касания с пользователем:

- Client-ID.

- User-ID, который мы выдаем только тем, кто авторизовался онлайн.

- Карта лояльности, полученная при офлайн-покупке.

Представим клиента Аллу. Она зашла с мобильного, посмотрела диваны. У нее один Client-ID. Затем Алла второй раз зашла с мобильного — ее Client-ID не изменился, так как девайс и браузер не изменились. Она авторизовалась и мы узнали ее User-ID.

Дома Алла показала мужу диван, который присмотрела. Муж одобрил — она зашла с десктопа и заказала диван. Client-ID поменялся, а User-ID не поменялся. Что мы можем вынести из этого случая? Если Алла зайдет с любого из своих устройств, мы будем знать, что это она.

Вы спросите: «А если это общественный компьютер»? В наше время такой вариант маловероятен и поэтому подмена IP вряд ли случится.

Также у нас есть пример другого клиента: Игорь. Он зашел с десктопа, потом — с мобильного, затем снова с десктопа. Кроме того, Игорь уже покупал что-то офлайн, и у него есть карта лояльности. То есть по взаимодействию с ним существуют все три точки касания. Можно ретроспективно прогнать эти данные и посмотреть, что Игорь делал ранее, кто привел лояльного к нам клиента.

Еще одна ситуация с Игорем. Он купил стол, затем посовещался дома и купил гарнитур. При этом заказал гарнитур через колл-центр и забрал из магазина.

И мы видим, куда и когда он пришел, на каком этапе и где исчез из поля зрения. Почему это произошло: может, он просто переехал и стал покупать с мобильного.

Этот кейс позволяет объединить и посмотреть на эти данные.

Шаг 2. Обработка сырых данных.

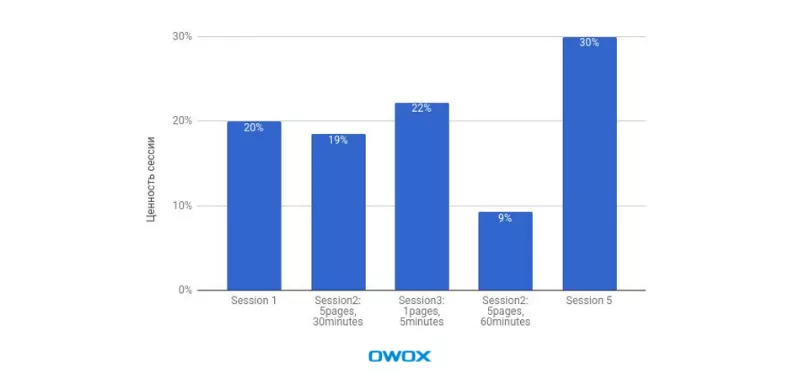

Шаг 3. Расчет модели атрибуции:

- определение рекламного канала, который инициировал первую сессию;

- назначение ценности сессиям.

Шаг 4. Передача и использование данных в Analytics.

Что получили в итоге аналитики OWOX?

- увеличение ROI контекстной рекламы на 17% за счет оптимизации размера ставок;

- рост числа поисковых фраз с ненулевой ценностью в 2,4 раза: стандартные модели атрибуции их просто не учитывали;

В результате выяснили, что отношение доходов офлайн к онлайну в некоторых категориях контекста на 50% больше, чем среднее отношение дохода офлайна и онлайна.

Как выявить истинную ценность канала ретаргетинга для компании

Действительно ли эффективен канал ретаргетинга? Признайтесь, вам тоже иногда нужен ответ на этот вопрос. Как на него ответили в OWOX, разбираемся на примере второго кейса.

Бизнес-задача: настроить частичную отправку данных о посетителях в партнерскую систему. То есть не показывать часть пользователей и посмотреть как она конвертится без ретаргетинга. При этом часть пользователей равномерно выделяется из всей аудитории.

Чтобы проверить, придут или не придут пользователи без ретаргетинга, провели А/В-тестирование. А/В-тест настраивали с помощью

В чем ценность:

- определить, как меняется модель поведения пользователей, которые взаимодействуют с партнерской рекламой;

- сравнить ценность пользователей, которые вернулись через рекламный сервис, и тех, кто никогда с ним не взаимодействовал.

Как решали эту задачу аналитики?

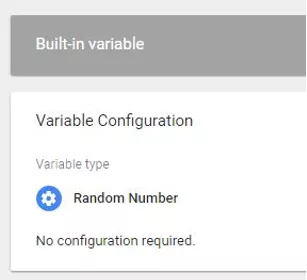

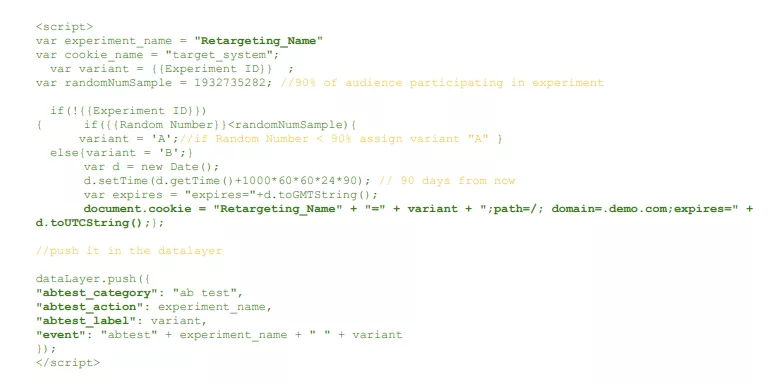

- Настроили две переменных:

- для cookie, в которой хранился вариант теста, показанного пользователю;

- переменную, в которой генерировалось произвольное число. На основании знания этого числа пользователи попадали в разные группы тестирования.

Принимали значение в диапазоне от 0 до 2147483647.

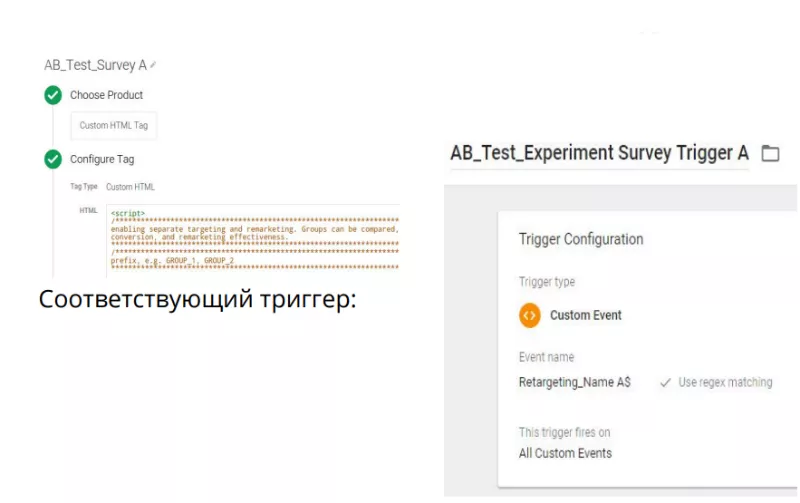

- Создали тег, в котором фиксируется передача в ретаргетинговую систему — пользовательский HTML-тег, в котором прописали логику распределения вариантов в тесте.

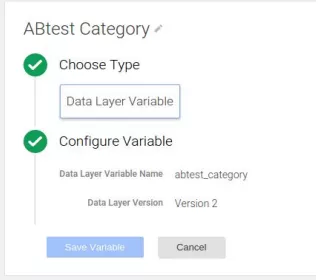

- Создали дополнительные переменные: abtest_category, abtest_action, abtest_label.

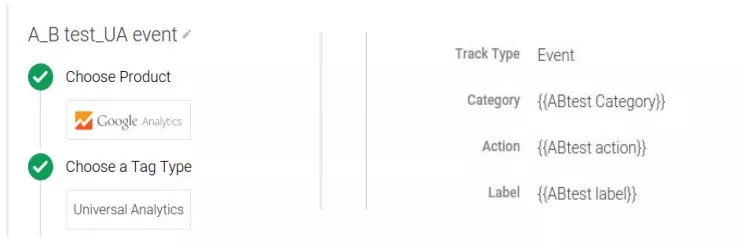

- Создали тег, отправляющий данные об эксперименте в GA.

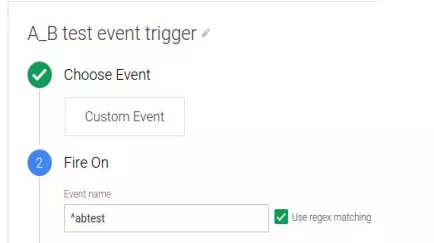

Запускали по такому тригеру:

- Создали тригер, отправляющий данные о части пользователей партнеру.

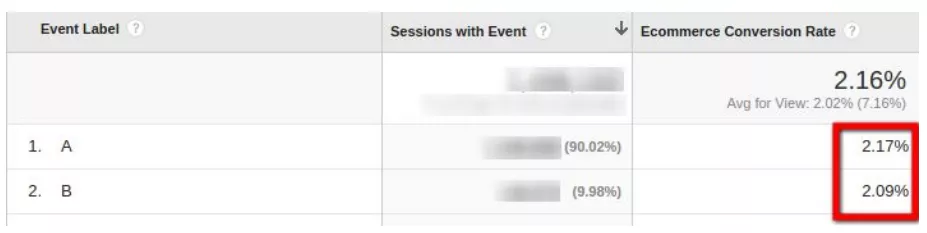

Что получили в результате:

- показатель конверсии выше для пользователей, пришедших с помощью ретаргетинга;

- при этом средний чек выше у пользователей, которые не взаимодействовали с рекламными объявлениями в ретаргетинге.

Несмотря на незначительную разницу в уровне конверсий, средний чек выше для пользователей, которые не взаимодействовали с данной системой. То есть продуктивные и заинтересованные пользователи часто приходят и без ретаргетинга.

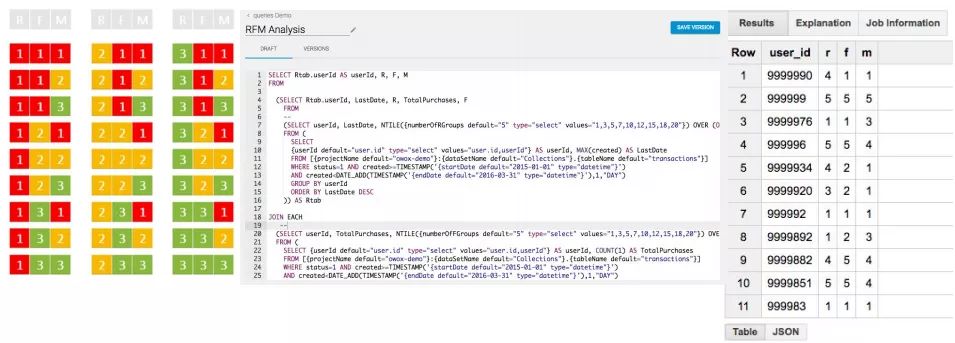

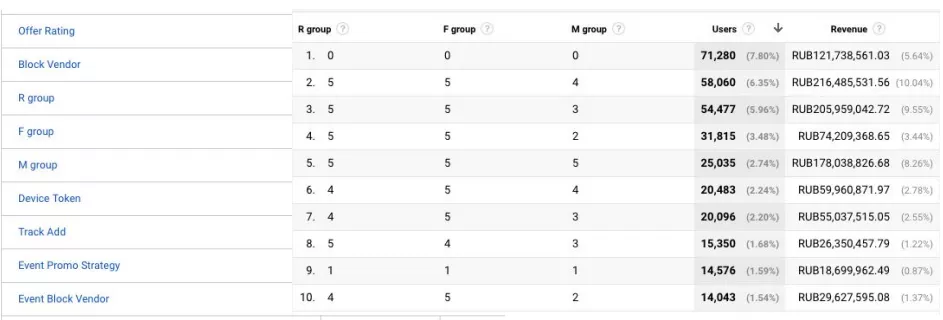

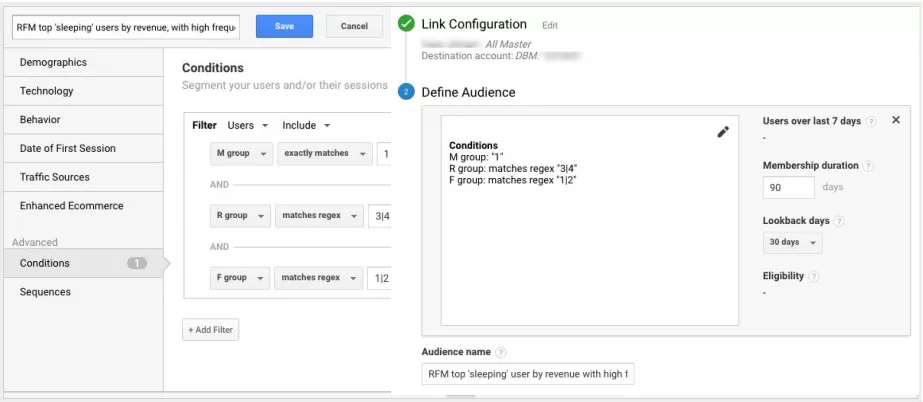

Эффективный ретаргетинг по сегментам аудитории

Чтобы рекламное сообщение попало точно в цель, следует сегментировать аудиторию. Увы, не для всех это так очевидно. Клиенты, которые приносят больший доход, привлекаются точно так же, как и основная масса пользователей. Чтобы изменить ситуацию, в OWOX предложили применить RFM-анализ на основе данных Google Marketing Platform и BigQuery.

RFM и LTV-анализ направлены на то, чтобы сегментировать аудиторию и сделать e-mail-рассылки, SEO-обращения более целевыми и направленными — бить в ту точку, которая действительно принесет результат.

Итак, бизнес-задача: увеличить конверсию и ROAS для платных источников трафика. Что для этого нужно:

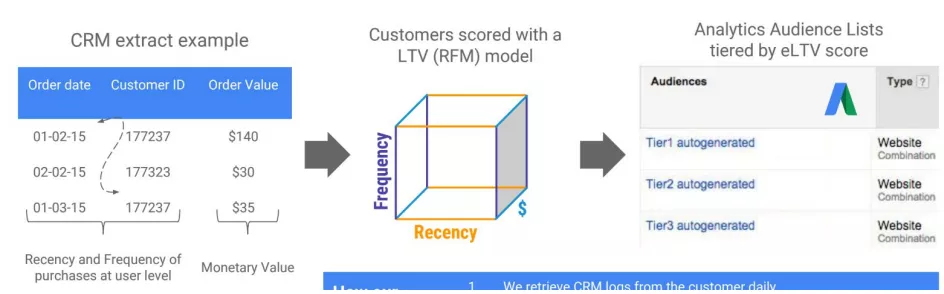

- Для каждого клиента рассчитать ожидаемый Lifetime Value (RFM model).

- Создать LTV-группы Аудиторий для экспорта в Google Рекламу.

- Провести корректировку ставок в Google Рекламе.

Каждый день специалисты выгружали эти данные, пересчитывали RFM, при этом тратили на хранение и обработку небольшие деньги. Так, для среднего бизнеса сумма не доходила даже до $100 в месяц (данные по состоянию на 2017 год). Что в итоге: известно движение аудитории, можно смотреть, как пользователь движется между сегментами в процессе своего жизненного цикла и можно правильно продать ему рекламу.

Шаги специалистов OWOX:

- Импортировали заказы из CRM в Google BigQuery (365+ дней).

- Выполнили сегментацию по давности (Recency), частоте (Frequency), сумме (Monetary) покупок — всего 125 сегментов (это не предел, может быть и 400.

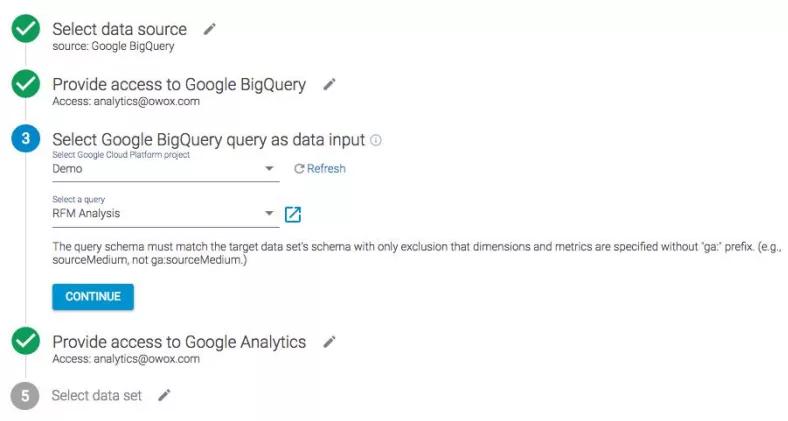

Важно: Если будете использовать, задавайте фильтры, по которым пользователи будут попадать в сегменты. Они делятся, затем попадают в табличку. Эти данные выгружаются с помощью инструмента

- Импортировали данные в Google Analytics из BigQuery.

- Использовали данные в GA для анализа поведения по когортам.

- Создали аудитории и настроили таргетинг в Google Рекламе по RFM группам.

Результаты через четыре месяца после запуска:

- Конверсия в Google Рекламе увеличилась в два раза.

- Расходы выросли в 2,5 раза, а ROAS на 55%.

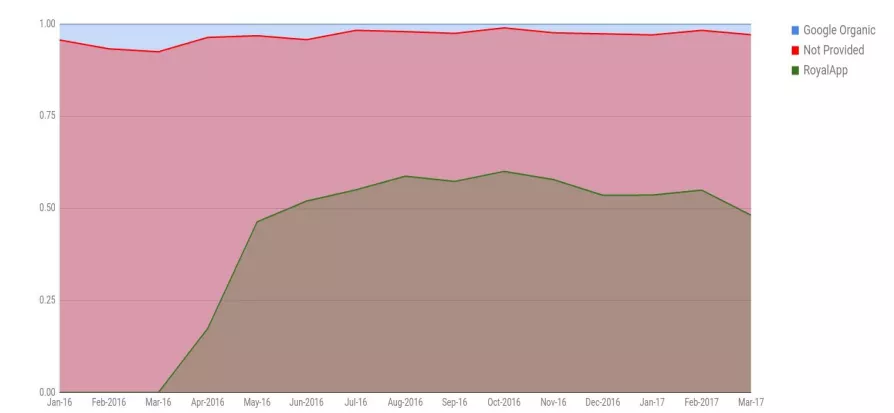

Как уменьшить процент not provided запросов

С чем наверняка сталкивались все: Google в конце 2012 начал шифровать 95% данных not provided.

Как с проблемой шифрования львиной доли ключевиков органического поискового трафика боролись в OWOX?

Для решения этого вопроса специалисты OWOX сформулировали аналитическую задачу:

- Собрать как можно больше слов из зоны, которую шифрует Google.

- Проанализировать релевантность запросов и, по возможности, поднять их в выдаче (первая десятка все равно всегда более релевантна).

Два метода решения:

Первый вариант: Использовать сторонний сервис RoyApp, который функционально похож на то, что делает Serpstat: бесплатный, встроенный и считает (в 2018 году RoyApp прекратил свое существование — примечание редакции).

Плюсы:

- расшифровывает 30-60% (not provided) трафика;

- собирает дополнительную позицию и версию поисковой системы;

- есть 30-дневный trial. Если вы его используете, данные сохранятся в Google Analytics и вы проверите, интересно ли работать с этим сервисом.

Минусы:

- платный сервис. Правда, не очень дорогой. И если у вас большая завязка на органическом трафике и проблема not provided стоит остро, обратите внимание на этот инструмент;

- необходимы настройки в GTM и GA.

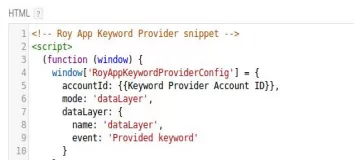

Краткая инструкция по настройке RoyApp:

Создать тег в GTM.

Создать переменную в GTM.

Последний шаг: создать переменные в GA для сбора расшифрованной информации.

Второй вариант: Встроенный отчет в Search Console

Основная проблема — он никак не связан с другими отчетами Google. Кастомные переменные не применяются к этому отчету, половина стандартных — тоже. Из других минусов:

- данные становятся доступны через 48 часов;

- хранит данные только за последние 90 дней;

- нет возможности работать с пользовательскими параметрами и в пользовательских отчетах.

Как все же можно использовать этот отчет? Выгружать каждый день данные, например, в Google BigQuery или в CRM, тогда сохранится вся ретроспектива и скорость доступа к данным.

Плюсы:

- не требуются дополнительные настройки GTM/кода;

- расшифровывает порядка 50-60% поисковых запросов;

- есть возможность посмотреть срезы по лендингам, GEO, девайсам.

Результаты:

- Благодаря RoyApp количество распознанных запросов выросло до 48%.

- С помощью выгрузки отчета из Search Console специалисты OWOX узнали на 46% больше поисковых запросов, которые раньше были not provided

Больше подробностей мы узнали уже в кулуарах, потому что в рамках одного доклада на 8P обо всех фишках можно и не успеть рассказать. И это уже та информация, который мы не можем с вами поделиться.

В эту субботу, 14 июля точно так же будем охотиться за докладчиками после выступлений. Увы, если вы не успели купить билет на 8Р, продажи уже закрыты, но мы будем вести прямую трансляцию конференции в блоге. Следите за обновлениями!

Свежее

Какие ошибки возникают при работе с Google Analytics и как с ними бороться

Советы специалистам по контекстной рекламе. Технические сложности, которые возникают при работе с Google Analytics: от ограничений интерфейса до ошибок настройки отслеживания и последующей недостоверности полученных данных, и решения для них

Как оптимизация Google Ads и Meta Ads принесла Mr.Lens рост дохода на 20% за месяц

Подробно о переходе к performance-форматам и точечной работе с аудиториями

Что эффективнее для анализа рекламы в AppsFlyer: сравнение отчетов Activity и Events

Почему важно понимать разницу между Activity и Events, каковы их основные возможности и отличия