Период продвижения: 01.07.2022 — 30.01.2024.

Регион: Восточная Европа.

Услуга: сквозная аналитика.

Команда проекта: Игорь Павленко, Internet Marketer; Ольга Горностаева, Web Analyst Team Lead; Оксана Демечева, Project Manager; Александр Конивненко, Department Head.

Кто наш партнер

Ведущее агентство трудоустройства, специализирующееся на подборе персонала из Украины и Восточной Европы для компаний в Польше и ЕС. Помогает найти работников для различных отраслей, включая промышленность, логистику и сельское хозяйство.

Причина обращения

Наш партнер активно привлекает пользователей благодаря каналам платного трафика, в том числе Meta Ads и Google Ads. Но возникла проблема: каждый инструмент выдает отдельные отчеты, которые сотрудники должны совмещать в ручном режиме. Реальное количество лидов видно только в СRM-системе, источник лидов — в Google Analytics 4 (GA4), а расходы — в рекламных кабинетах.

Перед нами встала задача объединить все источники в один автоматический отчет, чтобы минимизировать ручную работу.

Этапы внедрения

1. Инструменты и разработка архитектуры

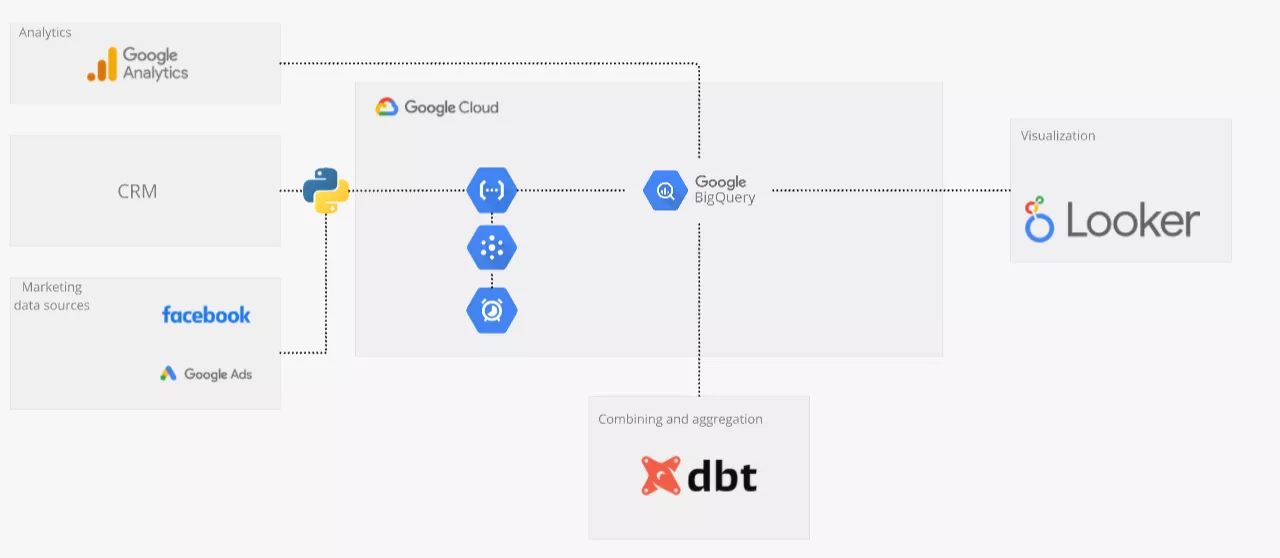

Для построения сквозной аналитики мы использовали преимущественно инструменты и сервисы Google, которые позволили автоматизировать сбор, обработку и визуализацию данных. Ниже — схема архитектуры решения.

Решение долговременное и стабильное, а использование всех инструментов в инфраструктуре Google Cloud стоит не более пяти долларов в месяц для этого объема данных.

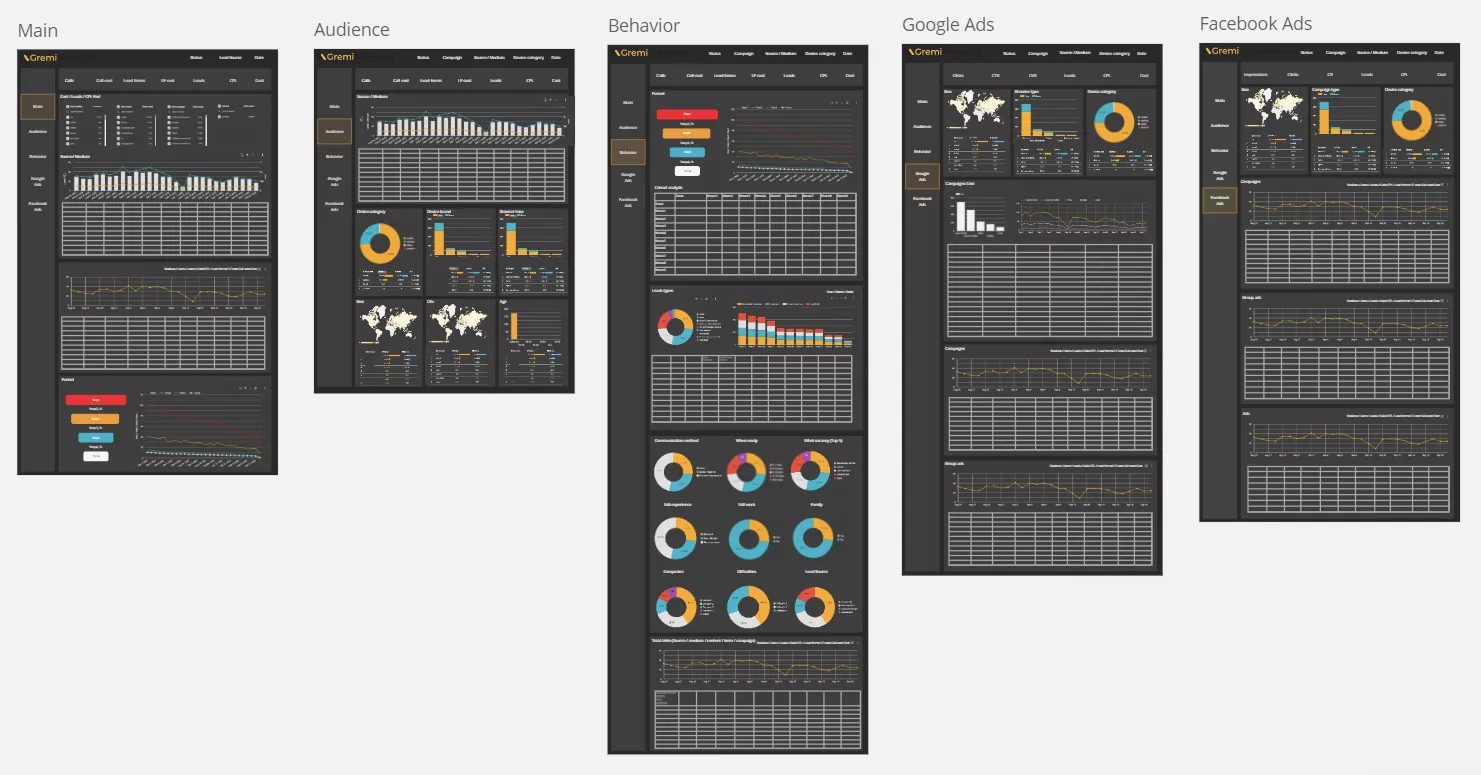

2. Создание макетов

Получив всю необходимую информацию от заказчика, мы создали макеты отчетов в Miro и утвердили их до начала основной работы. Это помогло сэкономить время и избежать недоразумений в дальнейшей разработке дашбордов.

3. Сохранение и сбор данных

Мы использовали Google BigQuery в качестве центрального хранилища. Это облачная база данных, созданная специально для аналитических целей, которая автоматически масштабируется и не требует дополнительной поддержки. Данные из Google Analytics поступают туда в «сыром» виде ежедневно и бесплатно.

Для рекламных источников мы разработали специальный коннектор — Python-код, который размещен в Cloud Functions и ежедневно автоматически загружает данные из Google Ads и Facebook.

Стандартной CRM-системы заказчик не имел, вместо нее используется система управления задачами (далее — система). Лиды хранятся как отдельные задачи. Python-код с сервера системы ежедневно забирает необходимые данные по заявкам и клиентам, сразу форматирует их и переносит в BigQuery.

4. Объединение и агрегирование

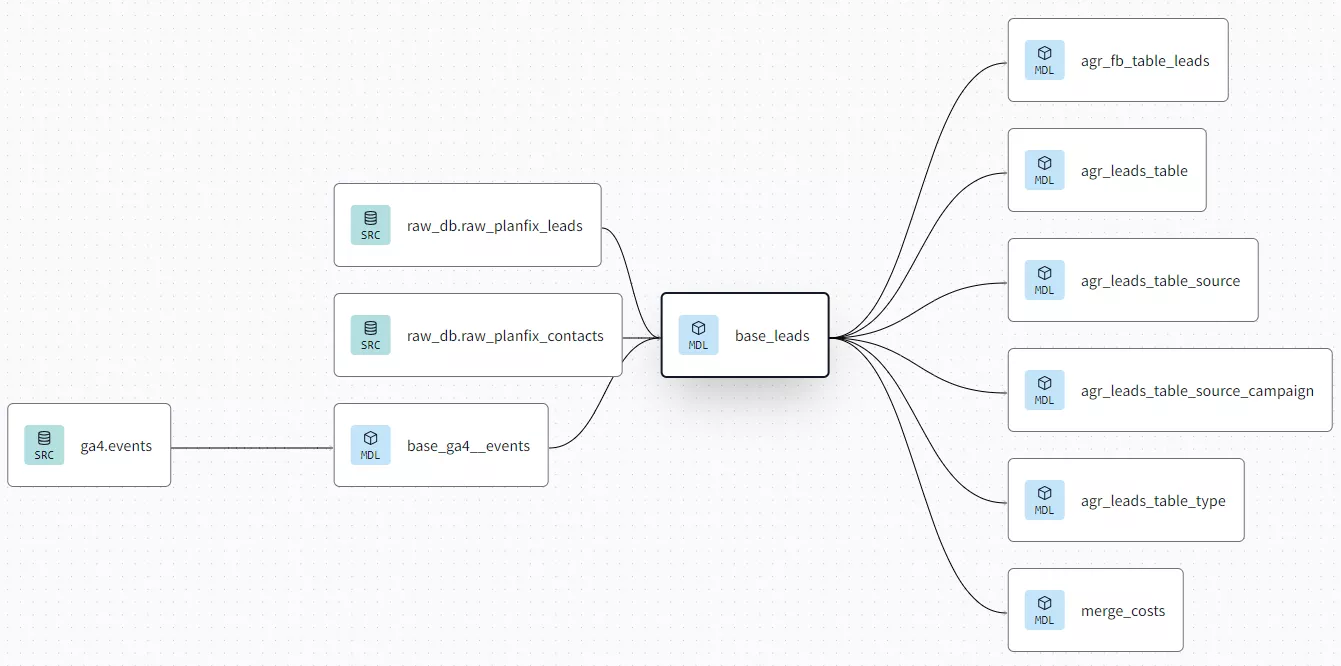

Мы использовали сервис DBT (Data Build Tool), который позволяет эффективно управлять проектом, содержащим много SQL-скриптов. DBT структурирует SQL-код, что значительно облегчает процесс трансформации и оркестрации.

Оркестрация — автоматизированный процесс построения таблиц в базе данных, который происходит по графику и в определенной последовательности. Позволяет уменьшить ручной труд и риски ошибок.

Благодаря этому сервису и построенным SQL запросам мы объединили данные из разных источников, выполнили сложные агрегации и создали единые витрины данных.

Витрины (data marts) — агрегированные и трансформированные таблицы данных из разных источников в формате удобном для визуализации.

Также на этапе агрегации мы отфильтровали дубли заявок, которые оставляли одни и те же клиенты.

Проблема. Заявки с сайта попадают в GA4 без ID, поэтому трудно объединить данные из GA4 с данными из CRM-системы. Внедрить передачу ID нет возможности.

Решение. Мы проверили с каким временным лагом (промежутком времени) приходят заявки с сайта в систему партнера. Лаг составляет до 60 секунд. На основе этого мы объединили заявки по времени. Если заявка из GA4 соответствует времени заявки из системы с промежутком до 60 секунд, мы присваиваем этой заявке соответствующий источник.

Чтобы реализовать этот процесс, мы вернулись к предыдущему шагу и изменили коннектор выгрузки данных из системы, добавили дату и точное время заявки в передаваемые данные. Это позволило понять источник и канал для более чем 85% заявок.

Остаток заявок не удалось объединить. Часть из них не была зафиксирована аналитикой из-за использования adblocker’ов пользователями, часть не была объединена, так как по отдельным заявкам лаг был более 60 секунд.

В дальнейшем партнер планирует внедрить новую CRM-систему и сможет отправлять номер заявки в GA4, что позволит корректнее совмещать эти данные. На этом этапе созданное решение помогло нам работать с имеющимися данными.

5. Визуализация

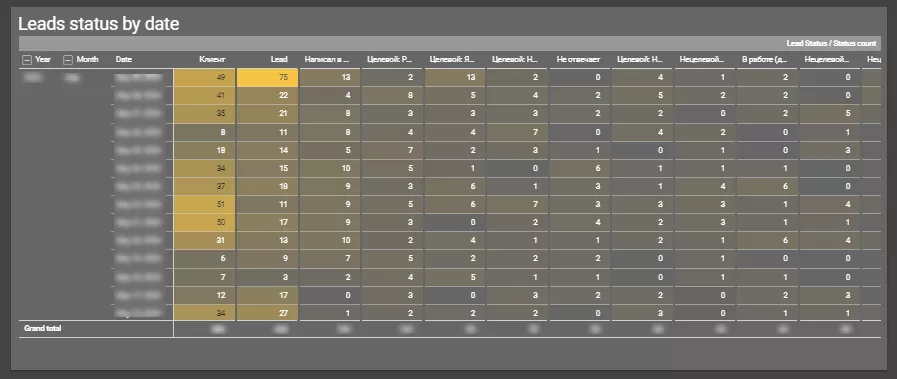

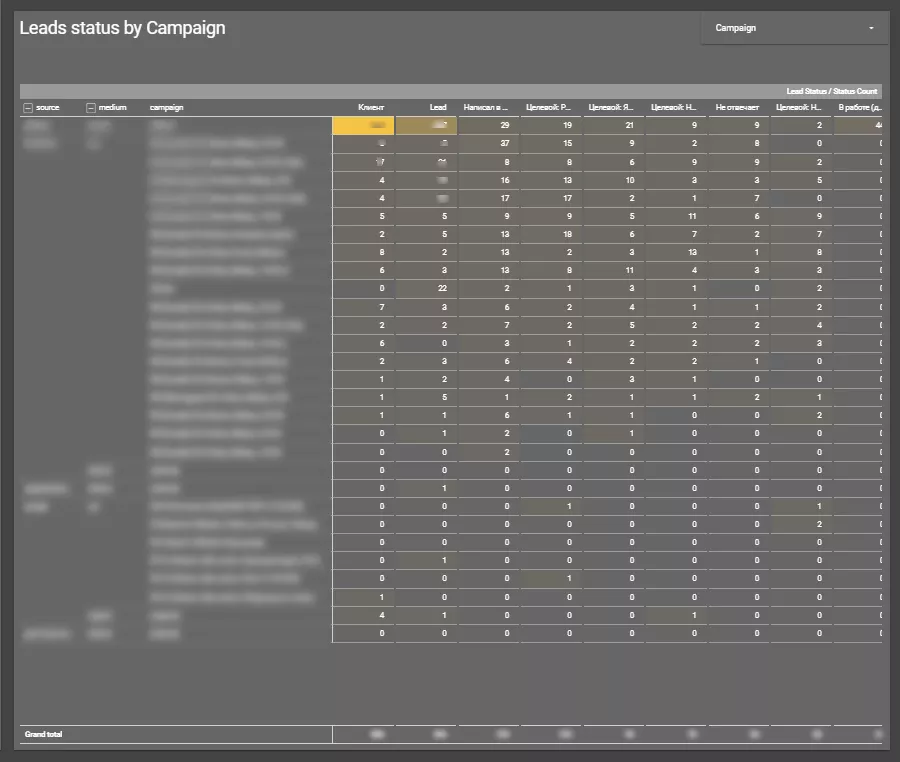

В конце мы подключили витрины к визуализатору Looker Studio, где готовили финальные дашборды. Ниже — несколько примеров из готового дашборда.

Результаты

Новая аналитическая платформа объединяет информацию из разных источников: аналитических систем, рекламных кабинетов и внутренних данных. Это позволяет контролировать эффективность всех каналов, анализировать расходы и ключевые показатели эффективности (KPI), оптимизировать бюджет, направляя средства на более результативные каналы.

Мы создали единую аналитическую систему, которая позволяет быстро принимать маркетинговые решения и вывести процесс оптимизации рекламы на качественно новый уровень.

Выводы

- Стояла задача объединить отдельные отчеты из разных инструментов (Google Ads, Meta Ads, Google Analytics 4, системы управления задачами) в один автоматизированный отчет, что минимизировало бы ручной вклад в его подготовку.

- Для этого использовали инструменты Google Cloud для хранения и обработки данных, что обеспечило стабильность и экономичность.

- Создали Python-код для автоматической загрузки данных с рекламных платформ и системы партнера.

- Собрали данные в облачной базе Google BigQuery, которая автоматически масштабируется при необходимости.

- Применили DBT для управления SQL-скриптами и трансформации данных, что позволило эффективно объединить заявки из разных источников и отфильтровать дубликаты.

- Подготовили финальные дашборды в Looker Studio для удобного и быстрого анализа данных. Внедрили контроль за эффективностью каналов, анализ затрат и ключевых показателей эффективности, что позволяет оптимизировать рекламный бюджет.

Свежее

Почему пользователи удаляют приложение и как этого избежать

Что именно заставляет пользователей забывать и удалять приложение? Разбираем и предотвращаем отток юзеров

Как настроить расширенную электронную торговлю с помощью Google Tag Manager

В этой статье разберу этапы построения системы — от стратегии до отдельных событий в воронке

Как оценить готовность бизнеса к ML-аналитике: чеклист от Netpeak

Компании все чаще инвестируют в машинное обучение, однако модели не становятся частью повседневных решений. Разбираем, почему