Шесть способов проверить индексацию сайта или страницы

Чтобы сайт отображался в результатах поиска, все его страницы, открытые для индексации, должны стать частью индекса поисковой системы. Если системе не удается добавить страницы сайта в базу данных, они остаются практически невидимыми для потенциальных клиентов.

Предлагаю рассмотреть шесть способов проверки индексации. Выясним — почему поисковые системы не индексируют сайт, найдем пути решения проблем.

- Как работает индексация сайта?

- Проверка в Google Search Console

- Как проверить индексацию конкретной страницы в Search Console?

- Анализ индексации сайта в Google поиске

- Проверка индексации онлайн с помощью сервисов

- SEO-инструменты для проверки сайтов

- Букмарклеты

- Индексатор Google Indexing API

- Почему Google не индексирует сайт?

- Как ускорить индексацию сайта?

- Как управлять краулинговым бюджетом?

Как работает индексация сайта?

На первый взгляд может показаться, что сканирование и индексация — два очень похожих процесса. Они действительно тесно взаимосвязаны, но являются разными этапами обработки сайта поисковыми системами.

Сканирование — процесс поиска страниц для дальнейшей обработки и индексации.

Индексация — процесс добавления просканированной страницы в базу данных (индекс) поисковой системы. Таким образом, при релевантном запросе пользователя, страница появится в результатах поиска:

Важно. Сканирование сайта не означает его индексацию. А попадание сайта в индекс поисковой системы не гарантирует первых позиций поисковой выдачи, так как за порядок отображения страниц по ключевому запросу отвечает ранжирование.

Как проверить сайт на индексацию

Проиндексирован — значит виден. Очень важно, чтобы все страницы, которые нужно показать потенциальным клиентам, пользователям или читателям, проиндексировались. Иначе может получиться так: товар или услуга лучшие на рынке, статья полностью раскрывает суть вопроса, но если страницы вашего сайта отсутствуют в индексе поисковой системы — про это никто не узнает.

Именно поэтому важно уметь проверять индексацию.

Как узнать сколько страниц на сайте с помощью счетчика страниц в Netpeak Spider.

1. Проверка в Google Search Console

Это один из базовых способов проверки индексации для владельца сайта и веб-мастера.

Войдите в ваш аккаунт на Search Console и перейдите по вкладке «Страницы» в разделе «Индексирование»:

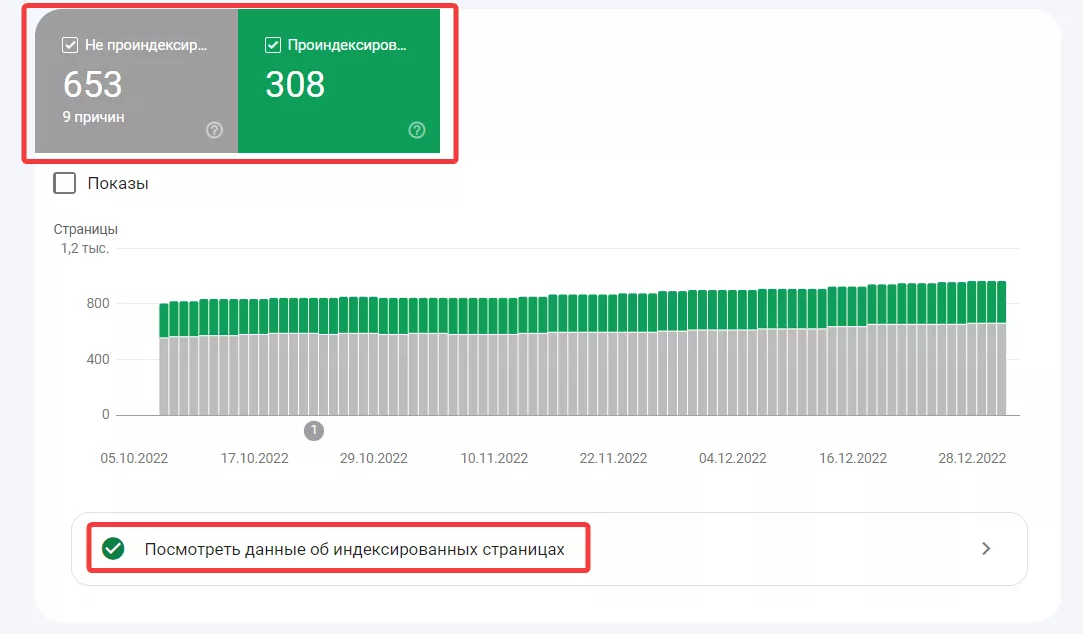

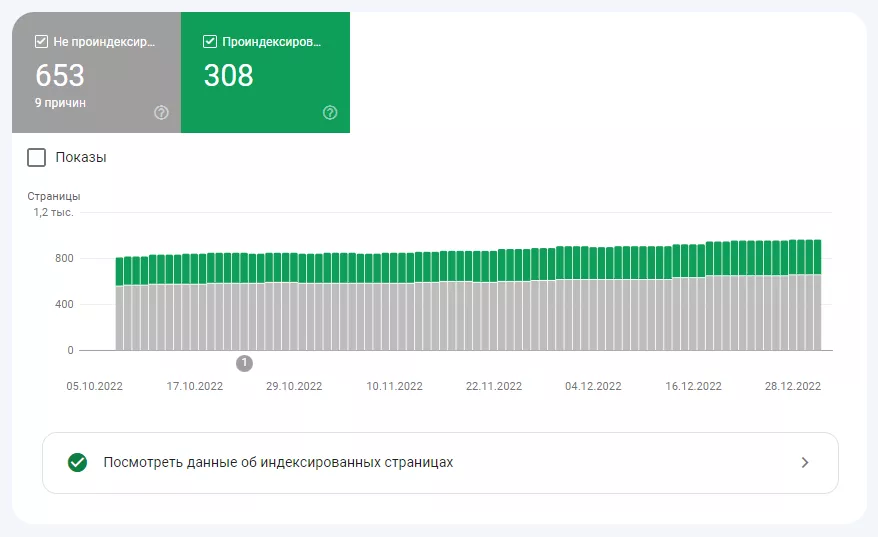

В этом отчете вы найдете общую информацию о проиндексированных и непроиндексированных страницах с отображением на временной шкале:

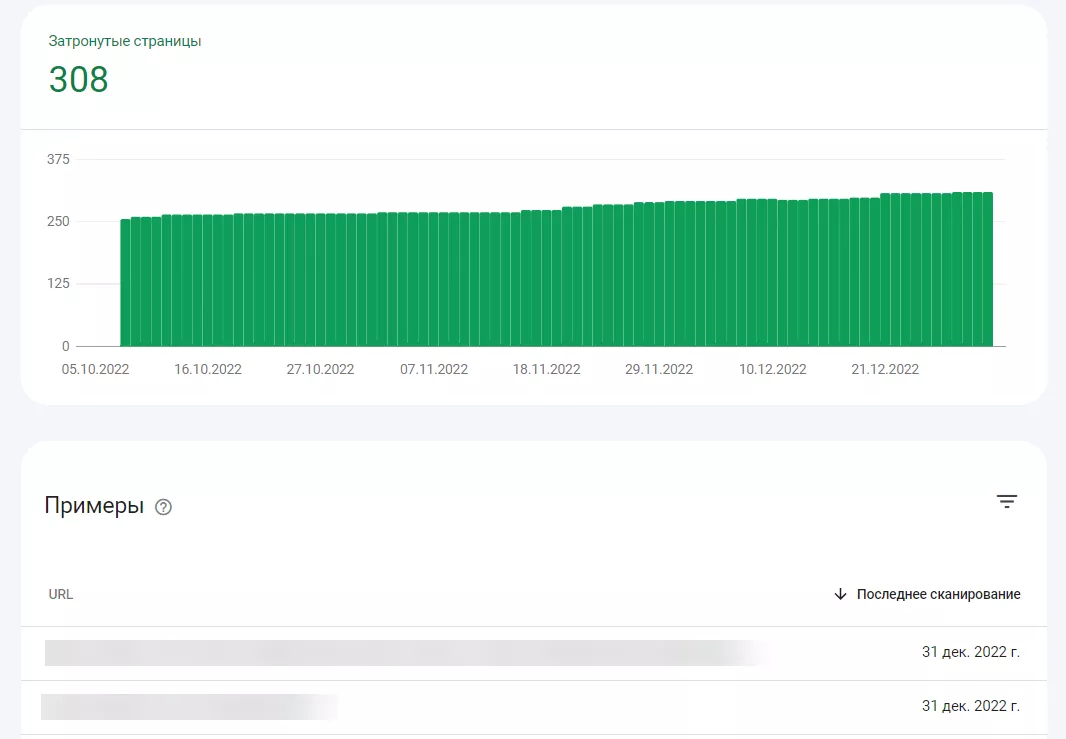

Перейдя в полный отчет, увидите подробные данные о всех страницах, проверенных на индексацию:

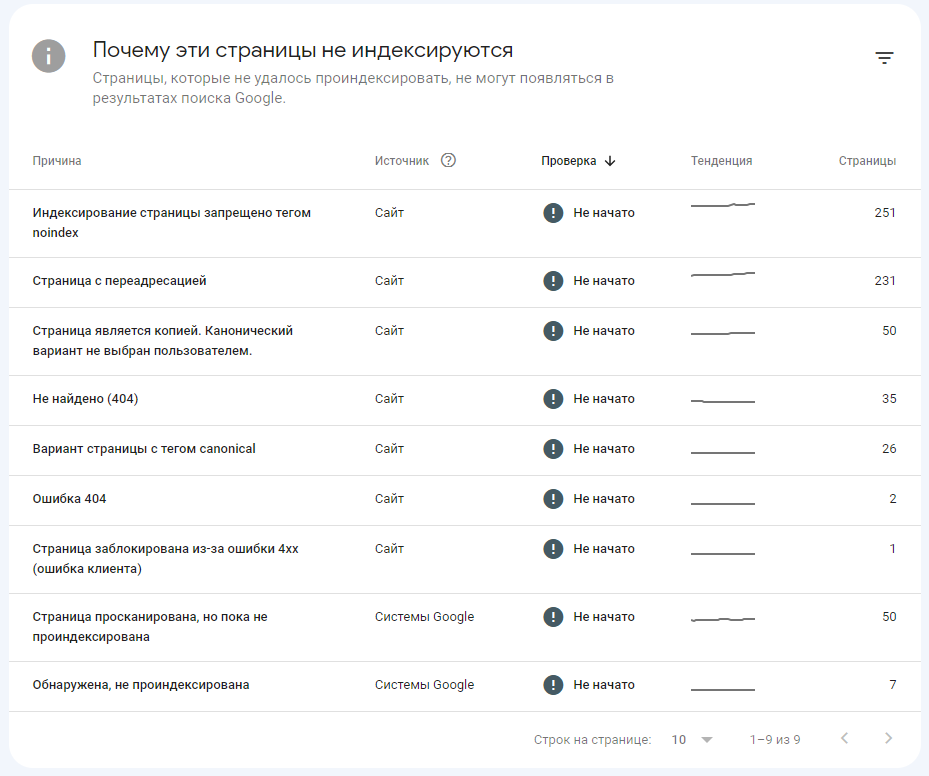

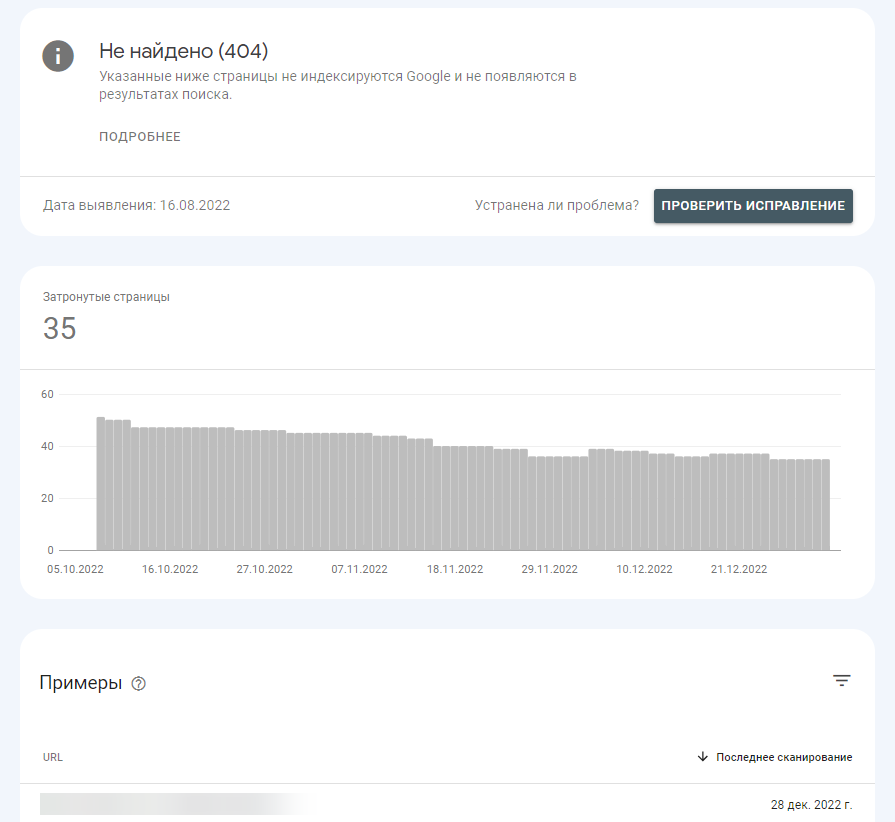

Чтобы просмотреть отчет по неиндексируемым страницам и ошибкам индексации, вернитесь в раздел «Индексирование страниц»:

Кликнув на левую колонку «Причина», можно увидеть списки страниц сайта, недоступных к индексации:

Как проверить индексацию конкретной страницы в Search Console?

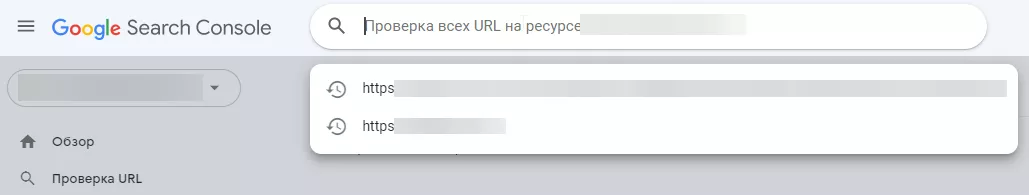

Вставьте ссылку на интересующую вас страницу в строку поиска Search Console:

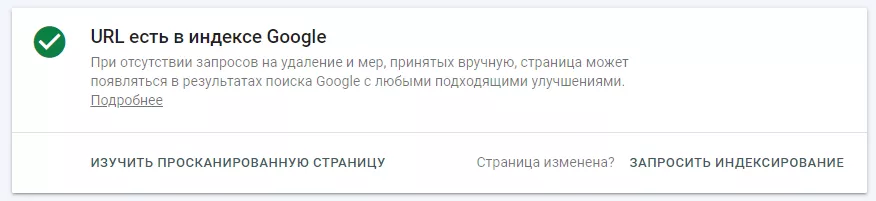

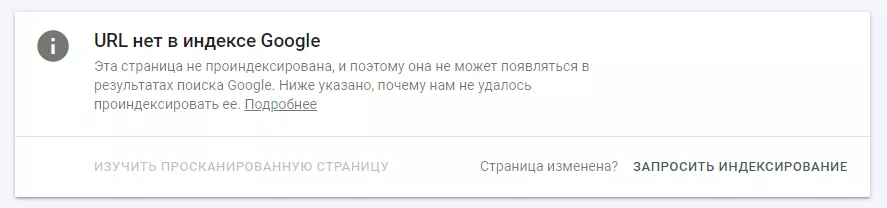

В результате проверки увидите одно из следующих сообщений:

- страница успешно проиндексирована;

- страница отсутствует в индексе.

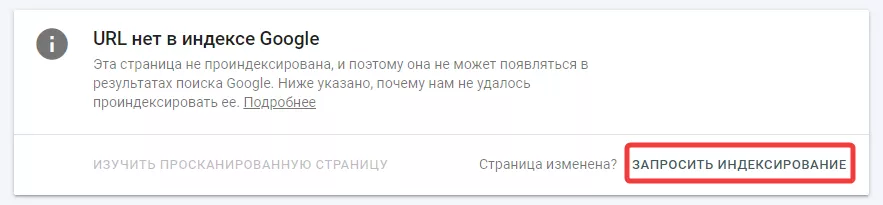

Если вы внесли все необходимые изменения, но страница все еще отсутствует в индексе — отправьте запрос на пересканирование самостоятельно:

- Введите адрес страницы в инструменте проверки URL.

- Нажмите кнопку «Запросить индексирование».

Этот же способ можно использовать для ускорения индексации новых страниц сайта — но не более 10 в день.

При сканировании сразу нескольких страниц рекомендуется применять

2. Анализ индексации сайта в Google поиске

Поисковые операторы (например, «site:») помогают уточнить результаты поиска.

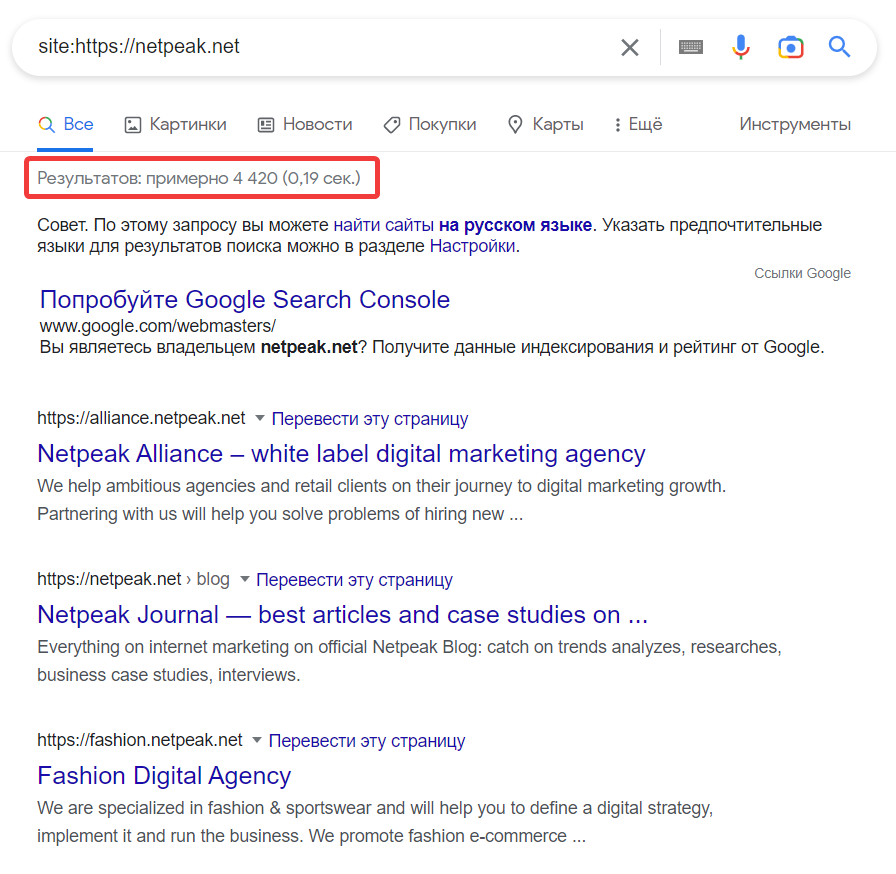

Чтобы узнать о наличии вашего сайта в индексе Google, наберите в строке поиска «site:[url вашего сайта]»:

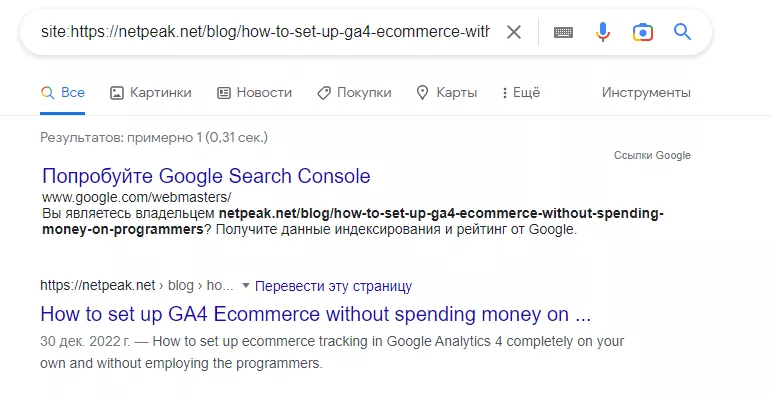

Для проверки индексации конкретной страницы используйте оператор в формате «site:[url страницы вашего сайта]»:

Если сайт или страница успешно проиндексированы, они отобразятся в результатах поиска. Появится информация о приблизительном количестве страниц вашего сайта, которые индексировалось поисковой системой:

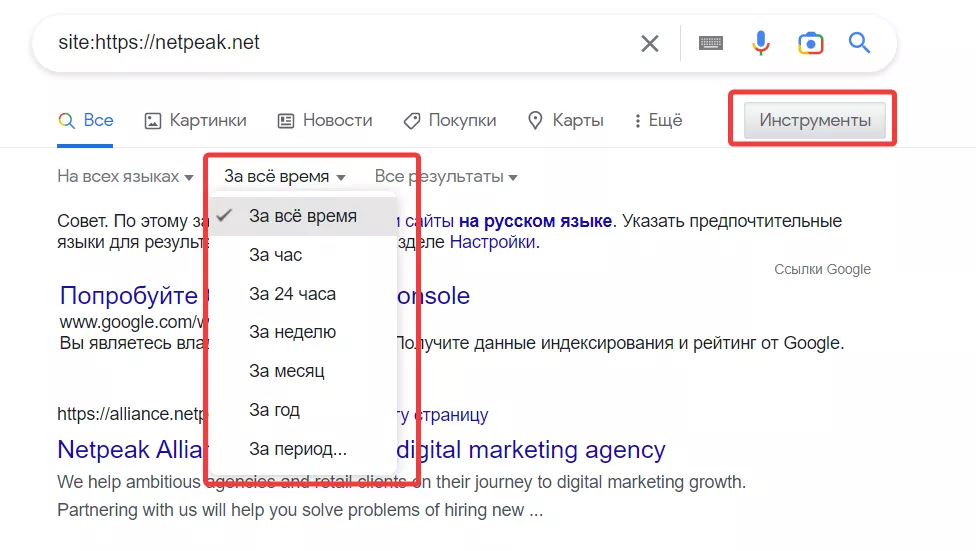

Кроме того, инструменты поиска могут проанализировать количество страниц, индексированных поисковой системой за определенный период времени:

3. Проверка индексации онлайн с помощью сервисов

Существует большое количество бесплатных онлайн-сервисов для контроля индексации сайта, таких как linkody.com или smallseotools.com. Их недостаток — лимиты: от 5 до 50 страниц.

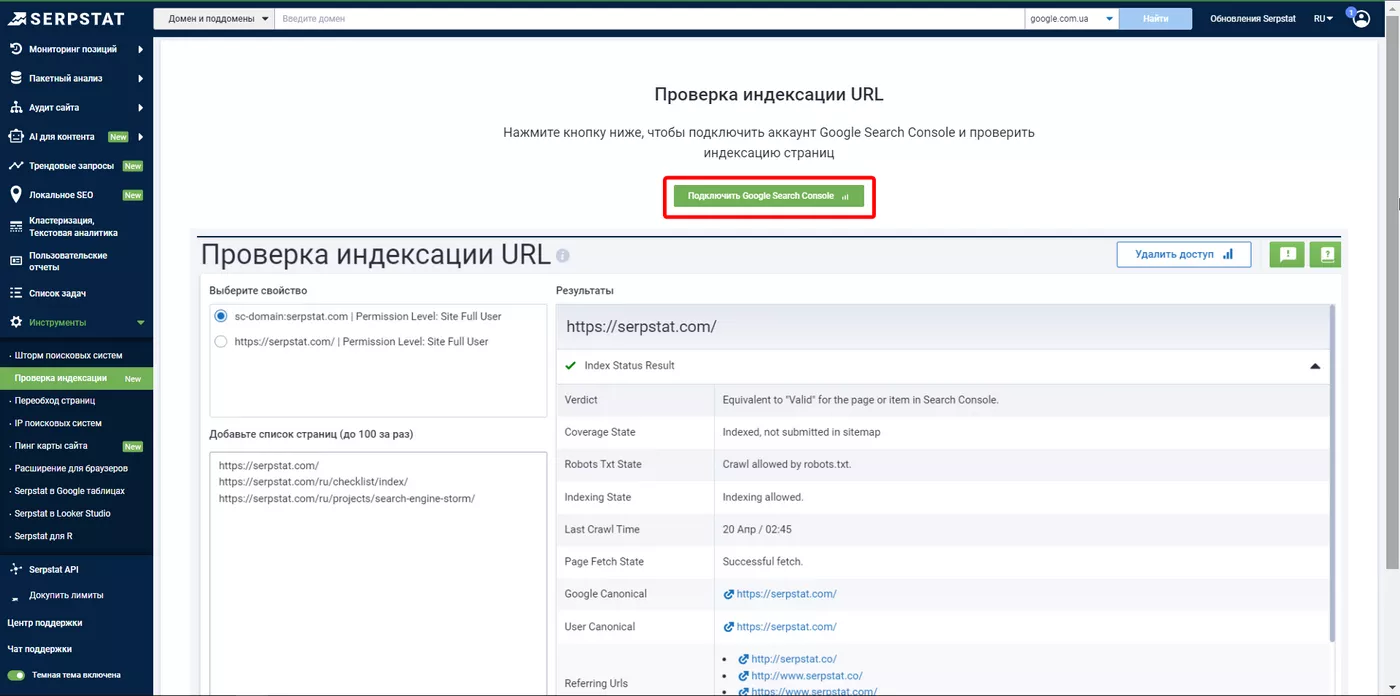

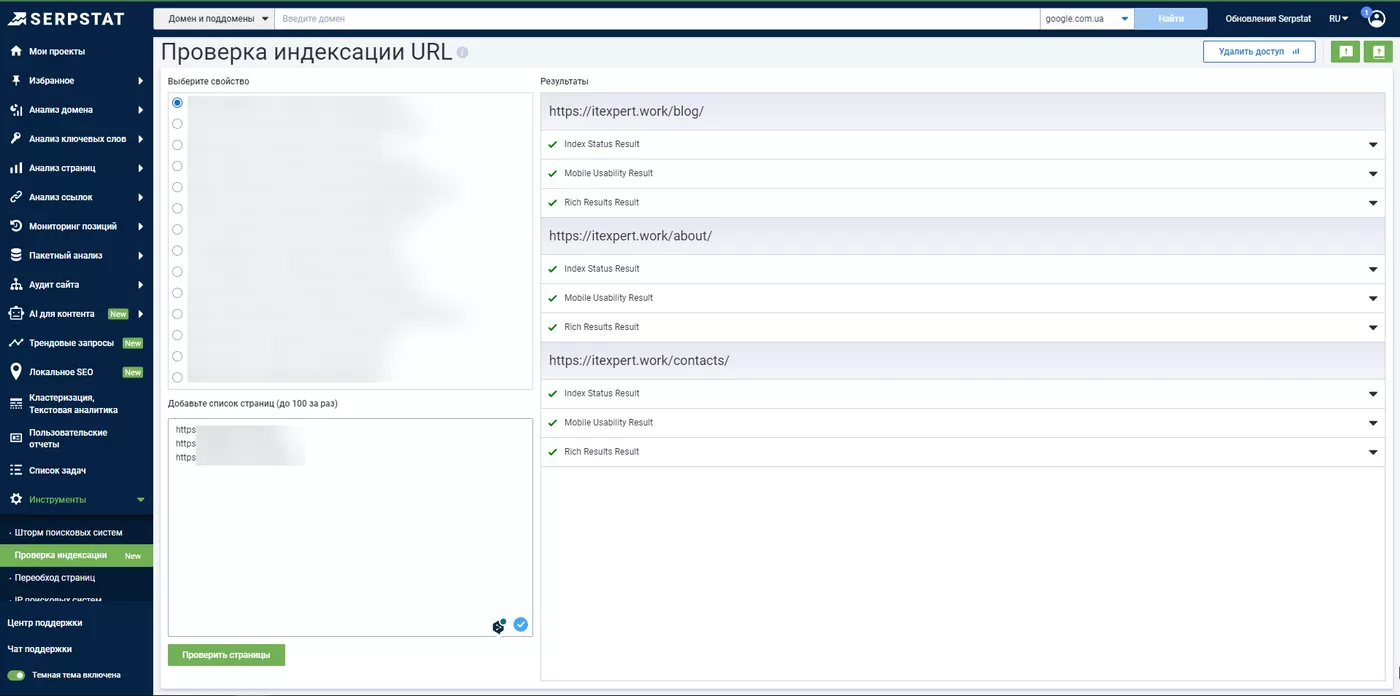

Однако, если ваш сайт подключен к Google Search Console, с помощью нового инструмента от Serpstat можно за один запрос проверить индексацию до 100 страниц.

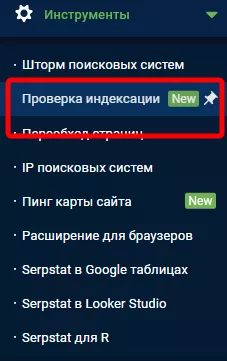

- Перейдите в раздел «Инструменты» и выберите пункт «Индексация страниц»:

- Нажмите кнопку «Подключить Google Search Console» и войдите в сервис с помощью вашего аккаунта Google:

- После авторизации в верхней левой части страницы увидите список всех сайтов, к которым у вас есть доступ с помощью Google Search Console:

- Введите до 100 URL-адресов для проверки индексации сайта и нажмите кнопку «Проверить страницы». В правой части сервиса отобразятся результаты этой операции.

4. SEO-инструменты для проверки сайтов

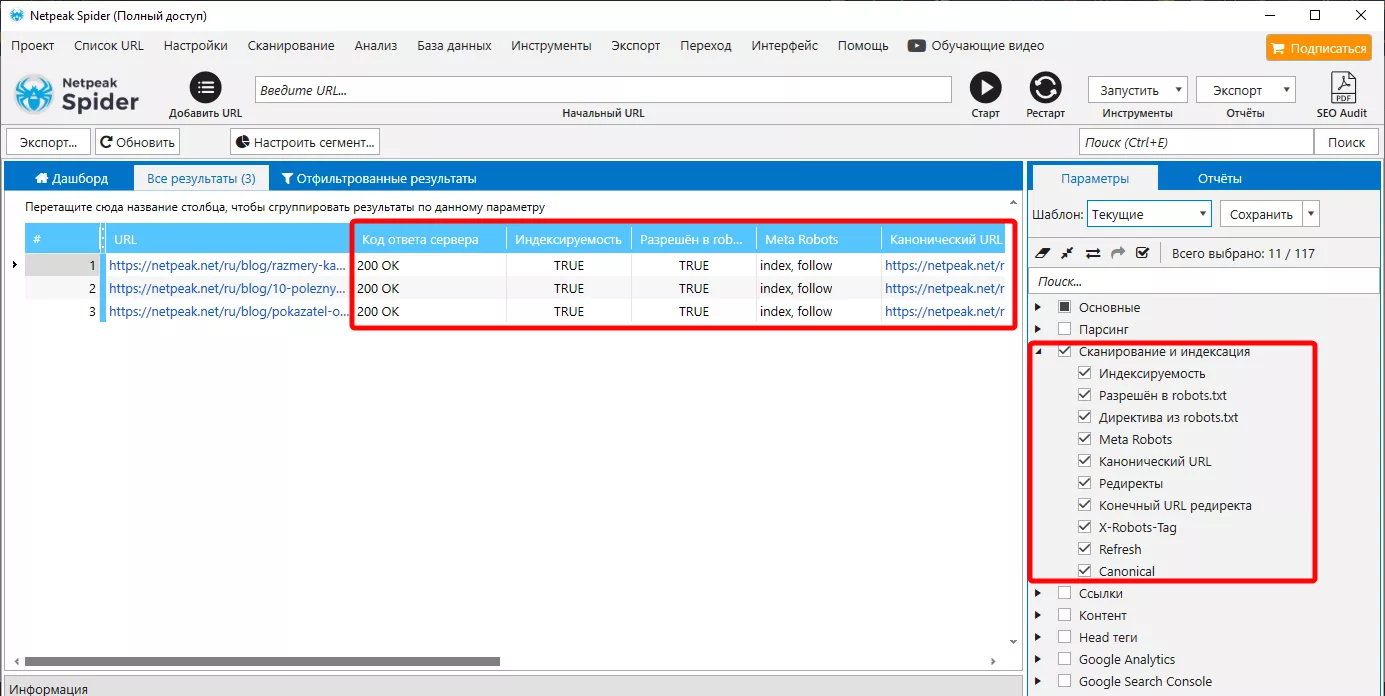

Специальные программы, предназначенные для сканирования и анализа основных параметров сайта с целью выявления ошибок, могут также проверять индексацию.

При сканировании сайта в Netpeak Spider вы получите список страниц и значения параметров, влияющих на индексацию сайта: robots.txt, canonical, mета robots, X-Robots-Tag, наличие редиректов и др.:

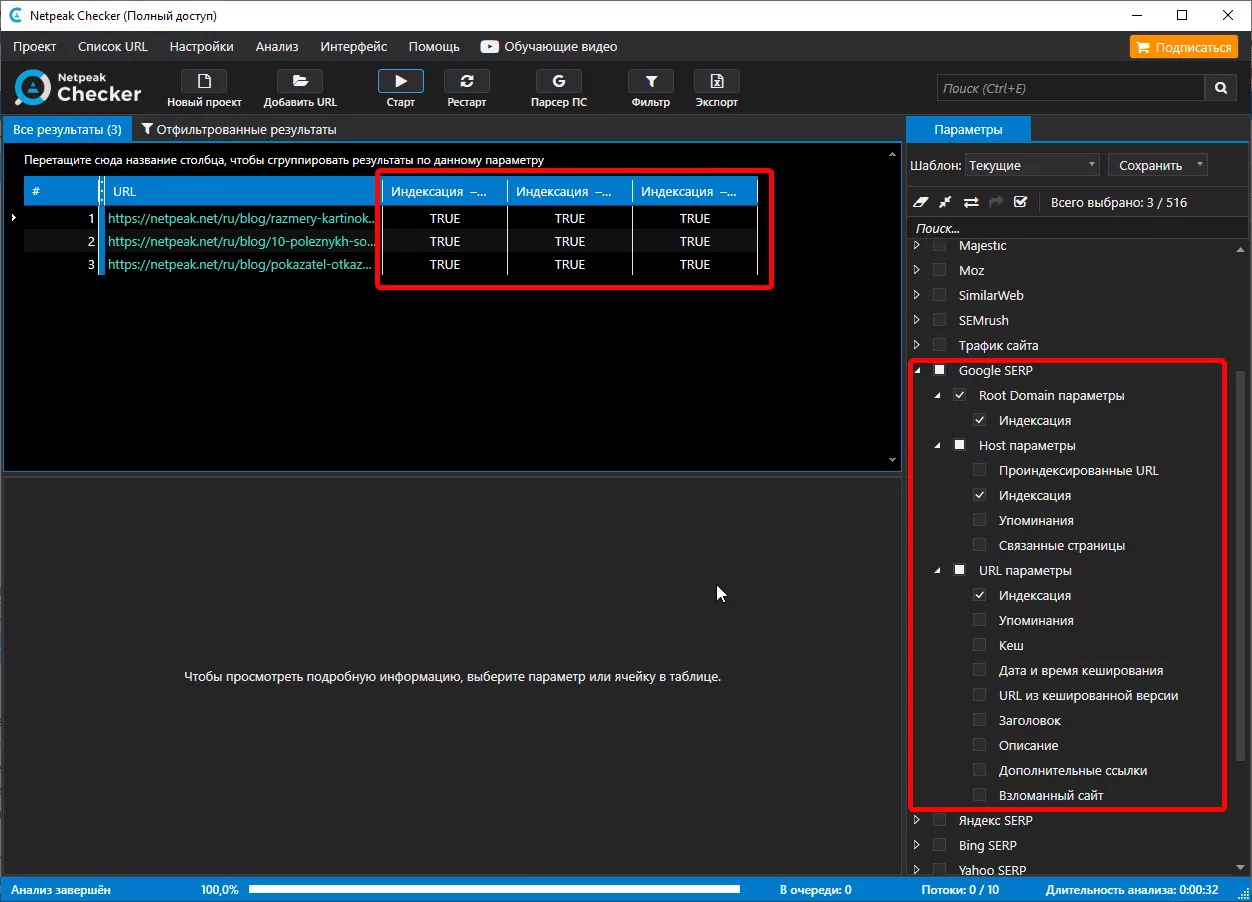

Загрузив полученный список в Netpeak Checker, можно проверить наличие страницы или сайта в поисковой выдаче:

5. Букмарклеты

Букмарклеты (небольшие javascript-программы, сохраняемые как браузерные закладки) — автоматизированный вариант проверки.

Чтобы воспользоваться букмарклетом, откройте файл Проверка индексации и перетяните ссылку на панель закладок:

Затем найдите интересующую вас страницу либо сайт и просто нажмите на закладку. Появится новая вкладка Google с поисковым запросом, использованием уточняющего оператора «site:» и результатами индексации по запросу.

6. Индексатор Google Indexing API

Google Indexing API — бесплатный индексатор от Google, с помощью которого можно:

- узнать, когда последний раз Google получал информацию по запрошенному URL-адресу;

- отправить запрос на переиндексацию страницы;

- отправить запрос на удаление страницы из индекса.

Важным преимуществом Google Indexing API является возможность пакетных запросов индексирования, объединенных в один HTTP (до 100 штук). В день можно использовать не более 200 запросов, но если на ваших страницах внедрена разметка JobPosting или BroadcastEvent — вы можете подать заявку на увеличение квоты.

Подробнее о квотах индексатора и его подключении читайте в справке Google.

Почему Google не индексирует сайт?

- Новый сайт. В зависимости от количества страниц, полная индексация нового сайта может занять у Googlebot от одной недели до 2-4 месяцев.

- Принудительное закрытие страниц от индексации.

Метатег robots

Размещается в HTML коде и действует на уровне страницы. Пример метатега robots, запрещающего сканирование —

<meta name="robots" content="noindex" />

X-Robot-Tag

Является HTTP-заголовком, размещается в файле конфигурации сервера. Пример X-Robot-Tag, запрещающего сканирование —

X-Robots-Tag: noindex, nofollow

Файл robots.txt

С помощью robots.txt невозможно управлять непосредственно индексацией сайта, но неправильная конфигурация этого файла может привести к полному закрытию для сканирования поисковыми роботами.

Строка в robots.txt, полностью закрывающая сайт от сканирования —

User-agent: * Disallow: /

- Неправильное использование тега canonical. Тег canonical применяется для борьбы с дублирующимся контентом, который также может быть одной из причин плохой индексации сайта. Он указывает поисковому роботу на предпочитаемую версию страницы. При сканировании URL-адрес, указанный в теге canonical, будет воспринят Googlebot как основная версия, среди похожих по содержанию страниц.

Помимо настроек, которые напрямую ограничивают или запрещают сканирование сайта, стоит отметить следующие факторы, негативно влияющие на скорость индексации:

- Отсутствие карты сайта sitemap.xml. Она помогает поисковым роботам понять его структуру и быстрее просканировать страницы.

- Отсутствие либо недостаточность внутренних ссылок. Правильная и равномерная перелинковка на сайте распределяет ссылочный вес страниц, а добавление ссылок на новые страницы сайта, а также страницы, которые уже находятся в индексе, помогает поисковым системам быстрее находить их.

- Скорость работы сайта. Googlebot не находится на сайте постоянно. Он лишь периодически сканирует контент его страниц. Медленная скорость загрузки сайта усложняет его индексацию и работу алгоритмов поискового робота.

- Качество контента. Последние обновления поисковой системы Google предполагают улучшение качества контента и создание авторитетных материалов — в первую очередь для людей, а не для манипуляции алгоритмами поиска. При оценке качества контента вашего сайта Google учитывает наличие орфографических ошибок, достоверность информации, оригинальность и другие факторы. Подробнее о создании полезного контента можно узнать в Google-справке.

- Отсутствие оптимизации мобильной версии. Для новых сайтов, созданных после 1 июля 2019 года, Google использует метод индексации Mobile-First index, отдающий предпочтение индексации мобильной версии сайта. Такое решение компании вызвано тем, что уже в 2016 году более половины запросов в Google выполнялись с мобильных устройств.

- Игнорирование ошибок в Google Search Console. Изучите отчет об ошибках в поисковой консоли Google. Посмотрите, какие из найденных ошибок, влияют на индексацию сайта и устраните их. Так же проверьте, не подвергался ли ваш сайт ручным санкциям. Возможно, его доменное имя ранее было ограничено в связи с нарушением правил Google.

Как ускорить индексацию сайта?

Возможности Googlebot по сканированию сайта ограничиваются краулинговым бюджетом — лимитом на проверку страниц за один визит. Узнать приблизительный краулинговый бюджет вашего сайта можно в Search Console (раздел «Индексация») — просмотрите отчет по количеству страниц, обработанных за месяц поисковой системой:

Краулинговый бюджет меняется по заложенному поисковой системой алгоритму: в зависимости от размера сайта, скорости его работы и потребностей. Если обнаружено много ошибок или мусорных страниц, бюджет может расходоваться быстрее.

Факторы, негативно влияющие на краулинговый бюджет:

- дубли страниц;

- неуникальный контент;

- битые ссылки;

- слишком большое количество редиректов;

- медленная скорость работы сайта.

Как управлять краулинговым бюджетом?

Помимо фактического управления краулинговым бюджетом с помощью индексатора Google Index API, уменьшить его расход можно с помощью технической оптимизации и улучшения качества контента.

Файл sitemap.xml.

Проверьте содержимое XML-карты сайта, убедитесь, что все указанные в ней страницы открыты к индексации и отдают код ответа сервера 200, установите автоматические добавление новых страниц (открытых к индексации) в файл sitemap.xml.

Дата изменения страницы.

Настройте HTTP заголовки Last-Modified и If-Modified-Since, чтобы указать Googlebot на страницы, контент которых не изменился с его последнего посещения (они не требуют повторного сканирования).

Оптимизация

Время ответа сервера не должно превышать 200 мс, а скорость загрузки страницы — 3-5 секунд. Проверьте скорость работы сайта с помощью PageSpeed Insights, оптимизируйте страницы исходя из рекомендаций.

Редиректы и битые страницы.

Не допускайте большого количества редиректов и битых страниц на сайте. В противном случае, вместо посещения нового контента, Googlebot будет расходовать свой краулинговый бюджет на переходы по неработающим позициям.

Оптимизация

Добавьте ссылки на новый контент на главную страницу сайта, выведите превью анонса недавних статей, покажите новинки товаров. Организуйте перелинковку между старыми и свежими материалами, разместите ссылки на новые страницы в соцсетях — это поможет поисковому роботу быстрее их найти и просканировать.

Частота обновления сайта.

Поисковые системы отдают предпочтение актуальной и качественной информации. Регулярно обновляйте содержимое своего сайта, добавляйте новый контент не реже, чем раз в неделю, актуализируйте и дополняйте информацию на старых страницах.

Запомнить

Шесть способов самостоятельно проверить индексацию сайта или страницы:

- В Google Search Console.

- С помощью операторов поиска.

- Онлайн-сервисами.

- SEO-инструментами, например, Netpeak Spider или Netpeak Checker.

- Используя букмарклеты.

- Google Indexing API.

Для улучшения индексации сайта:

- Настройте и оптимизируйте карту сайта sitemap.xml.

- Проверьте настройки файла robots.txt и использование тега noindex.

- Следите за количеством редиректов и наличием битых страниц.

- Работайте над перелинковкой сайта.

- Улучшите скорость загрузки страниц.

- Создавайте качественный контент и регулярно работайте над его обновлением и улучшением.

- Оптимизируйте расходование краулингового бюджета.

- Не забывайте о мобильной версии сайта.

- Регулярно изучайте отчеты об ошибках в Google Search Console.

Свежее

AI-поиск и SEO: как бизнесу адаптироваться к новой реальности

Рассказываем, как SEO-специалистам, маркетологам и владельцам бизнеса переосмыслить стратегию продвижения в эпоху развития искусственного интеллекта

Продвижение криптокошелька в Google Ads: как получить сертификацию в 12 странах и привлечь 300 000 пользователей

Возвращение рекламы после блокировки и масштабирования без потерь трафика

Как собрать 4900 контактов и получить 174 лида в сфере производства — кейс B2B Lead Generation для KZS Glass

Масштабирование B2B-коммуникации на европейских рынках