13 неочевидных и практически применимых SEO-фишек — круглый стол 8P 2017

Формат круглого стола, когда спикеры рассказывают мини-кейсы, а зал голосованием выбирает из них лучший, на конференциях Netpeak называется «Неочевидными и практически применимыми фишками».

В 2017 году на конференции 8P таких круглых столов было три. Один был посвящен продвижению интернет-магазинов, другой — продвижению стартапов за рубежом. В этой статье шеф-редактор Netpeak Journal Георгий Рябой рассказывает о третьем круглом столе и озвученных на нем фишках по SEO.

Участниками этого мероприятия были: Тарас Гуща (SEO.UA), Дмитрий Иванов (Иванов SEO), Виктор Карпенко (SeoProfy), Виталий Кравченко (Webline Promotion), Иван Кутас (Netpeak), Дмитрий Мазурян (Tonti Laguna), Олег Саламаха (Serpstat), Владимир Сахаров (SalesDoubler), Виталий Стеценко (Initium Group), Алексей Чекушин (Just-Magic), Дмитрий Шахов (REMARKA).

1. Несколько главных страниц

Общеизвестно, что главную страницу продвигать легче и запросов по главной в поиске всегда больше. Поэтому стоит делать несколько главных страниц. Добавленные размещать на поддоменах. С точки зрения структуры ничего не меняется, но сайт легко выходит в топ. Главное — правильно настроить поддомены.

В одном из кейсов Алексея Чекушина этот метод отлично сработал в нише недвижимости.

Также с помощью нехитрых приемов с URL-адресом можно сделать так, что роботы поисковых систем будут видеть несколько главных страниц. Для «создания» второй главной страницы следует поставить ссылку на нее с помощью «/#» и canonical. Так роботы увидят оба анкора.

Этот метод также применяется, когда со страницы A нужно поставить две и больше ссылки на страницу Б.

2. Быстрая индексация новых страниц

Если ежедневно на сайте появляется по 100-200 новых страниц, для более быстрого попадания в индекс достаточно разместить их в футере главной страницы. В качестве анкоров следует брать тайтлы страниц.

По словам Дмитрия Шахова, Google к такому методу с условным названием «в поддон навалили» относится вполне терпимо.

3. Ускоряем индексацию с помощью браузеров

Во-первых, для автоматизации процесса (если страниц много), следует установить расширение iMacros. Во-вторых, следует открыть Chrome и массово загнать новые страницы в iMacros — чтобы программа сама открывала их в Chrome. Так страницы быстрее попадут в индекс Google.

Для Яндекса действует аналогичное решение через Яндекс.Браузер.

4. Секундомер с обратным отсчетом времени до понижения цены

На странице с описанием товара или текстом устанавливать секундомер, который каждые N секунд показывает понижение цены товара на определенную сумму. Второй вариант реализации секундомера — настроить его так, чтобы на табло показывалось, сколько секунд осталось до понижения цены на товар. При этом, конечно, цена зафиксирована и ниже определенного порога никогда не опустится.

Метод отлично работает для улучшения поведенческих факторов сайта.

Больше идей по улучшению поведенческих факторов ищите в

5. Как обмануть Минусинск от Яндекса

Интересный факт: под фильтр Минусинск не попадают сайты, которые проставляют ссылки на картинки. Даже в достаточно большом количестве. В частности, на картинках сейчас хорошо работают дорвеи.

6. Размещаем «хлебные крошки» в разных местах страницы

Чтобы повысить релевантность, в первый элемент хлебной крошки можно вставить запросы главной страницы.

Если не получается изменить главные хлебные крошки, можно вставить еще одни хлебные крошки внизу страницы. Но URL ссылки не должен дублироваться на одной странице. Чтобы этого избежать, можно добавить хеш к URL или вставить ссылку, для которой канонической является нужная страница.

7. Как победить текучку в отделе арбитража трафика

Часто, освоив все необходимые технологии, сотрудники из отдела арбитража трафика просто увольняются, так как понимают, что выгоднее работать дома. В качестве варианта решения вопроса — позволить сотрудникам пить пиво на рабочем месте.

Отвечаю на немой вопрос: да, эту фишку признали новой и полезной для своих компаний более 150 человек в зале.

8. Анализируем конкурентов с помощью фейковых заказов

Часто заказы из интернет-магазинов приходят со сквозным номером. Сделав фейковый заказ в начале и в конце месяца, можно подсчитать, сколько продаж было у конкурента.

На Западе все еще проще — при заказе на сайте европейские магазины обязаны высылать инвойсы со сквозным номером заказа.

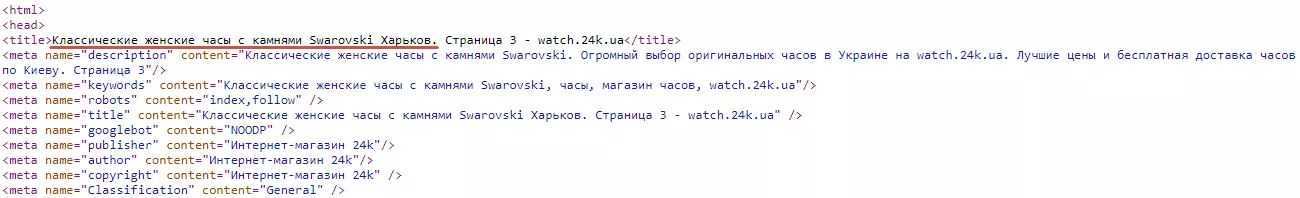

9. Оптимизируем метатеги на страницах пагинации для региональной выдачи

Обычно страницы пагинации не оптимизируют, или оптимизируют автоматически — при этом проставляются такие же метатеги, как у главной страницы, плюс «_ страница 2». Но если сайт интернет-магазина ориентируется на продажи в нескольких городах, страницы пагинации можно оптимизировать под каждый из них, проставляя артикулы нужных топонимов в тайтле и метатегах. Например, вторую страницу пагинации оптимизируем под Чернигов, третью под Полтаву и так далее.

На этом сайте можно посмотреть, как на отдельных страницах пагинации оптимизированы тайтлы.

10. Используем бренд и слова «официальный сайт» в метатегах

Если интернет-магазин — просто дистрибьютор, а не официальный сайт бренда, возникает вопрос охвата запросов вроде «телефон Xiaomi официальный сайт». Для этого в метатегах сайта (и на агрегаторах) можно прописать «Официальный сайт Xiaomi — [название сайта или бренда]». Ту же операцию стоит проделать с тайтлом карточки товара.

То есть никто не претендует на звание официального сайта, а нужные ключевые слова расставлены.

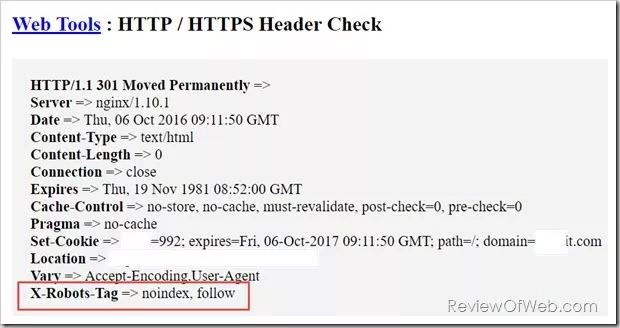

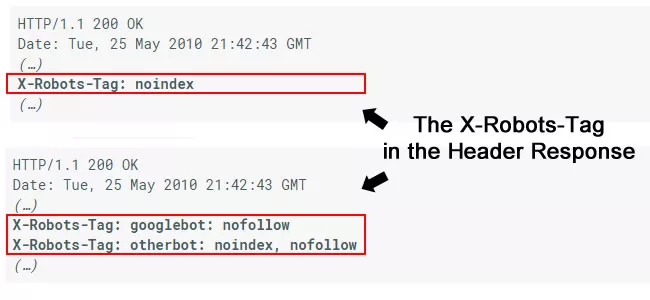

11. Проверяем, не насолил ли предыдущий подрядчик

Обычно страницы от индексации закрывают в robots.txt, метатегом noindex, или же используют атрибут rel=canonical. Но страницу можно также закрыть в http-заголовках (кодах ответа сервера). Для этого используют тег x-robots-tag http header.

Как это выглядит:

Посмотреть наличие или отсутствие этого тега можно только с использованием специальных плагинов или сервисов, например, Http Headers. Из-за того, что тег редко используют, недовольный подрядчик может закрыть сайт бывшего клиента, и тот потом не будет знать, почему сайт не индексируется.

Google предлагает отдельную инструкцию по использованию данного тега.

12. Как быстро найти ошибки на сайте

Например, программист случайно закрыл важные страницы от индексации с помощью <meta name='robots' content='noindex'>.

Мы устанавливаем скрипт в Google Tag Manager, который проверяет meta robots на нужных нам страницах (страницы задаем в триггерах). Если скрипт обнаруживает noindex, то шлет url и время обнаружения в таблицу Google или другую выбранную базу данных.

В таблице Google, куда отправляются данные, есть скрипт, который по расписанию (например, раз в час) проверяет наличие url. Если данные появились, шлет на почту предупреждение.

Читайте подробно о том,

13. Учим родных покупать трафик

Об одном нестандартном методе борьбы с текучкой в отделе арбитража трафика мы уже рассказали. Второй способ — научить родных основам медиабаинга. По словам одного из спикеров круглого стола: «У меня мама зарабатывает на арбитраже $5 000 в день».

Ваши сотрудники никуда не денутся, если они — ваша семья.

Да, этот метод также оказался новым и практически применимым для более чем половины участников круглого стола.

P.S.: Надеюсь, здоровое чувство юмора, которое всегда присуще читателям блога, поможет отличить обязательные для внедрения в своем бизнесе фишки от ироничных. Все-таки конференция проходила в Одессе.

Свежее

Что такое домен верхнего уровня (TLD)

Вы получите шпаргалку, по которой правильно выберете доменное имя и не допустите коварных ошибок. А также узнаете, где купить ценные и известные TLD

Как настроить специальные параметры в Google Analytics 4: пошаговая инструкция

Когда необходимо получить дополнительные данные стоит настроить специальные параметры и показатели

Чувствуете на себе влияние презентеизма? Исследование редакции Netpeak Journal

Ответьте на несколько вопросов, чтобы внести вклад в исследование этой важной темы.