Как провести SEO-анализ сайта: пошаговые методы и полезные инструменты

Анализ сайта — это регулярная проверка того, как работает ваш ресурс. Он показывает, насколько удобно пользователям находить нужную информацию, как быстро загружаются страницы и что мешает им попасть в верхние строки поиска.

SEO-анализ использует факты о поведении посетителей, технические ошибки, скорость, содержание и т. д. и не строит случайные теории. Он нужен всем: владельцам бизнеса, маркетологам и даже новичкам, которые только неделю назад запустили первый сайт.

Анализ vs аудит: в чем разница

Анализ сайта дает общее понимание, как сейчас работает ресурс и как его можно улучшить. Он изучает отдельные показатели: трафик, поведение пользователей, видимость в поиске, контент и т. д. В результате вы четко видите текущую ситуацию: где сайт растет, что в нем хромает, какие страницы работают лучше.

Анализ предполагает регулярность: ежедневно, еженедельно или ежемесячно. Для автоматизации рутины используют SEO-инструменты.

Похожий, но не тождественный процесс — аудит. Это глубокое и системное исследование, которое не просто считает метрики, но и разбирается в проблемах и пытается их решить. Аудит — скорее разовая проверка, его проводят раз в год или для того, чтобы найти причины конкретной проблемы. SEO-аудит в результате предоставляет подробный отчет и рекомендации: что исправить, как оптимизировать, что сделать в первую очередь.

Сегодня я рассмотрю, как сделать анализ сайта онлайн, даже если вы новичок в этом вопросе. Это простой, эффективный и вполне доступный для всех способ узнать, как работает ваш ресурс.

Качественный SEO-анализ сайта не может быть поверхностным. Обычно он касается нескольких направлений одновременно, а ваша задача — сопоставить информацию и сделать выводы.

|

Направление |

Что проверяется |

Как использовать информацию |

|

Техническое состояние |

Индексация страниц, битые ссылки, редиректы, корректность файлов sitemap.xml и robots.txt |

Определить, доступен ли ресурс для пользователей поисковых систем, нет ли критических сбоев |

|

Структура |

Логичность иерархии страниц, глубина вложенности, удобство навигации, наличие внутренних ссылок |

Сделать структуру сайта более понятной для пользователей и поисковых систем: убрать «потерянные» страницы, улучшить навигацию, чтобы люди быстрее находили нужную страницу |

|

Контент |

Уникальность, релевантность ключевым запросам, читабельность, структура заголовков (H1–H6), наличие метатегов |

Повышать качество контента, привлечь больше пользователей и улучшить видимость в поиске |

|

Скорость |

Скорость загрузки сайта, Core Web Vitals (LCP, INP, CLS) |

Улучшать пользовательский опыт и уменьшать показатель количества отказов |

|

Микроразметка |

Структурированность данных и их виды |

Увеличивать CTR в поиске, влиять на то, как поисковые системы воспринимают страницы |

|

Внешние факторы |

Количество и качество обратных ссылок, авторитетность доноров |

Стратегически формировать авторитетность сайта и улучшать его позиции в выдаче |

|

Поведенческие показатели |

Время на сайте, показатель отказов, клики, удержание пользователей |

Находить проблемные страницы, оптимизировать взаимодействие между пользователями и сайтом |

|

Мобильность |

Адаптивность дизайна, скорость мобильной версии |

Улучшать опыт пользователей, которые заходят со смартфона или планшета |

|

Безопасность |

SSL-сертификат (HTTPS), вредоносный код |

Улучшать безопасность данных пользователей и укреплять доверие к сайту |

Анализ ресурса предполагает комплексный подход. Вы можете создавать уникальный контент с экспертными знаниями и эксклюзивными примерами, но никто его не увидит, если страница не индексируется. Далее рассмотрю подробнее каждый этап.

Технический анализ: состояние, доступность, поисковая видимость

Технический анализ показывает, как поисковые системы (ПС) видят сайт: могут ли они его сканировать, индексировать и не возникают ли технические барьеры. В целом индексация нужна для того, чтобы страницы появлялись в поисковой выдаче. Если страница не попала в индекс, ее фактически нет для пользователей Google.

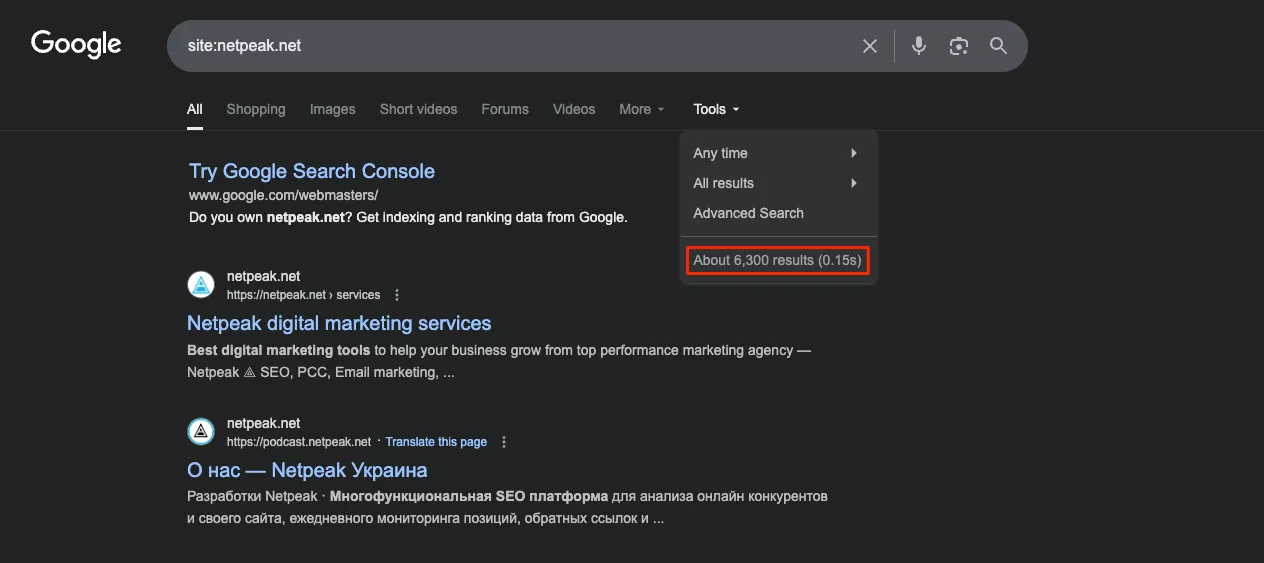

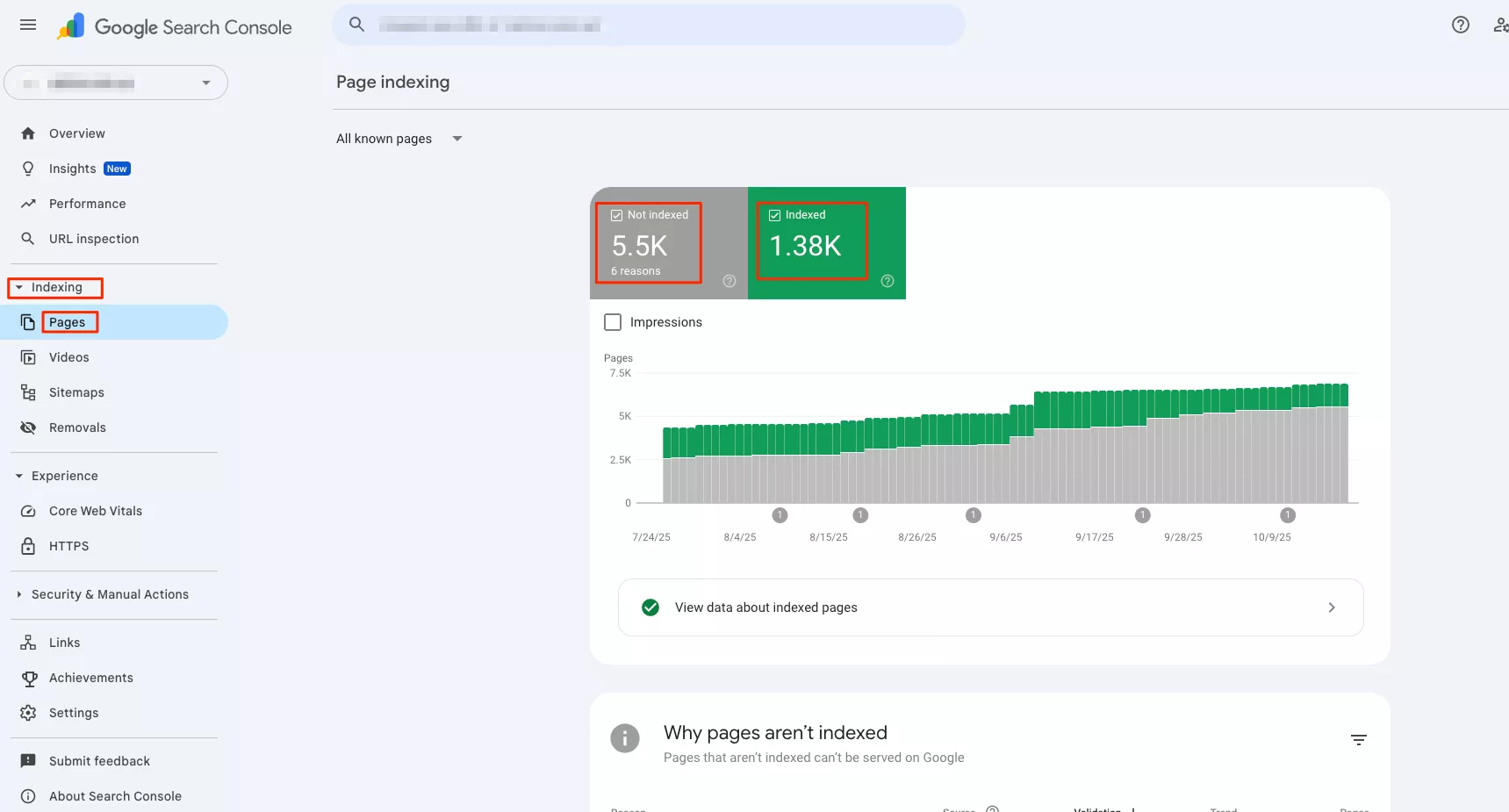

Проверку индексации можно начать с поискового оператора «site:» в Google: он показывает, что уже есть в индексе. Таким образом, вы не узнаете, какие URL отсутствуют и почему — этот инструмент стоит использовать только как ориентировочный.

Для точных данных нужен Google Search Console (GSC). Но учтите, что доступ к аналитике есть только у владельцев сайта, проверить таким образом конкурентов не удастся. В меню «Indexing — Pages» доступна информация о том, какие URL проиндексированы, какие исключены и по какой причине. Также видна дата последнего сканирования и учтены ли страницы из sitemap.

Если страница не проиндексирована, нужно искать технические причины. На этом этапе требуется диагностика HTTP-статусов. Для сканирования используются специальные программы, или краулеры. В частности, они фиксируют ответы сервера: 200, 301, 404, 500. Распространенные технические проблемы:

-

robots.txt блокирует важные страницы sitemap.xml;

-

в sitemap.xml остались URL с noindex, редиректами или 404;

-

есть дубликаты через http/https и www/non-www;

-

не настроены canonical-теги;

-

страницы расположены слишком глубоко в структуре.

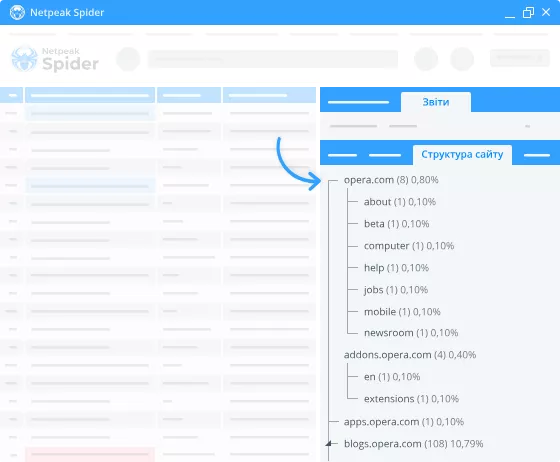

Для быстрого базового анализа подходит программа Netpeak Spider, она имеет готовые пресеты и удобный интуитивный интерфейс. Веб-сканер Screaming Frog предлагает широкие возможности для разработчиков и детальную визуализацию структуры.

Подобный анализ помогает выявить технические ошибки. Далее вы уже можете удалять неправильные URL, настраивать редиректы, устранять серверные ошибки и т. д., чтобы сайт работал без проблем.

Читайте також:

Анализ структуры сайта

Иерархию контента нужно строить так, чтобы пользователь мог легко добраться до ключевых страниц — обычно не более чем за четыре клика от главной. Оптимальная архитектура предусматривает достаточное количество внутренних ссылок для передачи авторитетности от главной страницы к важным разделам. Так вы облегчите процесс сканирования.

Меню должно оставаться понятным для людей. В интернет-магазине оно подстроено под категории товаров, в медиа основано на тематических рубриках, а на корпоративных сайтах содержит услуги. Стандартная внутренняя навигация состоит из хлебных крошек (breadcrumbs), фильтров, сопутствующих разделов и рекомендуемых материалов.

В крупных проектах плоская структура перегружает меню, глубокая — затрудняет доступ к контенту. К примеру, логическая иерархия в магазине электроники такая: «Главная — Ноутбуки — Игровые ноутбуки — Конкретная модель». В то же время для фасетной навигации при анализе страниц сайта (фильтры по бренду, цене, характеристикам) нужно настроить canonical-теги и параметры URL так, чтобы контент не дублировался.

Внутренняя перелинковка распределяет авторитет между страницами и помогает ПС выявлять важный контент. Что это означает на практике? Если на страницу «Услуги SEO-аудита» ведет 50 внутренних ссылок, а на «Контакты» — только пять, Google поймет: первая важнее.

Критически важные страницы должны получать больше всего внутренних ссылок с релевантным контекстом.

Для этого нужно добавлять анкоры с конкретными словами, которые описывают целевую страницу (например, не «читать здесь», а «заказать услуги SEO»). Netpeak Spider и Screaming Frog показывают карту сайта с глубиной вложенности и распределением внутренних ссылок. При необходимости проблемные URL можно добавить в меню, блоки рекомендаций или создавать на них релевантные внутренние ссылки из других разделов.

Контент-анализ: уникальность, оптимизация, релевантность

Качество контента измеряется прежде всего его уникальностью. Технически это касается дубликатов внутри сайта и на внешних ресурсах. С помощью DupliChecker и Grammarly можно найти совпадения с чужими текстами. А Netpeak Spider автоматически находит страницы с идентичными title, description или H1 на вашем же ресурсе — такое часто встречается на фильтрованных страницах интернет-магазинов.

Сам текст нужно строить по логике ПС:

-

заголовок H1 — содержит основной ключ;

-

H2–H6 — раскрывают тему через семантически связанные запросы;

-

списки и таблицы — улучшают читабельность;

-

логическая структура — увеличивает шансы попасть в блок расширенных результатов;

-

объем контента — определяется глубиной раскрытия темы и целью запроса.

Контент-анализ сайта предполагает изучение конкурентов, а точнее — статей, попавших в десятку лучших. Так вы можете определиться с объемом своих текстов: информационные статьи обычно детализируют, а коммерческие страницы могут быть более лаконичными.

Инструменты также анализируют метатеги с учетом On-Page SEO — оптимизации элементов на самой странице. Для быстрой проверки метатегов на нескольких страницах можно использовать браузерное расширение SEO META in 1 CLICK: оно показывает title, description, заголовки и другие теги прямо на странице. Если нужно проанализировать весь сайт, используйте программы (Screaming Frog, Netpeak Spider), а они уже среди прочего заметят и метатеги.

Оптимальные показатели:

-

title — до 60 символов, содержит ключевой запрос;

-

description — до 160 символов, описывает страницу;

-

контент — естественный читабельный вид, отсутствие переспама (чрезмерной повторяемости ключей).

Спам можно проверять через сервисы для семантического анализа текста — у каждого из них свои метрики и нормы. Сам контент должен соответствовать целям пользователя. Если человек ищет «как убрать царапину с экрана телефона», ему нужна пошаговая инструкция, а не каталог защитных покрытий. Когда страница не соответствует ожиданиям посетителя, он быстро ее покидает — и Google это замечает.

К тому же Google Helpful Content Update усилил акцент на принципах EEAT. Особенно критичны принципы EEAT для так называемых YMYL-тематик (Your Money or Your Life): финансы, здоровье, юридические вопросы и т. д., где неправильная информация может навредить человеку.

Качественный контент должен быть релевантным запросу пользователя, уникальным (не скопированным из других источников), фактологически правдивым и подтвержденным ссылками на авторитетные источники. Если вы пишете о сложных темах, лучше указывать автора с реальной квалификацией и добавлять источники, на которых можно проверить информацию.

Читайте также:

Скорость загрузки

Скорость загрузки сайта — это время между тем, как человек перешел на ресурс, и тем, как он полностью загрузился. Если страница долго загружается, пользователи уходят. Сам Google оценивает производительность сайта по метрикам Core Web Vitals:

-

LCP — скорость отображения самого большого элемента на экране (желаемый результат — < 2,5 с);

-

INP — скорость реакции сайта на действия пользователей, в частности, клики (в идеале < 200 мс);

-

CLS — отсутствие неожиданных сдвигов контента (хорошо, если < 0,1).

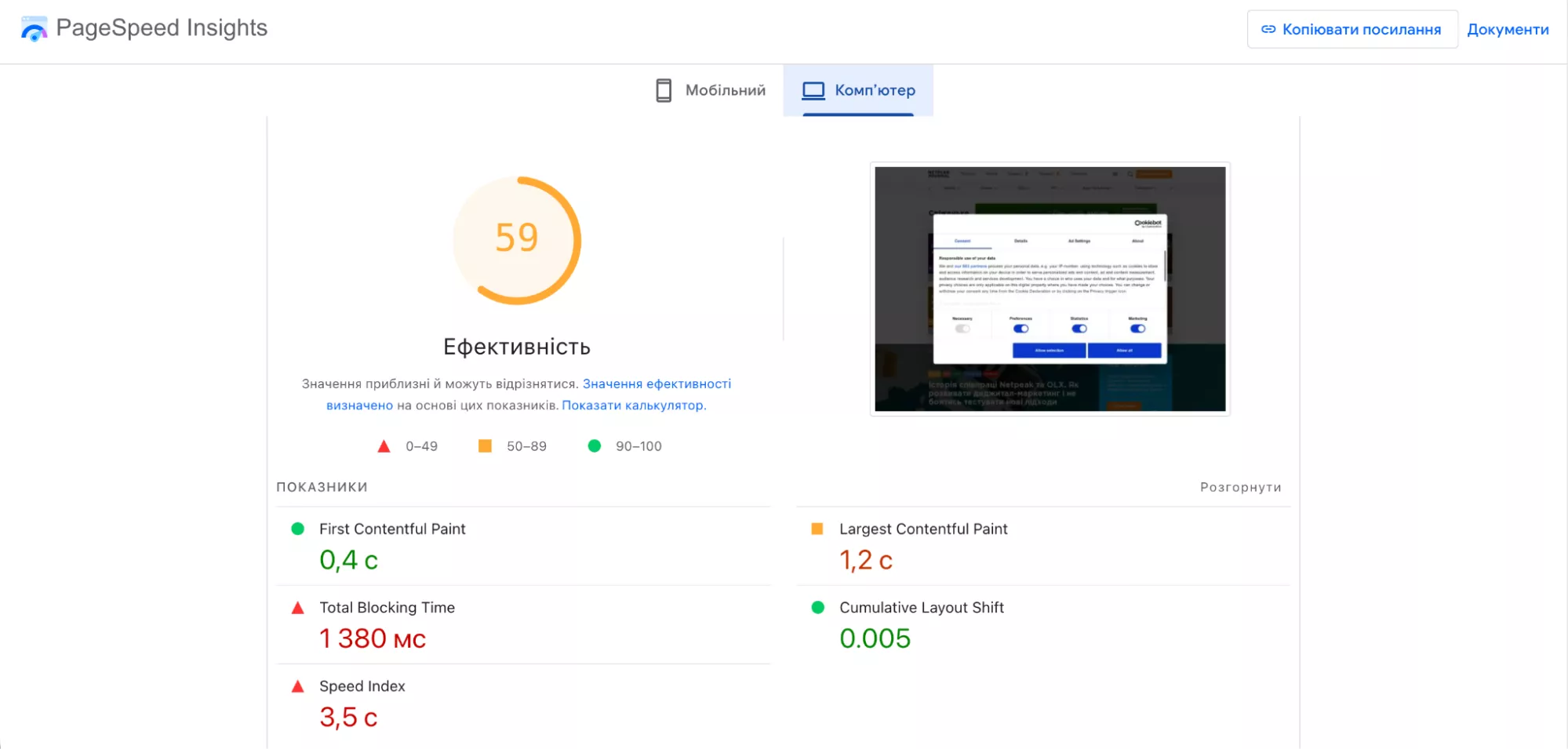

Интересно, что метрику INP можно измерить только полевыми результатами, то есть по реальным данным пользователей, а не с помощью лабораторных методов. Для этого часто используют PageSpeed Insights от Google.

Проверить скорость загрузки можно через несколько сервисов. В таблице я сравнил основные из них, чтобы вы могли выбрать оптимальный инструмент под свои задачи.

|

Netpeak Checker |

Google PageSpeed Insights |

GTmetrix |

WebPageTest |

|

|

Тип анализа |

Массовая или выборочная проверка всех страниц сайта |

Оценка скорости с рекомендациями |

Подробный технический анализ этапов загрузки |

Тест с настройкой параметров |

|

Гибкость тестирования |

Локально или с одного сервера |

Фиксированная среда Google |

Выбор локации сервера |

Выбор браузера, устройства, скорости, региона |

|

Уровень детализации |

Высокий |

Средний |

Высокий |

Высокий |

|

Интерфейс |

Ориентирован на SEO-специалистов, но интуитивно понятен |

Интуитивно понятный |

Интуитивно понятный |

Ориентирован на SEO-специалистов |

|

Основное преимущество |

Массовый анализ большого сайта |

Быстрая оценка от Google |

Сравнение из разных регионов |

Симуляция реальной загрузки |

|

Для чего подходит |

Поиск медленных разделов крупных проектов |

Быстрая диагностика |

Технический анализ страницы |

Тест производительности |

Стратегический анализ эффективности сайта может включать сразу несколько инструментов. Для быстрой диагностики лучше воспользоваться Google PageSpeed Insights. Он покажет основные показатели Core Web Vitals на основе реальных данных пользователей и даст оценку эффективности: 0–49 — критично, 50–89 — есть резерв для улучшения, 90–100 — отлично. Далее инструмент показывает конкретные проблемы и советы. Например, он может предложить уменьшить код JavaScript, который вы не используете.

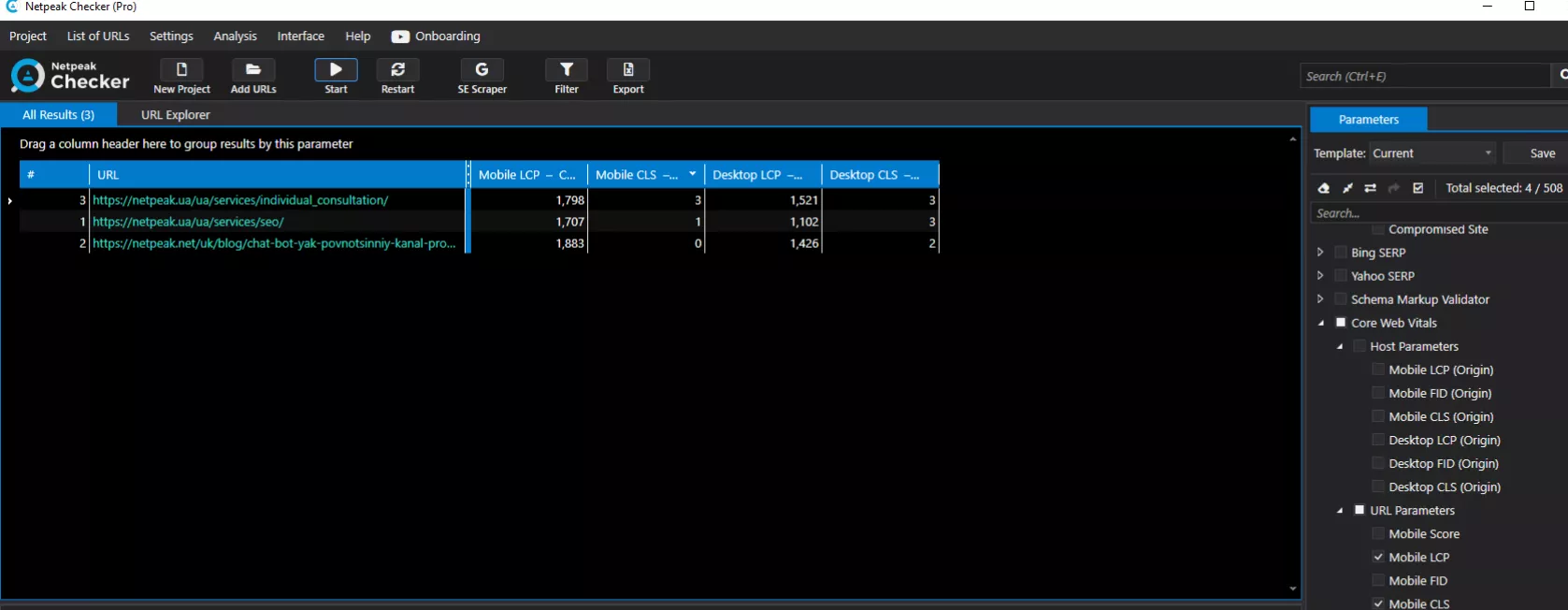

Если сайт большой, запустите проверку через Netpeak Checker. Здесь загрузите список необходимых URL (из Sitemap или GSC) и включите анализ. Инструмент автоматически проверит скорость каждой страницы и покажет результаты в таблице.

Отфильтруйте URL с оценкой ниже 50 — это те, которые тормозят больше всего и требуют оптимизации. Так вы быстро найдете проблемные разделы (например, категории товаров со сложными фильтрами).

При анализе сайта массовую проверку абсолютно всех страниц используют редко — это долго и не всегда нужно. Достаточно выбрать репрезентативную выборку: главная, около пяти категорий, карточки товаров разных типов, страницы блога. Также желательно проверять скорость версии для десктопа и мобильных отдельно. Затем все показатели сравниваются в формате таблицы.

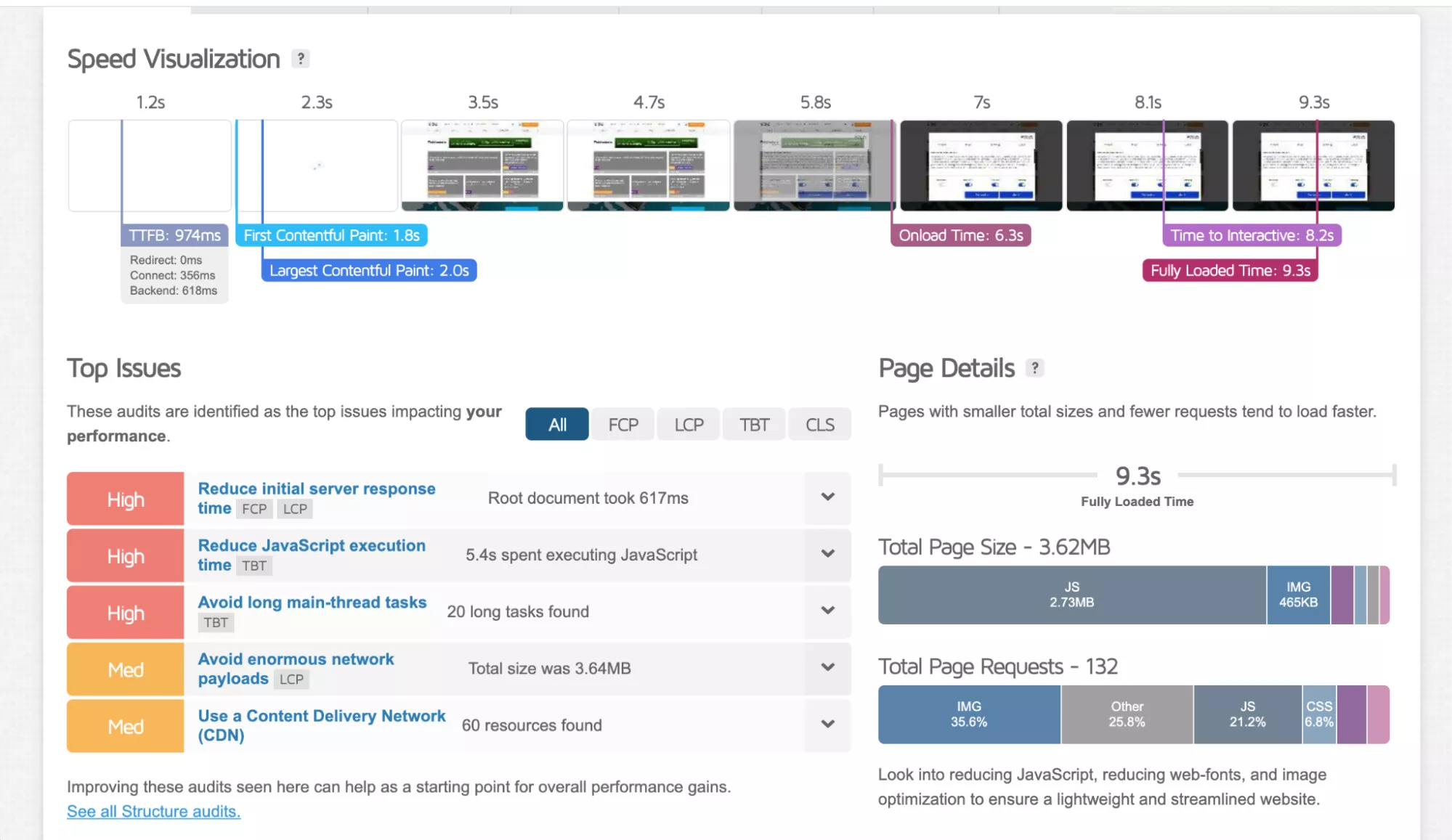

Для детального анализа можно использовать GTmetrix. Инструмент выдает большой отчет. Логика проста: зеленый цвет — «хорошо», красный — «есть проблемы». Удобно, что здесь везде есть пометка «?», за которой скрывается подробное объяснение метрики.

Speed Visualization показывает, как работает ваш сайт во время загрузки. На вкладке Performance еще больше метрик, выделю несколько из них:

-

Largest Contentful Paint (LCP) — время загрузки самого большого элемента на странице (изображение, блок текста и т. д.). Улучшается оптимизацией изображений и видео.

-

Total Blocking Time (TBT) — время, в течение которого скрипты блокируют основной поток браузера во время загрузки. Оптимальный результат — до 150 мс. Уменьшается оптимизацией JavaScript.

-

Cumulative Layout Shift (CLS) — показывает, насколько элементы смещаются во время загрузки страницы. Уменьшается указанием размеров медиа, избеганием резких вставок рекламы, виджетов и iframe.

-

Time to First Byte (TTFB) — время до получения первого байта ответа от сервера. Улучшается оптимизацией редиректов, подключения и формирования страницы.

В разделе Top Issues собраны советы, как улучшить эффективность вашего ресурса — здесь можно больше узнать о других метриках.

Регулярная проверка скорости помогает удерживать пользователей и поддерживать позиции в выдаче. Комбинируйте инструменты в зависимости от задачи: PageSpeed Insights для быстрой оценки, Netpeak Checker для выборочного или массового анализа, GTmetrix для поиска конкретных проблем. Исправляйте критические ошибки последовательно — улучшение скорости даже до двух секунд может снизить количество отказов и увеличить конверсию.

Проверка микроразметки и структурированных данных

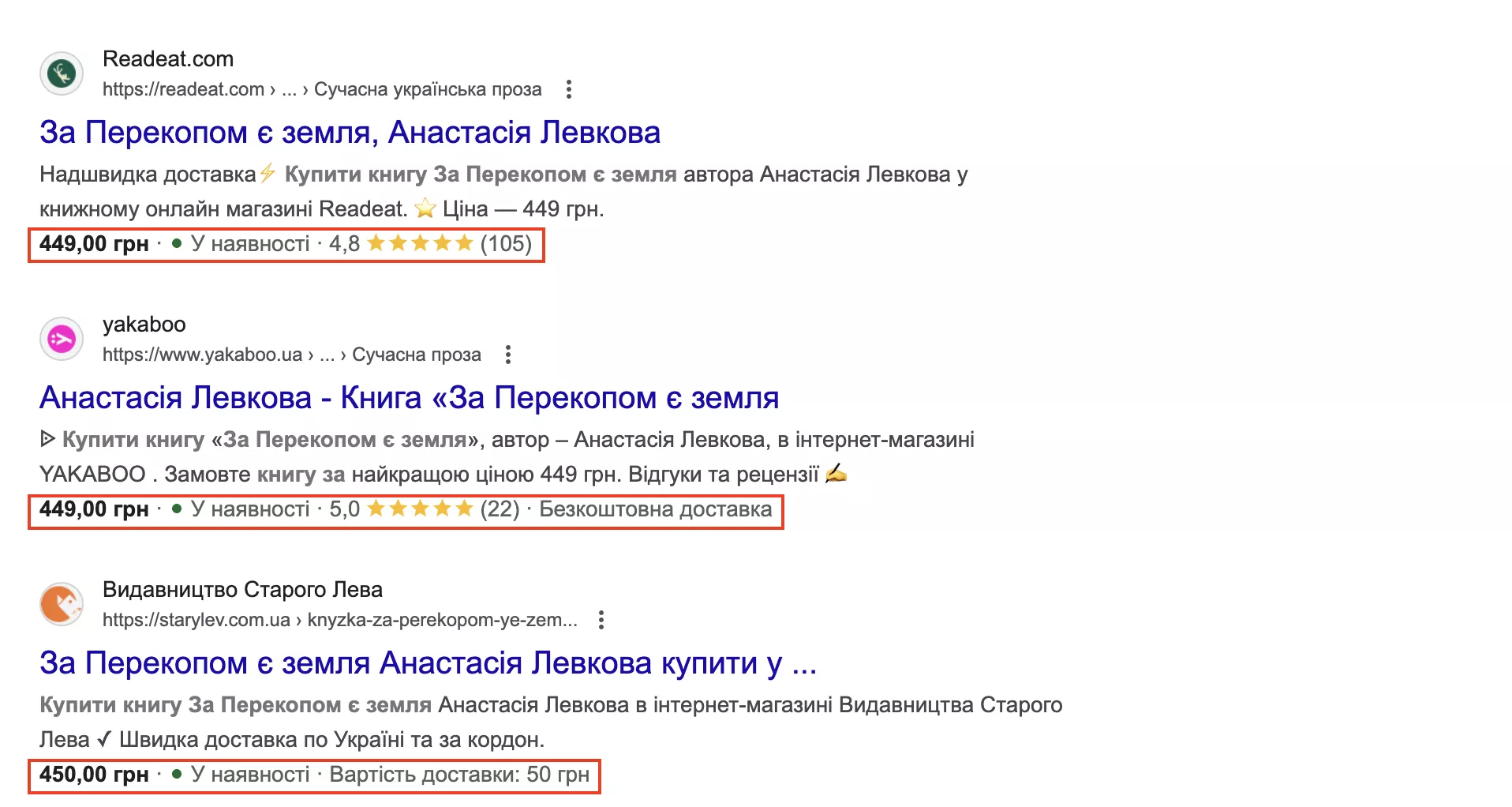

Микроразметка — это специальный код на странице, который помогает Google понять, что именно вы описываете: товар, рецепт, статью, организацию и т. д. Благодаря этому в выдаче могут появляться расширенные результаты (rich results): звезды рейтинга, цена и наличие товара, FAQ-блоки и т. д. Такие снипеты привлекают больше внимания и увеличивают кликабельность.

Google рекомендует использовать JSON-LD — это отдельный блок кода в <script>, который не вмешивается в видимую HTML-структуру. Его проще добавлять и редактировать, чем старые форматы (Microdata или RDFa), требующие изменений во всем коде.

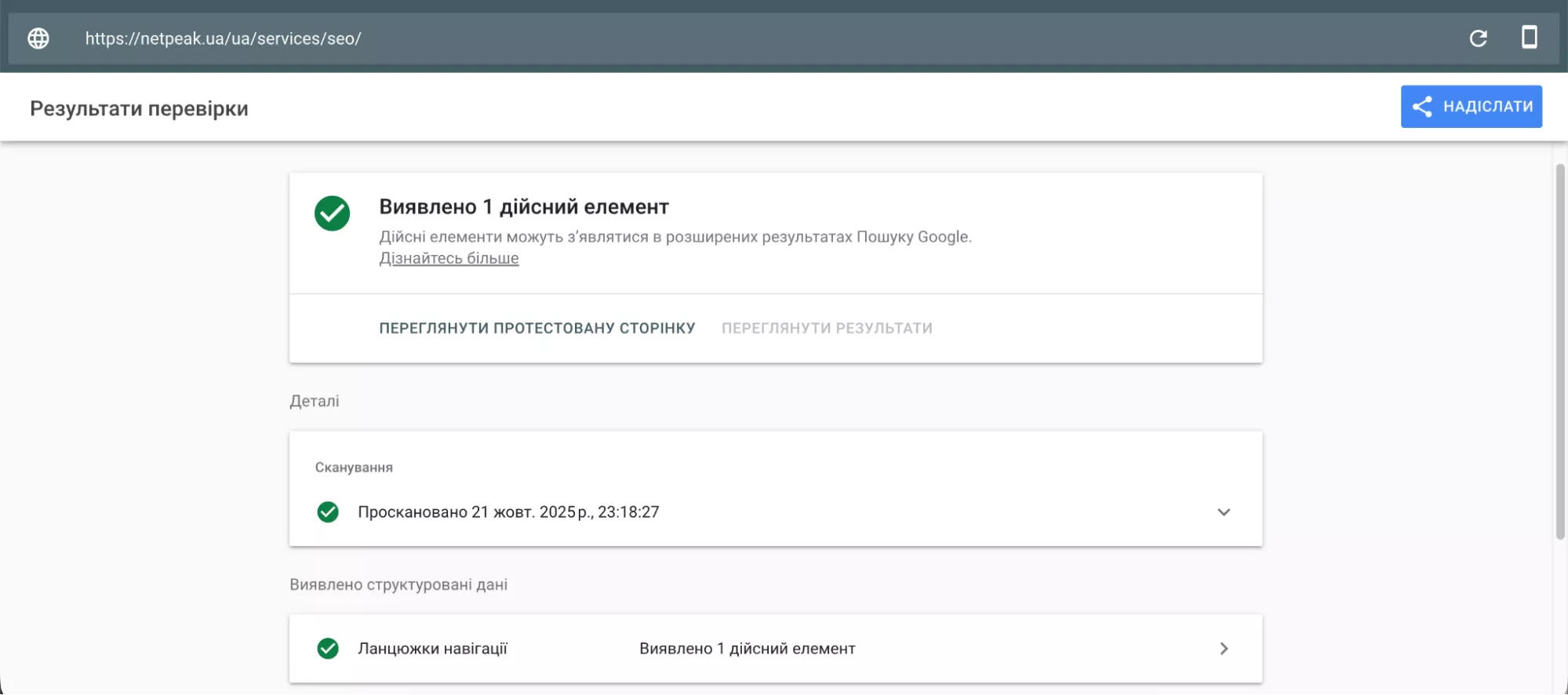

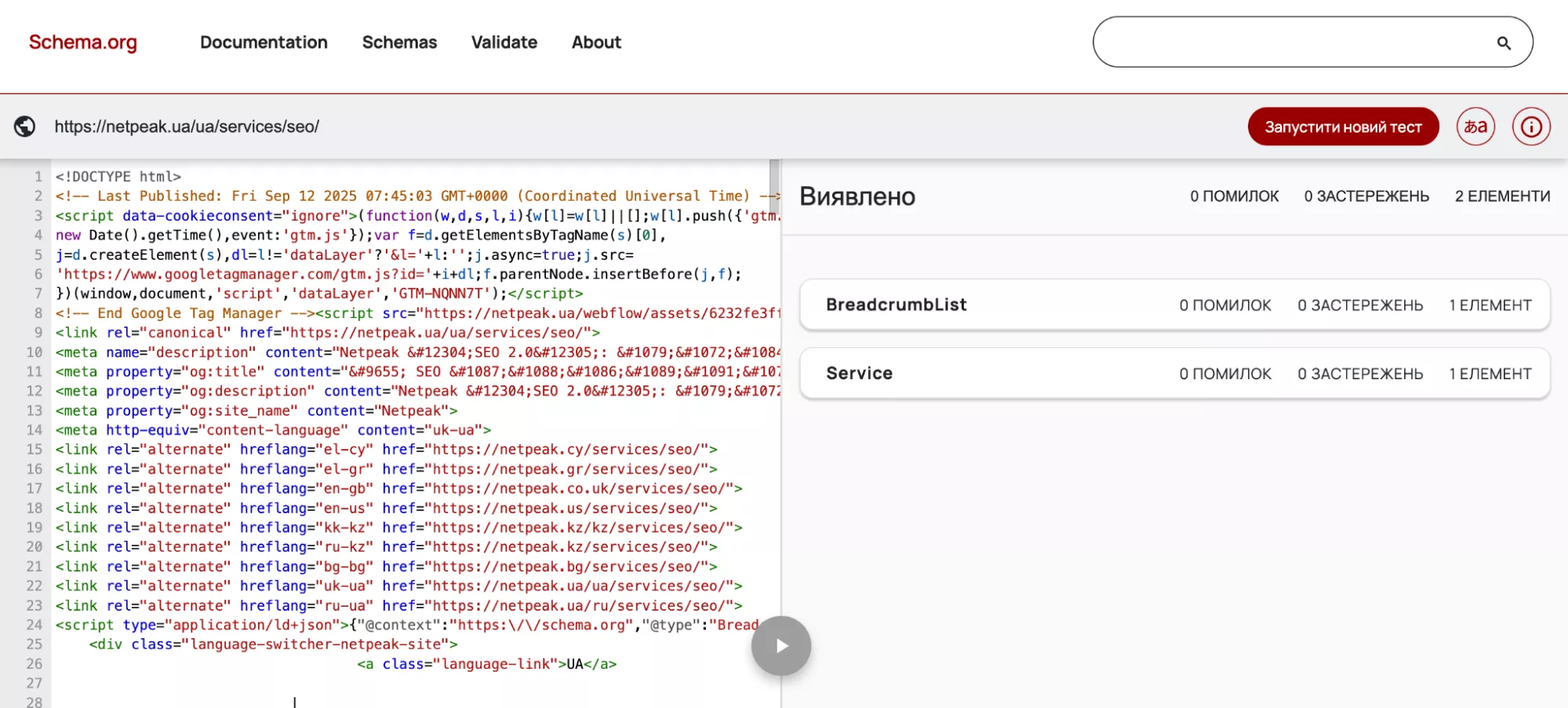

Сервис Google Rich Results Test проверяет разметку, наличие структурированных данных (например, цепочки навигации или часто задаваемые вопросы), проблемы веб-страницы, мешающие полной загрузке.

Через Schema Markup Validator также можно проверить структурированные данные. Валидатор показывает часть кода страницы, микроразметку и ошибки, если таковые имеются.

Что делать дальше с этой информацией? Ошибки (errors) нужно исправить, иначе страница может не появиться с расширенным отображением в поиске. Предупреждения (warnings) не критичны, но их исправление повышает качество данных.

Если используются несовместимые типы микроразметки или дублируется одна и та же информация разными методами, нужно оставить только один корректный вариант. Когда внесли правки, прогоните страницу еще раз через эти инструменты.

Внешние факторы: бэклинки и сайты-доноры

Обратные ссылки, или бэклинки, — это ссылки с других сайтов на ваш. Google рассматривает их как «рекомендации»: чем больше качественных ресурсов ссылаются на вас, тем выше может быть ваша позиция в выдаче. Однако здесь важно не количество, а качество. Условно ссылки должны идти с авторитетных ресурсов, таких как крупные медиа или отраслевые порталы.

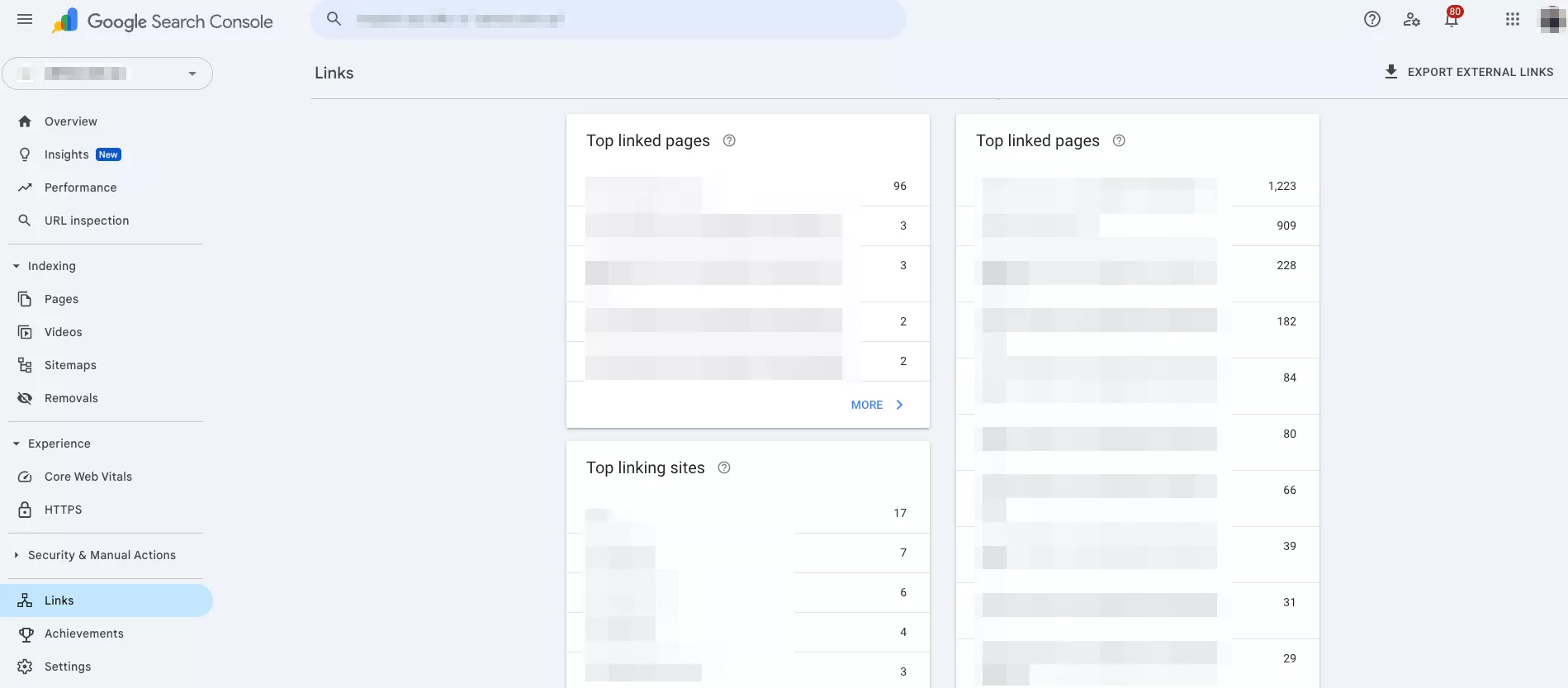

Анализ сайта по домену должен показывать backlink-профиль: количество ссылок, авторитетность доноров, тематическую релевантность, естественность анкор-листа, отсутствие токсичных ссылок. Самый простой способ проверить внешние факторы — использовать Google Search Console. Инструмент анализирует ссылки, доноров, анкоры из Google и подает файл Disavow (в случае спам-ссылок).

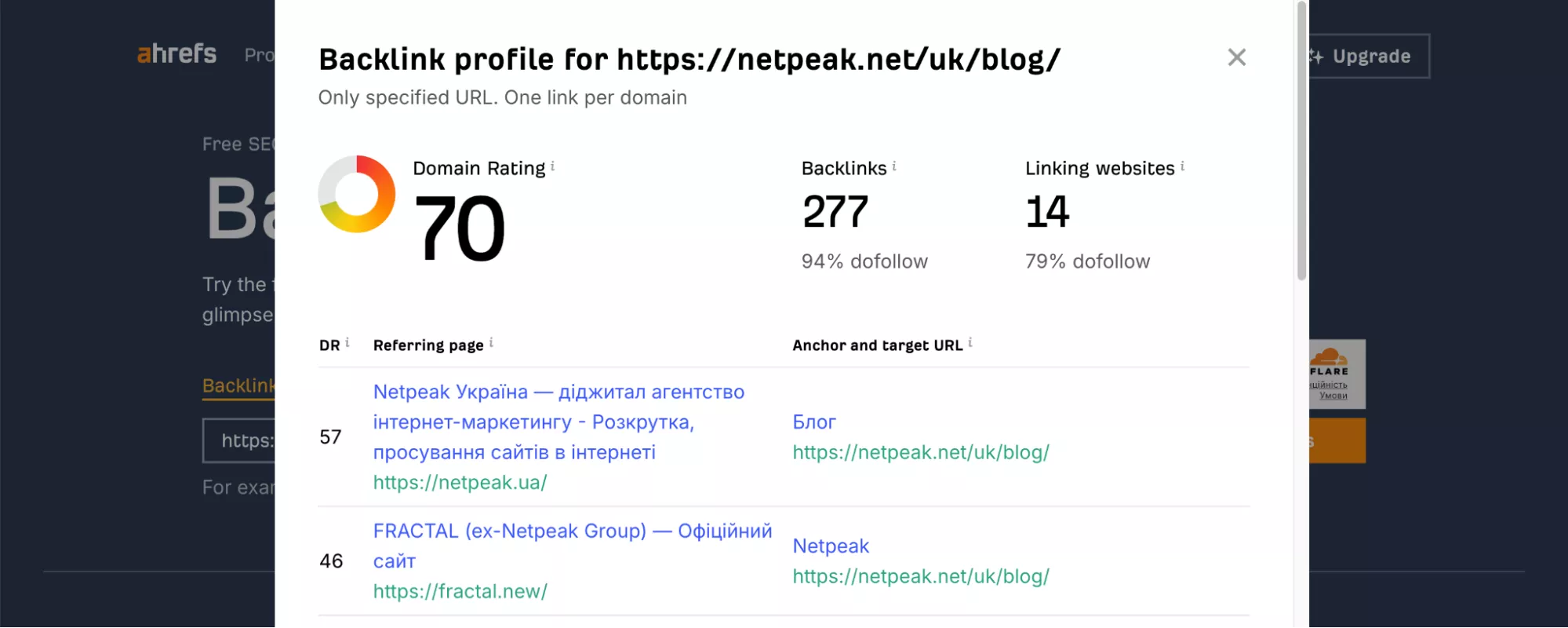

Можно использовать Ahrefs: в бесплатном режиме он дает ограниченную информацию, а для более глубокого анализа нужно уже оплатить план. Однако вы можете увидеть рейтинг домена и страниц, ориентировочный трафик, анкоры бэклинков, а также 100 топовых внешних ссылок и самые популярные страницы по количеству ссылок.

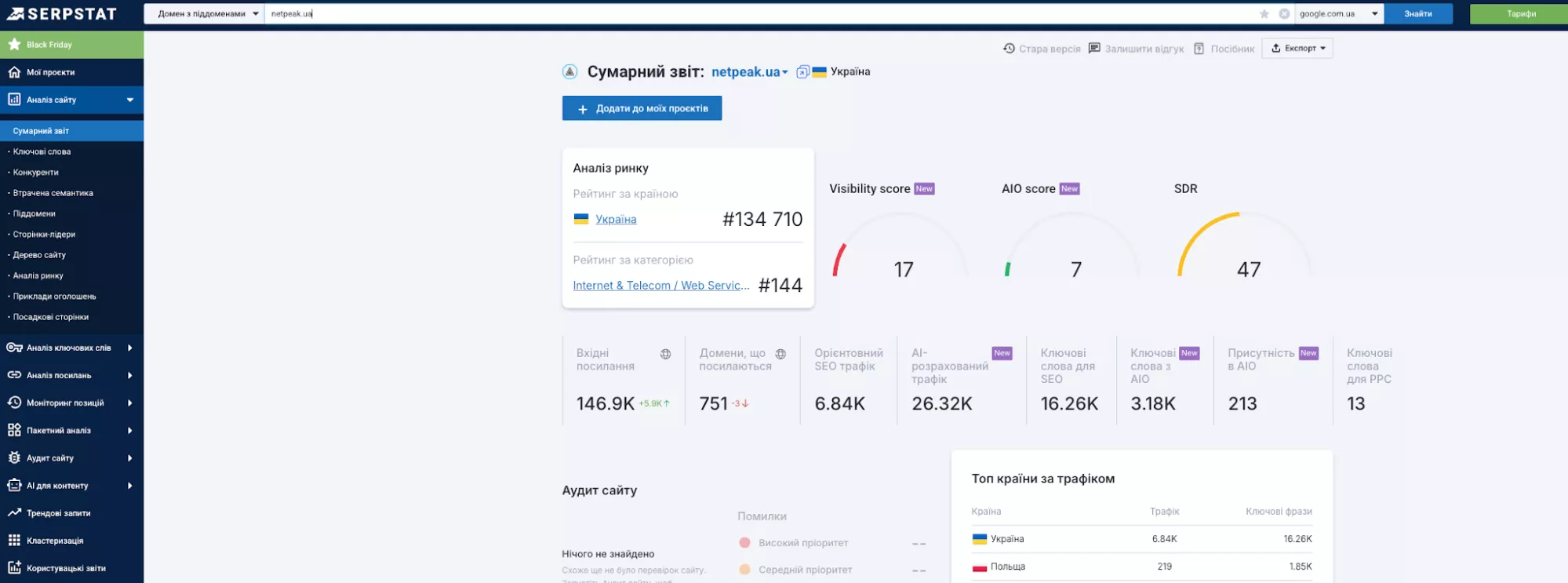

Сервис Serpstat проверяет бэклинки и использует собственный показатель авторитетности. Преимущество инструмента в том, что он объединяет много SEO-функций в одном сервисе: анализ ссылок, подробные отчеты, сегментацию ссылок по типам и т. д.

Также воспользуйтесь Majestic, который проверяет доноров через Trust Flow, Citation Flow и Topical Trust Flow. Инструмент Moz определяет авторитетность и ищет токсичные бэклинки через показатели DA, PA и Spam Score. А SE Ranking с подобным функционалом проще использовать для локальных рынков.

После сбора всех внешних ссылок основная задача — оценить их качество и определить, какие из них приносят пользу, а какие могут навредить сайту. Для этого:

-

Проанализируйте все полученные бэклинки — откройте отчеты из предыдущих сервисов и проверьте авторитетность доноров, тематику, анкорный текст.

-

Проверьте вредные ссылки — Google автоматически игнорирует большинство низкокачественных ссылок, но вам нужно выявить и отклонить те, которые представляют потенциальную угрозу. Например, неправильное описание сайта, ссылки на казино, когда сам ресурс не имеет такой тематики. Для этого воспользуйтесь Google Disavow Tool, если убрать вручную не получается.

Далее просмотрите анкор-лист. Это список всех текстов ссылок (то есть анкоров), ведущих на ваш ресурс. Естественный профиль должен состоять из различных типов: коммерческих («купить iPhone» или «заказать джинсы»), брендовых («интернет-магазин N»), URL (n.shop.ua), общих («здесь», «перейти на сайт»). Если одна из этих категорий доминирует, необходимо разбавить ее другими.

Для удобства настройте мониторинг новых ссылок (Ahrefs Alerts или ежемесячная проверка GSC), чтобы вовремя выявлять полезные и токсичные линки.

Чтобы сформировать стратегию развития собственного бэклинк-профиля, проанализируйте соответствующую активность на ресурсах конкурентов через Ahrefs или Serpstat. Введите домен конкурента и найдите доноров, которые ссылаются на него, а на ваш сайт — нет. На основе этого уже можно строить тактику развития собственного бэклинк-профиля.

Например, попробуйте получить ссылки из тех же источников. Желательно проверять, какие типы контента (обзоры, исследования, инфографики) имеют больше всего ссылок у конкурентов и учитывать это для себя.

Итак, качественный бэклинк-профиль — это баланс между авторитетностью доноров, естественностью анкоров и тематической релевантностью. ПС автоматически игнорирует большинство низкокачественных ссылок, а вам стоит контролировать и отклонять только действительно опасные (например, спам-анкоры). Регулярно анализируйте ссылки конкурентов, чтобы находить новые возможности для развития собственного профиля, и проверяйте новые бэклинки, чтобы вовремя реагировать на угрозы.

О бэклинках читайте также в материалах:

Анализ позиций и видимости

Мониторинг позиций показывает, насколько эффективно работает SEO-стратегия, и помогает вовремя замечать возможные проблемы. Отслеживая позиции по ключевым запросам, вы вовремя заметите изменения: поднимаетесь ли вы в выдаче, теряете ли позиции из-за активности конкурентов или обновления алгоритмов Google и т. д.

Какие инструменты можно использовать для анализа:

-

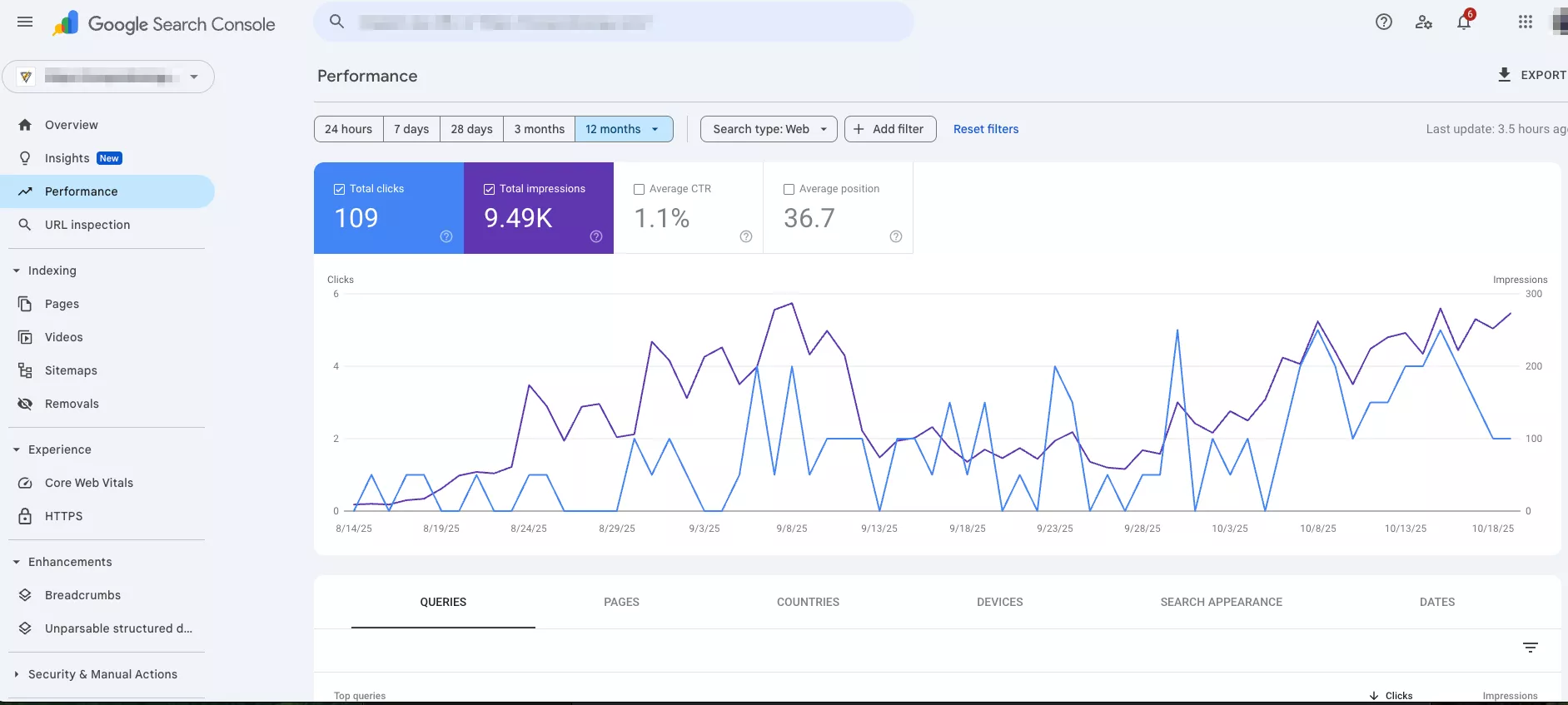

Google Search Console — бесплатный сервис, предоставляющий данные о средней позиции сайта, запросах, по которым он ранжируется. В Performance можно также посмотреть CTR, количество показов и кликов по каждому запросу.

-

Serpstat — платный инструмент (от 59 $/мес), сочетающий трекинг позиций с проверкой конкурентов в выдаче, он показывает изменения в ведущих сайтах, их видимость и новые ключи, по которым те продвинулись, определяет самые результативные SERP-функции.

-

SE Ranking — платный сервис (от 55 $/мес), который автоматически проверяет позиции с указанной периодичностью, визуализирует динамику и показывает изменения. Выделяется отчетами о каннибализации — вы можете находить собственные страницы, конкурирующие за одни и те же ключи.

Отслеживайте только важные запросы — в платных сервисах количество ключей ограничено тарифом, поэтому не стоит мониторить все подряд. Чтобы анализ был проще, разделяйте запросы по группам: товары, города, этапы воронки продаж и т. д. — так легче видеть закономерности и использовать их для дальнейших стратегий.

Среди функций SERP стоит проверять выделенные фрагменты (Featured Snippet) — это небольшие отрывки, которые оказываются в верхних результатах поиска и часто попадают в сгенерированные ответы. Благодаря этому они способны приводить столько же органического трафика, сколько и первая позиция в выдаче.

Чтобы усилить свои позиции, анализируйте также конкурентов. Так вы можете найти слабые места в ключевых запросах и скорректировать свою стратегию, а затем провести оптимизацию: добавить ключи в метатеги, анкоры, сам контент на сайте и т. д.

Регулярный мониторинг позиций помогает быстро реагировать на изменения в выдаче и корректировать стратегию. Для базового анализа достаточно Google Search Console, для более детального мониторинга и анализа конкурентов — Serpstat или SE Ranking.

Поведенческий анализ: как пользователи взаимодействуют с сайтом

Анализ юзабилити сайта показывает, насколько ожидания посетителей относительно ресурса оправдались. Часто проводят аудит Google Analytics 4 (GA4), чтобы увидеть взаимодействие через события: просмотры, клики, скроллинг, видео, формы. GA4 в отчете «Привлечение» на основе посещения сайта показывает, какие страницы удерживают внимание.

Другие популярные сервисы для анализа посещаемости онлайн:

-

Hotjar записывает сессии пользователей, строит тепловые карты кликов и скроллинга. Его аналитика форм дает понять, где посетители перестают заполнять информацию о себе.

-

Microsoft Clarity не ограничивает запись сессий — это бесплатно. Он автоматически ищет мертвые клики, чрезмерную прокрутку и так называемые клики злости (повторные и многократные).

-

Google Search Console показывает CTR сниппетов и готовит отчет по уже знакомым Core Web Vitals.

После анализа трафика можно уже переходить к конкретным действиям. Например, вы поняли по тепловой карте, что люди не видят CTA-кнопку. Тогда можно заменить цвет или переместить ее ближе к центру.

Поведенческий анализ показывает вам, где продукт теряет внимание аудитории и почему не срабатывают ожидаемые крючки (заполнение формы, покупка продукта). После этого можно перевести UX-решения из интуитивных в доказательные, изменив структуру, элементы, визуальные акценты и т. д.

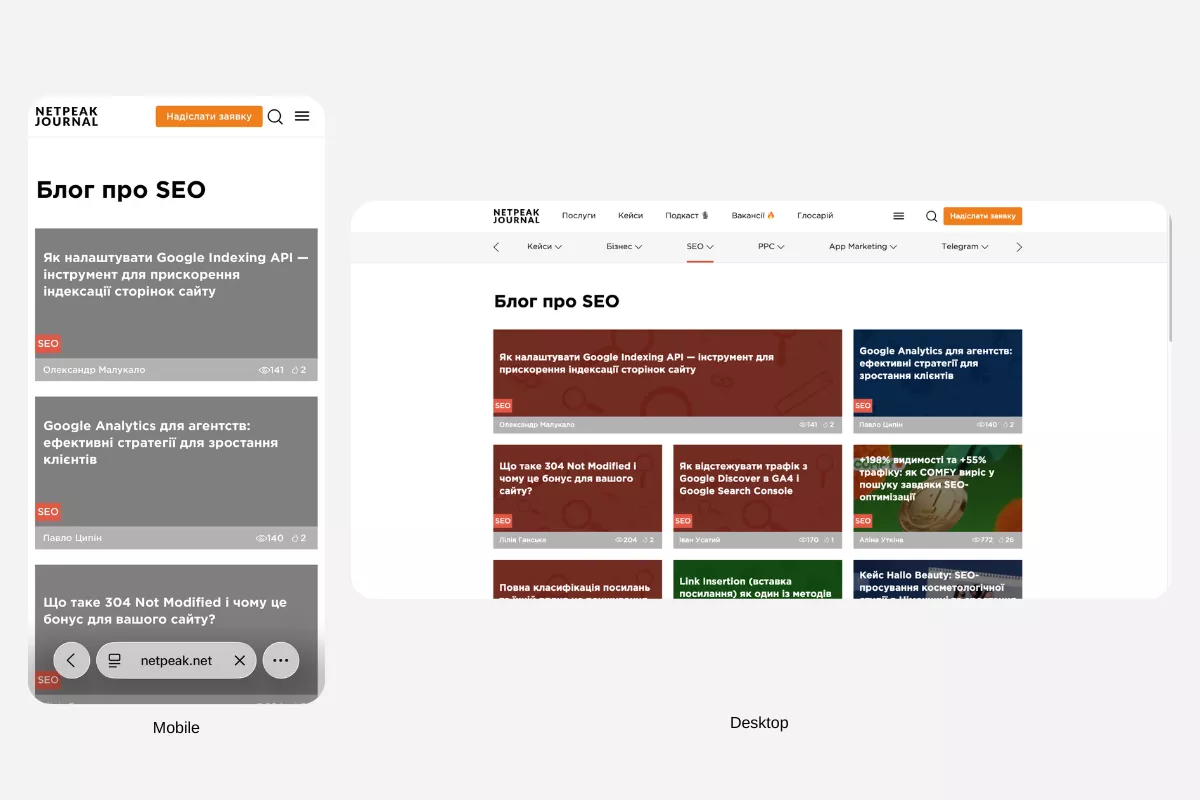

Мобильность и адаптивность

Google окончательно перешел на mobile-first индексацию. ПС оценивает сайты прежде всего по их мобильной версии, а люди все чаще заходят в интернет через смартфоны — игнорировать этот вопрос точно не стоит.

Чтобы проверить совместимость сайта с планшетом и смартфоном, используйте PageSpeed Insights — он сравнивает скорость загрузки различных форматов. Сервис также показывает Core Web Vitals по реальным данным пользователей Chrome. Если сравнивать с десктопом, мобильная оценка может быть немного ниже — это происходит из-за ограниченных ресурсов устройств и более медленных сетей.

Еще один вариант, как проанализировать работу сайта, — BrowserStack, который также рассчитан на приложения. Его принцип тестирования прост: он использует данные с реальных устройств, у которых отличаются браузеры и ОС. Эмуляторы не всегда замечают все проблемы, а так вы получаете немного более широкий угол обзора.

Например, анализ может показать, что в приложении Safari на iPhone 12 кнопка «Добавить в корзину» слишком мала и затрудняет клики.

Отчет с выявленными проблемами далее передайте разработчикам или технической команде: они устранят ошибки в верстке, оптимизации скорости, шрифтах, некорректной работе кнопок и т. д. Если ошибок много, расставьте их по приоритетам: сначала нужно исправить критические баги, которые влияют на пользовательский опыт и блокируют взаимодействие (кнопки, формы, верстка), затем должна идти оптимизация скорости, а далее — второстепенные визуальные элементы.

После внесения изменений повторно протестируйте сайт на тех же платформах, чтобы убедиться — предыдущие проблемы устранены, а новых не появилось.

Безопасность и техническое соответствие

HTTPS — это безопасный вариант протокола HTTP, он шифрует данные и отвечает за конфиденциальность информации. Если ресурс работает исключительно с HTTP, браузер может показывать предупреждения об опасности. Это отпугивает людей, особенно когда нужно оставить свои персональные данные или оплатить покупку на ресурсе.

Google учитывает HTTPS для ранжирования, а пользователи больше доверяют защищенным сайтам. Когда на ресурсе нет SSL-сертификата (а это он превращает HTTP в HTTPS), браузеры не позволяют использовать другие технологии: например, HTTP/2 для скорости, Service Worker для офлайн-режима, геолокацию и push-уведомления.

Есть два способа проанализировать сайт онлайн в этом направлении:

-

Зайти в раздел «Проблемы безопасности» от Google Search Console. Система показывает, нет ли взломанных страниц, вредоносных скриптов и фишинга.

-

Использовать Chrome DevTools, он на вкладке Security указывает состояние SSL-сертификата и обнаруживает смешанный контент — когда HTTPS-страница загружает ресурсы через HTTP.

Если SSL-сертификата нет, его нужно установить. В большинстве случаев хостинги предоставляют бесплатную версию Let’s Encrypt, которая быстро устанавливается через панель управления хостингом. Если такой формат не поддерживается, сертификат нужно купить (например, у провайдеров Comodo, Sectigo или GeoTrust). После этого важно проверить, чтобы было настроено принудительное перенаправление с HTTP на HTTPS — так вы избежите дублирования страниц и смешанного контента.

Как организовать анализ: чеклист и периодичность

Проверять ключевые показатели нужно регулярно, чтобы сформировать системный подход к SEO-анализу сайта. Тогда вы сразу будете видеть проблемы и быстро их устранять.

Ежедневный анализ может касаться:

-

технических ошибок с индексацией и сервером (Google Search Console);

-

доступности и времени отклика сервера (Google PageSpeed Insights);

-

аномалий в трафике (GA4).

Немного реже — раз в одну-две недели — стоит проверять:

-

как меняются позиции по основным ключевым словам (Serpstat, SE Ranking);

-

появляются ли новые и теряются ли бэклинки (Ahrefs, Majestic);

-

как меняются поведенческие метрики, в частности, отказы, время на сайте, глубина просмотра (GA4).

Ежемесячно желательно проводить:

-

полное сканирование (Netpeak Spider, Screaming Frog);

-

проверку микроразметки и структурированных данных (Rich Results Test);

-

оценку мобильной версии и Core Web Vitals (PageSpeed Insights);

-

анализ внутренней перелинковки и архитектуры сайта (Netpeak Spider).

Еще реже проводится глубокий конкурентный анализ, аудит контента, просмотр и обновление семантического ядра, проверка токсичности бэклинков и т. д.

Чтобы систематизировать процесс, составьте собственный маршрут.

-

Начните с технической основы: просмотрите индексацию и критические ошибки.

-

Проанализируйте структуру и внутреннюю оптимизацию, сосредоточьтесь на внешних факторах и конкурентах.

-

Завершите оценкой поведенческих метрик и конверсий.

Чтобы видеть динамику изменений, ведите таблицу проверок: фиксируйте дату анализа, проблемы, выполненные действия и результаты. Через несколько месяцев увидите, какие изменения дали эффект, а какие оказались бесполезными.

Выводы и общие советы

-

Анализ сайта должен быть регулярной практикой, а не разовым явлением. Однако ни один инструмент не даст вам абсолютно полной картины во всех направлениях сразу.

-

Эффективная стратегия — сочетать бесплатные ресурсы (Google Search Console, например) и профильные сервисы в зависимости от бюджета. Можно использовать такие базовые программы для анализа сайтов: GSC и Netpeak Spider. Для регулярного мониторинга добавьте Serpstat или SE Ranking. Для более глубокого аудита рационально еще применить Ahrefs и Sitebulb.

-

Успешный SEO-анализ сайта основан на нескольких принципах: комплексность ради объективности, регулярность для предупреждения проблем, правильная приоритизация и фиксация результатов. Однако анализ — это сухая аналитика, а вам нужно еще превратить ее в конкретные действия, которые повышают трафик, улучшают конверсии и дают реальные результаты.

FAQ

Что такое анализ сайта и в чем его отличие от аудита?

SEO-анализ сайта — это систематическая проверка отдельных аспектов: технического состояния, контента, видимости в поиске, поведенческих факторов. Аудит — комплексное исследование всех SEO-компонентов одновременно с подробным отчетом об обнаруженных проблемах и рекомендациями по их устранению.

Какие методы применяют для анализа контента сайта?

Netpeak Spider анализирует, как построены тексты, есть ли метатеги, дублируются ли title и description. Инструменты для анализа сайта по типу Serpstat и Sitechecker оценивают, насколько контент совпадает с целями людей, проверяют плотность ключевых запросов и соответствие основному поисковому интенту. А через DupliCheker можно проверять уникальность и увидеть дубликаты у конкурентов.

Как влияет скорость загрузки на SEO и как ее проверить?

Медленные страницы ухудшают поведение пользователей, например, растет показатель отказов, а это влияет на позиции в Google. Через Google PageSpeed Insights можно провести базовую диагностику, Netpeak Spider лучше подходит для массовой проверки всех страниц ресурса. А GTmetrix можно использовать как дополнительный взгляд со стороны.

Как оценить внешнюю оптимизацию и ссылочный профиль сайта?

Профиль внешних ссылок можно проверять несколькими сервисами. Ahrefs показывает количество и качество бэклинков по метрикам DR/UR, Majestic оценивает доверие доноров через Trust Flow, а Serpstat микширует анализ ссылок и исследование конкурентов. Также нужно оценивать количество обратных ссылок, авторитетность доноров, тематическую релевантность и т. д.

Какие инструменты лучше всего подходят для мониторинга позиций сайта?

Serpstat фиксирует позиции и проводит анализ SEO сайта конкурентов в выдаче, а Google Search Console исследует фактический трафик. SE Ranking автоматически отслеживает позиции с выбранной периодичностью, показывает изменения в топе ПСа и SERP-функции.

Свежее

Что ждет бизнес и как адаптировать маркетинговые стратегии: AI-поиск 2026

Материал на основе митапа AI Search 2026. Рассматриваем изменения в AI-поиске и выдаче в целом.

Почему пользователи удаляют приложение и как этого избежать

Что именно заставляет пользователей забывать и удалять приложение? Разбираем и предотвращаем отток юзеров

Как настроить расширенную электронную торговлю с помощью Google Tag Manager

В этой статье разберу этапы построения системы — от стратегии до отдельных событий в воронке