У світі пошукової оптимізації (SEO) індексація є однією з ключових фаз, яка визначає видимість вебсайту та його окремих сторінок у пошукових системах — Google, Bing, Yahoo та інших. У цій статті я розповім, що таке індексація та як вона працює, як перевірити індексування сайту і як правильно закрити від цього процесу сайт.

Що таке індексація простими словами

Індексація — процес, у якому пошукові роботи (пошукові павуки або боти) сканують вебсайти для збору інформації про їхній зміст. Ці роботи переходять за посиланнями між сторінками та аналізують контент. Після збору даних вони додають інформацію до індексу пошукової системи.

Індекс — це велика база, у якій містяться зібрані дані про сторінки вебсайтів. Він допомагає пошуковим системам швидко знаходити сторінки, що відповідають запитам користувачів. Чим більше якісного та релевантного контенту зібрано в індексі, тим ефективнішим буде пошук для користувачів.

Ознайомтеся зі словником для кращого розуміння статей Netpeak Journal. Дізнайтеся визначення SEO-термінів для розуміння основ пошукової оптимізації.

Як проходить індексування сайту

Щоб розібратись в темі «Як заборонити індексацію сайту?», варто спершу зрозуміти процес індексування.

Пошукові роботи починають індексацію з переходу на сайт. Уявімо, що ви працюєте із сайтом https://netpeak.net/ і хочете його проіндексувати. Для цього є наступні етапи:

- Пошуковий робот починає зі сканування стартової сторінки сайту. Він перевіряє HTML-код, зображення, посилання та інші елементи на сторінці.

- Перехід за посиланнями на інші сторінки. Пошуковий робот переходить за посиланнями, знайденими на головній сторінці, і сканує інші. Наприклад, якщо на головній сторінці є лінк на https://netpeak.net/blog/category/seo/, робот перейде на нього.

- Пошуковий робот аналізує вміст відвіданих сторінок, збираючи текст, зображення, відео та інші елементи вмісту. На сторінці https://netpeak.net/blog/category/seo/ є перелік статей та інша інформація. Саме це і потрібно роботу.

- Після збору інформації пошуковий робот додає сторінку до свого індексу. Це допомагає пошуковій системі знаходити її при введені користувачем відповідних запитів.

- Оновлення та переіндексація. Пошукові роботи періодично повертаються на кожний сайт, щоб оновити інформацію та знайти новий контент. Вони сканують ці зміни та оновлюють індекс.

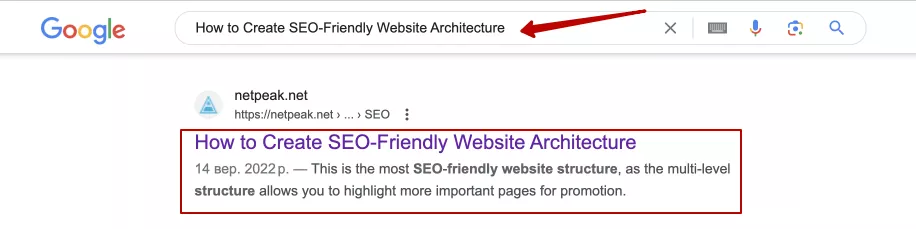

- Показ у результатах пошуку. Коли користувач вводить запит у пошукову систему, вона використовує свій індекс для пошуку найбільш відповідних сторінок. Наприклад, коли користувач шукає «How to Create SEO-Friendly Website Architecture», пошукова система використовує індекс для знаходження сторінки https://netpeak.net/blog/how-to-create-seo-friendly-website-architecture-best-practices/ та відображає її у результатах:

Індексація сайту — складний процес, який дозволяє пошуковим системам ефективно знаходити та відображати релевантні сторінки у результатах пошуку. Це допомагає як SEO-фахівцям, так і власникам сайтів покращити видимість та забезпечити оптимальну взаємодію з пошуковими роботами.

Як перевірити індексування сайту

Перевірка індексації важлива, оскільки дозволяє переконатися, що пошукові системи коректно розуміють вебсайт та вміст, який передається користувачам. Дізнатись, чи проіндексований сайт можна наступними методами:

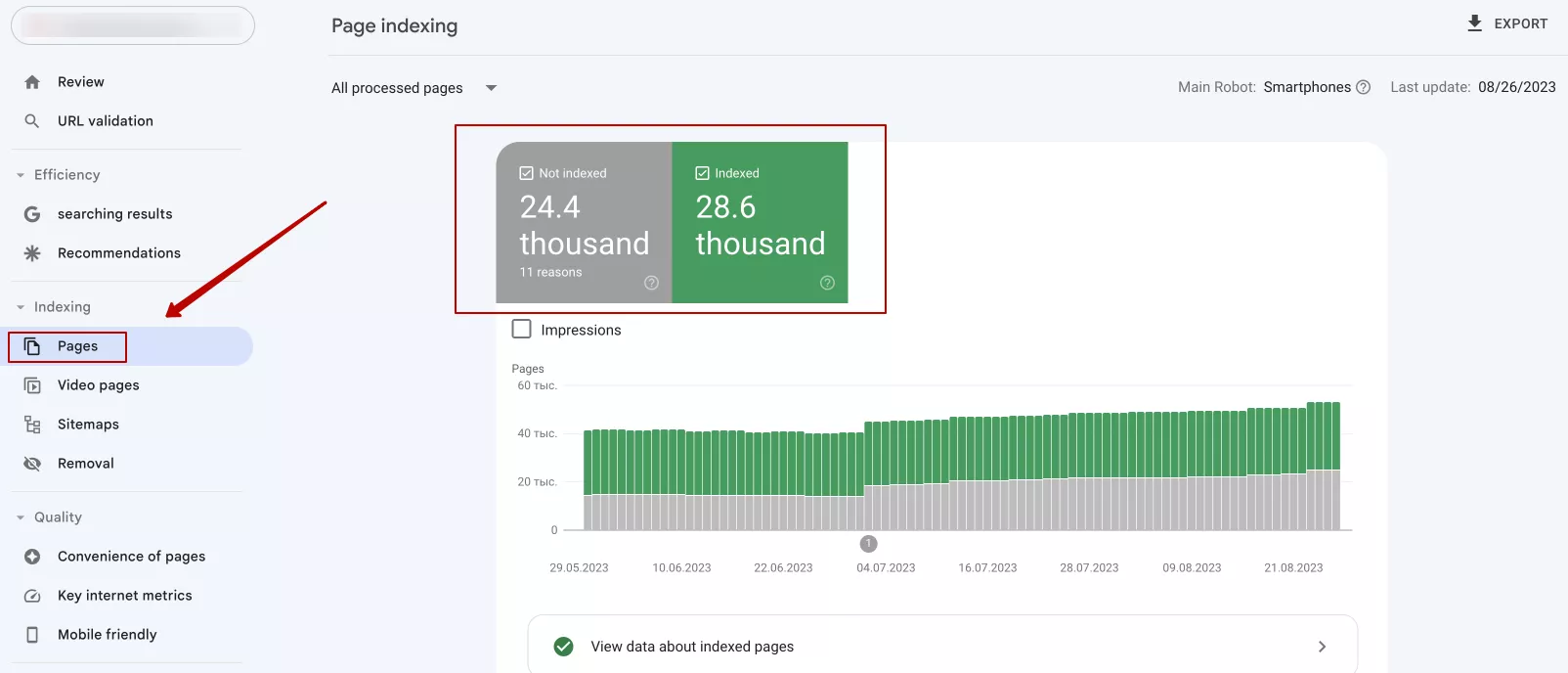

1. Використати Google Search Console. Якщо ви власник сайту, обов’язково зареєструйте його в Google Search Console. Це безкоштовний інструмент від Google. Він надає інформацію про те, як Google бачить ваш вебсайт, звіти про індексацію сторінок, виявлення помилок і багато іншого. Щоб перевірити індексування через Google Search Console, перейдіть у вкладку «Pages». Там можна побачити, скільки сторінок проіндексовано, а також які з них мають проблеми:

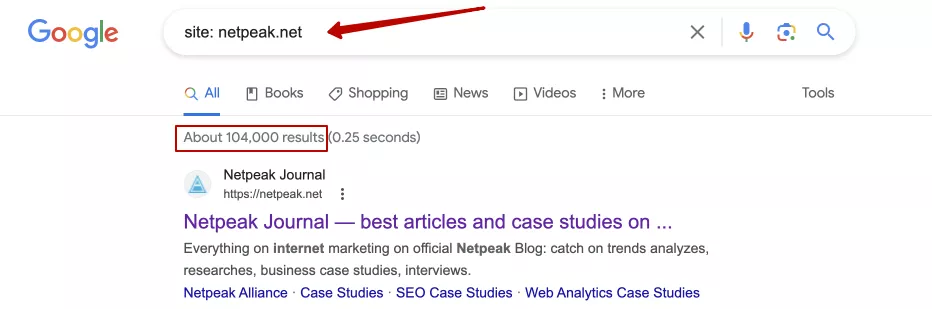

2. Використати команду «site:» у пошукових системах. Вона дозволяє перевірити, скільки сторінок конкретного сайту проіндексовано в певній пошуковій системі. Наприклад, введення «site: netpeak.net» у Google покаже всі сторінки, які індексовані з цього сайту:

Утім, це досить неточний спосіб отримання інформації про індексацію сайту та його окремих сторінок. Але при цьому — це корисний метод, адже в комплексі з іншими операторами, дозволяє знайти певні сторінки з вкладеннями/параметрами, які повинні бути прихованими від індексації на нашому сайті. Також цей спосіб дозволяє дізнатися про індексацію окремих сторінок чи сайту конкурентів.

3. Існують також різні сервіси, які інформують про індексацію сайту. Наприклад, Netpeak Checker дозволяє з’ясувати, чи є сайт або сторінки у видачі. Інші сервіси: Ahrefs, SEMrush тощо — допомагають відслідковувати індексацію та виявляти можливі проблеми.

Власне, почитайте більш детально про шість способів перевірки індексації сайту.

Як закрити сайт від індексації: ефективні методи

Належний контроль того, як вебсайт і його вміст індексуються пошуковими системами є важливою частиною SEO-оптимізації. У певних випадках закриття сторінок від індексації може бути доречним та корисним. Мова про такі сторінки:

- Тестовий чи розробницький контент. Така сторінка часто є незавершеною, непридатною для публічного перегляду або може містити помилки. Закривши ці сторінки від індексації, зникає імовірність випадкової публікації недоробленого контенту.

- Сторінки з конфіденційною інформацією. Конфіденційність даних завжди є пріоритетом, і якщо на сайті є сторінки з особистою, фінансовою або іншою конфіденційною інформацією, їх слід закрити від індексації. Це може бути сторінка з обліковими даними користувачів, платіжні дані тощо.

- Дубльований контент. Якщо на сайті є сторінки з контентом, який повторюється на інших сторінках, це може призвести до проблем з ранжуванням в пошукових системах. Закриття дубльованого контенту від індексації допоможе забезпечити кращу видимість та послідовність основної сторінки.

- Внутрішні адміністративні сторінки. Потрібні для керування вмістом сайту або його налаштуваннями і не мають бути доступними назагал. Закриття від індексації дозволить уникнути можливого ризику несанкціонованого доступу та збереже контроль над адміністративною частиною.

- Користувацькі сторінки покупки або реєстрації. Якщо на сайті є сторінки з корзиною покупок, реєстрацією, оформленням замовлення, сторінки пошуку, порівняння, сортування, фільтрів за ціною та виведенням кількості товарів на сторінках, їх варто закрити від індексації. Адже вони формують дублі.

Розуміння процесу індексації допоможе в ефективній оптимізації сайту, адже таким чином відбувається відкриття і закриття важливих та неважливих сторінок сайту.

Про індексацію сторінок читайте також у практичному кейсі: «Як збільшити органічний трафік на 160% у конкурентній тематиці ecommerce — кейс grokholsky.com».

Як закрити сайт від індексації

Є 4 основні методи, які допомагають керувати індексацією.

Метатег «robots»

Метатег «robots» є одним із найпоширеніших способів контролю індексації вебсторінок. Є 4 головних правила, які можемо використати в метатезі «robots»:

- «index» — дозволяємо боту індексацію;

- «noindex» — забороняємо індексацію;

- «follow» — дозволяємо боту переходити за внутрішніми посиланнями;

- «nofollow» — забороняємо перехід за посиланнями.

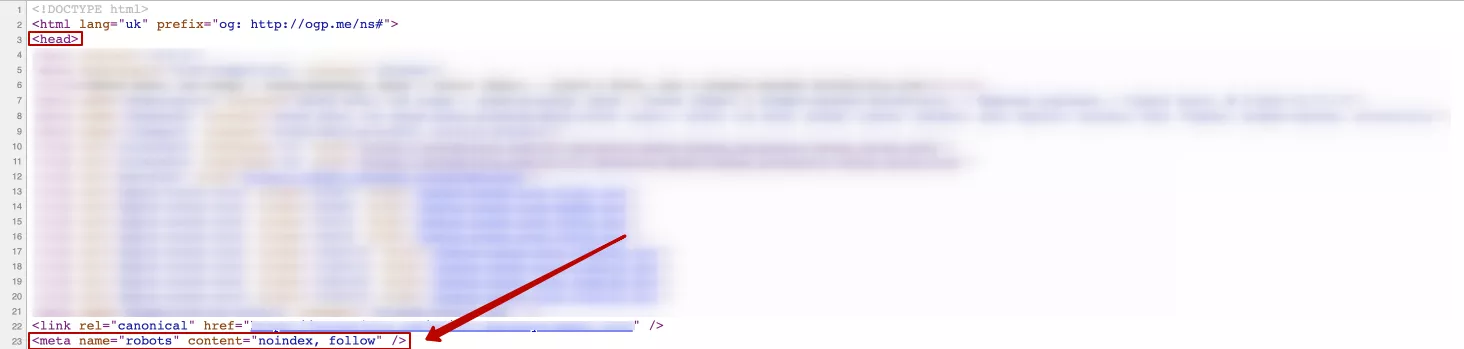

Додавання метатега зі значенням «noindex» до коду сторінки в блоці <head> забороняє пошуковим системам індексувати її. Він прописується так:

<meta name=«robots» content=«noindex, follow» />Де «noindex» — правило, що забороняє індексацію сторінки пошуковими системами. Варто додати правило «follow», що дозволяє перейти роботу за посиланнями на іншу сторінку і продовжити досліджувати сайт.

Приклад використання:

Ще один варіант реалізації цього правила, а саме:

<meta name=«robots» content=«noindex, nofollow» />Де «nofollow», відповідно, забороняє роботу перехід за посиланнями на інші сторінки сайту.

Якщо замінити «robots», наприклад, на «bing», інструкція поширюватиметься лише на робота пошукової системи Bing. Але якщо певна сторінка повинна бути прихована від індексації, рекомендую прописувати інструкцію для всіх пошукових роботів.

Метатег «robots» особливо корисний для окремих сторінок, які необхідно захистити від загального доступу.

Важливо! Google довідка каже: «Щоб правило «noindex» працювало, файл robots.txt не повинен блокувати пошуковому роботу доступ до сторінки. Інакше він не зможе обробити її код і не виявить правило noindex. У результаті контент з такої сторінки, як і раніше, з’являтиметься в результатах пошуку, наприклад, якщо на неї посилаються інші ресурси».

X-Robots-Tag у відповіді сервера

Заголовок «X-Robots-Tag» може бути встановлений на рівні сервера або на рівні окремих сторінок для керування індексацією пошуковими системами. Він вказує пошуковим системам, як обробляти конкретну сторінку чи ресурс. Заголовок «X-Robots-Tag» може містити ті самі директиви, які й метатег «robots»:

X-Robots-Tag: noindex, nofollowЗаголовок вказує пошуковим системам не індексувати сторінку («noindex») і не переходити за посиланнями на ній («nofollow»). Правило можна прописати в різних варіаціях.

Встановити «X-Robots-Tag» для конкретної сторінки або ресурсу на сервері можна в налаштуваннях до сервера або використати файл конфігурації, який вказує на HTTP-заголовки, які потрібно встановити для конкретних запитів.

Щоб налаштувати X-Robots-Tag для Apache сервера, потрібно додати наступний код в файл .htaccess:

Header set X-Robots-Tag «noindex, nofollow»Цей приклад встановлює заголовок X-Robots-Tag для всіх сторінок сайту і забороняє їх індексацію та перехід за посиланням.

Після внесення змін у .htaccess Apache, потрібно перезавантажити вебсервер щоб зміни набрали чинності.

Для налаштування X-Robots-Tag для Nginx сервера, потрібно використовувати додатковий модуль nginx, який називається «add_header». Цей модуль дозволяє додавати HTTP заголовки до відповідей сервера.

- Відкрийте конфігураційний файл для вашого сайту.

- Знайдіть блок «server», що відповідає вашому сайту, і додайте або відредагуйте рядок «add_header» в цьому блоці, щоб додати заголовок X-Robots-Tag. Наприклад:

add_header X-Robots-Tag «noindex, nofollow»У цьому прикладі, як і в попередніх, заголовок X-Robots-Tag встановлено як «noindex, nofollow», що забороняє індексацію і перехід на інші сторінки сайту за посиланням. Після внесення змін у конфігураційний файл, потрібно перезавантажити вебсервер Nginx, щоб зміни набрали чинності.

Після встановлення «X-Robots-Tag» пошукові системи будуть дотримуватися вказаних директив щодо індексації та переходу за посиланнями на вказаній сторінці чи ресурсі.

HTTP-код 403 (Forbidden)

HTTP-код 403 (Forbidden) вказує на те, що запит до сервера був коректним, але сервер відмовився обробляти його через обмеження доступу. Цей код можна використати для закриття сторінки від індексації пошуковими системами, і ось як це зазвичай робиться:

1. Створення сторінки для відображення повідомлення про заборону. Спершу можна створити сторінку, на яку перенаправлятимуться користувачі у разі відмови у доступі. Наприклад, сторінка «forbidden.html» та вміст, який варто відобразити користувачам, коли вони намагаються отримати доступ до забороненої сторінки. Якщо користувач зайде на таку сторінку, вона повинна мати відповідне оформлення. І якщо розмістити на ній посилання на головну (наприклад), користувач не втратиться, а просто перейде на іншу сторінку сайту.

Можна прописати інформацію: «Вибачте, але ви не маєте доступу до цієї сторінки. Зв’яжіться, будь ласка, з адміністратором сайту для отримання доступу». Варто зазначити, що 403 код можна використовувати, щоб закрити не лише певні сторінки від індексації, а і весь сайт. Це може бути корисним, наприклад, коли потрібно обмежити доступ користувачам з інших регіонів/країн.

2. Використання HTTP-коду 403 і налаштування robots.txt. Потрібно налаштувати сервер так, щоб він надсилав HTTP-код 403 при спробі доступу до забороненої сторінки і, одночасно, вказати пошуковим системам не сканувати цю сторінку у файлі robots.txt:

- HTTP-код 403. Слід налаштувати веб-сервер (наприклад, через файл «.htaccess» для Apache) так, щоб він надсилав HTTP-код 403 для забороненої сторінки;

<Files «forbidden page.html»>

Order Allow,Deny

Deny from all

</Files>

де «forbidden page.html» — це шлях до сторінки, яку потрібно заборонити.

- Файл robots.txt. У файлі robots.txt слід додати наступний рядок для сторінки, яку треба заборонити до сканування.

User-agent: *

Disallow: /forbidden page.htmlЦей запис вказує пошуковим системам, що сторінку /forbidden page.html слід ігнорувати і не сканувати.

Після виконання цих кроків, коли користувачі спробують отримати доступ до забороненої сторінки, сервер відправить їм HTTP-код 403 і може перенаправити на створену сторінку «forbidden.html». Пошукові системи також ігноруватимуть цю сторінку через налаштування в файлі robots.txt, і вона не буде індексована у їх базі даних.

Важливо! Довідка Google рекомендує не зловживати 403 кодом для управління індексацією. В майбутньому така сторінка може бути видалена з Google пошуку. Коли робот потрапляє на сторінку з 403 кодом, він бачить помилку на стороні користувача, отже, потрібно повернутись пізніше. Після повторних відвідувань і отримання того самого коду відповіді, ці сторінки можуть бути видалені з Google пошуку.

Захист сторінок паролем

Якщо потрібно обмежити доступ до сторінок не лише для пошукових систем, а й для користувачів, можна використовувати захист паролем. Він передбачає, що користувач повинен ввести правильний логін і пароль для отримання доступу до сайту чи окремої сторінки.

Такий метод особливо корисний у випадках:

- Коли потрібно захистити адміністративний інтерфейс. Якщо є адміністративна панель або інший розділ сайту, до якого повинен мати доступ тільки обмежена кількість користувачів (наприклад, адміністратори), HTTP-автентифікація допоможе забезпечити доступ лише цим користувачам.

- Тестові або розробницькі сайти, сторінки. У разі розробки або тестування сайту можна використовувати HTTP-автентифікацію.

- Спеціалізовані послуги або ресурси. Деякі вебсайти надають спеціалізовані послуги або ресурси, до яких повинні мати доступ лише певні групи користувачів. HTTP-автентифікація допомагає забезпечити цей обмежений доступ.

- Захист від публічного індексування. Якщо потрібно захистити сторінку або каталог від індексації пошуковими системами, HTTP-автентифікація може бути використана як додатковий шар безпеки після заборони сканування в файлі robots.txt. Цей спосіб забезпечує високий рівень безпеки та конфіденційності для користувачів і надає доступ тільки тим, хто має відповідні облікові дані.

Висновки

Індексація — невід’ємна частина SEO-стратегії, яка допомагає забезпечити належну видимість та релевантність вебсайту для цільової аудиторії. Важливо перевіряти індексацію, аби переконатись, що пошукові системи коректно розуміють вміст, який передається користувачам.

Однак є сторінки, які через низку причин можна закрити від індексації. Для цього використовуються наступні методи:

- метатег «robots»;

- X-robots-tag;

- HTTP-код 403 (Forbidden);

- захист сторінок паролем.

Вони допомагають ефективно контролювати процес індексації сайту та забезпечують захист конфіденційної інформації.

Свіжі

Як аналізувати ефективність креативів в Google Universal App Campaigns

У цій статті розповідаємо, як системно аналізувати креативи в Google UAC і приймати рішення, котрі впливають на результат

Автоматизація SEO-задач: як пришвидшити роботу за допомогою Tampermonkey і ChatGPT

Дізнайтеся, як автоматизувати роботу по SEO-задачах без знань програмування: позбуваємося рутини за допомогою ChatGPT і Tampermonkey.

Як ефективно просувати криптопроєкти з допомогою інструментів Telegram?

Стаття створена за мітапом Максима Цапа, Head of Telegram Promotion Department у Netpeak Ukraine