Як налаштувати Google Indexing API — інструмент для прискорення індексації сторінок сайту

Щодня SEO-спеціалісти працюють над тим, щоб якомога більше релевантних сторінок сайту було проіндексовано. Це досить складний процес, який залежно від розміру сайту може зайняти тижні, місяці, а то й роки. Однак, є способи його прискорити.

Що таке індексація сайту та для чого вона потрібна

Індексація сайту — це процес потрапляння вмісту сайтів до бази пошукової системи (ПС): не лише самих сторінок сайту, а й відео, фото та інших матеріалів, що розміщуються на ресурсах.

З погляду окремої сторінки, потрапляння до бази даних ПС означає: система вважає її достатньо якісною, щоб вона надалі з’явилася у видачі. Пошуковий бот під час зчитування інформації і додавання сторінки до індексу також орієнтується на її зміст: це дає змогу присвоїти їй в індексі певний перелік ключових запитів, за якими вона буде ранжуватися.

Чому ж індексація є важливою?

-

Потрапляння в індекс і, відповідно, у результати пошуку — це і є SEO-трафік будь-якого сайту. Без індексації можливість знайти користувачами ваш сайт стрімко падає.

-

Лематизація дає змогу присвоїти індексу найбільш релевантний кластер запитів. За ними сторінка з’являтиметься у пошуку, збільшуючи релевантний трафік та покращуючи поведінкові чинники.

Водночас, далеко не всі сторінки є корисними для видачі, а деякі — навіть шкідливими. У такому випадку важливо знати, як правильно закрити сайт або окремі сторінки від індексації.

Коли виникають проблеми з індексацією та скануванням сайту

Серед проблем, що можуть завадити індексації контенту сайту:

-

Сторінки низької якості. Якщо на сторінці, на думку Google, немає достатньо корисного контенту або він схожий на спам, пошукова система не додасть її до індексу. В Google Search Console такі сторінки матимуть статус «проскановано», але не «проіндексовано».

-

Дубль сторінки. Коли Google вважає сторінку такою, що дублює контент, він також не додаватиме її в індекс. В Google Search Console це може відображатися статусами: «дублікат, Google визначив інший канонікал, аніж користувач», «альтернативна сторінка з правильним канонічним тегом», «дублікат сторінки без канонічного тегу».

-

Сайт знаходиться під ручними санкціями/фільтрами від пошукових систем (стосується насамперед Google). Сайт може як частково втратити сторінки в індексі, так і повністю вилетіти з нього.

Більше про причини проблем з індексацією читайте в матеріалі «Що таке деіндексація, або Як вийти з тіньового бану Google».

Окрім індексації, необхідно також згадати про краулінг сторінок — це процес виявлення та сканування вмісту сайтів пошуковими роботами. Без попереднього краулінгу індексація неможлива, бо пошукові роботи не зможуть знайти ваш контент. І навіть якщо знайдуть, можуть бути обмеження для сканування (одного зі складників краулінга), що також унеможливить потрапляння контенту у видачу.

Серед основних причин проблем із краулінгом:

-

Відсутність директиви Robots.txt — текстового документа, що містить інформацію про типи сторінок та файлів, доступних для індексації.

-

Відсутність карти сайту. Sitemap полегшує пошуковим роботам знаходження потрібних сторінок.

-

Велика кількість редиректів і битих посилань. Є поняття «краулінгового бюджету», тобто кількості сторінок, що може бути просканована за певний час. Кожен же редирект вважається за окрему сторінку, і таким чином краулінговий бюджет витрачається дарма.

-

Погана внутрішня перелінковка. Якщо на сторінці забагато посилань, вони всі ведуть на одну і ту саму адресу або мають незрозумілі анкори, то частина потрібних URL-адрес так і не знайдеться пошуковими роботами.

-

429, 500, 503 коди відповідей — дані коди повідомляють пошуковим роботам про проблеми на стороні сервера. При їхньому масовому отриманні, пошуковий робот на певний час припиняє сканувати сайт, і зменшує подальший краулінговий бюджет.

-

Низька швидкість завантаження сторінок, що також сприяє зниженню краулінгового бюджету.

-

Обробка файлів. Окремі JavaScript та CSS-файли можуть не оброблятися пошуковим роботом, що спричиняє як проблеми з індексацією окремого контенту сторінки, так і унеможливлює її сканування.

-

Відсутність мобільної версії. Google працює за принципом Mobile-First Index, що ставить першочерговим пріоритетом оптимізацію сторінки саме для мобільних пристроїв.

Способи прискорення індексації сторінок

Є кілька стандартних методів прискорення краулінгу та індексації сторінок:

-

Грамотна внутрішня перелінковка.

-

Наявність Sitemap.

-

Збільшення швидкості завантаження сторінок та їхніх елементів.

-

Зменшення кількості битих посилань і зайвих редиректів, наприклад, тих, що ведуть на ще одну переадресацію.

-

Забезпечення якості та цінності контенту.

-

Наявність посилань на соціальні мережі.

Серед інструментів, якими можна прискорити краулінг та індексацію, є такі:

-

Інструмент перевірки URL в Google Search Console.

Дає змогу перевірити:

-

статус сторінки у Google Search Console;

-

де вона була знайдена;

-

коли востаннє просканована тощо.

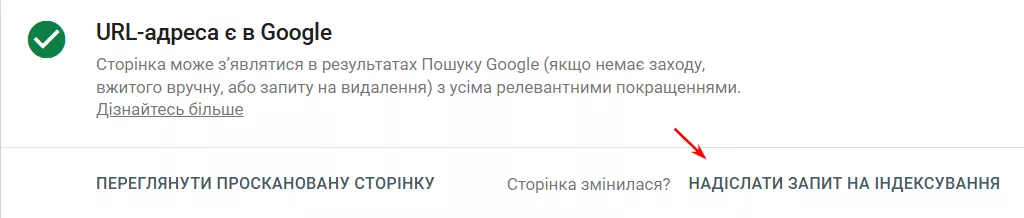

Якщо необхідно просканувати її повторно, наприклад, після зміни контенту чи статусу, скористайтеся кнопкою «Надіслати запит на індексування».

Інструмент підходить лише для одиничних запитів на сканування/індексацію, бо не може перевірити більше одного URL за раз.

Загальний ліміт складає приблизно 10–20 запитів. Після його вичерпання з’явиться повідомлення про тимчасове обмеження запитів, яке діятиме до наступного дня.

-

Ping-сервіси — ресурси, що сповіщають пошукові системи про появу нових сторінок. В них ви додаєте сторінки сайту, які необхідно просканувати та проіндексувати. Деякі з цих сайтів використовують у роботі Google Indexing API, тому це не найнадійніший спосіб індексації для різних типів сторінок (про це трохи нижче).

-

Google Indexing API — безплатний інструмент для масового сканування URL-адрес.

Важливо! Google Indexing API працює лише для сторінок з мікророзмітками Job Posting/BroadcastEvent для відео. Це сторінки з коротким циклом існування, і індексація через API забезпечує показ актуального контенту. Спроби використати його для індексації звичайних сторінок ніяк не спрацює: Google попередньо перевіряє запити на спам і відхиляє їх, якщо вони не відповідають вимогам.

Інструкція з налаштування Google Indexing API

Налаштування поділяється на шість етапів:

Далі розберу кожен етап детально.

Етап 1. Створення сервісного акаунту та JSON-ключа

Зайдіть у Google Cloud Platform та натисніть Console.

Далі, перейшовши в Console, клікніть наступну іконку.

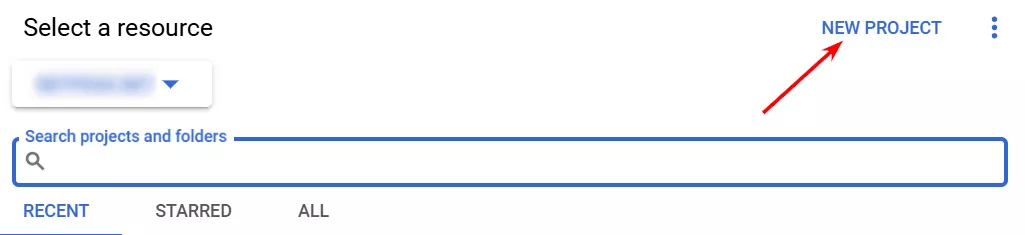

Оберіть «New Project».

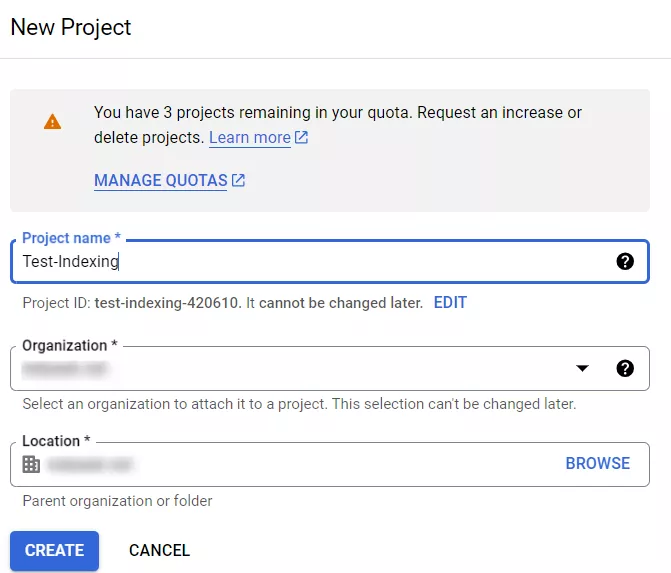

У вас з’явиться ось таке вікно.

В ньому необхідно вказати назву вашого проєкту (будь-яка зручна для вас), Organization — можна вказувати «No organization» та без Location. Якщо у вас корпоративна пошта, буде за замовчуванням вказана назва корпоративного домену в Location та в Organization. В такому випадку варіант «No organization» не буде доступний.

Закінчивши, натисніть «Create».

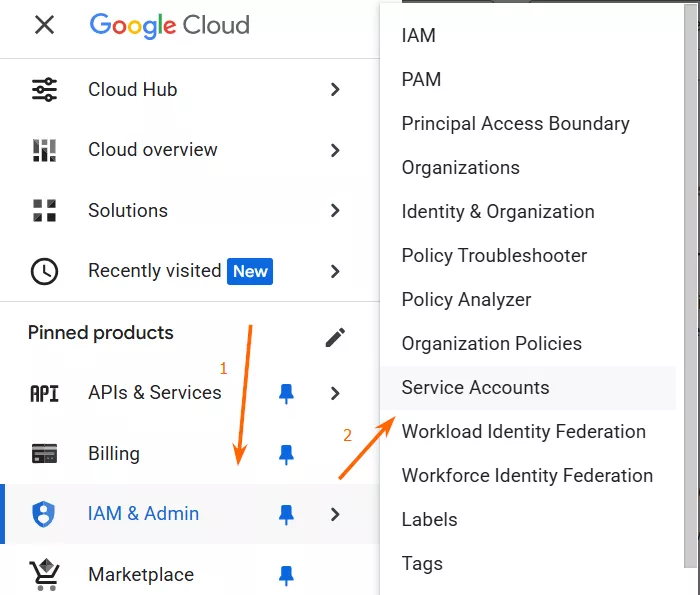

Коли проєкт створений, клікніть на навігаційне меню (три горизонтальні смужки) зліва зверху та перейдіть у Service Accounts.

Угорі натисніть кнопку «Create Service Account».

Детальніше про сервісний акаунт та його створення, розповіла в статті моя колега.

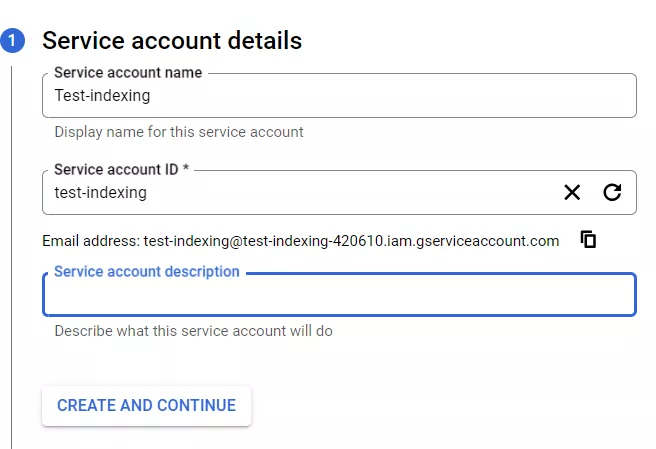

З’явиться вкладка.

Назву акаунту ви можете придумати самостійно, ID автоматично підтягнеться після її прописування. Опис сервісного акаунту можна пропустити, натискайте «Create and Continue».

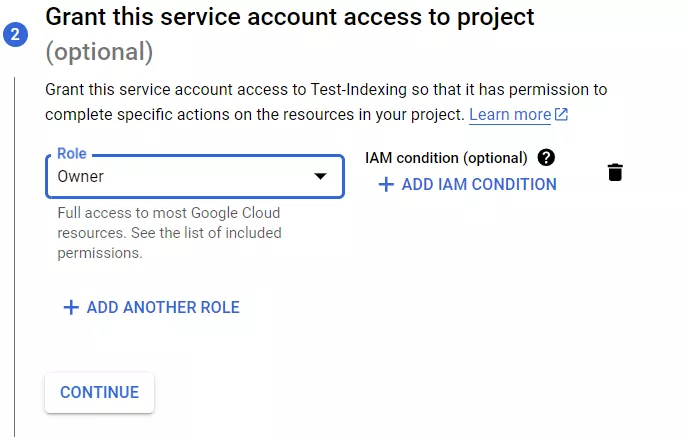

Далі оберіть роль «Owner» для сервісного акаунту. Вибір будь-якої іншої ролі не дасть вам змогу скористатись Google Indexing API для вашого сайту.

На третьому кроці можна надати доступи іншим до сервісного акаунту, втім, для цієї інструкції дана дія не обов’язкова, тож я її пропущу.

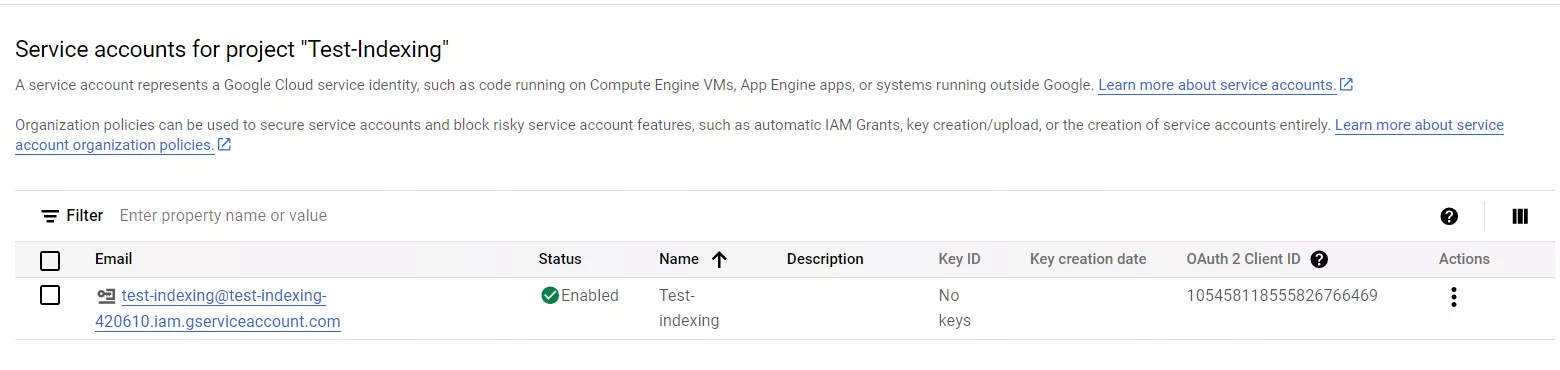

Натисніть кнопку «Done», після чого вас перекине на вкладку з ім’ям проєкту та email-адресою, яка знадобиться пізніше.

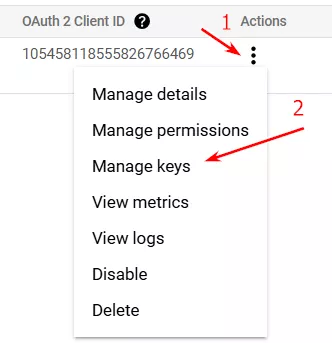

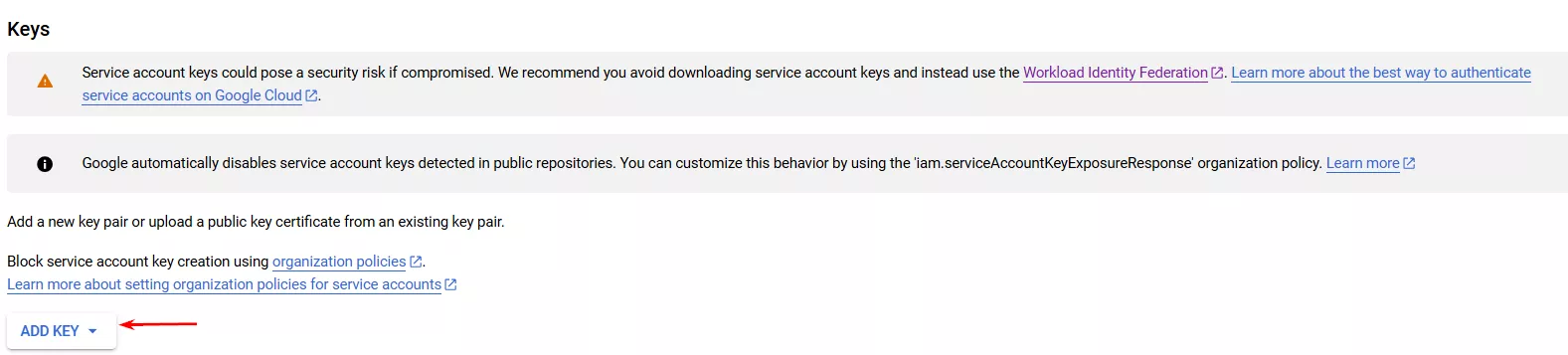

Далі натисніть на три крапки під «Actions» і оберіть «Manage Keys».

Після цього вас перекине на вкладку, де треба буде обрати «Add key».

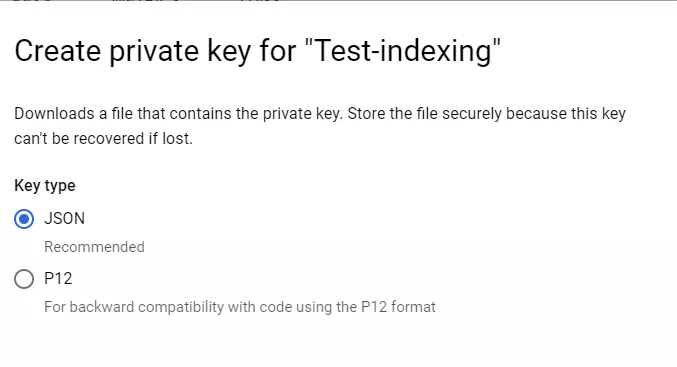

Вам буде запропоновано «Create new key». Оберіть формат JSON.

Ключ автоматично завантажиться на комп’ютер. В подальшому він знадобиться для додавання в файл service_account, про що йтиме мова в другому етапі.

Неможливо запустити скрипт для відправки сторінок на індексацію без створення сервісного акаунту і скачування JSON-ключа.

Етап 2. Підготовка теки проєкту

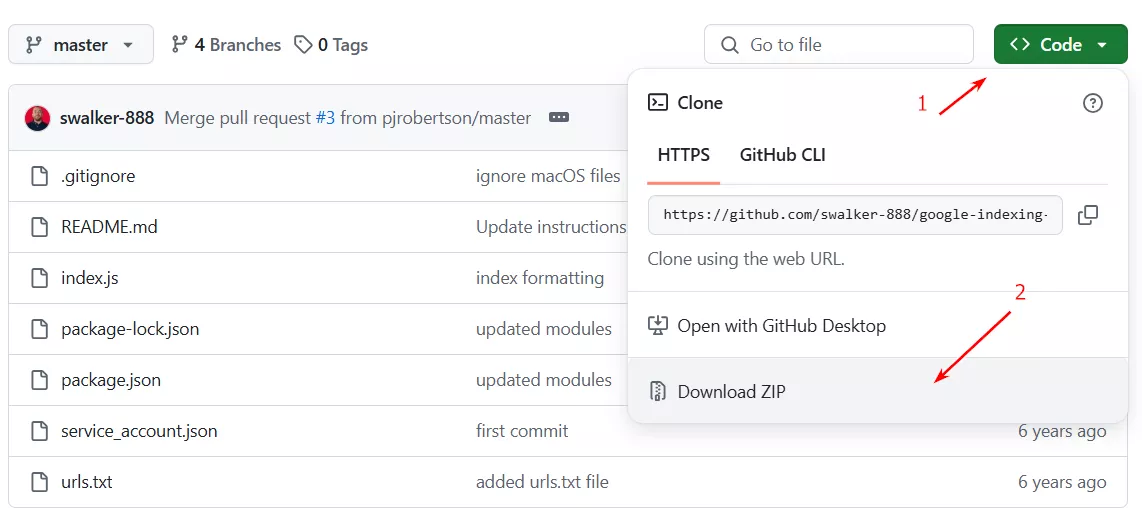

Перейдіть в Github (сервіс для спільної розробки ПЗ) та завантажте ZIP-архів проєкту.

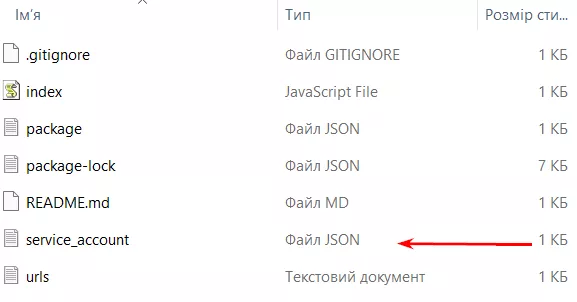

Розпакуйте теку. В ній буде список файлів, вам потрібен наступний.

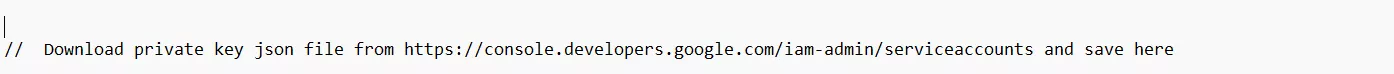

Відкрийте його і знайдіть наступний рядок.

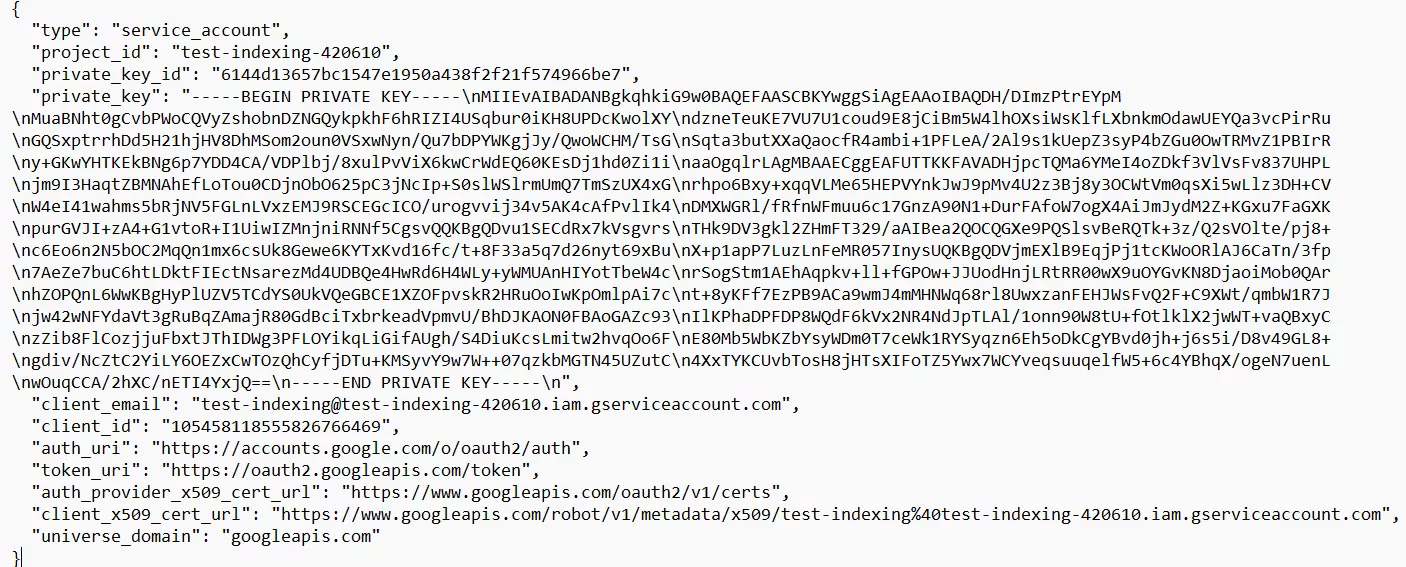

Замініть його повністю JSON-ключем, який ви скачали попередньо, і не забудьте зберегти файл. Має виглядати наступним чином.

Етап 3. Надання дозволів в Google Search Console

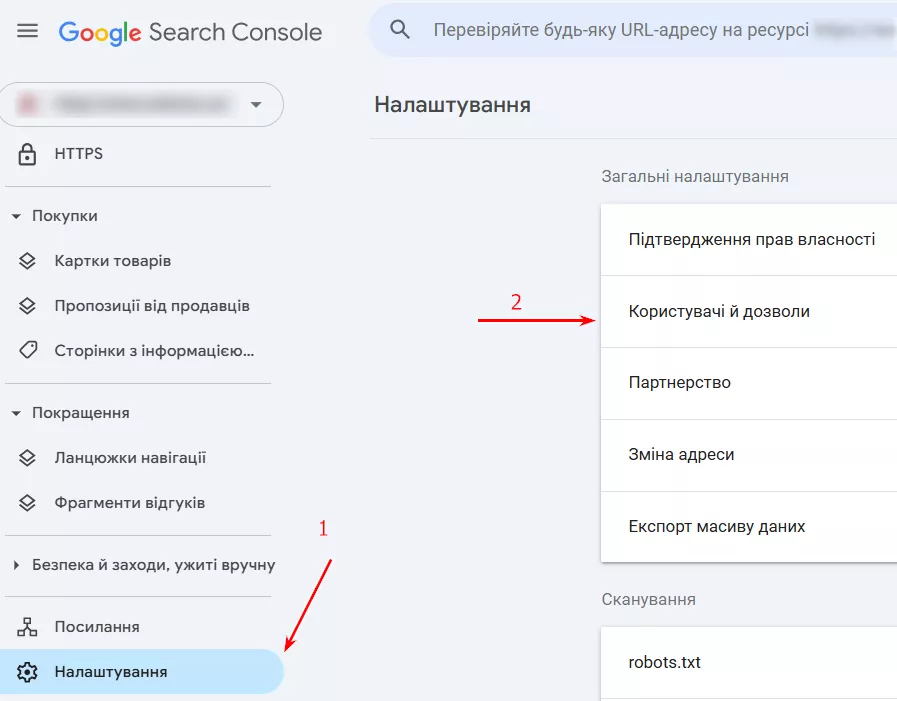

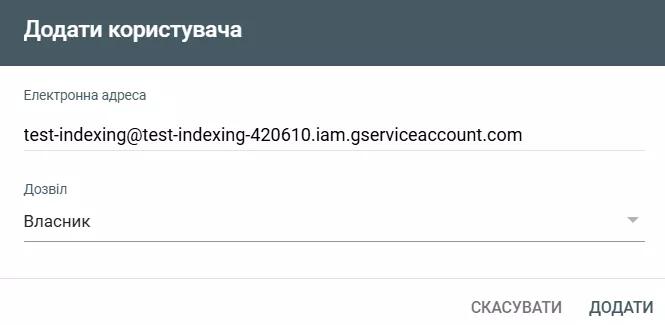

В GSC перейдіть в розділ «Налаштування» і зайдіть у вкладку «Користувачі та дозволи».

Натисніть кнопку «Додати користувача»і введіть email-адресу, яку ви отримали під час створення сервісного акаунту. Також призначте роль Власника (Owner), як робили це у Google Cloud Platform. Натисніть «Додати».

Етап 4. Підключення API в Google Cloud Platform

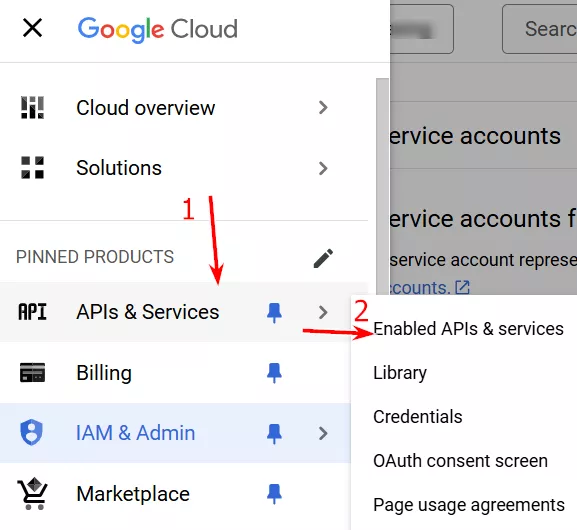

Поверніться в Google Cloud Platform, натисніть «Навігаційне меню», і перейдіть на вкладку «APIs & Services» і оберіть «Enabled APIs & services».

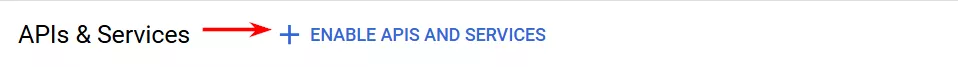

Угорі сторінки натисніть кнопку «Enable APIs and services».

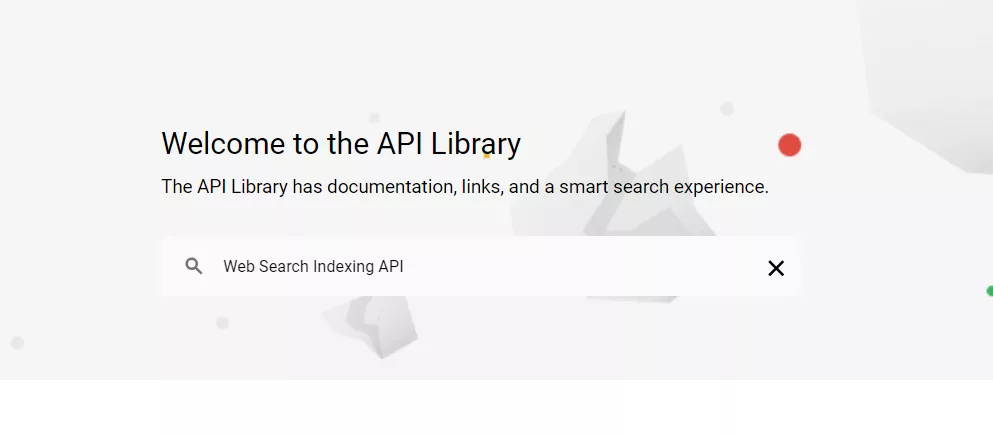

Після чого вас перекине на вкладку, вказану нижче, де ви маєте ввести в пошуковий рядок «Web Search Indexing API» і клікнути на результат пошуку.

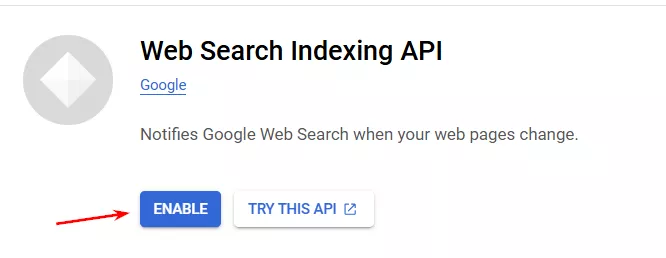

У вікні, що з’явиться, натисніть «Enable».

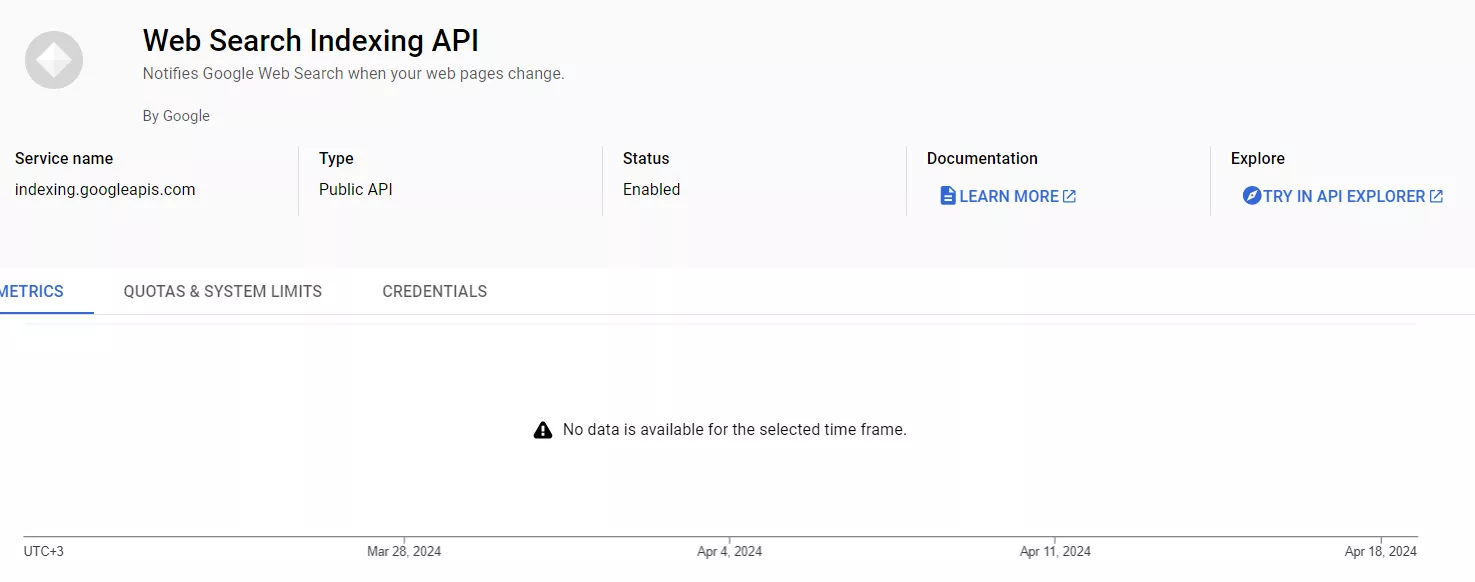

Після цього ви потрапите на екран налаштованого API.

Етап 5. Завантаження бібліотеки проєкту

Бібліотека — це набір функцій, класів, модулів та інших компонентів, які розробники використовують у застосунках для виконання певних задач. У нашому випадку бібліотека знадобиться для відправки URL-адрес на сканування та індексацію.

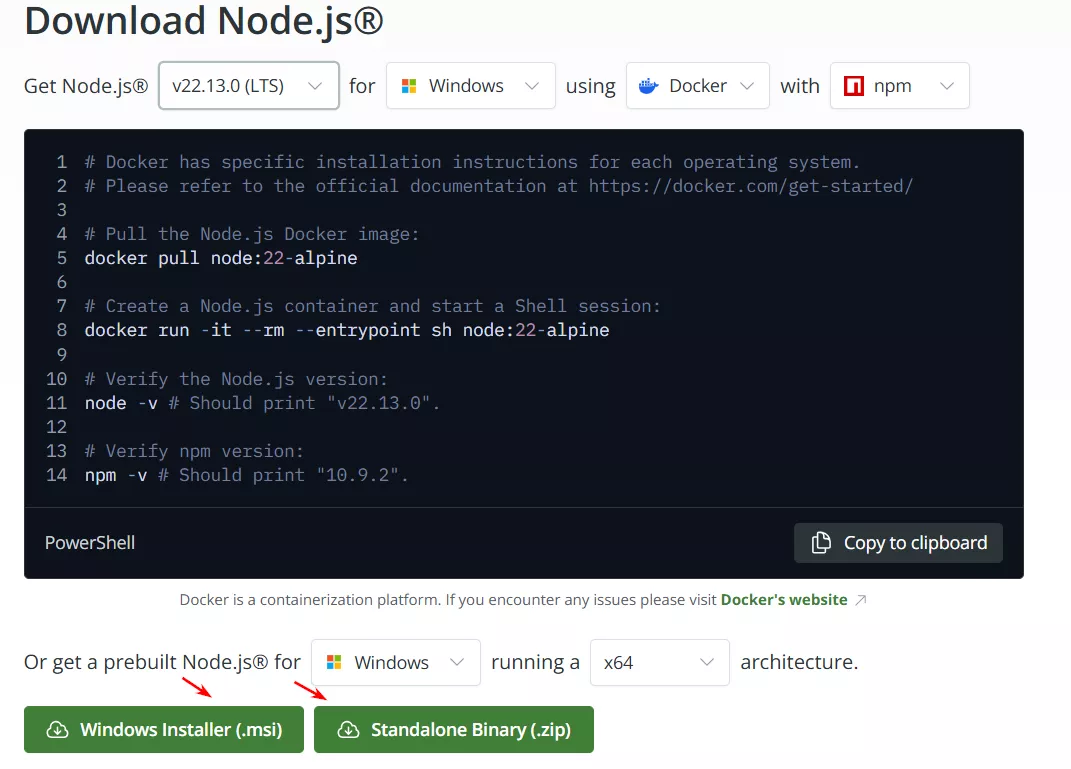

Для роботи вам знадобиться бібліотека Node.js. Перейдіть на сайт nodejs.org і оберіть вашу операційну систему, її версію та інші параметри. Після чого натисніть на одну з кнопок внизу, щоб завантажити бібліотеку в відповідному форматі.

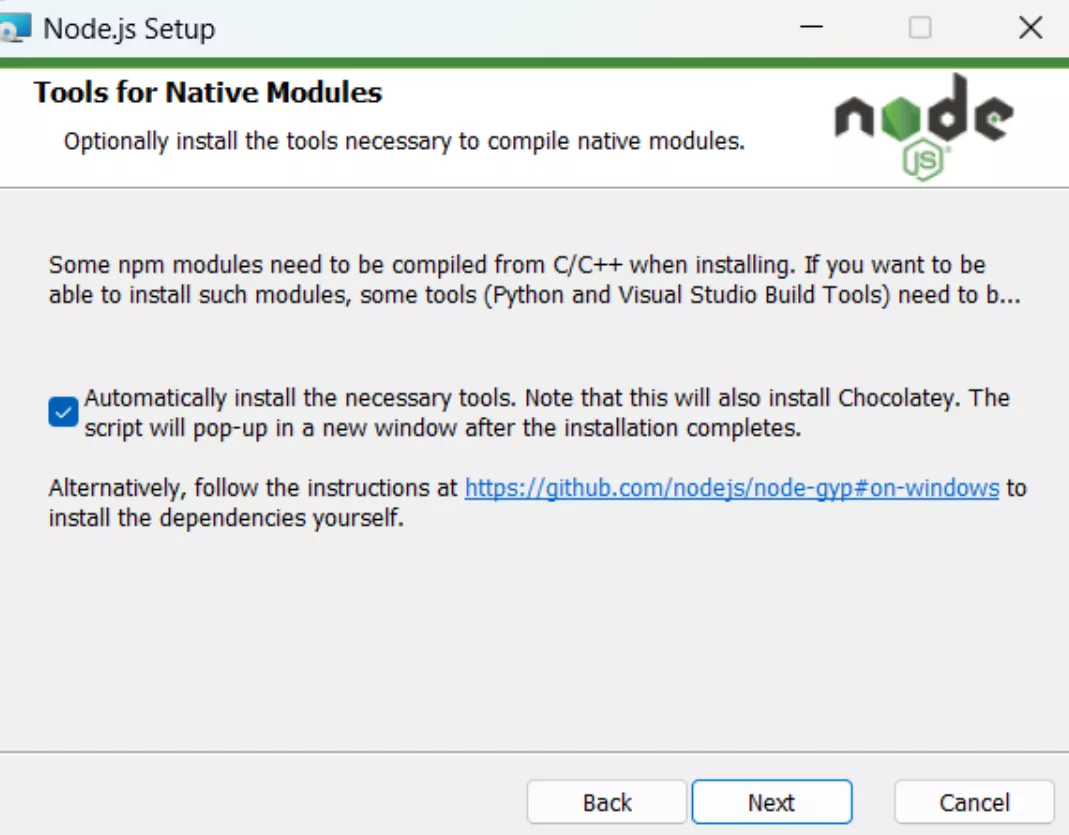

Далі розпочнеться стандартний процес встановлення. Єдине, на що варто звернути увагу — на етапі, що зображений внизу, необхідно поставити галочку. Це потрібно, щоб Node.js автоматично завантажував оновлення (для безпеки і продуктивності). Після чого завершіть інсталяцію та переходьте до фінального етапу.

Етап 6. Відправка сторінок на індексацію

Відберіть сторінки, які ви хочете відправити на сканування Google. Пам’ятайте про обмежений тип сторінок, що допускається до сканування та індексації через Google Indexing API.

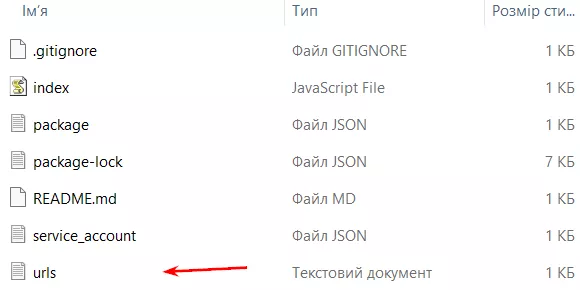

Зайдіть у теку, яку ви раніше створили для проєкту та оберіть файл «urls».

Внесіть сюди необхідні URL-адреси. За раз можна додати не більше 100, а всього за день — 200 адрес. Натисніть «Зберегти».

Після цього відкрийте Node.js через командний рядок Windows. Перед вам з’явиться ось така іконка. Натисніть на неї.

Відкриється цей екран.

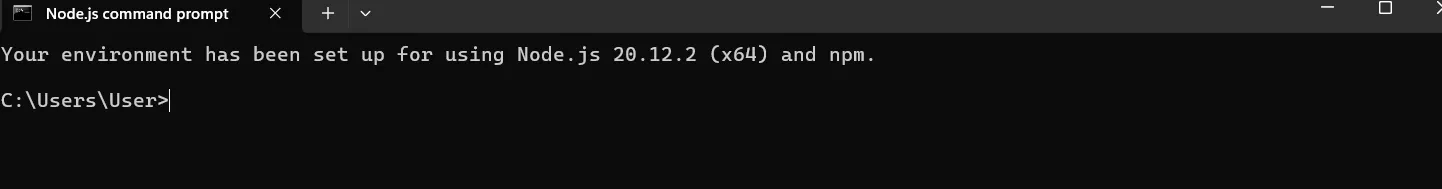

Щоб завантажити потрібні URL на сканування, вам необхідно ввести точний шлях до теки з необхідними URL-адресами. Для цього перейдіть в теку проєкту та натисніть правою кнопкою миші на останній рядок адресного шляху. У вас з’явиться можливість скопіювати адресу як текст.

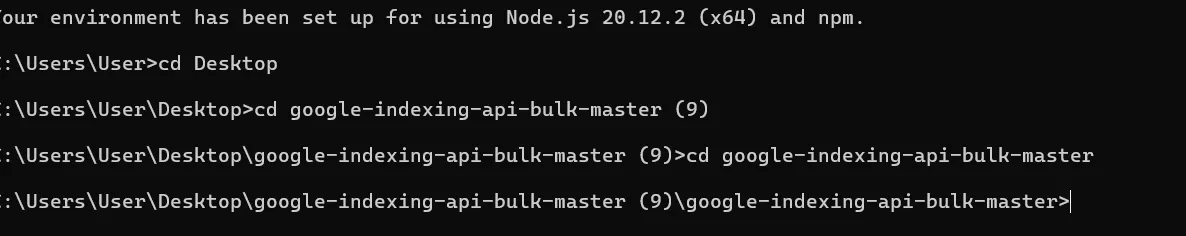

В моєму випадку адреса файлу наступна: C:\Users\User\Desktop\google-indexing-api-bulk-master (9)\google-indexing-api-bulk-master.

Після цього додайте кожен з елементів адреси в Node.js з приставкою cd. Це матиме такий вигляд.

Після того як додасте останній елемент шляху до папки, виконайте команди по черзі (впишіть одну команду — натисніть Enter, другу — Enter, і т. д.):

-

npm install requests

-

npm audit fix

-

npm audit fix --force

-

node index.js

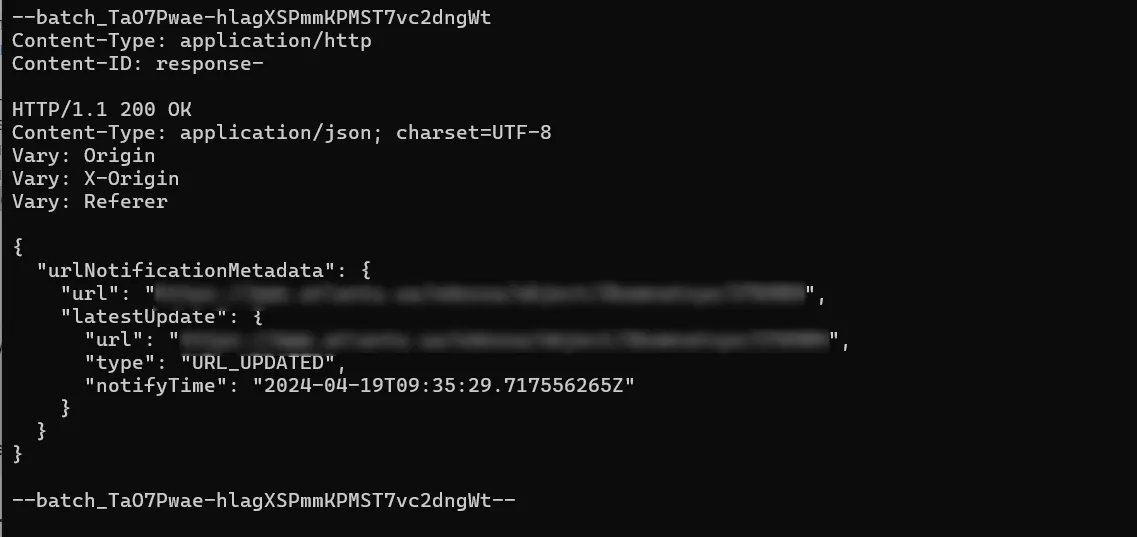

Якщо все зроблено правильно, ви побачите результат, подібний до цього.

Поширені проблеми використання Google Indexing API

Якщо під час роботи виникають помилки, перевірте наступні відповіді системи.

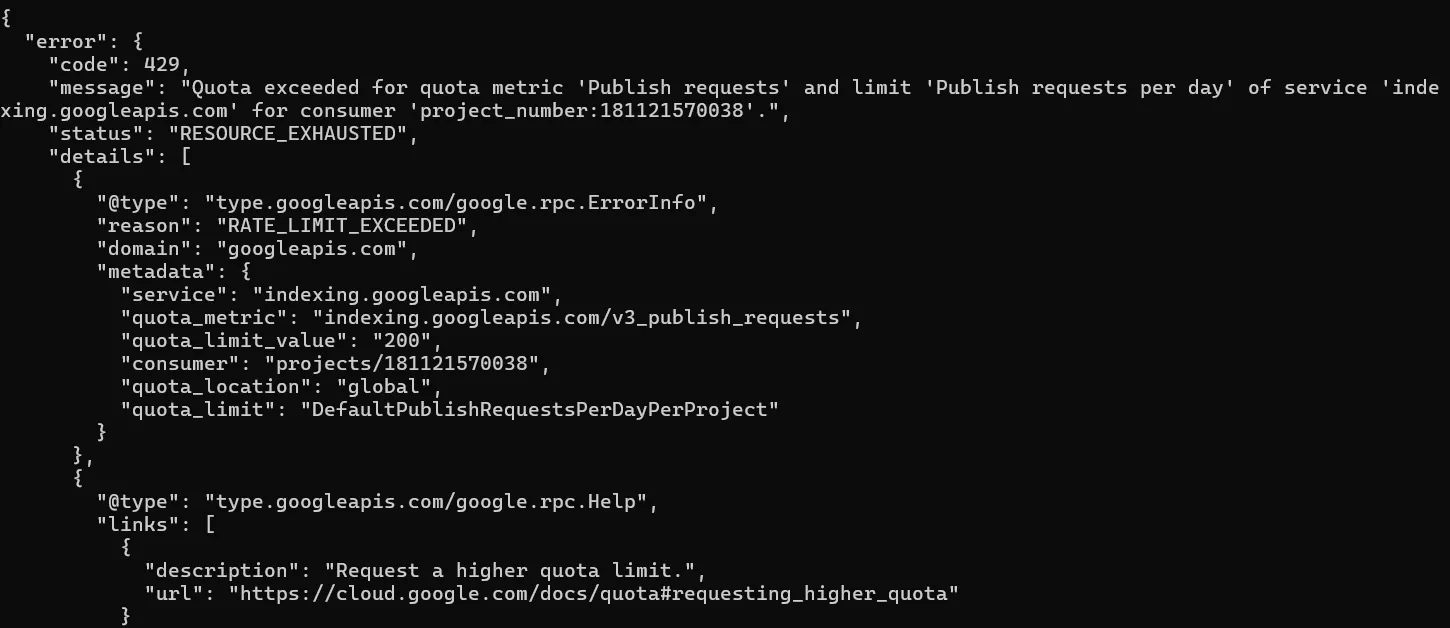

429 код — Too Many Requests

Виникає, якщо ви намагаєтеся відправити понад 200 URL-адрес на день для одного сайту.

Це не критична проблема: вам необхідно дочекатися 12 години ночі за північноамериканським тихоокеанським часом (це 10 ранку за Києвом) і повторно відправити URL на сканування.

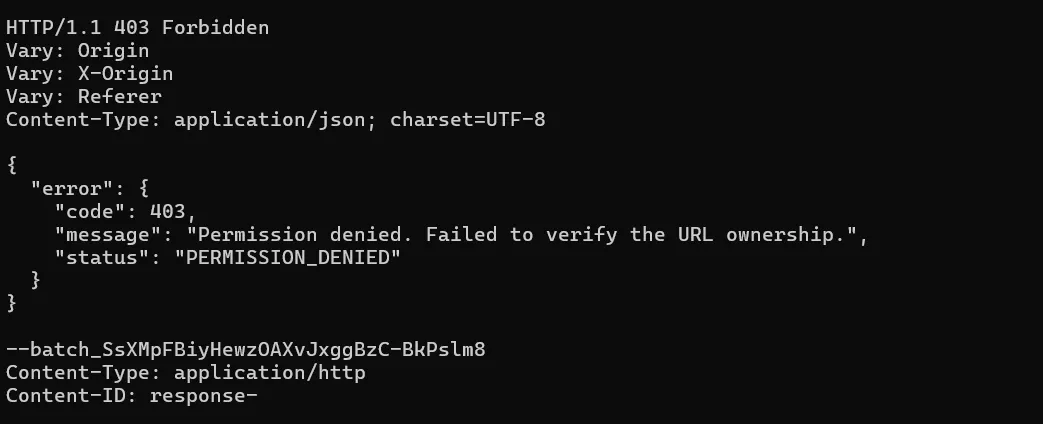

403 код — Forbidden

Даний код відповіді може з’явитись, якщо ви відправили на сканування URL-адреси іншого проєкту. Тобто: у вас є проєкти Х та У (різні сайти) і ви у файл «urls» теки проєкту Х додали URL-адреси проєкту У.

Для виправлення відправте URL-адреси через теку коректного проєкту.

Така ж помилка буде, якщо ви не прив’яжете пошту свого сервісного акаунту до Google Search Console, або зробите це, не вказавши роль «Власник».

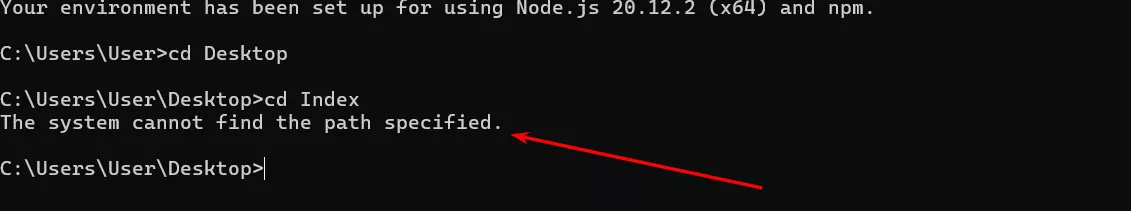

Система не може знайти вказаний шлях

Означає, що ви могли неправильно вказати шлях під час вводу елементів адреси теки в Node.js. Щоб уникнути, рекомендую копіювати та вставляти окремо кожен елемент адреси.

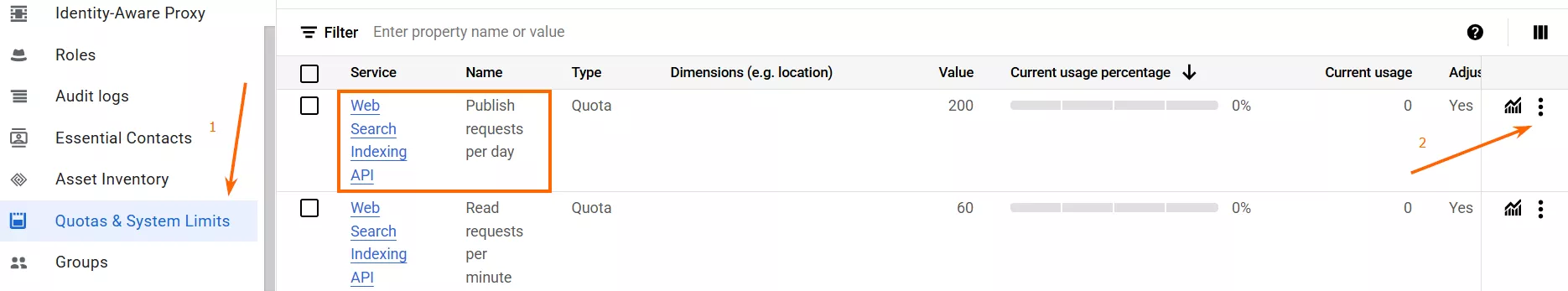

Чи можна відправляти більше 200 URL-адрес на день?

Так, але для цього необхідно подати спеціальний запит в Google на збільшення квот.

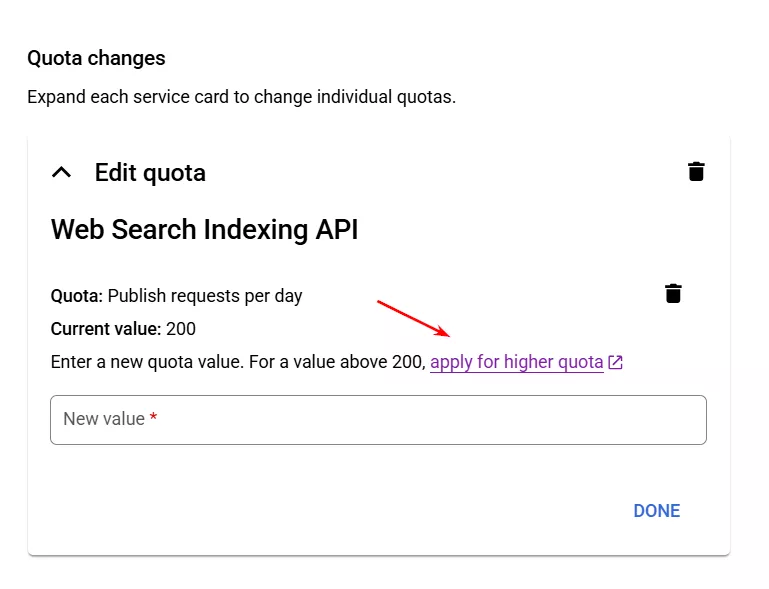

Зробити це можна в розділі «Quotas & System Limits» вашого акаунту в Google Cloud Console, натиснувши на три крапки навпроти сервісу «Web Search Indexing API — Publish Requests per Day». Після цього оберіть функцію «Edit Quota».

У формі, що з’явиться, перейдіть на опцію «Apply for higher quota».

Далі відкриється Google-форма, де треба вказати ім’я та прізвище, електронну пошту, бажану щоденну квоту, приклад URL, що буде відправлений на індексацію і, відповідно, випадок використання (для вакансій/прямих трансляцій).

На наступному етапі форми ознайомтеся з умовами збільшення квот, натисніть «Я зрозумів» і подайте заявку.

Врахуйте наступні моменти під час подачі заявки:

-

Прийняття рішення займає два-три тижні. Звертатися до Google за апдейтами немає сенсу.

-

Ні в результаті успіху, ні в результаті невдачі ви не отримаєте сповіщення від Google. Зрозуміти, чи все пройшло успішно, можна лише подивившись квоти на запити Google Indexing API через три тижні.

-

Google не пояснює причини відмови. Якщо ваш сайт відповідає вимогам (постинг вакансій/прямих трансляцій), але запит відхилено — подайте заявку повторно.

Що враховувати при індексації

Хоч Google Indexing API — корисний інструмент для сканування та індексації окремих типів сторінок, він не гарантує їхню індексацію. Якщо після використання інструменту ваші сторінки не з’явилися в індексі, врахуйте такі фактори:

-

Сторінка вже додана до індексу, але ще не показується в пошуці та/або в звіті Google Search Console. Період між додаванням у базу та реальною появою у видачі може коливатися від кількох годин до кількох тижнів. Це залежить від таких показників, як якість контенту, конкуренція у видачі, авторитет сайту, технічні аспекти.

В звіті Google Search Console сторінка теж може з’явитись не одразу, оскільки дані в Console потрапляють лише через певний час (зазвичай це 24–72 години).

-

Сторінка є дублем.

-

Сторінка має занадто низьку якість на думку Google.

-

Сторінка з редиректом.

-

Сторінка заблокована мета-тегом noindex або через robots.txt

-

Сторінка на період сканування віддавала 4xx або 5xx код відповіді.

Як перевірити індексацію сторінок

Для цього є такі інструменти:

-

Перевірка URL в Google Search Console.

-

Оператор site: в пошуку. Додаєте до site: потрібну URL-адресу. Якщо вона вже є в індексі, сторінка з’явиться у результатах пошуку.

-

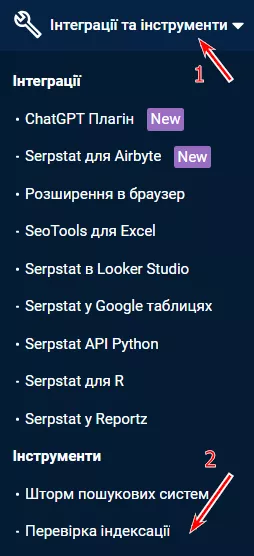

Перевірка індексації URL з допомогою сторонніх сервісів. Для масової перевірки індексації URL-адрес можна використовувати Serpstat. Інструмент доступний в розділі «Інтеграції та інструменти» — «Інструменти», де буде вкладка «Перевірка індексації».

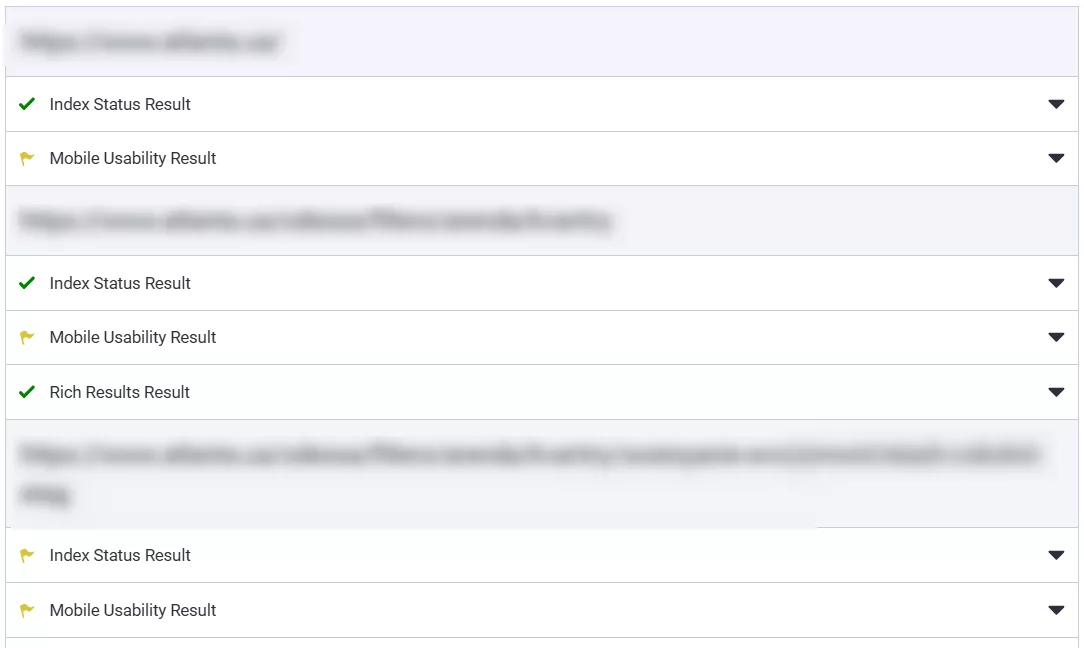

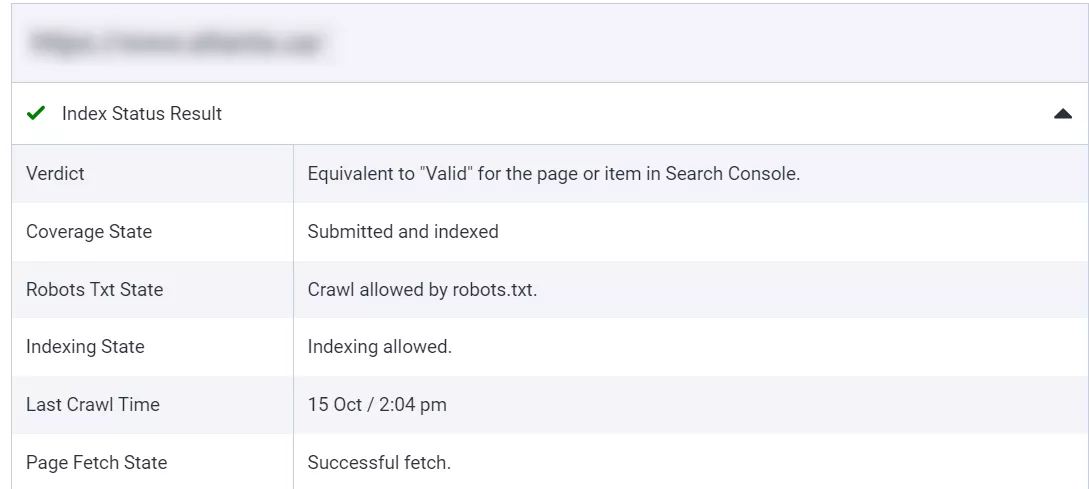

Далі обираєте необхідний домен. Попередньо необхідно додати ваш власний e-mail, який ви використовуєте в Serpstat, до Google Search Console проєкту у ролі «Власник», інакше ви не отримаєте результатів. Тоді додаєте URL-адреси, які вам необхідно перевірити (до 100 адрес за раз і до 2000 загалом на день), і натискаєте кнопку «Перевірити сторінки». Результати матимуть такий вигляд.

Index Status Result показує, чи знаходиться ваша сторінка в індексі пошукової системи Google. Може виникати ситуація, що в індексі сторінка вже є, але в результатах пошуку ще немає — в такому випадку треба почекати.

Якщо зелена галочка — все добре, якщо жовтий прапорець — щось заважає сторінці бути доданою в індекс: продивіться статус сторінки для того, щоб з’ясувати у чому причина.

Висновки

-

Індексація сайту — додавання сторінок та іншого вмісту сайту до баз даних пошукових систем. Без неї ваш сайт користувачеві буде неможливо знайти у пошуку.

-

Серед причин, що ускладнюють індексацію — низька якість сторінки, дубльований контент, ручні санкції або фільтри. Серед тих, що впливають на процес краулінгу — погана структура сайту, низька швидкість завантаження, велика кількість редиректів, битих посилань або 5хх помилок, відсутність мобільної версії, необроблюємі файли та директиви Robots.txt.

-

Щоб прискорити індексацію сторінок звичайними методами можна налаштувати грамотну внутрішню перелінковку, збільшити швидкість завантаження вмісту сайту, додати Sitemap, зменшити кількість битих посилань та редиректів. Серед інструментів можна виділити такі речі як Google Indexing API, ping-сервіси та інструмент перевірки URL від Google Search Console.

-

Процес підключення Google Indexing API включає в себе 6 базових етапів:

-

налаштування в Google Cloud Platform;

-

скачування ZIP-папки з GitHub, додавання ключа J-SON в файл service_account;

-

підключення пошти проєкту в Google Search Console;

-

підключення Web Search Indexing API до проєкту;

-

скачування бібліотеки, наприклад — node.js;

-

відправка URL-адрес на індексацію з допомогою node.js.

-

Серед частих помилок, що можуть виникнути при використанні Google Indexing API — 429 код — Too Many Requests, 403 код — Forbidden, Система не може знайти вказаний шлях.

-

Відправити за день з одного проєкту домену можна 200 URL-адрес, але можна відправити й більше — для цього необхідно запросити запит на збільшення квот через Google.

-

Для перевірки індексації можна скористатися як пошуковим оператором та інструментом перевірки URL від Google Search Console, так і сторонніми сервісами на зразок Інструмент перевірки індексації URL від Serpstat.

Свіжі

Меми в стресових ситуаціях і як їх використовують в маркетингу

Чи дійсно жарти під час апокаліпсиса є суто нашою українською рисою, і як бізнеси вдало запускають хвилю популярних мемчиків — собі во благо й всім на радість?

Чому користувачі видаляють застосунок і як цьому запобігти

Що саме змушує користувачів забувати і видаляти застосунок? Розбираємо і упереджуємо відтік юзерів

Як налаштувати розширену електронну торгівлю за допомогою Google Tag Manager

У цій статті розберу етапи побудови системи — від стратегії до кожної окремої події у воронці