10 найпоширеніших міфів та помилок технічного SEO

Пошукова оптимізація (SEO) є предметом численних міфів і хибних уявлень, особливо коли йдеться про технічну сторону. Щоб навчитися їх уникати, необхідно зрозуміти, як народжуються SEO-міфи, і які з них наразі є найпоширенішими.

Саме про це я розкажу далі в статті. Поїхали!

Як виникають SEO-міфи

- Неправильне тлумачення рекомендацій. Пошукові системи, такі як Google, надають рекомендації та найкращі практики для SEO, але вони часто неправильно інтерпретовані або вирвані з контексту.

- Застаріла інформація. SEO-індустрія надзвичайно динамічна, а це означає, що колись ефективні практики можуть вже не працювати сьогодні. Багато джерел в інтернеті не оновлюють інформацію на своїх сторінках вчасно. Деякі з них лише змінюють дату публікації чи оновлення статті на свіжішу для залучення більшої кількості відвідувачів.

- Кореляція не дорівнює причинно-наслідковому зв’язку. Деякі SEO-фахівці, помічаючи кореляцію між певними факторами та вищими позиціями у видачі, часто помилково вважають її причинно-наслідковим зв’язком. Якщо фахівець відомий і авторитетний, такий міф швидко пошириться. Насправді причинно-наслідковий зв’язок в SEO — рідкісне явище через величезну кількість параметрів і змінних.

- Складність алгоритмів. Мінливі алгоритми пошукових систем складно до кінця зрозуміти, особливо враховуючи, що певні їхні аспекти ретельно тримаються в секреті. Нерозуміння певних понять, механізмів і процесів призводить до вигадок, які заповнюють прогалини у знаннях.

- Надмірне спрощення. Спроба пояснити складні SEO-концепції простими словами іноді призводить до надмірного скорочення й, як наслідок, викривлення інформації.

- Клікбейт. Деякі автори контенту навмисно поширюють SEO-міфи, щоб залучити аудиторію на свої сайти. Сенсаційна або суперечлива інформація має тенденцію поширюватися набагато краще і швидше.

Міф 1. Технічне SEO — це одноразова річ

Згідно з однією з найбільш поширених помилок, технічну оптимізацію достатньо зробити на етапі розробки сайту або для вже існуючого сайту, але тільки один раз. Було б непогано, чи не так?

Технічне SEO — це безперервний процес.

Принаймні, воно повинно бути таким, щоб досягти максимальної ефективності та рентабельності. Google та інші системи постійно вдосконалюють свої алгоритми, намагаючись забезпечити користувачів найкращими результатами пошуку, щоб вони поверталися до них знову і знову.

Яскравим прикладом цього є INP (Interaction to Next Paint) — нова метрика Core Web Vitals, яка замінила FID (First Input Delay) у березні 2024 року. Вона дозволяє краще і повніше виміряти адаптивність сторінки, відображаючи те, як користувачі насправді її сприймають.

Бізнеси, що вже оптимізували свій сайт за новою метрикою, досягли поліпшення SEO-показників і отримали значну перевагу. Це підтверджує кейс платформи електронної комерції Trendyol, яка знизила свій INP на 50% і покращила CTR на 1%.

І навіть якщо у вас надзвичайно досвідчений і кваліфікований розробник, технічні проблеми все одно виникають після нових впроваджень через специфіку CMS, сторонні ресурси і безліч інших чинників. Особливо це стосується великих сайтів.

Саме тут наявність SEO-фахівця або, в ідеалі, спеціальної команди, залученої до цього процесу, стає неоціненною. Тісно співпрацюючи з розробниками, вони надають рекомендації, як впроваджувати зміни з урахуванням найкращих практик SEO. Потім, після завершення роботи, вони перевірять, чи все було впроваджено правильно і чи не виникли нові проблеми.

Міф 2. Технічне SEO потрібне лише для пошукових систем

Насправді технічне SEO дійсно впливає на ранжування, але воно також важливе як для користувачів, так і для самого бізнесу.

Чим краща реакція на взаємодію, чим стабільніша сторінка візуально, тим швидше завантажуються наступні сторінки і тим більше користувач:

- захоче залишитися на такому сайті;

- виконає певну цільову дію;

- повернеться на сайт в майбутньому;

- порекомендує сайт друзям або своїй аудиторії (а це можливість отримати зворотне посилання).

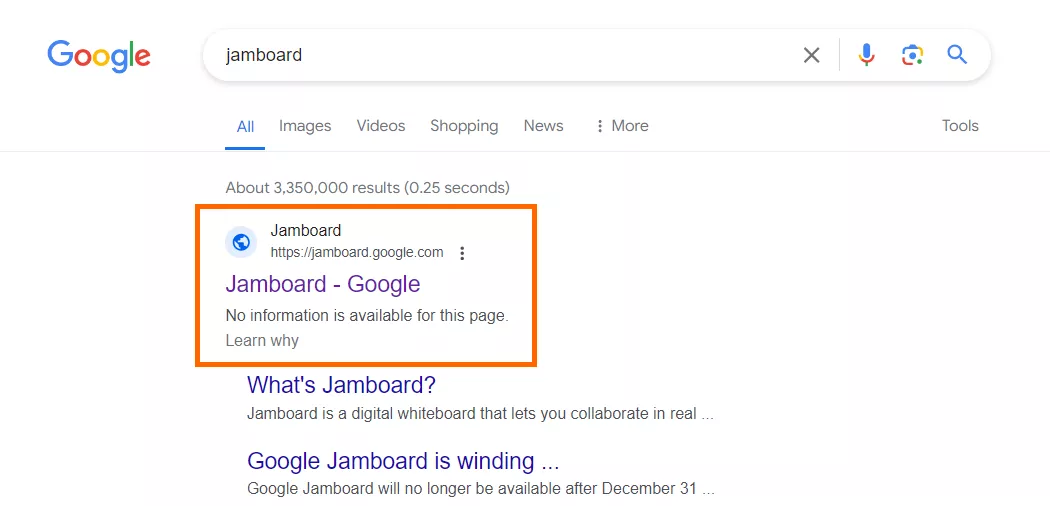

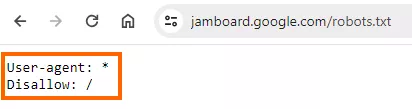

Міф 3. Robots.txt може заблокувати індексацію сторінки

Насправді robots.txt використовується лише для керування скануванням сайту, щоб вказати роботові, які можна сканувати, а до яких йому доступ заборонено. Це стосується «слухняних» краулерів, таких як Googlebot, оскільки деякі зловмисні роботи можуть не виконувати директиви, розміщені у файлі.

Якщо ви вирішили заборонити індексацію сторінки за допомогою файлу robots.txt, все одно є ймовірність знайти її в результатах пошуку. Хоча краулер не буде здатний просканувати таку сторінку, система все одно може додати її до свого індексу, якщо посилання на неї розміщено на іншій сторінці.

Це відбувається, коли пошуковик вважає, що сторінка була заблокована в robots.txt помилково. Щоб зрозуміти її вміст і відобразити в результатах пошуку, система використовує анкорний текст. Для прикладу.

На наступному скріншоті видно, що сайт заблокований для сканування.

Google зазначає у своїй документації, що файл robots.txt не є засобом для запобігання індексації сторінок у Google.

Щоб заблокувати сторінку від індексації, необхідно або обмежити доступ до неї за допомогою пароля, або додати метатег noindex до її блоку <head>:

<meta name="robots" content="noindex">Міф 4. Атрибути нумерації сторінок rel="next" та rel="prev" є сигналами ранжування

Атрибути нумерації сторінок rel="next" і rel="prev" — це HTML-теги, які раніше допомагали Google зрозуміти взаємозв’язок між сторінками сайту. Дехто вважає, що це досі так, але з 2019 року ці атрибути перестали бути сигналами для індексації:

Spring cleaning!

– Google Search Central (@googlesearchc) March 21, 2019

As we evaluated our indexing signals, we decided to retire rel=prev/next.

Studies show that users love single-page content, aim for that when possible, but multi-part is also fine for Google Search. Know and do what's best for your users! #springiscoming pic.twitter.com/hCODPoKgKp

Якщо на вашому сайті використовуються атрибути rel="next" і rel="prev", необов’язково їх видаляти: вони не завдають шкоди і корисні для пошуковика Bing. Однак, якщо ви не просуваєте свій сайт цілеспрямовано для Bing або інших пошукових систем, які все ще підтримують ці атрибути, додавати їх — марна трата часу й зусиль.

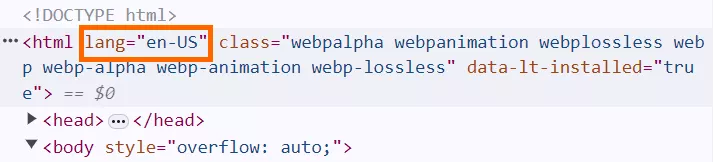

Міф 5. Атрибут HTML Lang допомагає з локалізацією сайту

Атрибут lang — це один з атрибутів тегу <html>, який дозволяє вказати мову сторінки. Його можна знайти на більшості сторінок.

Зверніть увагу, що «US» в цьому випадку — це не цільова країна сторінки, а діалект мови. Це означає, що текст сторінки написаний американською англійською.

Міф, пов’язаний з цим атрибутом, полягає в тому, що він необхідний для локалізації сайту і сприяє кращому ранжуванню локалізованих сторінок. Насправді ж Google ігнорує цей атрибут, оскільки часто зазначена в ньому мова є некоректною, а пошукова система використовує власні алгоритми для визначення мови сторінки.

Про це заявив Джон Мюллер, представник Google, у своїй відеовідповіді.

Тому помилково вважати, що використання атрибута lang допомагає оптимізувати локалізовані версії сторінок. Для цього необхідно використовувати або атрибут hreflang HTML/HTTP заголовка, або атрибут xhtml:link XML Sitemap.

Водночас видаляти атрибут lang не обов’язково. Він все ще корисний, наприклад, для інструментів перекладу або доступності, таких як зчитувачі з екрана.

Міф 6. Вихідні посилання погано впливають на SEO

Згідно з концепцією посилальної маси або, як її ще називають, «посилального соку», за допомогою вхідних лінків сайт отримує цінність від зовнішнього ресурсу, а за допомогою вихідних — передає цю цінність. Тому здається, що найкраще мати якомога більше вхідних посилань і зовсім не мати вихідних. Однак це не завжди так.

Додавання занадто великої кількості лінків, особливо у випадку посилань на ресурси, що не мають відношення до тематики сайту, видасться пошуковій системі дивним і навіть може завдати певної шкоди. Однак додавання прийнятної кількості, коли посилання доречні й корисні для користувача, сприяє зміцненню Е-Е-А-Т і, як наслідок, кращому ранжуванню, особливо в YMYL-нішах.

YMYL-ніші — це типи ресурсів з контентом, який може суттєво вплинути на фінансову стабільність, здоров’я, безпеку або добробут людини. Google висуває до таких сайтів вищі вимоги щодо якості, точності та правдивості контенту.

Твердження, озвучене Джоном Мюллером у першому епізоді «Запитайте вебмайстрів Google», доводить це:

Посилання на інші сайти — чудовий спосіб забезпечити користь для ваших користувачів. Часто посилання допомагають їм дізнатися більше, перевірити джерела і краще зрозуміти, наскільки ваш контент відповідає їхнім запитам.

Порада: щоб підсилити ефект, посилайтеся на ті тематично пов’язані та авторитетні ресурси. Вони мають бути дійсно цікавими та корисними вашій цільовій аудиторії, а не просто вести на будь-який авторитетний сайт.

Наприклад, якщо ви просуваєте кулінарну сторінку, замість посилання на Вікіпедію дайте лінк на відповідну статтю Гордона Рамзі. У більшості випадків це буде цікавіше для ваших відвідувачів і дасть чіткіший сигнал пошуковій системі.

Використовуйте також відповідні атрибути rel:

- rel="nofollow" або rel="ugc", щоб запобігти передачі посилальної цінності зовнішнім ресурсам;

- target="_blank" для відкриття зовнішніх лінків у новій вкладці;

- rel="noopener noreferrer", щоб уникнути проблем з безпекою.

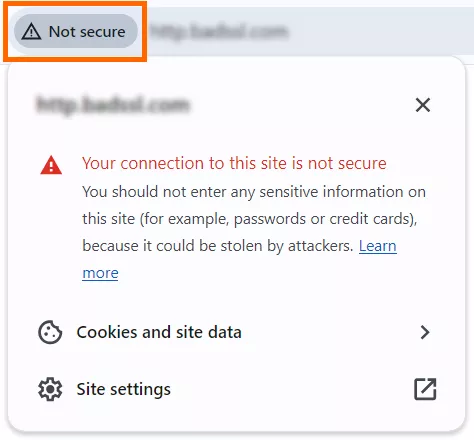

Міф 7. HTTPS не потрібен

Hypertext Transfer Protocol Secure (захищений протокол передачі гіпертексту) — це спосіб забезпечити зашифрований і захищений зв’язок між користувачем і сайтом.

Припущення, що HTTPS неважливий — одне із найхибніших уявлень. Впровадження цього протоколу на сайті є необхідним, бо:

- HTTPS — це сигнал для ранжування. Про це у серпні 2014 року оголосив Google Search Central Blog:

...протягом останніх кількох місяців ми проводили тести, які враховували, чи використовують сайти безпечні, зашифровані з’єднання в якості сигналу в наших алгоритмах ранжування. Ми побачили позитивні результати, тому починаємо використовувати HTTPS як сигнал для ранжування.

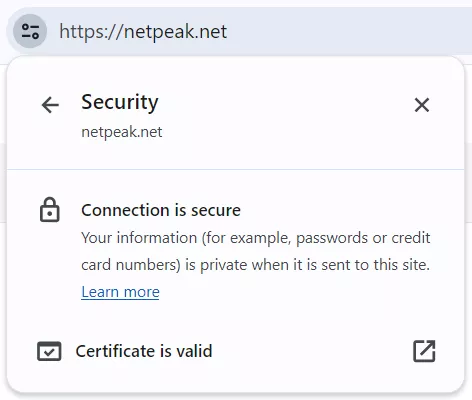

- Довіра користувачів. HTTPS гарантує безпечну передачу даних для відвідувачів сайтів і зараз є загальновизнаним стандартом. Користувачів про це інформує наступне повідомлення.

Відповідно, якщо HTTPS належним чином реалізований на сайті, такого повідомлення немає.

Користувачі можуть з пересторогою ставитися до сайтів, які все ще використовують протокол HTTP, часто залишаючи їх ще до того, як сайт завантажиться.

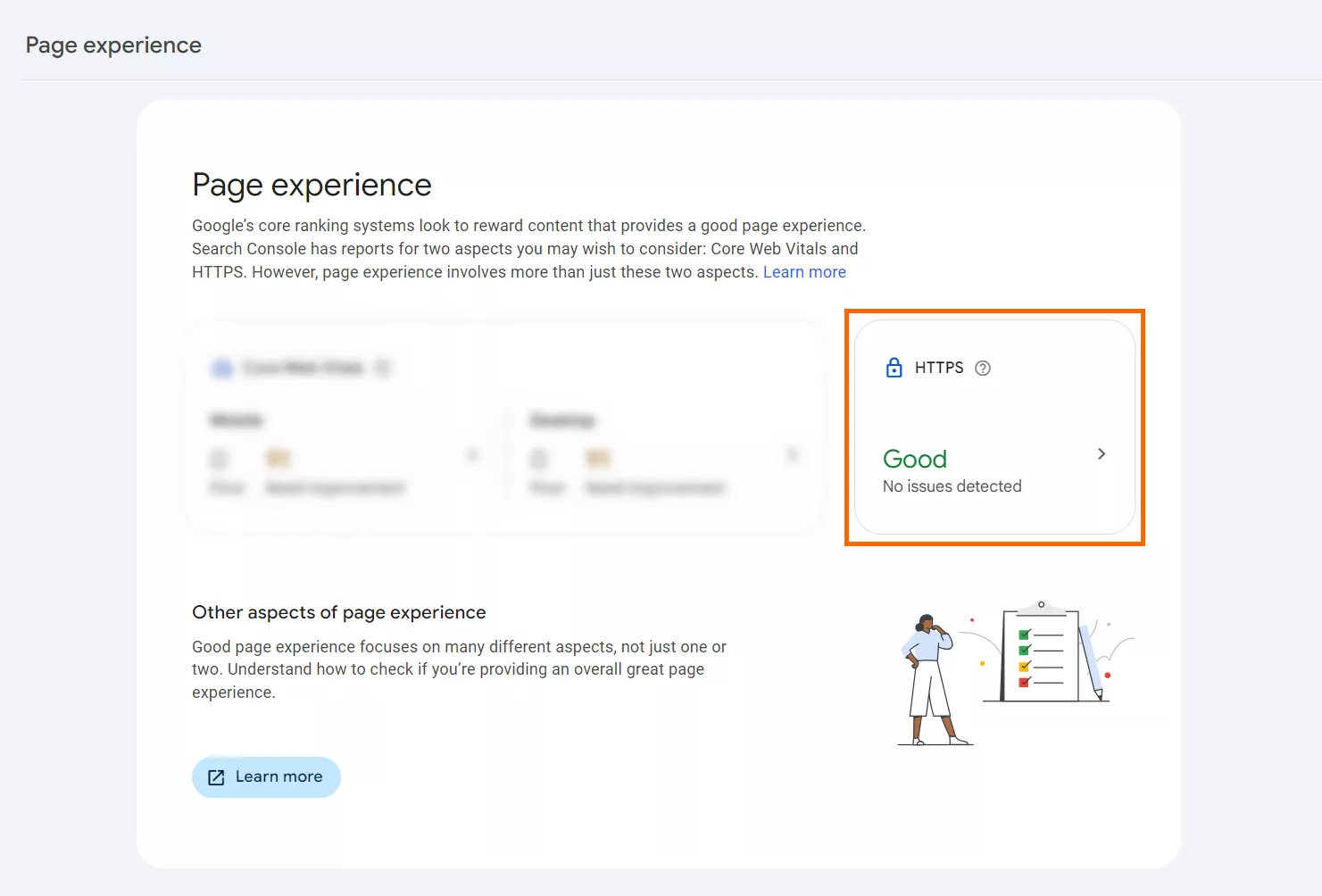

- Наявність HTTPS є одним із критеріїв Google при оцінці Page Experience і відповідного звіту в Search Console.

Детальніше про цю оцінку та звіт читайте в документації Google.

Міф 8. Швидкість сторінки не впливає на ранжування

Оптимізація швидкості завантаження сторінок — завдання не з легких і вимагає відповідних знань, зусиль і часу. Однак воно однозначно того варте. На це є кілька причин:

- Швидкість сторінки є фактором ранжування для десктопів вже майже півтора десятиліття. Про це свідчить відповідна заява Google від квітня 2010 року:

Наші користувачі, як і ми, надають великого значення швидкості — саме тому ми вирішили враховувати швидкість сайту при ранжируванні в пошуковій видачі.

- З липня 2018 року швидкість сторінки на мобільних пристроях також стала одним із факторів ранжування в алгоритмі Google. Підтвердження цьому — цитата з відповідного посту в блозі Google Search Central Blog:

Люди хочуть мати можливість знаходити відповіді на свої запитання якомога швидше — дослідження показують, що користувачам дійсно важлива швидкість сторінки. Хоча швидкість вже деякий час використовується при ранжируванні, цей сигнал був зосереджений на десктопному пошуку. Сьогодні ми оголошуємо, що з липня 2018 року швидкість сторінки стане фактором ранжування і для мобільного пошуку.

- Оптимізація швидкості завантаження вашого сайту не тільки допомагає займати вищі позиції у видачі, але й покращує бізнес-показники, зокрема коефіцієнт конверсії. Прикладом цього є Yelp, який збільшив конверсію на 15%, оптимізувавши FCP з 3,25 секунд до 1,8.

Міф 9. Адаптивність до мобільних пристроїв неважлива

Це твердження абсолютно не відповідає реаліям сучасного цифрового світу, коли кількість мобільних пошукових запитів стрімко зростає. Наявність сайту, адаптованого для мобільних пристроїв, є обов’язковою для будь-якого бізнесу або організації, яка хоче ефективно охопити свою аудиторію, адже:

- Люди все більше покладаються на мобільні пристрої для вирішення певних завдань, пошуку інформації та здійснення покупок. Водночас, користувачі мобільних пристроїв очікують, що сайти, які вони використовують для цих цілей, будуть швидкими, адаптивними та зручними для навігації.

Ресурси, які добре працюють на мобільних пристроях, можуть значно підвищити задоволеність користувачів і зменшити показник відмов. Такі функції, як великі, помітні кнопки, на які зручно натискати, читабельний текст без масштабування та оптимізований контент допомагають у цьому. - Окрім забезпечення зручного користувацького досвіду, оптимізація під мобільні пристрої є фактором ранжування в Google. Про це свідчить уривок з блогу Google Search Central:

Починаючи з 21 квітня, ми розширюємо наше застосування адаптивності для мобільних пристроїв як сигналу ранжування. Ця зміна торкнеться мобільного пошуку всіма мовами світу і матиме значний вплив на нашу пошукову видачу. Таким чином, користувачам буде простіше отримувати релевантні, якісні результати пошуку, оптимізовані для їхніх пристроїв.

Сайти, не оптимізовані для мобільних пристроїв, будуть займати нижчі позиції в мобільній видачі.

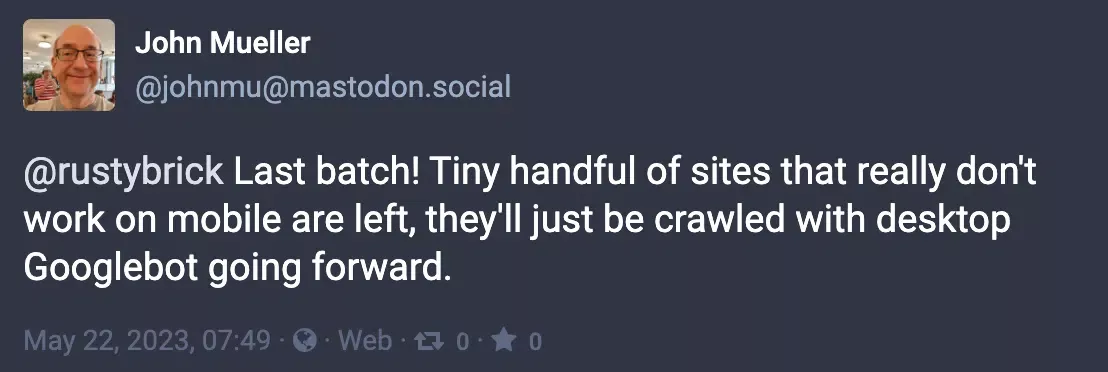

- Навіть якщо частка мобільних користувачів на вашому сайті незначна, не нехтуйте мобільною адаптивністю. В листопаді 2016 року був оголошений підхід mobile-first і почав тестуватися на деяких сайтах. Станом на травень 2023 року всі сайти, крім тих, які працюють лише на десктопі, були переведені на індексацію в першу чергу для мобільних пристроїв.

Міф 10. XML-карти сайту корисні лише для великих сайтів

XML-файл — це файл, в якому ви надаєте список посилань на сторінки, які вважаєте важливими і хотіли б, щоб пошукові системи сканували їх в першу чергу. XML-карти сайту корисні для середніх і малих сайтів, а саме:

- Допомагають пошуковим системам знаходити та індексувати всі сторінки сайту, гарантуючи, що жодна з них не буде пропущена. Це особливо актуально для сайтів, які не мають належного внутрішнього перелінкування. XML-файл також корисний для ресурсів, які не мають багато зовнішніх посилань, що вказують на нього.

- Для інформування пошуковиків про нові додані або оновлені сторінки, що дозволяє пришвидшити сканування та індексацію. Для цього необхідно використовувати атрибут lastmod. Можливість повідомляти систему про появу нової сторінки на сайті особливо корисна для новинних сайтів. Для них існує окремий тип карти сайту, називається News sitemap.

Створення й надсилання XML-карти сайту до пошукових систем — відносно простий процес, навіть для невеликих сайтів або сайтів з обмеженими технічними ресурсами. Існують плагіни для CMS і інструменти SEO, які можуть автоматично генерувати карти сайту.

Наприклад, Netpeak Spider має для цього вбудовану функцію Sitemap generator. Він також надає можливість перевірки вже наявного XML-файлу.

Як уникнути міфів і помилок в SEO

Алгоритми пошуковиків постійно розвиваються. Методи, ефективні в минулому, виявляються застарілими, а іноді навіть шкідливими. Вкрай важливо бути в курсі актуальних практик SEO та змін алгоритмів, отримуючи інформацію з авторитетних джерел, як-от:

Використовуючи будь-які інші ресурси, обов’язково перевіряйте факти, які здаються вам навіть трохи сумнівними або суперечливими. Крім того, перевіряйте актуальність: статті, написані рік чи два тому, можуть містити застарілі або нерелевантні дані.

Висновки

- Технічне SEO є вирішальним складником успішної присутності в онлайні, а розвіювання поширених міфів і хибних уявлень допомагає ефективніше проводити оптимізацію.

- Міфи про SEO можуть виникати з різних причин, зокрема через застарілу інформацію, неправильне тлумачення рекомендацій пошукових систем і спрощення складних понять.

- Оскільки пошукові системи постійно оновлюють свої алгоритми, важливо залишатися обізнаними та покладатися на авторитетні ресурси, щоб відокремлювати факти від вигадок.

FAQ

Чи технічне SEO варте вкладених коштів?

Так, технічне SEO варте інвестицій. Воно не тільки покращує видимість сайту в пошукових системах, але й загальний користувацький досвід, що збільшує трафік, покращує залучення та показники конверсії.

Скільки часу займає технічне SEO?

Час, необхідний для технічної оптимізації, варіюється залежно від розміру і складності сайту, а також кількості технічних SEO-проблем, які необхідно вирішити. Деякі поліпшення технічної оптимізації можна впровадити відносно швидко, тоді як інші можуть вимагати більш значних зусиль. Це безперервний процес, який вимагає регулярного моніторингу та корегування.

Скільки коштує технічне SEO?

Вартість технічного SEO сильно варіюється залежно від таких факторів, як розмір сайту, обсяг необхідних робіт, використовувана CMS, а також від того, чи залучаєте ви агентство, фрилансера або виконуєте його власними силами. Деякі CMS, особливо кастомні, можуть мати певні особливості та обмеження, які можуть перешкоджати SEO і вимагати додаткових зусиль для їх усунення.

Свіжі

Меми в стресових ситуаціях і як їх використовують в маркетингу

Чи дійсно жарти під час апокаліпсиса є суто нашою українською рисою, і як бізнеси вдало запускають хвилю популярних мемчиків — собі во благо й всім на радість?

Чому користувачі видаляють застосунок і як цьому запобігти

Що саме змушує користувачів забувати і видаляти застосунок? Розбираємо і упереджуємо відтік юзерів

Як налаштувати розширену електронну торгівлю за допомогою Google Tag Manager

У цій статті розберу етапи побудови системи — від стратегії до кожної окремої події у воронці