Як провести SEO-аналіз сайту: покрокові методи і корисні інструменти

Аналіз сайту — це регулярна перевірка того, як працює ваш ресурс. Він показує, наскільки зручно користувачам знаходити потрібну інформацію, як швидко завантажуються сторінки й що заважає їм потрапити у верхні рядки пошуку.

SEO-аналіз використовує факти про поведінку відвідувачів, технічні помилки, швидкість, зміст тощо й не будує випадкові теорії. Він потрібен усім: власникам бізнесу, маркетологам і навіть новачкам, які тільки тиждень тому запустили перший сайт.

Аналіз vs аудит: у чому різниця

Аналіз сайту дає загальне розуміння, як зараз працює ресурс і як його можна покращити. Він вивчає окремі показники: трафік, поведінку користувачів, видимість у пошуку, контент тощо. У результаті ви чітко бачите поточну ситуацію: де сайт зростає, що в ньому кульгає, які сторінки працюють краще.

Аналіз передбачає регулярність: щодня, щотижня або щомісяця. Заради автоматизації рутини використовують SEO-інструменти.

Схожий, але не тотожний процес — аудит. Це глибоке й системне дослідження, яке не просто рахує метрики, а ще й розбирається в проблемах і намагається їх розвʼязати. Аудит — радше разова перевірка, його роблять раз на рік або для того, щоб знайти причини конкретної проблеми. SEO-audit в результаті надає докладний звіт і рекомендації: що виправити, як оптимізувати, що зробити насамперед.

Сьогодні я розгляну, як зробити аналіз сайту онлайн, навіть якщо ви новачок у цьому питанні. Це простий, ефективний і цілком доступний для всіх спосіб дізнатися, як працює ваш ресурс.

Основні напрями аналізу

Якісний SEO-аналіз сайту не може бути поверхневим. Зазвичай він стосується кількох напрямів одночасно, а ваша задача — зіставити інформацію та зробити висновки.

|

Напрям |

Що перевіряється |

Як використовувати інформацію |

|

Технічний стан |

Індексація сторінок, биті посилання, редиректи, коректність файлів sitemap.xml і robots.txt |

Визначити чи доступний ресурс для користувачів пошукових систем, чи немає критичних збоїв |

|

Структура |

Логічність ієрархії сторінок, глибина вкладеності, зручність навігації, наявність внутрішніх посилань |

Зробити структуру сайту зрозумілішою для користувачів і пошукових систем: прибрати «загублені» сторінки, покращити навігацію, щоби люди швидше знаходили потрібну сторінку |

|

Контент |

Унікальність, релевантність ключовим запитам, читабельність, структура заголовків (H1–H6), наявність метатегів |

Підвищувати якість контенту, залучити більше користувачів і покращити видимість у пошуку |

|

Швидкість |

Швидкість завантаження сайту, Core Web Vitals (LCP, INP, CLS) |

Поліпшувати користувацький досвід і зменшувати показник кількості відмов |

|

Мікророзмітка |

Структурованість даних і їхні види |

Збільшувати CTR у пошуку, впливати на те, як пошукові системи сприймають сторінки |

|

Зовнішні чинники |

Кількість і якість зворотних посилань, авторитетність донорів |

Стратегічно формувати авторитетність сайту й покращувати його позиції у видачі |

|

Поведінкові показники |

Час на сайті, показник відмов, кліки, утримання користувачів |

Знаходити проблемні сторінки, оптимізувати взаємодію між користувачами й сайтом |

|

Мобільність |

Адаптивність дизайну, швидкість мобільної версії |

Покращувати досвід користувачів, які заходять зі смартфону чи планшету |

|

Безпека |

SSL-сертифікат (HTTPS), шкідливий код |

Поліпшувати безпеку даних користувачів і посилювати довіру до сайту |

Аналіз ресурсу передбачає комплексний підхід. Ви можете робити унікальний контент з експертністю й ексклюзивними прикладами, але ніхто його не побачить, якщо сторінка не індексується. Далі розгляну детальніше кожен етап.

Технічний аналіз: стан, доступність, пошукова видимість

Технічний аналіз показує, як пошукові системи (ПС) бачать сайт: чи можуть вони його сканувати, індексувати й чи не виникають технічні бар’єри. Загалом індексація потрібна для того, щоби сторінки з’являлися в пошуковій видачі. Якщо сторінка не потрапила в індекс, її фактично немає для користувачів Google.

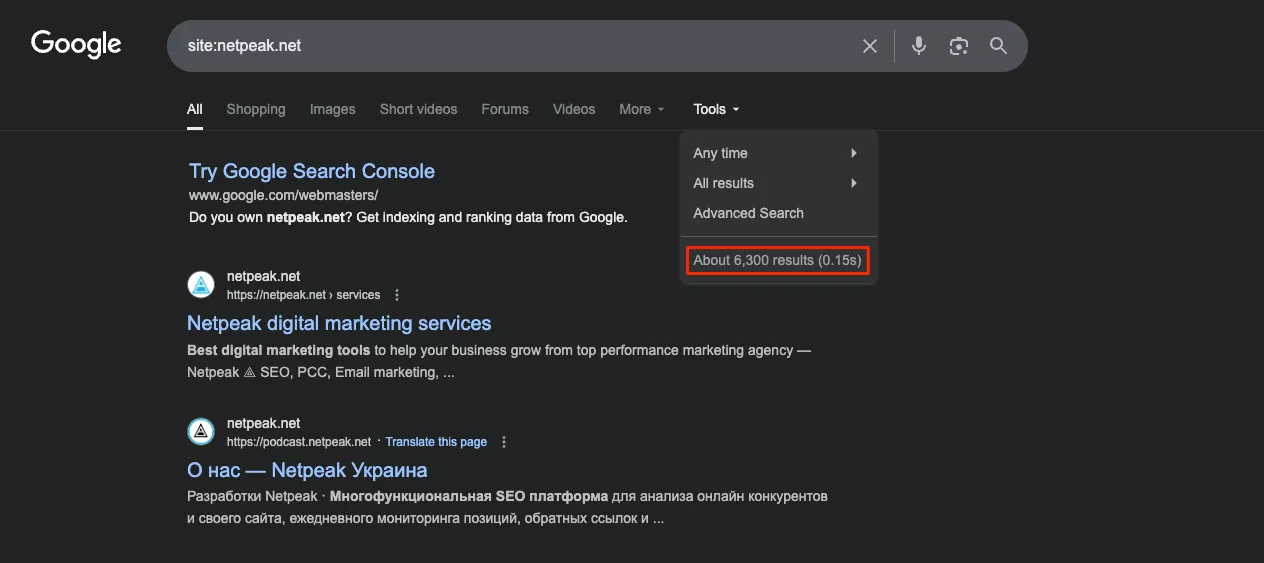

Перевірку індексації можна розпочати з пошукового оператора «site:» у Google: він показує, що вже є в індексі. Отже, ви не дізнаєтеся, які URL відсутні й чому — цей інструмент варто використовувати лише як орієнтовний.

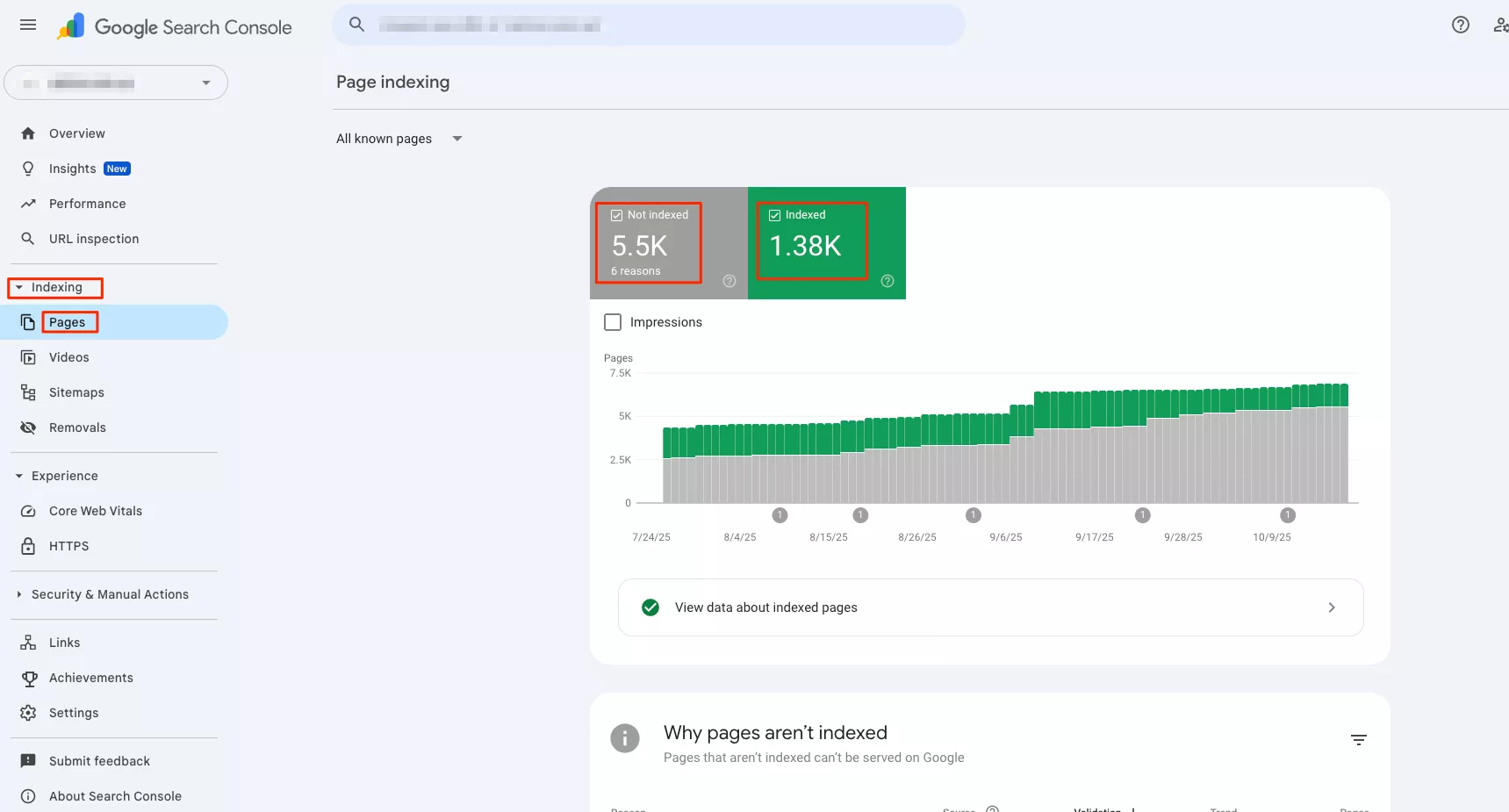

Для точних даних потрібен Google Search Console (GSC). Але врахуйте, що доступ до аналітики є лише у власників сайту, перевірити в такий спосіб конкурентів не вдасться. У меню «Indexing — Pages» доступна інформація про те, які URL проіндексовані, які виключені й із якої причини. Також видно дату останнього сканування і чи враховані сторінки з sitemap.

Якщо сторінка не проіндексована, треба шукати технічні причини. На цьому етапі потрібна діагностика HTTP-статусів. Для сканування використовуються спеціальні програми, або краулери. Зокрема, вони фіксують відповіді сервера: 200, 301, 404, 500. Поширені технічні проблеми:

-

robots.txt блокує важливі сторінки sitemap.xml;

-

у sitemap.xml залишилися URL з noindex, редиректами або 404;

-

є дублікати через http/https і www/non-www;

-

не налаштовані canonical-теги;

-

сторінки розташовані надто глибоко в структурі.

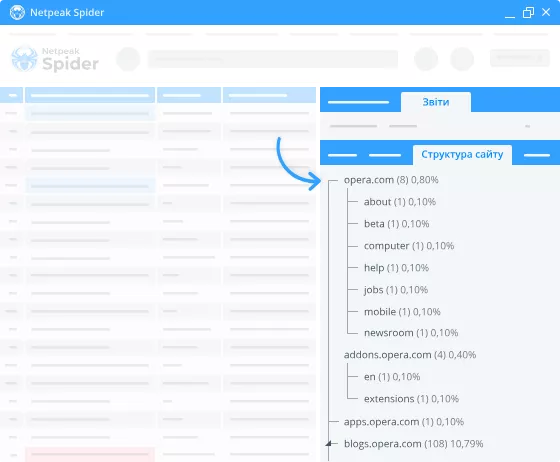

Для швидкого базового аналізу підходить програма Netpeak Spider, він має готові пресети і зручний інтуїтивний інтерфейс. Вебсканер Screaming Frog пропонує широкі можливості для розробників і детальну візуалізацію структури.

Подібний аналіз допомагає виявити технічні помилки. Далі ви вже можете видаляти неправильні URL, налаштовувати редиректи, усувати серверні помилки тощо, аби сайт працював без проблем.

Читайте також:

Аналіз структури сайту

Ієрархію контенту треба будувати так, щоби користувач міг легко дістатися ключових сторінок — зазвичай не більше за чотири кліки від головної. Оптимальна архітектура передбачає достатньо внутрішніх посилань для передачі авторитетності від головної сторінки до важливих розділів. Так ви полегшите процес сканування.

Меню має лишатися зрозумілим для людей. В інтернет-магазині воно підлаштоване під категорії товарів, у медіа засновано на тематичних рубриках, а на корпоративних сайтах містить послуги. Стандартна внутрішня навігація складається з хлібних крихт (breadcrumbs), фільтрів, супутніх розділів і рекомендованих матеріалів.

У великих проєктах пласка структура перевантажує меню, глибока — ускладнює доступ до контенту. До прикладу, логічна ієрархія в магазині електроніки така: «Головна — Ноутбуки — Ігрові ноутбуки — Конкретна модель». Водночас для фасетної навігації під час аналізу сторінок сайту (фільтри за брендом, ціною, характеристиками) потрібно налаштувати canonical-теги і параметри URL так, щоби контент не дублювався.

Внутрішнє перелінкування розподіляє авторитет між сторінками і допомагає ПС виявляти важливий контент. Що це означає на практиці? Якщо на сторінку «Послуги SEO-аудиту» веде 50 внутрішніх посилань, а на «Контакти» — лише пʼять, Google зрозуміє: перша важливіша.

Критично важливі сторінки мають отримувати найбільше внутрішніх посилань із релевантним контекстом.

Для цього треба додавати анкори з конкретними словами, які описують цільову сторінку (наприклад, не «читати тут», а «замовити послуги SEO»). Netpeak Spider і Screaming Frog показують карту сайту з глибиною вкладеності й розподілом внутрішніх посилань. За потреби проблемні URL можна додати в меню, блоки рекомендацій або створювати на них релевантні внутрішні посилання з інших розділів.

Контент-аналіз: унікальність, оптимізація, релевантність

Якість контенту вимірюється насамперед його унікальністю. Технічно це про дублі всередині сайту й на зовнішніх ресурсах. За допомогою DupliChecker і Grammarly можна відшукати збіги з чужими текстами. А Netpeak Spider автоматично знаходить сторінки з ідентичними title, description або H1 на вашому ж ресурсі — таке часто трапляється на фільтрованих сторінках інтернет-магазинів.

Сам текст потрібно будувати за логікою ПС:

-

заголовок H1 — містить основний ключ;

-

H2–H6 — розкривають тему через семантично пов’язані запити;

-

списки й таблиці — покращують читабельність;

-

логічна структура — збільшує шанси потрапити в блок розширених результатів;

-

обсяг контенту — визначається глибиною розкриття теми й метою запиту.

Контент-аналіз сайту передбачає вивчення конкурентів, а точніше — статей, що потрапили в десятку кращих. Так ви можете визначитися з обсягом своїх текстів: інформаційні статті зазвичай деталізують, а комерційні сторінки можуть бути лаконічнішими.

Інструменти також аналізують метатеги з огляду на On-Page SEO — оптимізацію елементів на самій сторінці. Для швидкої перевірки метатегів на кількох сторінках можна використовувати браузерне розширення SEO META in 1 CLICK: воно показує title, description, заголовки й інші теги прямо на сторінці. Якщо потрібно проаналізувати весь сайт, використовуйте програми (Screaming Frog, Netpeak Spider), а вони вже серед іншого помітять і метатеги.

Оптимальні показники:

-

title — до 60 символів, містить ключовий запит;

-

description — до 160 символів, описує сторінку;

-

контент — природний читабельний вигляд, відсутність переспаму (надмірної повторюваності ключів).

Спам можна перевіряти через сервіси для семантичного аналізу тексту — у кожного з них свої метрики й норми. Сам контент має відповідати цілям користувача. Якщо людина шукає «як прибрати подряпину з екрана телефону», їй потрібна покрокова інструкція, а не каталог захисних покриттів. Коли сторінка не відповідає очікуванням відвідувача, той швидко її покидає — і Google це помічає.

До того ж Google Helpful Content Update посилив акцент на принципах EEAT. Особливо критичні принципи EEAT для так званих YMYL-тематик (Your Money or Your Life): фінанси, здоров’я, юридичні питання тощо, де неправильна інформація може зашкодити людині.

Якісний контент має бути релевантним запиту користувача, унікальним (не скопійованим з інших джерел), фактологічно правдивим і підтвердженим посиланнями на авторитетні джерела. Якщо ви пишете про складні теми, краще вказувати автора з реальною кваліфікацією і додавати джерела, на яких можна перевірити інформацію.

Читайте також:

Швидкість завантаження

Швидкість завантаження сайту — це час між тим, як людина перейшла на ресурс, і тим, як він повністю завантажився. Якщо сторінка довго вантажиться, користувачі ідуть. Сам Google оцінює продуктивність сайту за метриками Core Web Vitals:

-

LCP — швидкість відображення найбільшого елемента на екрані (бажаний результат — < 2,5 с);

-

INP — швидкість реакції сайту на дії користувачів, зокрема, кліки (в ідеалі < 200 мс);

-

CLS — відсутність несподіваних зсувів контенту (добре, якщо < 0,1).

Цікаво, що метрику INP можна вимірювати лише польовими результатами, тобто за реальними даними користувачів, а не через лабораторні методи. Для цього часто використовують PageSpeed Insights від Google.

Перевірити швидкість завантаження можна через кілька сервісів. У таблиці я порівняв основні з них, щоби ви могли вибрати оптимальний інструмент під свої задачі.

|

Netpeak Checker |

Google PageSpeed Insights |

GTmetrix |

WebPageTest |

|

|

Тип аналізу |

Масова або вибіркова перевірка всіх сторінок сайту |

Оцінка швидкості з рекомендаціями |

Детальний технічний аналіз етапів завантаження |

Тест із налаштуванням параметрів |

|

Гнучкість тестування |

Локально або з одного сервера |

Фіксоване середовище Google |

Вибір локації сервера |

Вибір браузера, пристрою, швидкості, регіону |

|

Рівень деталізації |

Високий |

Середній |

Високий |

Високий |

|

Інтерфейс |

Орієнтований на SEO-фахівців, але інтуїтивно зрозумілий |

Інтуїтивно зрозумілий |

Інтуїтивно зрозумілий |

Орієнтований на SEO-фахівців |

|

Основна перевага |

Масовий аналіз великого сайту |

Швидка оцінка від Google |

Порівняння з різних регіонів |

Симуляція реального завантаження |

|

Для чого підходить |

Пошук повільних розділів великих проєктів |

Швидка діагностика |

Технічний аналіз сторінки |

Тест продуктивності |

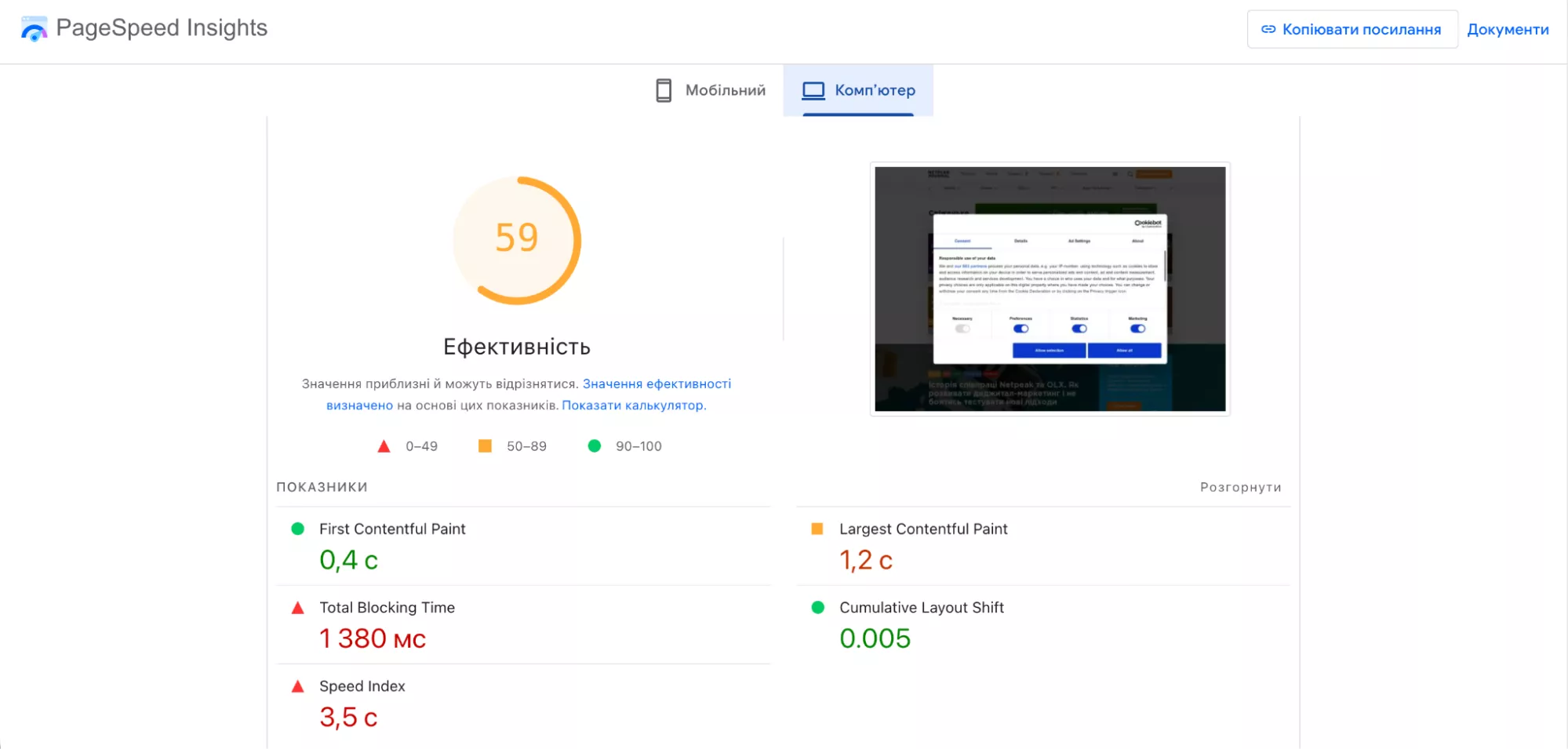

Стратегічний аналіз ефективності сайту може містити одразу кілька інструментів. Для швидкої діагностики краще скористатися Google PageSpeed Insights. Він покаже основні показники Core Web Vitals на основі реальних даних користувачів і надасть оцінку ефективності: 0–49 — критично, 50–89 — є резерв для покращення, 90–100 — відмінно. Далі інструмент показує конкретні проблеми й поради. Наприклад, він може запропонувати зменшити код JavaScript, який ви не використовуєте.

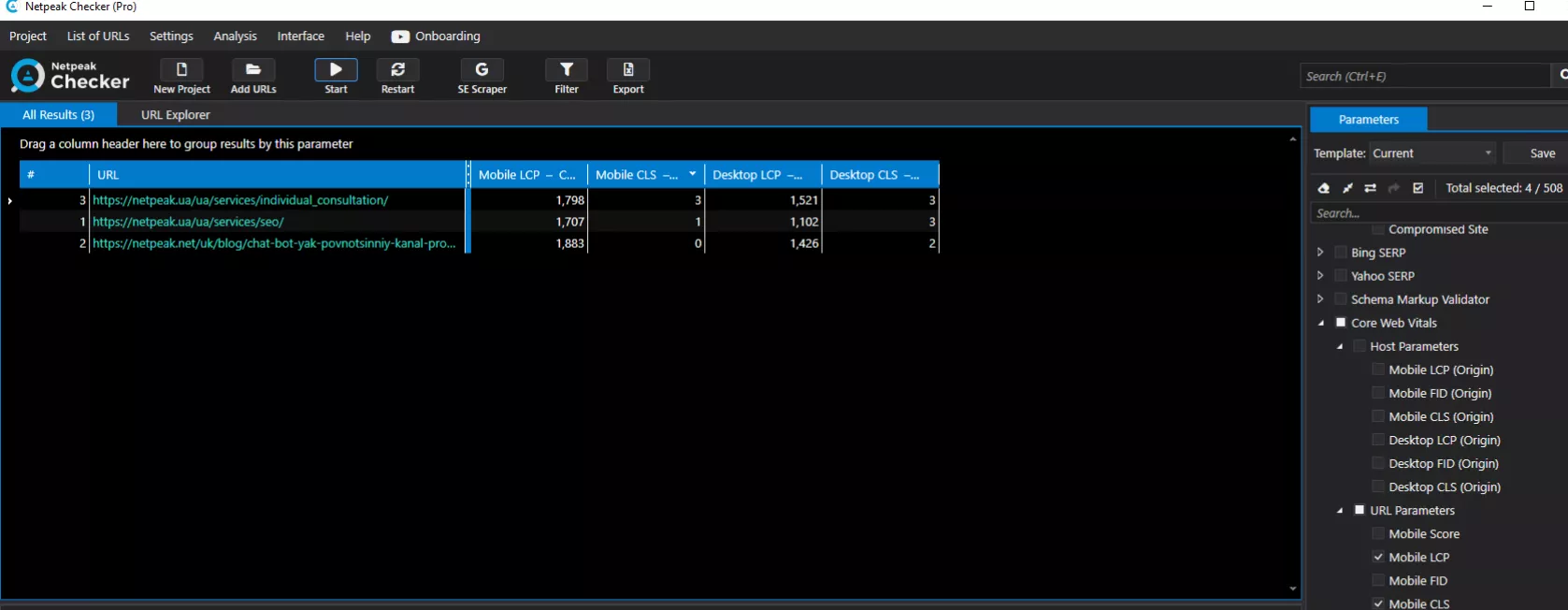

Якщо сайт великий, запустіть перевірку через Netpeak Checker. Тут завантажте список необхідних URL (з Sitemap або GSC) і увімкніть аналіз. Інструмент автоматично перевірить швидкість кожної сторінки й покаже результати в таблиці.

Відфільтруйте URL з оцінкою нижче за 50 — це ті, що гальмують найбільше й потребують оптимізації. Так ви швидко знайдете проблемні розділи (наприклад, категорії товарів зі складними фільтрами).

Під час аналізу сайту масову перевірку абсолютно всіх сторінок використовують рідко — це довго й не завжди потрібно. Достатньо вибрати репрезентативну вибірку: головна, близько пʼяти категорій, картки товарів різних типів, сторінки блогу. Також бажано перевіряти швидкість версії для десктопа й мобільних окремо. Потім усі показники порівнюються у форматі таблиці.

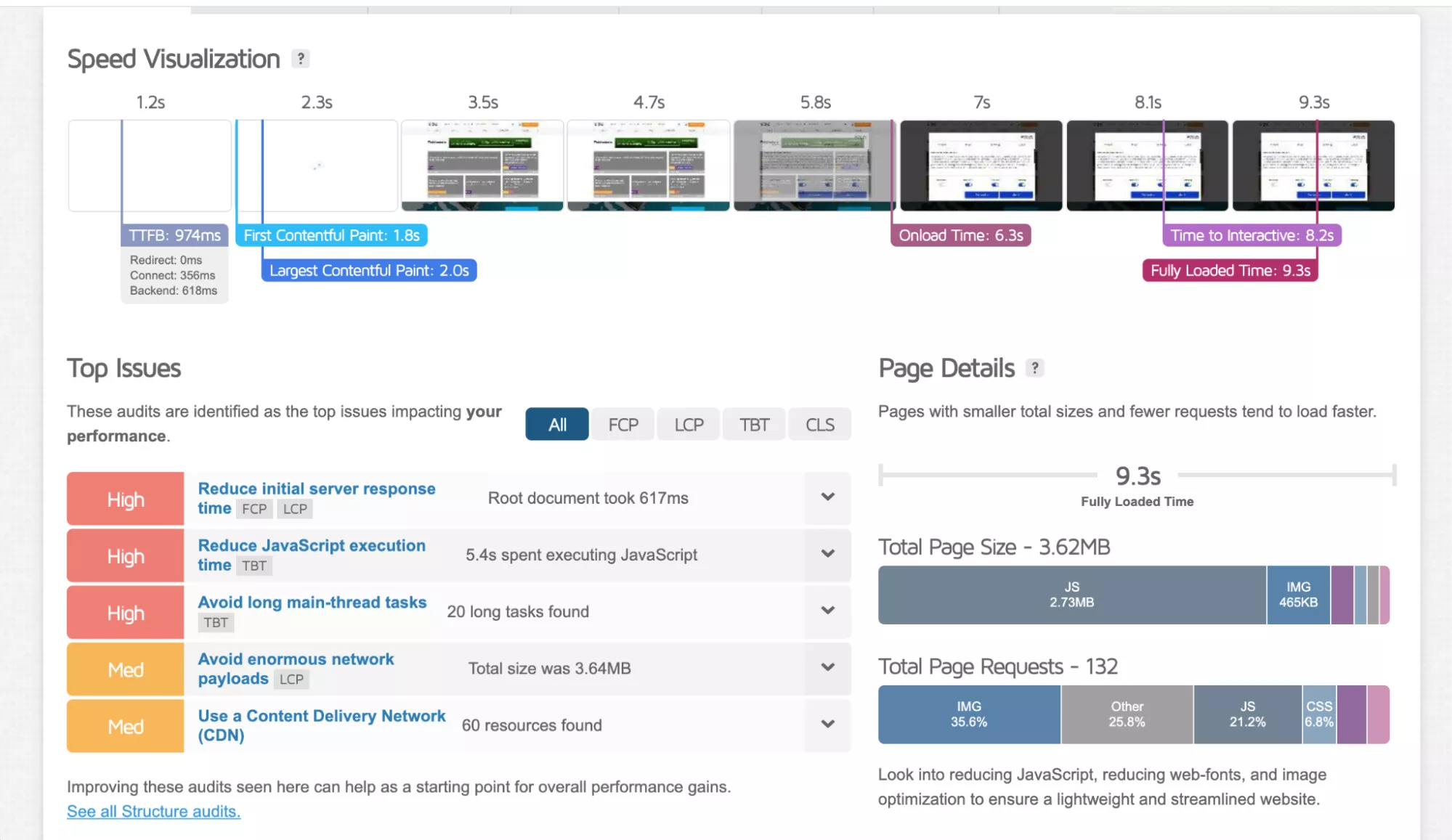

Для детального аналізу можна використовувати GTmetrix. Інструмент видає чималий звіт. Логіка проста: зелений колір — «добре», червоний — «є проблеми». Зручно, що тут всюди є позначка «?», за якою ховається детальне пояснення метрики.

Speed Visualization показує, як працює ваш сайт під час завантаження. На вкладці Performance ще більше метрик, виділю кілька з них:

-

Largest Contentful Paint (LCP) — час завантаження найбільшого елемента на сторінці (зображення, блоку тексту тощо). Покращується оптимізацією зображень і відео.

-

Total Blocking Time (TBT) — час, протягом якого скрипти блокують основний потік браузера під час завантаження. Оптимальний результат — до 150 мс. Зменшується оптимізацією JavaScript.

-

Cumulative Layout Shift (CLS) — показує, наскільки елементи зміщуються під час завантаження сторінки. Зменшується вказанням розмірів медіа, уникненням різких вставок реклами, віджетів і iframe.

-

Time to First Byte (TTFB) — час до отримання першого байта відповіді від сервера. Покращується оптимізацією редиректів, підключення і формування сторінки.

У розділі Top Issues зібрані поради, як покращити ефективність вашого ресурсу — тут можна більше дізнатися про інші метрики.

Регулярна перевірка швидкості допомагає утримувати користувачів і підтримувати позиції у видачі. Комбінуйте інструменти залежно від завдання: PageSpeed Insights для швидкої оцінки, Netpeak Checker для вибіркового або масового аналізу, GTmetrix для пошуку конкретних проблем. Виправляйте критичні помилки послідовно — покращення швидкості навіть до двох секунд може знизити кількість відмов і збільшити конверсію.

Перевірка мікророзмітки й структурованих даних

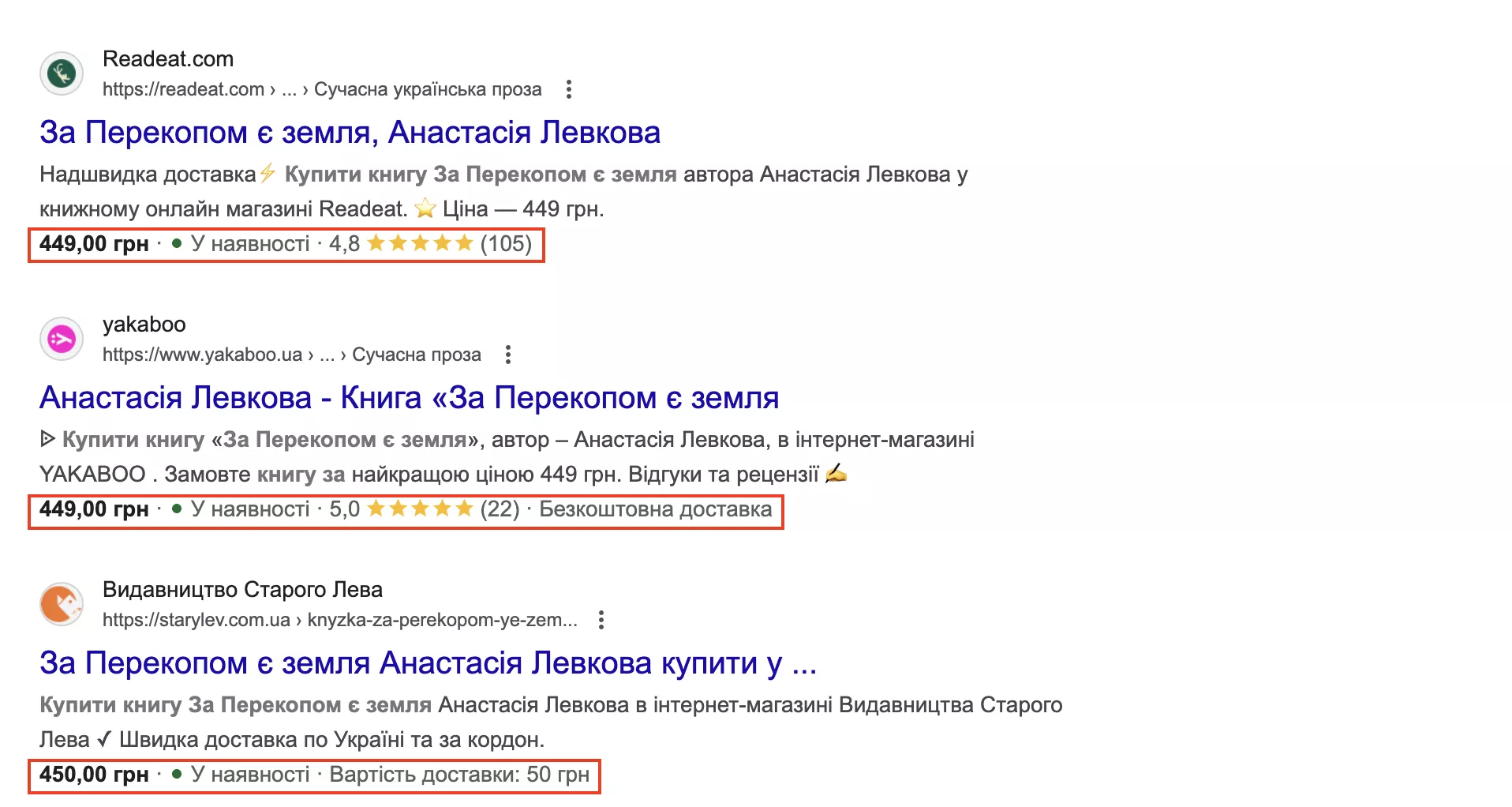

Мікророзмітка — це спеціальний код на сторінці, який допомагає Google зрозуміти, що саме ви описуєте: товар, рецепт, статтю, організацію тощо. Завдяки цьому у видачі можуть з’являтися розширені результати (rich results): зірки рейтингу, ціна й наявність товару, FAQ-блоки тощо. Такі сніпети привертають більше уваги й збільшують клікабельність.

Google рекомендує використовувати JSON-LD — це окремий блок коду у <script>, який не втручається у видиму HTML-структуру. Його простіше додавати й редагувати, ніж старі формати (Microdata чи RDFa), що вимагають змін у всьому коді.

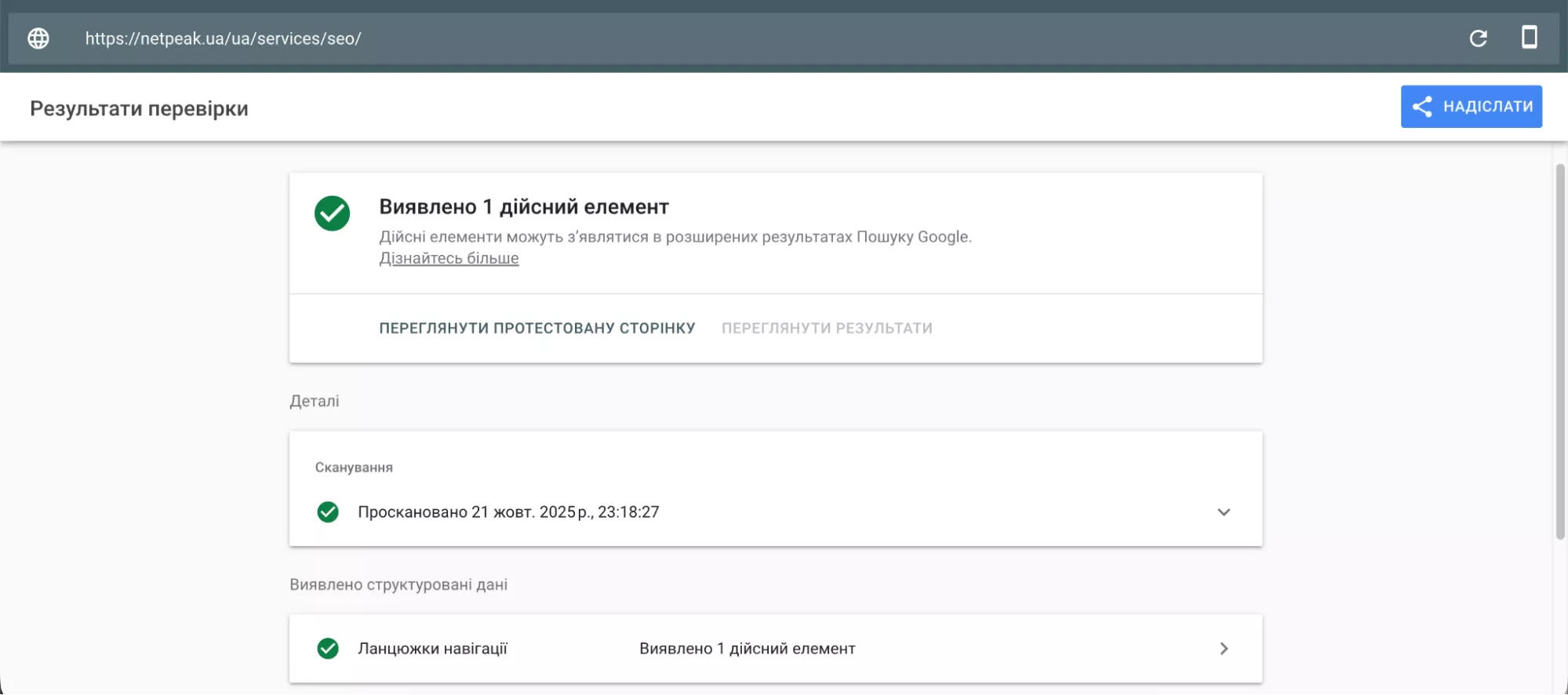

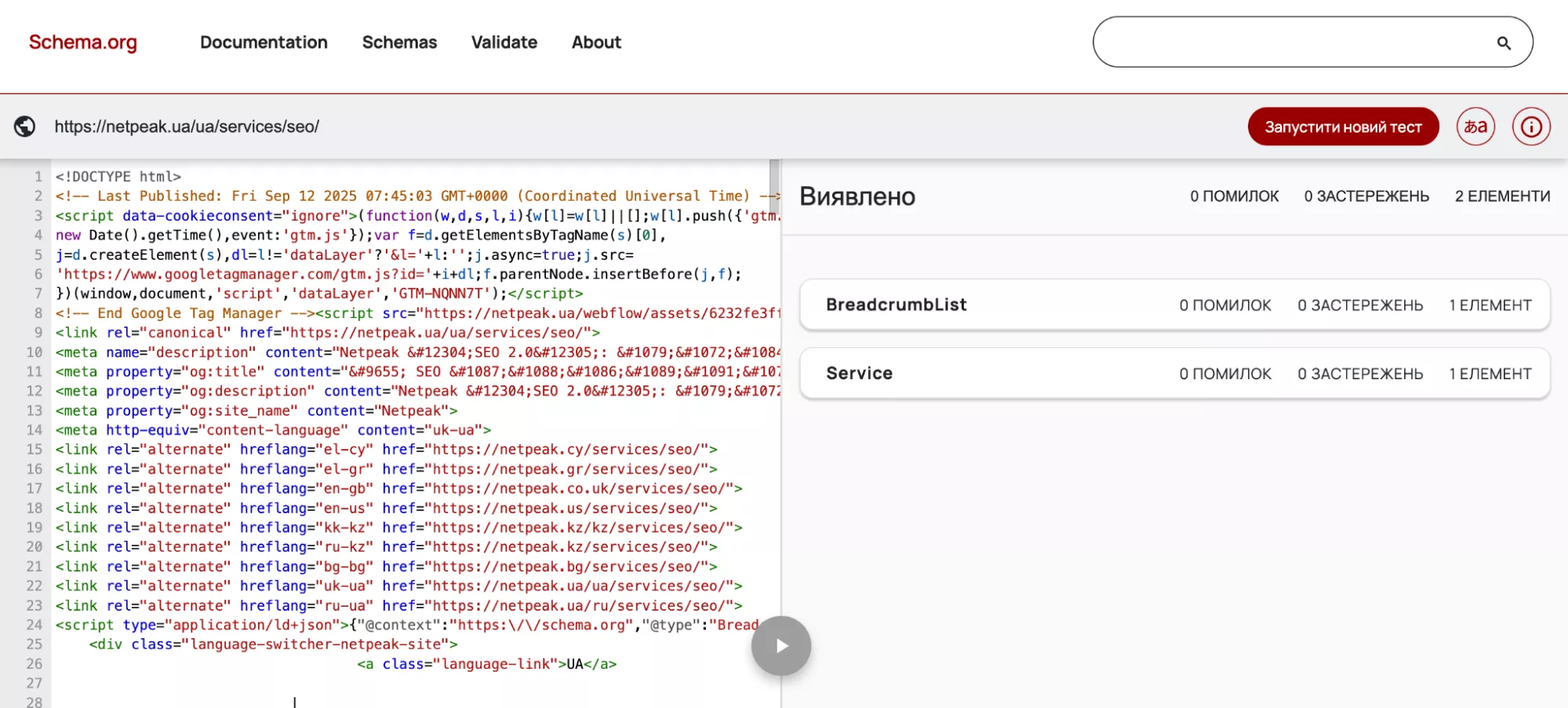

Сервіс Google Rich Results Test перевіряє розмітку, наявність структурованих даних (наприклад, ланцюжки навігації або часті питання), проблеми вебсторінки, що заважають повному завантаженню.

Через Schema Markup Validator також можна перевірити структуровані дані. Валідатор показує частину коду сторінки, мікророзмітку й помилки, якщо ті є.

Що робити далі з цією інформацією? Помилки (errors) потрібно виправити, інакше сторінка може не зʼявитися з розширеним відображенням у пошуку. Попередження (warnings) не критичні, але їхнє виправлення підвищує якість даних.

Якщо використовуються несумісні типи мікророзмітки або дублюється одна й та сама інформація різними методами, треба залишити лише один коректний варіант. Коли внесли правки, проженіть сторінку ще раз через ці інструменти.

Зовнішні фактори: беклінки й сайти-донори

Зворотні посилання, або беклінки, — це посилання з інших сайтів на ваш. Google розглядає їх як «рекомендації»: чим більше якісних ресурсів зсилаються на вас, тим вищою може бути ваша позиція у видачі. Однак тут важлива не кількість, а якість. Умовно лінки мають йти з авторитетних ресурсів, як-от великі медіа або галузеві портали.

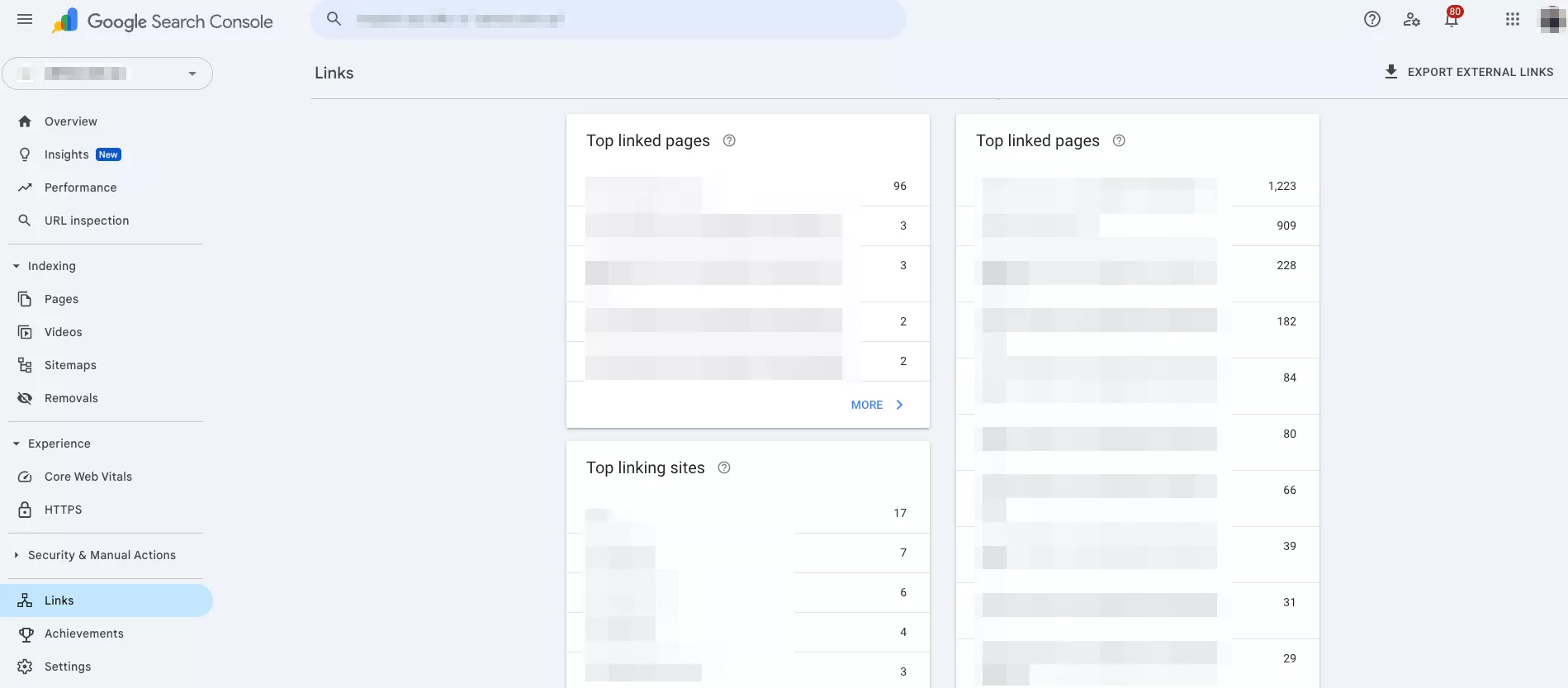

Аналіз сайту за доменом має показувати backlink-профіль: кількість посилань, авторитетність донорів, тематичну релевантність, природність анкор-листа, відсутність токсичних посилань. Найпростіший спосіб перевірити зовнішні фактори — використати Google Search Console. Інструмент аналізує лінки, донорів, анкори з Google і подає файл Disavow (у разі спам-посилань).

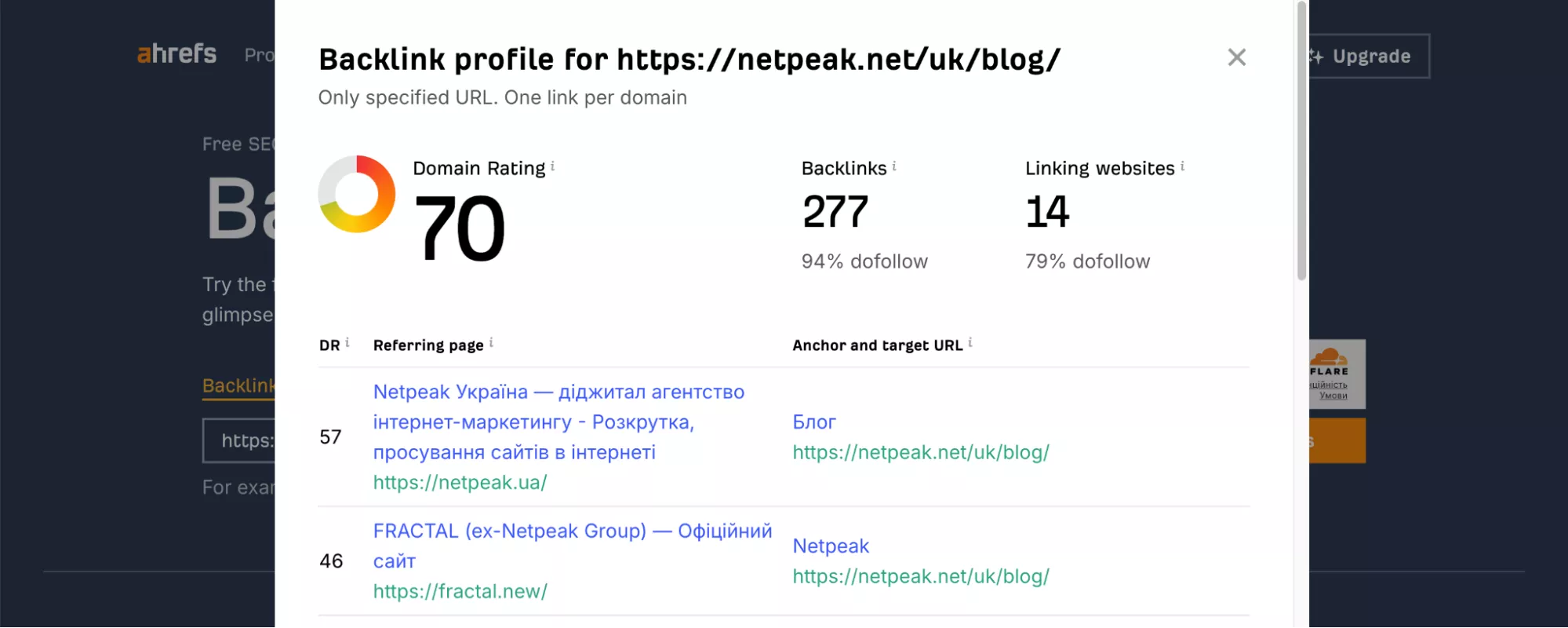

Можна використовувати Ahrefs: у безоплатному режимі він дає обмежену інформацію, а для глибшого аналізу потрібно вже сплатити план. Проте ви можете побачити рейтинг домену і сторінок, орієнтовний трафік, анкори беклінків, а також 100 топових зовнішніх посилань і найпопулярніші сторінки за кількістю лінків.

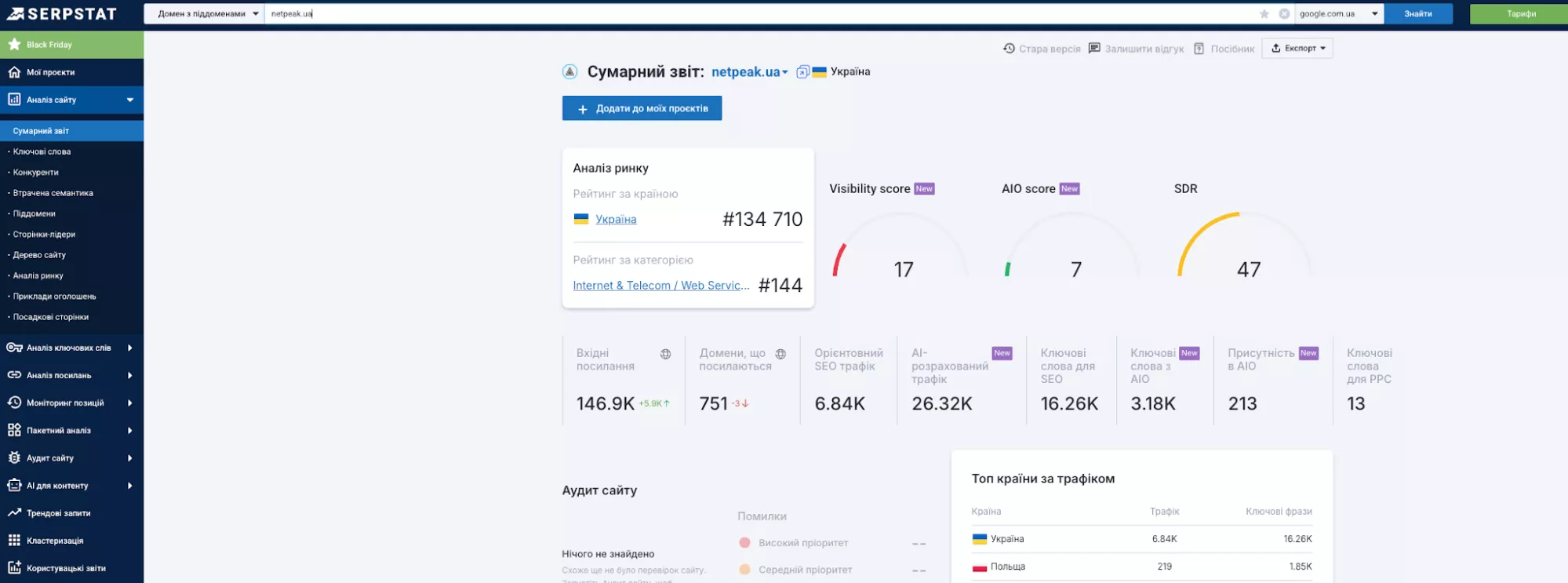

Сервіс Serpstat перевіряє беклінки і використовує власний показник авторитетності. Перевага інструменту в тому, що він об’єднує багато SEO-функцій в одному сервісі: аналіз посилань, детальні звіти, сегментацію посилань за типами тощо.

Також скористайтеся Majestic, що перевіряє донорів через Trust Flow, Citation Flow і Topical Trust Flow. Інструмент Moz визначає авторитетність і шукає токсичні беклінки через показники DA, PA і Spam Score. А SE Ranking з подібним функціоналом простіше використовувати для локальних ринків.

Після збору всіх зовнішніх посилань основне завдання — оцінити їхню якість і визначити, які з них приносять користь, а які можуть зашкодити сайту. Для цього:

-

Проаналізуйте всі отримані беклінки — відкрийте звіти з попередніх сервісів і перевірте авторитетність донорів, тематику, анкорний текст.

-

Перевірте шкідливі посилання — Google автоматично ігнорує більшість низькоякісних лінків, але вам потрібно виявити й відхилити ті, що мають потенційну загрозу. Наприклад, неправильний опис сайту, лінки на казино, коли сам ресурс не має таких тематик. Для цього скористайтеся Google Disavow Tool, якщо прибрати вручну не виходить.

Далі перегляньте анкор-лист. Це список усіх текстів посилань (тобто анкорів), що ведуть на ваш ресурс. Природний профіль має складатися з різноманітних типів: комерційних («купити iPhone» або «замовити джинси»), брендових («інтернет-магазин N»), URL(n.shop.ua), загальних («тут», «перейти на сайт»). Якщо одна з цих категорій домінує, необхідно розбавити її іншими.

Для зручності налаштуйте моніторинг нових посилань (Ahrefs Alerts або щомісячна перевірка GSC), щоби вчасно виявляти корисні й токсичні лінки.

Щоби сформувати стратегію розвитку власного беклінк-профілю, проаналізуйте відповідну активність на ресурсах конкурентів через Ahrefs або Serpstat. Введіть домен конкурента і знайдіть донорів, які посилаються на нього, а на ваш сайт — ні. На основі цього вже можна будувати тактику розвитку власного беклінк-профілю.

Наприклад, спробуйте отримати посилання з тих самих джерел. Бажано перевіряти, які типи контенту (огляди, дослідження, інфографіки) мають найбільше лінків у конкурентів і враховувати це для себе.

Отже, якісний беклінк-профіль — це баланс між авторитетністю донорів, природністю анкорів і тематичною релевантністю. ПС автоматично ігнорує більшість низькоякісних посилань, а вам варто контролювати й відхиляти лише дійсно небезпечні (наприклад, спам-анкори). Регулярно аналізуйте посилання конкурентів, щоби знаходити нові можливості для розвитку власного профілю, і перевіряйте нові беклінки, аби вчасно реагувати на загрози.

Про беклінки читайте також в матеріалах:

Аналіз позицій і видимості

Моніторинг позицій показує, наскільки ефективно працює SEO-стратегія, і допомагає вчасно помічати можливі проблеми. Відстежуючи позиції за ключовими запитами, ви вчасно помітите зміни: чи підіймаєтеся ви у видачі, чи втрачаєте позиції через активність конкурентів або оновлення алгоритмів Google тощо.

Які інструменти можна використовувати для аналізу:

-

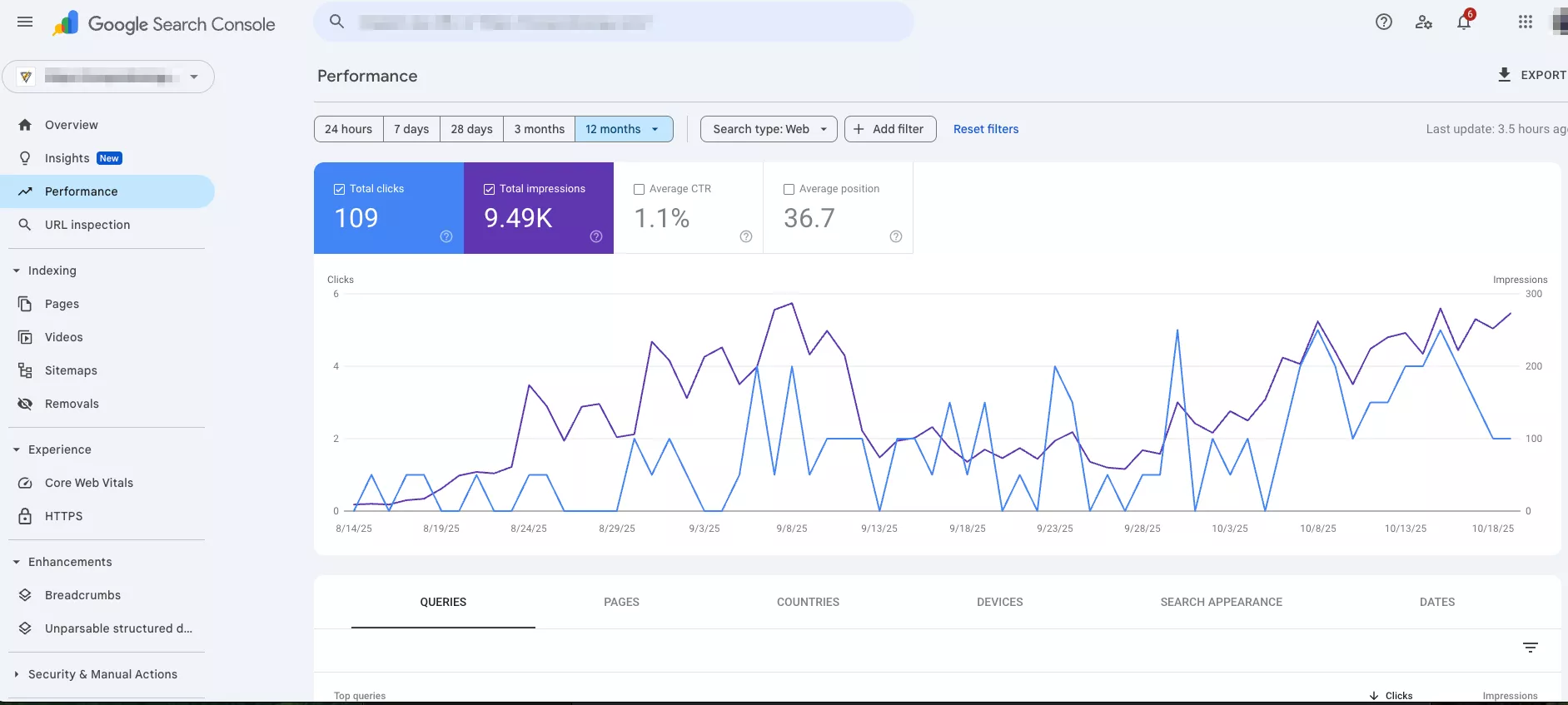

Google Search Console — безоплатний сервіс, що надає дані про середню позицію сайту, запити, за якими він ранжується. У Performance можна переглянути також CTR, кількість показів і кліків за кожним запитом.

-

Serpstat — платний інструмент (від 59 $/міс), що поєднує трекінг позицій із перевіркою конкурентів у видачі, він показує зміни в провідних сайтах, їхню видимість і нові ключі, за якими ті просунулись, визначає найрезультативніші SERP-функції.

-

SE Ranking — платний сервіс (від 55 $/міс), що автоматично перевіряє позиції із зазначеною періодичністю, візуалізує динаміку й показує зміни. Виділяється звітами про канібалізацію — ви можете знаходити власні сторінки, що конкурують за одні й ті самі ж ключі.

Відстежуйте тільки важливі запити — у платних сервісах кількість ключів обмежена тарифом, тож не варто моніторити все поспіль. Щоби аналіз був легшим, розділяйте запити за групами: товари, міста, етапи воронки продажів тощо — так легше бачити закономірності й використовувати їх для подальших стратегій.

Серед функцій SERP варто перевіряти виділені фрагменти (Featured Snippet) — це невеликі уривки, які опиняються у верхніх результатах пошуку й часто потрапляють до згенерованих відповідей. Завдяки цьому вони здатні приводити стільки ж органічного трафіку, скільки й перша позиція в видачі.

Щоб посилити свої позиції, аналізуйте також конкурентів. Так ви можете відшукати слабкі місця в ключових запитах і скоригувати свою стратегію, а потім провести оптимізацію: додати ключі в метатеги, анкори, сам контент на сайті тощо.

Регулярний моніторинг позицій допомагає швидко реагувати на зміни у видачі і коригувати стратегію. Для базового аналізу достатньо Google Search Console, для детальнішого моніторингу й аналізу конкурентів — Serpstat або SE Ranking.

Поведінковий аналіз: як користувачі взаємодіють із сайтом

Аналіз юзабіліті сайту показує, наскільки очікування відвідувачів щодо ресурсу виправдалися. Часто проводять аудит Google Analytics 4 (GA4), щоби побачити взаємодію через події: перегляди, кліки, скролінг, відео, форми. GA4 у звіті «Залучення» на основі відвідування сайту показує, які сторінки утримують увагу.

Інші популярні сервіси для аналізу відвідуваності онлайн:

-

Hotjar записує сесії користувачів, будує теплові карти кліків і скролінгу. Його аналітика форм дає зрозуміти, де відвідувачі перестають заповнювати інформацію про себе.

-

Microsoft Clarity не обмежує в записі сесій — це безоплатно. Він автоматично шукає мертві кліки, надмірне прокручування й так звані кліки злості (повторні й багаторазові).

-

Google Search Console показує CTR сніпетів і готує звіт щодо вже знайомих Core Web Vitals.

Після аналізу трафіку можна вже переходити до конкретних дій. Наприклад, ви зрозуміли за тепловою картою, що люди не бачать CTA-кнопку. Тоді можна замінити колір або пересунути її ближче до центра.

Поведінковий аналіз показує вам, де продукт втрачає увагу аудиторії і чому не спрацьовують очікувані гачки (заповнення форми, покупка продукту). Після цього можна перевести UX-рішення з інтуїтивних у доказові, змінивши структуру, елементи, візуальні акценти тощо.

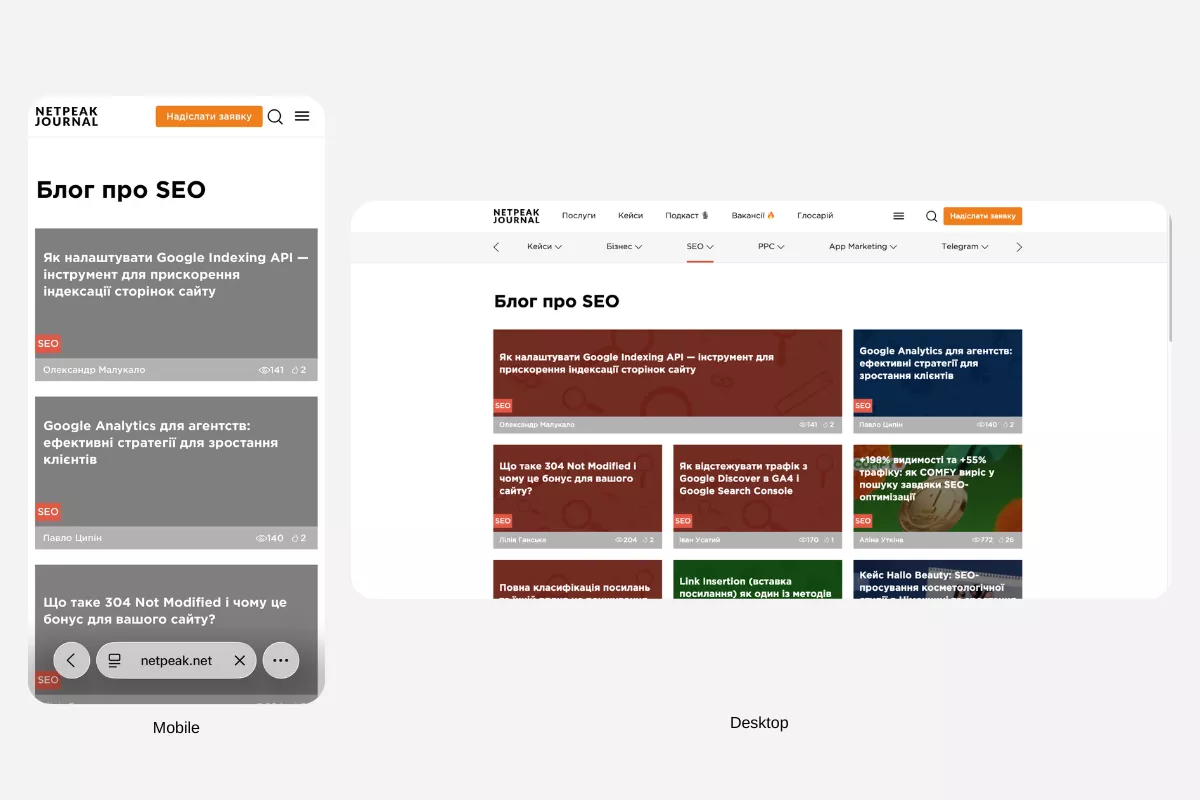

Мобільність і адаптивність

Google остаточно перейшов на mobile-first індексацію. ПС оцінює сайти насамперед за їхньою мобільною версією, а люди дедалі частіше заходять в інтернет через смартфони — ігнорувати це питання точно не треба.

Щоби перевірити сумісність сайту з планшетом і смартфоном, використайте PageSpeed Insights — він порівнює швидкість завантаження різних форматів. Сервіс також показує Core Web Vitals з реальних даних користувачів Chrome. Якщо порівнювати з десктопом, мобільна оцінка може бути трохи меншою — це відбувається через обмежені ресурси пристроїв і повільніші мережі.

Ще один варіант, як проаналізувати роботу сайту, — BrowserStack, що також розрахований на застосунки. Його принцип тестування простий: він використовує дані з реальних пристроїв, у яких відрізняються браузери й ОС. Емулятори не завжди помічають усі проблеми, а так ви отримуєте трохи ширший кут огляду.

Наприклад, аналіз може показати, що в застосунку Safari на iPhone 12 кнопка «Додати в кошик» занадто мала й ускладнює кліки.

Звіт із виявленими проблемами далі передайте розробникам або технічній команді: вони усунуть помилки у верстці, оптимізації швидкості, шрифтах, некоректній роботі кнопок тощо. Якщо помилок багато, пріоритезуйте їх: спершу треба виправити критичні баги, що впливають на користувацький досвід і блокують взаємодію (кнопки, форми, верстка), потім має йти оптимізація швидкості, а далі — другорядні візуальні елементи.

Після внесення змін повторно протестуйте сайт на тих самих платформах, щоби переконатися — попередні проблеми усунені, а нових не зʼявилося.

Безпека й технічна відповідність

HTTPS — це безпечний варіант протоколу HTTP, він шифрує дані й відповідає за конфіденційність інформації. Якщо ресурс працює виключно з HTTP, браузер може показувати попередження про небезпеку. Це відлякує людей, особливо, коли треба залишити свої персональні дані чи сплатити покупку на ресурсі.

Google враховує HTTPS для ранжування, а користувачі більше довіряють захищеним сайтам. Коли на ресурсі немає SSL-сертифіката (а це він перетворює HTTP на HTTPS), браузери не дозволяють використовувати інші технології: наприклад, HTTP/2 для швидкості, Service Worker для офлайн-режиму, геолокацію і push-сповіщення.

Є два способи проаналізувати сайт онлайн у цьому напряму:

-

Зайти в розділ «Проблеми безпеки» від Google Search Console. Система показує, чи немає зламаних сторінок, шкідливих скриптів і фішингу.

-

Використати Chrome DevTools, він на вкладці Security зазначає стан SSL-сертифіката й виявляє змішаний контент — коли HTTPS-сторінка завантажує ресурси через HTTP.

Якщо SSL-сертифіката немає, його потрібно встановити. Здебільшого хостинги надають безоплатну версію Let’s Encrypt, що швидко встановлюється через панель управління хостингом. Якщо такий формат не підтримується, сертифікат потрібно купити (наприклад, у провайдерів Comodo, Sectigo або GeoTrust). Після цього важливо перевірити, аби було налаштоване примусове перенаправлення з HTTP на HTTPS — так ви уникнете дублю сторінок і змішаного контенту.

Як організувати аналіз: чекліст і періодичність

Перевіряти ключові показники треба регулярно, щоби сформувати системний підхід до SEO-аналізу сайту. Тоді ви одразу бачитимете проблеми й швидко їх усуватимете.

Щоденний аналіз може торкатися:

-

технічних помилок з індексацією і сервером (Google Search Console);

-

доступності й часу відгуку сервера (Google PageSpeed Insights);

-

аномалій у трафіку (GA4).

Трохи рідше — раз на один-два тижні — варто перевіряти:

-

як змінюються позиції за головними ключовими словами (Serpstat, SE Ranking);

-

чи зʼявляються нові й втрачені беклінки (Ahrefs, Majestic);

-

як змінюються поведінкові метрики, зокрема, відмови, час на сайті, глибина перегляду (GA4).

Щомісяця бажано проводити:

-

повне сканування (Netpeak Spider, Screaming Frog);

-

перевірку мікророзмітки і структурованих даних (Rich Results Test);

-

оцінку мобільної версії і Core Web Vitals (PageSpeed Insights);

-

аналіз внутрішньої перелінковки й архітектури сайту (Netpeak Spider).

Ще рідше проводиться глибокий конкурентний аналіз, аудит контенту, перегляд і оновлення семантичного ядра, перевірка токсичності беклінків тощо.

Щоб систематизувати процес, складіть власний маршрут.

-

Почніть із технічної основи: перегляньте індексацію і критичні помилки.

-

Проаналізуйте структуру і внутрішню оптимізацію, зосередьтеся на зовнішніх чинниках і конкурентах.

-

Завершуйте оцінкою поведінкових метрик і конверсій.

Щоби бачити динаміку змін, ведіть таблицю перевірок: фіксуйте дату аналізу, проблеми, виконані дії і результати. Через кілька місяців побачите, які зміни дали ефект, а які виявилися марними.

Висновки й загальні поради

-

Аналіз сайту має бути регулярною практикою, а не разовим явищем. Проте жоден інструмент не дасть вам абсолютно повної картини в усіх напрямах одразу.

-

Ефективна стратегія — поєднувати безоплатні ресурси (Google Search Console, наприклад) і профільні сервіси залежно від бюджету. Можна використовувати такі базові програми для аналізу сайтів: GSC і Netpeak Spider. Для регулярного моніторингу додайте Serpstat або SE Ranking. Для глибшого аудиту раціонально ще застосувати Ahrefs і Sitebulb.

-

Успішний SEO-аналіз сайту стоїть на кількох принципах: комплексність заради обʼєктивності, регулярність для попередження проблем, правильна пріоритизація і фіксація результатів. Проте аналіз — це суха аналітика, а вам потрібно ще перетворити її на конкретні дії, які підвищують трафік, покращують конверсії і дають реальні результати.

FAQ

Що таке аналіз сайту й в чому його відмінність від аудиту?

SEO-аналіз сайту — це систематична перевірка окремих аспектів: технічного стану, контенту, видимості в пошуку, поведінкових факторів. Аудит — комплексне дослідження всіх SEO-компонентів одночасно з детальним звітом про виявлені проблеми й рекомендаціями до їхнього усунення.

Які методи застосовують для аналізу контенту сайту?

Netpeak Spider аналізує, як побудовані тексти, чи є метатеги, чи дублюються title і description. Інструменти для аналізу сайту по типу Serpstat і Sitechecker оцінюють, наскільки контент збігається з цілями людей, перевіряють щільність ключових запитів і відповідність основному пошуковому інтенту. А через DupliCheker можна перевіряти унікальність і побачити дублікати в конкурентів.

Як впливає швидкість завантаження на SEO і як її перевірити?

Повільні сторінки погіршують поведінку користувачів, наприклад, зростає показник відмов, а це впливає на позиції в Google. Через Google PageSpeed Insights можна провести базову діагностику, Netpeak Spider краще підходить для масової перевірки всіх сторінок ресурсу. А GTmetrix можна використати як додатковий погляд зі сторони.

Як оцінити зовнішню оптимізацію і посилальний профіль сайту?

Профіль зовнішніх посилань можна перевіряти кількома сервісами. Ahrefs показує кількість і якість беклінків за метриками DR/UR, Majestic оцінює довіру донорів через Trust Flow, а Serpstat міксує аналіз лінків і дослідження конкурентів. Також потрібно оцінювати кількість зворотних посилань, авторитетність донорів, тематичну релевантність тощо.

Які інструменти найкраще підходять для моніторингу позицій сайту?

Serpstat фіксує позиції і проводить аналіз SEO сайту конкурентів у видачі, а Google Search Console досліджує фактичний трафік. SE Ranking автоматично відстежує позиції з вибраною періодичністю, показує зміни в топі ПСа і SERP-функції.

Свіжі

Що чекає на бізнес і як адаптувати маркетингові стратегії: AI-пошук 2026

Матеріал на основі мітапу AI Search 2026. Розглядаємо зміни в AI-пошуку та видачі загалом.

Як Telegram Ads працює у фінансовій ніші: кейс ICU з просування держоблігацій

Кілька форматів, різні точки входу й один результат — стабільний інтерес до інвестиційного продукту ICU

Netpeak оголосив про ребрендинг до 20-річчя компанії

Чому саме зараз? І що таке ефект зірки? Дивіться на нову візуальну айдентику Netpeak від Spiilka Design Büro